1.参数

loss_func_none = nn.CrossEntropyLoss(reduction="none")

loss_func_mean = nn.CrossEntropyLoss(reduction="mean")

loss_func_sum = nn.CrossEntropyLoss(reduction="sum")默认是“mean” 也就是说当loss_func_none = nn.CrossEntropyLoss()时 会输出一组batch 的损失平均值

import torch

import torch.nn as nn

loss_func = nn.CrossEntropyLoss(reduction="none")

pre = torch.tensor([[0.8, 0.5, 0.2, 0.5],

[0.2, 0.9, 0.3, 0.2],

[0.4, 0.3, 0.7, 0.1],

[0.1, 0.2, 0.4, 0.8]], dtype=torch.float)

tgt_index = torch.tensor([0,1,2,3], dtype=torch.long)

print(loss_func(pre, tgt_index))

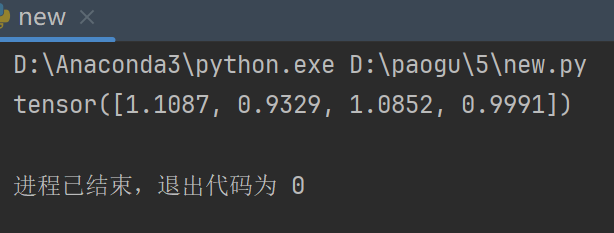

输出如下

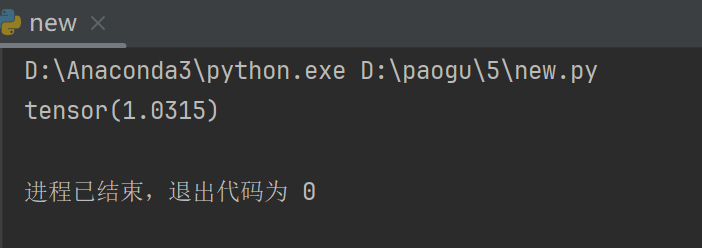

import torch

import torch.nn as nn

loss_func = nn.CrossEntropyLoss()

pre = torch.tensor([[0.8, 0.5, 0.2, 0.5],

[0.2, 0.9, 0.3, 0.2],

[0.4, 0.3, 0.7, 0.1],

[0.1, 0.2, 0.4, 0.8]], dtype=torch.float)

tgt_index = torch.tensor([0,1,2,3], dtype=torch.long)

print(loss_func(pre, tgt_index))

输出

tgt表示样本类别的真实值,有两种表示形式,一种是类别的index,另一种是one-hot形式。

tgt_index_data = torch.tensor([0,

1,

2,

3], dtype=torch.long)

tgt_onehot_data = torch.tensor([[1, 0, 0, 0],

[0, 1, 0, 0],

[0, 0, 1, 0],

[0, 0, 0, 1]], dtype=torch.float)

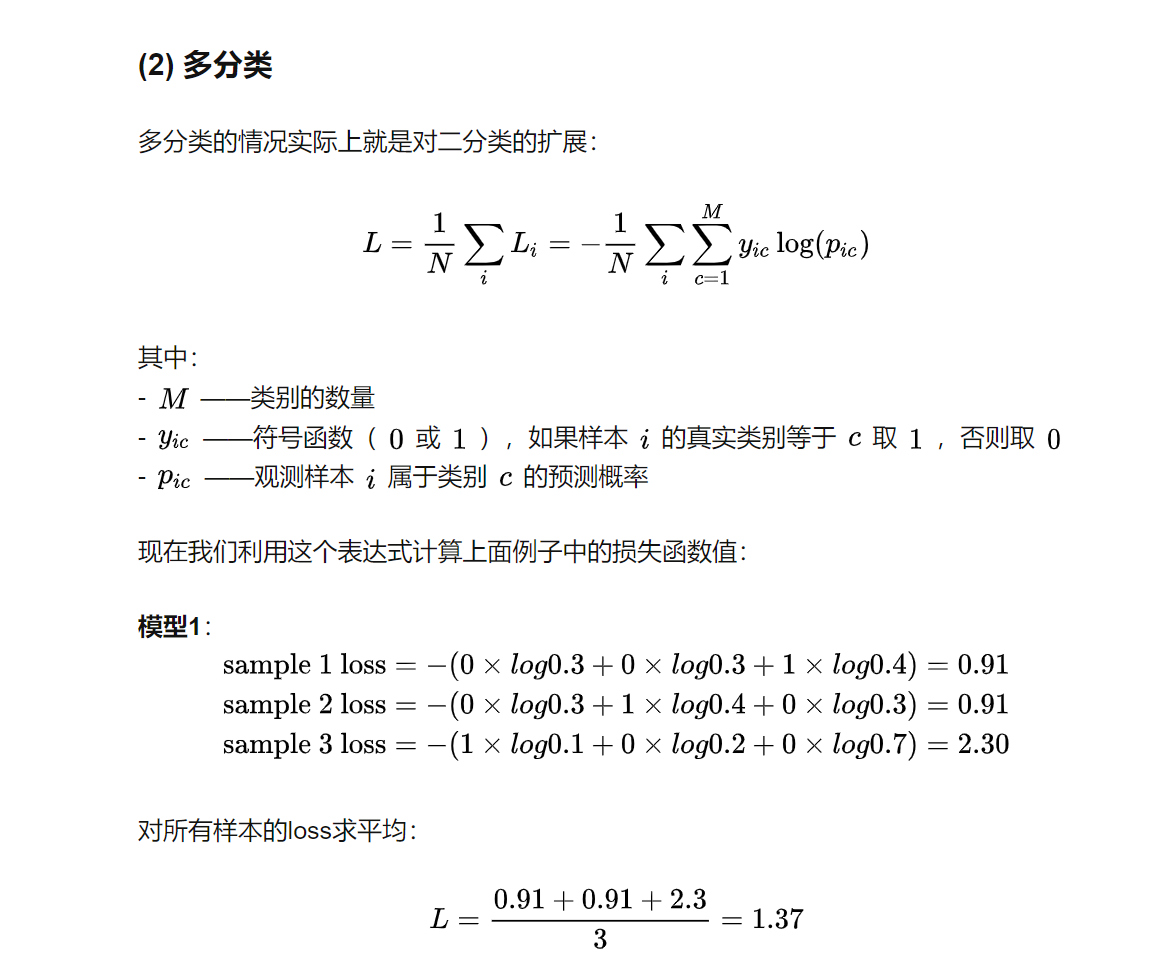

2.计算过程

loss_func = nn.CrossEntropyLoss()

pre = torch.tensor([0.8, 0.5, 0.2, 0.5], dtype=torch.float)

tgt = torch.tensor([1, 0, 0, 0], dtype=torch.float)

print("手动计算:")

print("1.softmax")

print(torch.softmax(pre, dim=-1))

print("2.取对数")

print(torch.log(torch.softmax(pre, dim=-1)))

print("3.与真实值相乘")

print(-torch.sum(torch.mul(torch.log(torch.softmax(pre, dim=-1)), tgt), dim=-1))

print()

print("调用损失函数:")

print(loss_func(pre, tgt))

交叉熵损失函数会自动对输入模型的预测值进行softmax。因此在多分类问题中,如果使用nn.CrossEntropyLoss(),则预测模型的输出层无需添加softmax层。

参考torch.nn.CrossEntropyLoss() 参数、计算过程以及及输入Tensor形状 - 知乎 (zhihu.com)

![[自研开源] MyData v0.8.0 更新日志](https://img-blog.csdnimg.cn/direct/9ad8596a05214d688a39231352b20b98.png)