ICLR 2024 reviewer评分 6888

1 intro

- zero-shot prompt 在视觉-语言模型中,已经取得了令人印象深刻的表现

- 这一成功呈现出一个看似令人惊讶的观察:这些方法相对不太受过拟合的影响

- 即当一个提示被手动工程化以在给定训练集上达到低错误率时(从而使得该方法实际上不再是零次学习),该方法在保留的测试数据上仍然表现良好。

- 这一成功呈现出一个看似令人惊讶的观察:这些方法相对不太受过拟合的影响

- 论文试图从理论上解释这一点

- 使用了经典的 PAC-Bayes bound,结合prompt的离散属性,以及大语言模型给出了先验概率 (prior distribution)

- 能够得到非常紧的泛化误差

- ——>对一个已经预训练完毕的大语言模型做prompt engineering不会受到泛化误差的负面影响

- 实验证明,这对现有的手工制作的提示和通过简单贪婪搜索生成的提示都成立

2 方法部分

(方便部分很理论,没有特别深挖。。。)

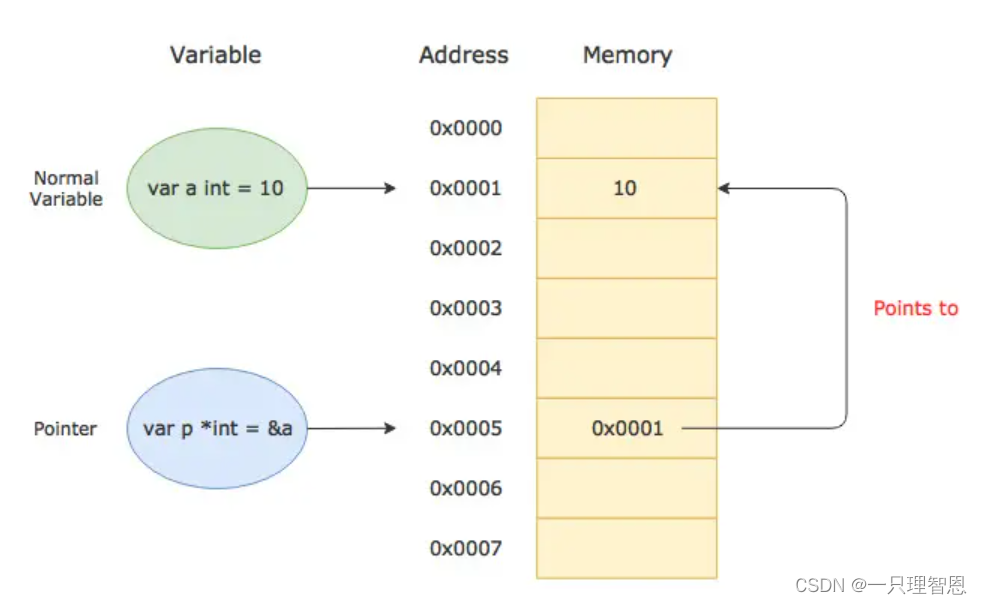

- 设计一个提示类似于在机器学习模型中找到一组权重,其中假设空间是文本/令牌的空间

- 目标是找到能够最大化训练准确率而不需要微调模型参数

- 可以被构想为在令牌空间V上的离散优化

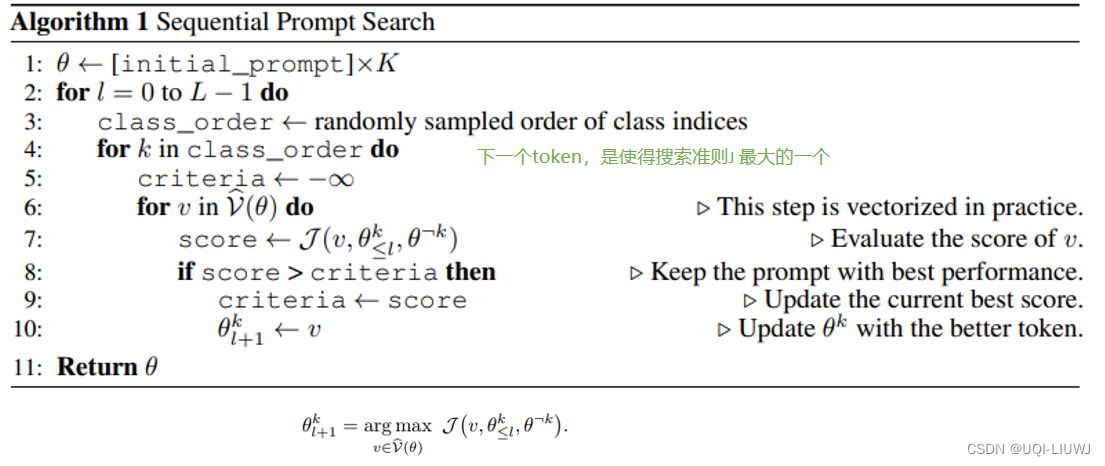

- 论文考虑一个简单的贪婪搜索算法,连续生成prompt

- 如果设计这个score,论文考虑了两种方式

- 经验风险最小化

- 通过PAC-Bayes进行结构风险最小化

- 经验风险最小化

3 实验

- 评估了通过贪婪生成的离散提示的泛化情况

3.1 实验结果

相较于所有3个数据集的最新技术,通过Greedy生成的离散提示实现了更紧的界限

- ‘即使是简单的UC界限,通过Greedy生成的离散提示也能在各种数据集上得到紧凑、非空泛的界限【紧密&在y=x下方】,而带有LLM先验的PAC-Bayes界限进一步改善了这些界限

现有文献中手工生成的prompt(启发式prompt)同样适用

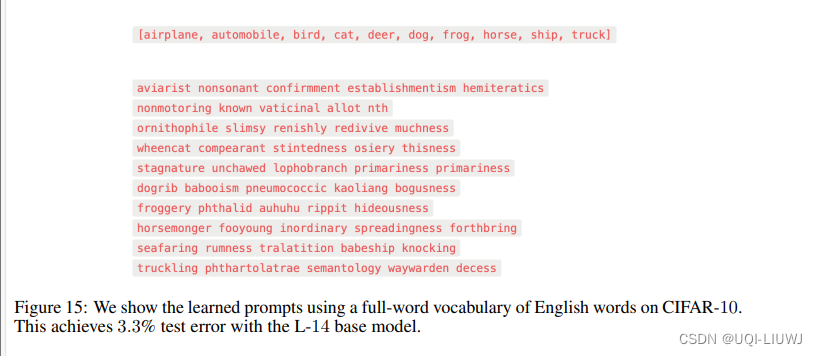

3.2 使用greedy的方式找到的prompt

4 结论

- 研究了在图像识别任务上prompt engineering的泛化属性

- 观察到一个令人惊讶的事实:提示工程似乎不会过度拟合,并且在测试分布上也表现良好。

- 手动提示工程【贪婪 or 手工】通常表现出令人惊讶的强大泛化行为