LLM的知识库问答有3种实现路径:RAG 或 微调,或两者结合。

- RAG:低成本易部署,适用于知识会更新的场景,但知识内容多的情况下,检索成本会变高。

- 微调:算力成本高,微调效果不稳定,训练不好容易出现幻觉,不适用于知识频繁更新场景,但调好后,LLM回复速度很可观。

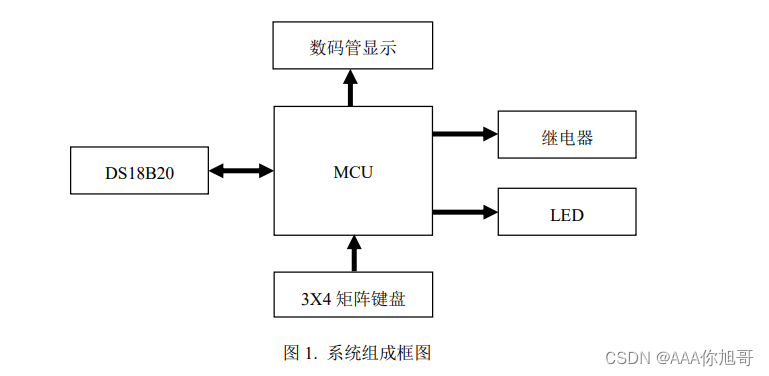

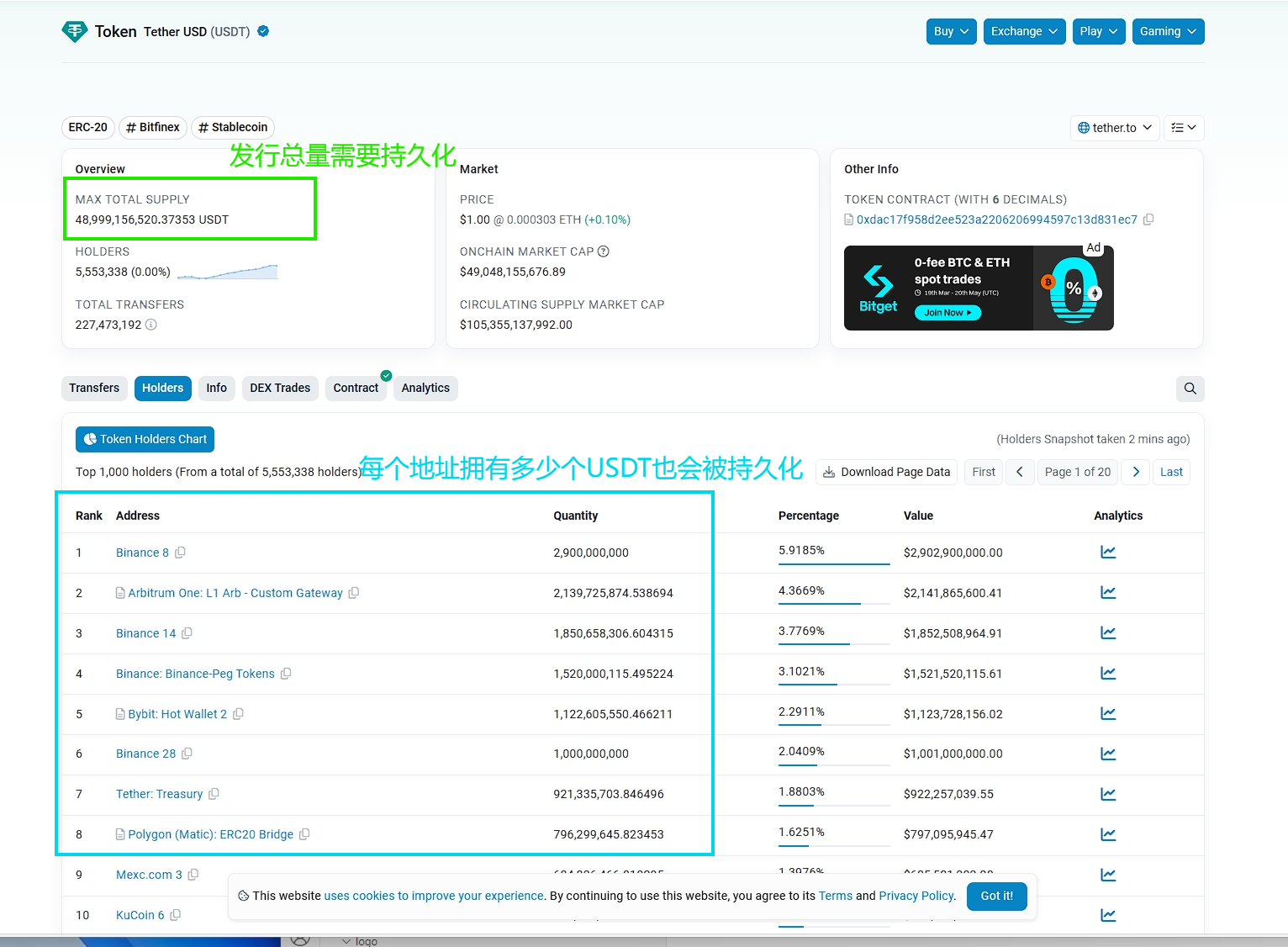

一种只适合采用外挂知识库而不适合采用微调方式的情况

对于已有的结构化数据,一定不要将其直接训练到大模型当中。

结构化数据,其实是已经进行了精确标注的数据,无论是数据的准确性、可解释性,都是大模型中的token所无法企及的,如果将这些结构化数据训练到大模型当中,极大可能会失去数据的各种标注属性,或者会弱化数据及其标注属性的强关联。

大语言模型的基础是机器学习,属于归纳法,要从海量的数据中发现规律,结果的可靠性、可解释性是它正在努力解决的问题,那么对于已经解决了这些问题的结构化的数据,如果重新混入大模型当中,则被认为是一种倒退,是损失。

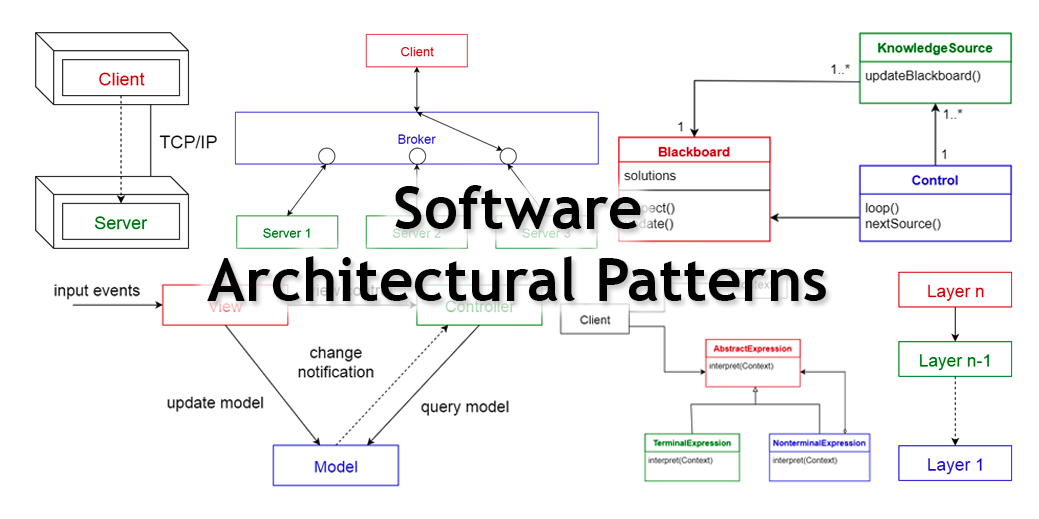

在基于大模型的整体应用架构中,大模型的作用到底应该如何定位?

从目前来看,大模型所起到的作用主要体现在两方面,一是推理能力,二是知识库。

按照大力出奇迹的思路,知识库越大,也就是模型参数规模越大,推理能力越强,当然成本也就越高。

是否存在另外一种选择,例如大语言模型,就发挥它的“词语接龙”的语言能力,用于对指令的理解意图和生成自然语言式的结果,而其中关键的内在专业逻辑或事实,则由外部知识库来提供,不要由大语言模型来“推理”,这样就将纯专业知识交给外挂知识库来管理,大语言模型则重点提升语言相关的能力,不断增强特定的话术和表达方式。概括一句话就是,大语言模型负责语言逻辑,外挂知识库负责领域中的专业逻辑。

19-1 LLM之野望 1 – 微软打开1-bit LLM时代

2024-04-05 16:20:05 34 阅读

![纯初中数学!快速幂[mod]](https://img-blog.csdnimg.cn/direct/c1a64cc71eb047bebf6d3bd84eb961f7.png)