深度学习模型在诸多领域如图像识别、自然语言处理、语音识别等展现出强大的应用潜力。然而,模型训练与实际部署是两个不同的环节,许多开发者在使用Python进行模型训练后,出于性能、集成便利性或特定平台要求等因素,会选择使用C++进行模型部署。本文将详细介绍如何利用C++来实现深度学习模型的部署。

一、准备阶段

模型导出

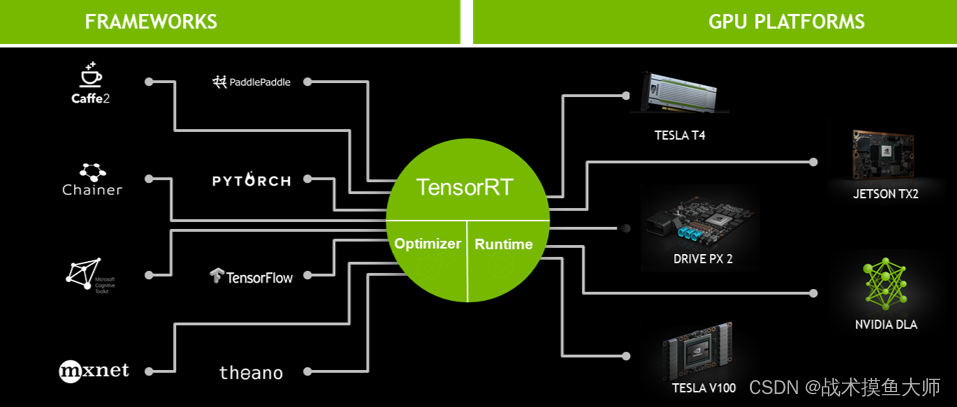

首先,你需要从训练环境中导出已训练好的深度学习模型。大部分深度学习框架(如TensorFlow、PyTorch、Keras等)都支持将模型转换为通用格式,以便于跨平台和语言使用。以下是一些常见模型格式:

- TensorFlow SavedModel 或 Frozen Graph: 使用

tf.saved_model.save()保存模型,或者通过freeze_graph.py脚本将模型冻结为一个包含权重的计算图。 - ONNX (Open Neural Network Exchange): 支持多种框架模型互转,包括PyTorch、TensorFlow等,便于跨平台部署。

- Caffe Model 或 Caffe2 Protobuf: 对于Caffe/Caffe2框架训练的模型,可以直接导出。

选择合适的格式导出模型,并确保所有必要的权重和结构信息都已保存。

- TensorFlow SavedModel 或 Frozen Graph: 使用

依赖库安装

在C++项目中部署深度学习模型,通常需要依赖相应的推理库。例如:

- TensorFlow C++ API: 如果你的模型是以TensorFlow格式保存,可以使用TensorFlow的C++库进行推理。

- PyTorch C++ Frontend (LibTorch): 对应PyTorch模型,LibTorch提供了完整的C++接口。

- ONNX Runtime: 对于ONNX模型,可使用ONNX Runtime进行高效推理。

- Caffe/Caffe2 C++ API: 若模型来自Caffe/Caffe2,直接使用对应的C++ API即可。

根据所选库的文档指引,正确安装并配置所需的依赖库。

C++以其高效的执行速度、贴近硬件的能力、灵活的内存管理以及支持面向对象编程等特点深受游戏开发者青睐。它可以用来编写底层图形渲染、物理模拟、网络通信等核心模块,这些模块构成了游戏引擎的基础架构。

为了帮助大家更好地入门并深入掌握C++,我们精心准备了一系列丰富的学习资源包,包括但不限于基础语法教程、实战项目案例、核心概念解析以及进阶技巧指导等。

您只扫码上方二维码,即可免费获取这份专属的学习礼包。我们的教程覆盖了C++语言的各个方面,旨在让您在理论学习与实践操作中不断进步,提升编程技能。

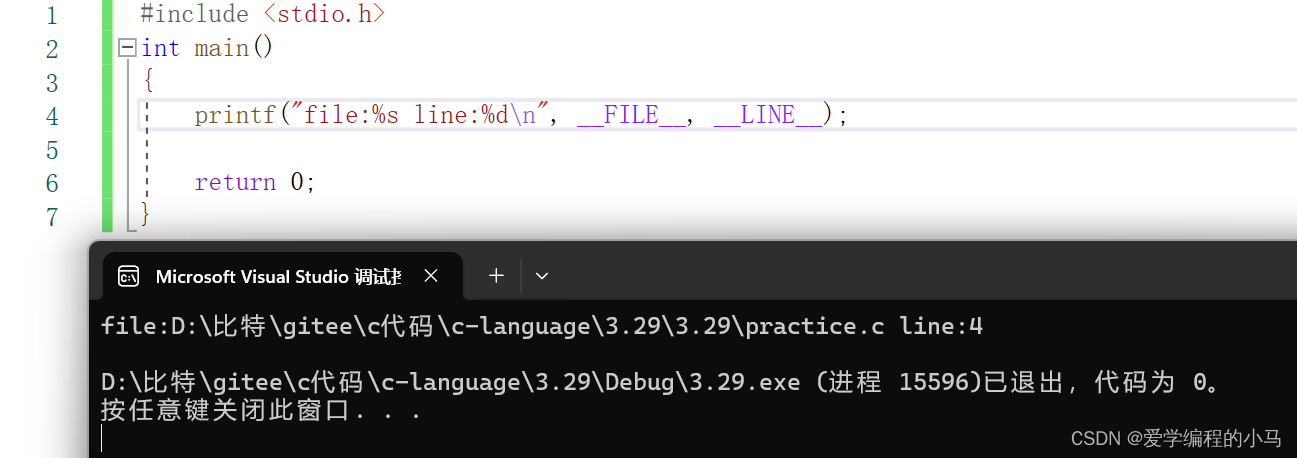

二、编写C++代码

加载模型

使用选定的库提供的API加载模型文件。以下是一些示例:

// TensorFlow

tensorflow::Session* session;

tensorflow::Status status = tensorflow::NewSession(tensorflow::SessionOptions(), &session);

status = session->Create(graph_def); // graph_def是从SavedModel/Frozen Graph读取的

// PyTorch (LibTorch)

torch::jit::script::Module module;

module = torch::jit::load(model_path);

// ONNX Runtime

Ort::Env env(ORT_LOGGING_LEVEL_WARNING, "test");

Ort::SessionOptions session_options;

Ort::Session session(env, model_path.c_str(), session_options);

// Caffe

caffe::Net<float> net;

net.CopyFromPROTOBUF(proto_file, trained_file);数据预处理

在C++端实现与训练时相同的数据预处理逻辑,确保输入数据格式、归一化等与模型期望一致。这可能涉及图像缩放、归一化、文本编码等操作。

执行推理

调用库提供的API执行模型推理。以下是各框架的示例:

// TensorFlow

std::vector<tensorflow::Tensor> outputs;

status = session->Run(inputs, {"output_node_name"}, {}, &outputs);

// PyTorch (LibTorch)

at::Tensor output = module.forward(inputs).toTensor();

// ONNX Runtime

Ort::AllocatorWithDefaultOptions allocator;

std::vector<const char*> input_names = {"input_node_name"};

std::vector<Ort::Value> input_tensors = {ort_utils::MakeTensor<float>(allocator, input_shape, input_data)};

std::vector<const char*> output_names = {"output_node_name"};

std::vector<Ort::Value> output_tensors;

session.Run(Ort::RunOptions{nullptr}, input_names.data(), input_tensors.data(), input_tensors.size(),

output_names.data(), output_tensors.data(), output_names.size());

// Caffe

net.Forward(&output_blobs);解析输出

将模型输出转化为实际应用所需的结果形式,如分类标签、回归值、检测框等,并应用于后续业务逻辑。

三、优化与部署

性能优化

利用库提供的异步推理、批处理、GPU加速等功能提升推理速度。注意调整线程池大小、内存分配策略等以适应实际硬件环境。

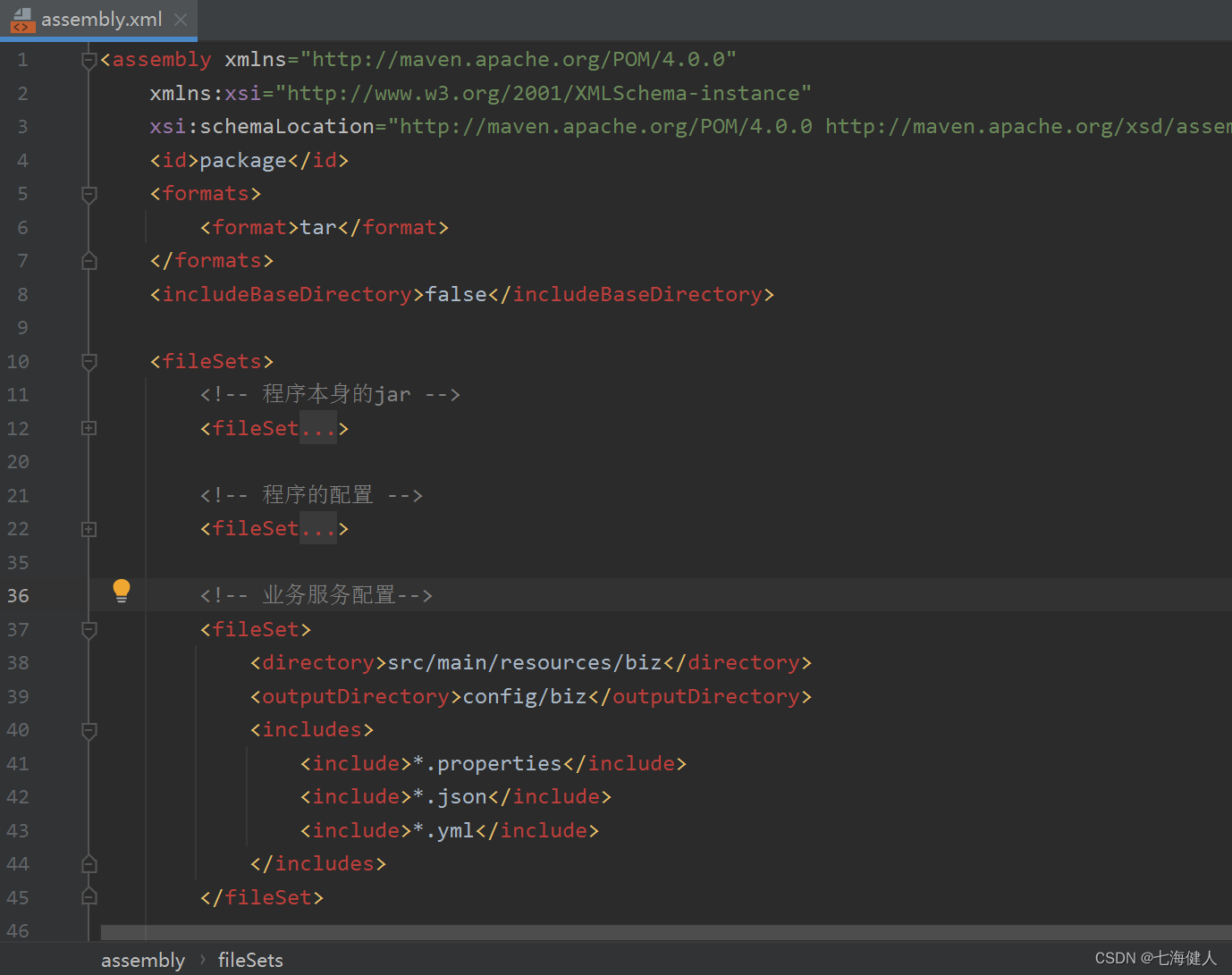

编译与打包

编译生成目标平台的可执行文件或动态链接库。对于嵌入式设备,可能需要交叉编译。确保所有依赖库一同打包或正确指定运行时库路径。

集成到应用程序

将模型推理模块无缝融入到现有的C++应用程序中,如桌面软件、服务器后台服务、嵌入式系统等。

总结,部署深度学习模型至C++环境涉及模型导出、依赖库安装、编写C++代码、性能优化、编译打包及集成等步骤。遵循上述指南,你可以成功地将训练好的深度学习模型运用到各类C++项目中,实现高性能、低延迟的实时推理。