很高兴为您撰写这篇题为《强化学习:让AI自主学习与决策》的技术博客文章。作为一位计算机领域的大师,我将以专业、深入、实用的角度来探讨强化学习的核心概念、算法原理、最佳实践以及未来发展趋势。让我们一起深入了解这项革命性的人工智能技术。

1. 背景介绍

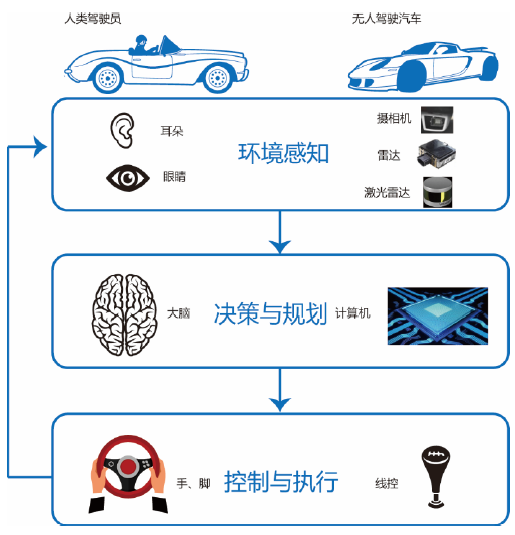

强化学习是人工智能领域中一种非常重要的学习范式。与监督学习和无监督学习不同,强化学习关注如何通过与环境的交互,让智能体自主学习并做出最优决策。这种学习方式模拟了人类和动物的学习过程,通过反复尝试、获取奖赏或惩罚,逐步优化自身的行为策略,最终达到预期目标。

强化学习已经在各种复杂的决策问题中展现出巨大的潜力,从游戏AI、机器人控制、资源调度到个性化推荐等,强化学习都有广泛的应用。随着硬件计算能力的不断提升以及相关算法的不断进步,强化学习将在未来扮演更加重要的角色,让AI系统能够更加自主、灵活地学习和决策。

2. 核心概念与联系

强化学习的核心概念包括:

2.1 智能体(Agent):能够感知环境并采取行动的主体,如机器人、游戏AI等。

2.2 环境(Environment):智能体所处的外部世界,包括各种状态和可供选择的行动。

2.3 状态(State):智能体观察到的环境信息,是智能体决策的依据。

2.4 行动(Action):智能体可以选择执行的动作。

2.5 奖赏(Reward):智能体执行某个行动后获得的反馈信号,用于评估该行动的好坏。

2.6 价值函数(Value Function):预测智能体从当前状态出发,将来能获得的累积奖赏。

2.7 策略(Policy):智能体在给定状态下选择行动的概率分布。

这些核心概念之间存在着密切的联系。智能体根据当前状态,选择执行某个行动,并根据获得的奖赏来更新价值函数和策略,最终学习出一个最优的决策策略。

3. 核心算法原理和具体操作步骤

强化学习的核心算法主要包括:

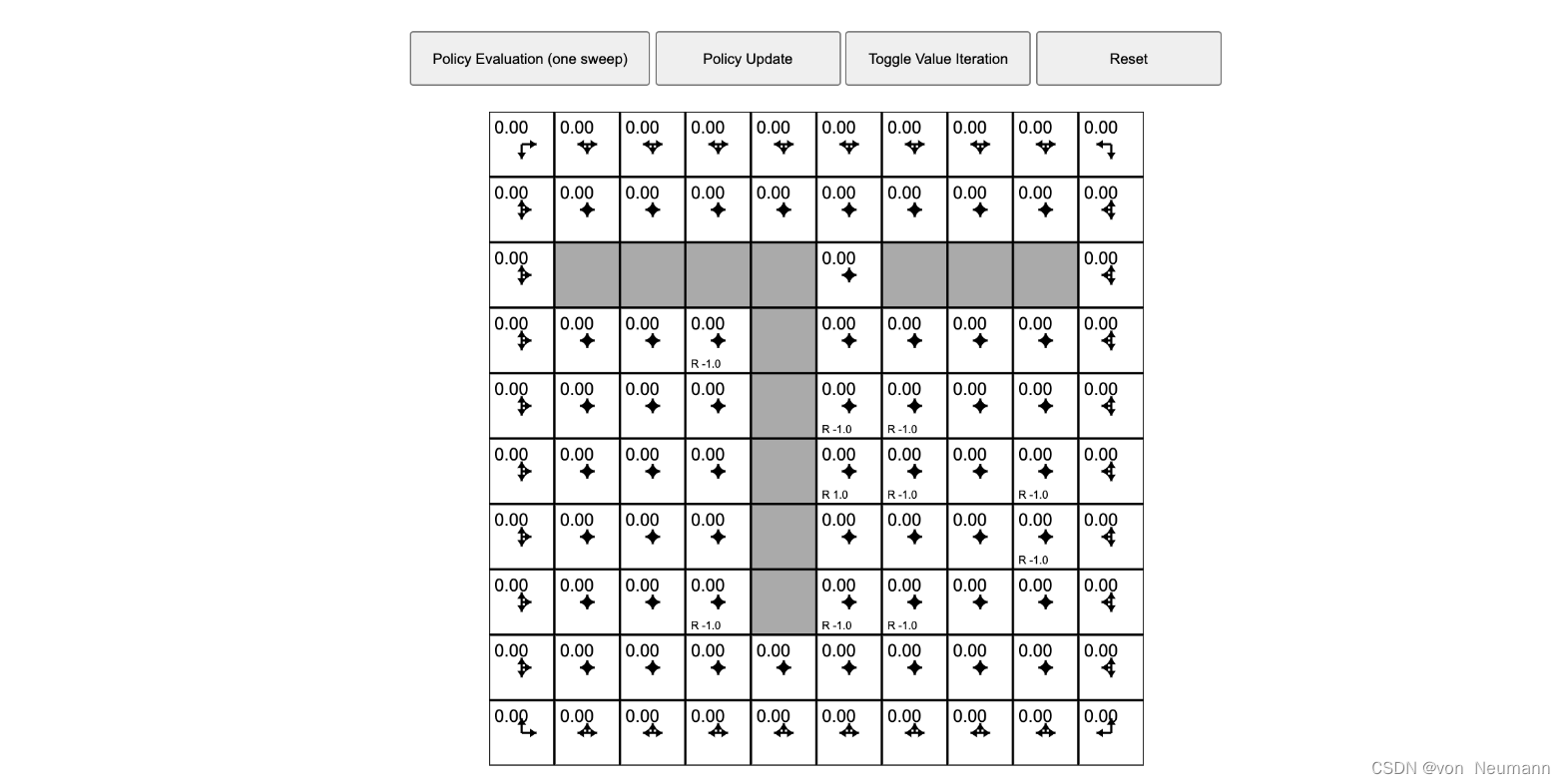

3.1 动态规划(Dynamic Programming): 动态规划是解决马尔科夫决策过程(MDP)的经典方法,通过递归地计算状态价值,得到最优策略。主要算法有值迭代和策略迭代。

$$V(s) = \max_a \left[ R(s,a) + \gamma \sum_{s'} P(s'|s,a)V(s') \right]$$

3.2 时间差分学习(Temporal-Difference Learning): 时间差分学习是一种无模型的强化学习算法,通过观察状态转移和奖赏,逐步修正价值函数的估计,主要算法有TD(0)、Q-learning和SARSA。

$$Q(s,a) \leftarrow Q(s,a) + \alpha [r + \gamma \max_{a'} Q(s',a') - Q(s,a)]$$

3.3 蒙特卡洛方法(Monte Carlo Methods): 蒙特卡洛方法通过大量随机模拟,统计样本回报,得到状态价值的无偏估计。主要算法有首次访问MC和每次访问MC。

$$G_t = \sum_{k=t+1}^T \gamma^{k-t-1}R_k$$ $$V(S_t