Transformer的前世今生 day01(预训练

- 开发

- 16

-

预训练

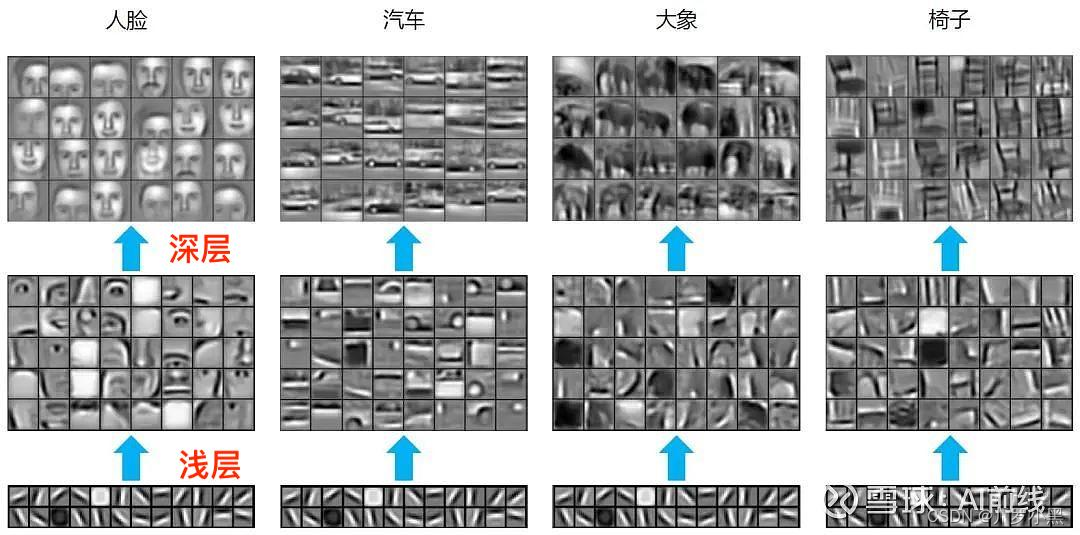

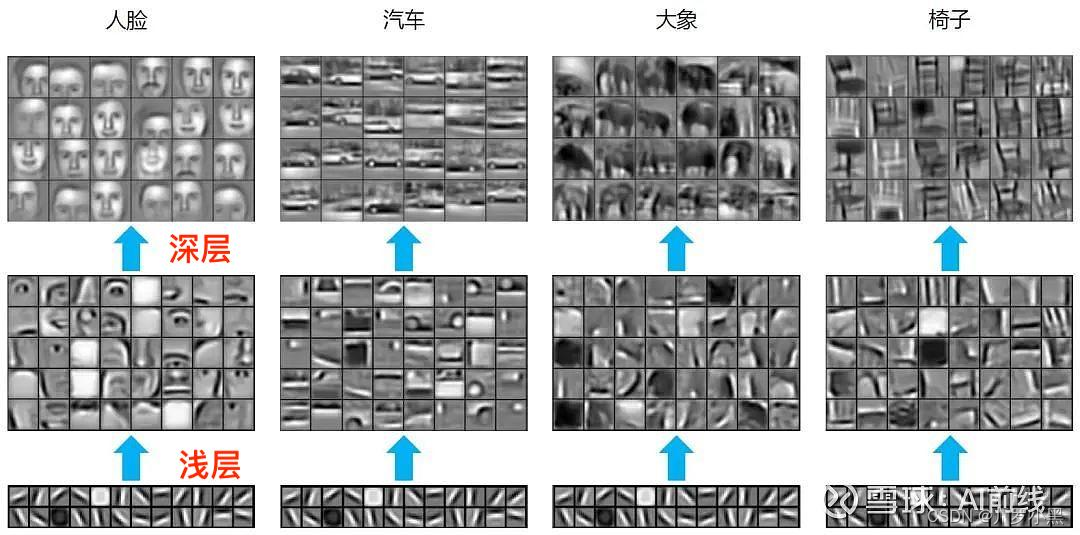

- 在相似任务中,由于神经网络模型的浅层是通用的,如下图:

- 所以当我们的数据集不够大,不能产生性能良好的模型时,可以尝试让模型B在用模型A的浅层基础上,深层的部分自己生成参数,减小数据集的压力

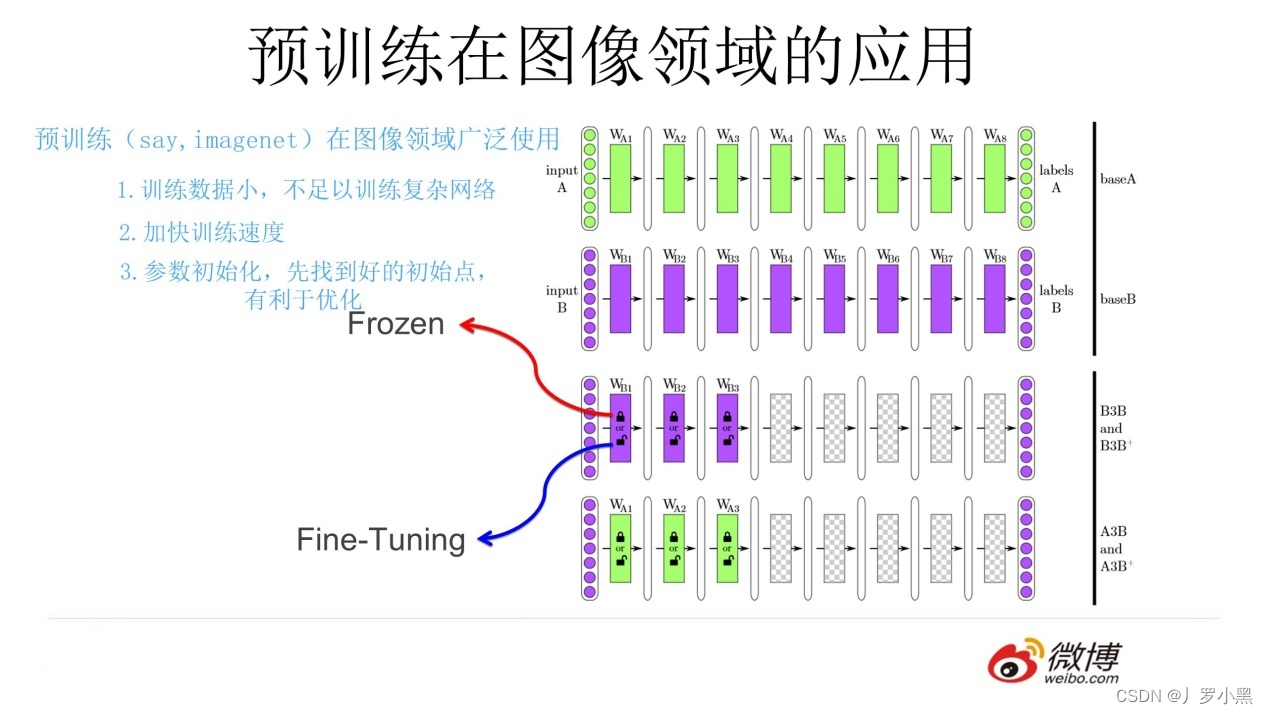

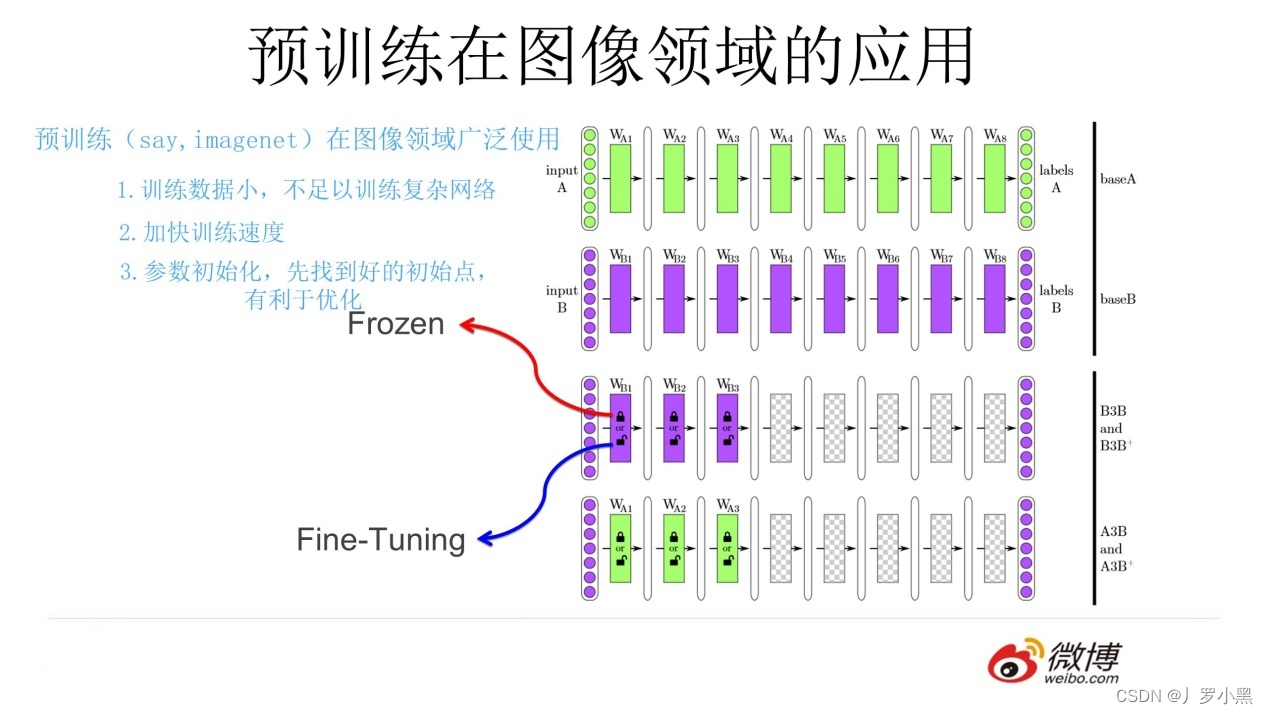

- 使用模型A的浅层来实现任务B,由两种方式:

- 冻结(frozen):浅层参数不变

- 微调(Fine-Tuning):浅层参数会跟着任务B的训练而改变

- 总结:一个任务A,一个任务B,两者极其相似,任务A已经通过大数据集训练出一个模型A,使用模型A的浅层参数去训练任务B,得到模型B。

原文地址:https://blog.csdn.net/u011453680/article/details/136748564

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。

本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:https://www.suanlizi.com/kf/1768885415114313728.html

如若内容造成侵权/违法违规/事实不符,请联系《酸梨子》网邮箱:1419361763@qq.com进行投诉反馈,一经查实,立即删除!