【PyTorch】进阶学习:BCEWithLogitsLoss在多标签分类任务中的正确使用—logits与标签形状指南

🌈 个人主页:高斯小哥

🔥 高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程👈 希望得到您的订阅和支持~

💡 创作高质量博文(平均质量分92+),分享更多关于深度学习、PyTorch、Python领域的优质内容!(希望得到您的关注~)

🌵文章目录🌵

🔥一、PyTorch进阶学习:BCEWithLogitsLoss初探

在深度学习的旅程中,我们经常会遇到各种各样的损失函数。对于多标签分类任务,BCEWithLogitsLoss是一个常用的损失函数。在PyTorch中,BCEWithLogitsLoss结合了Sigmoid层和二元交叉熵损失(Binary Cross Entropy Loss),使得在训练过程中能够直接接收未经过Sigmoid激活的logits作为输入,从而提高计算效率。

首先,我们需要了解BCEWithLogitsLoss的基本原理。它主要用于处理二分类问题,但在多标签分类任务中,通过扩展每个标签为一个独立的二分类问题,也可以得到应用。

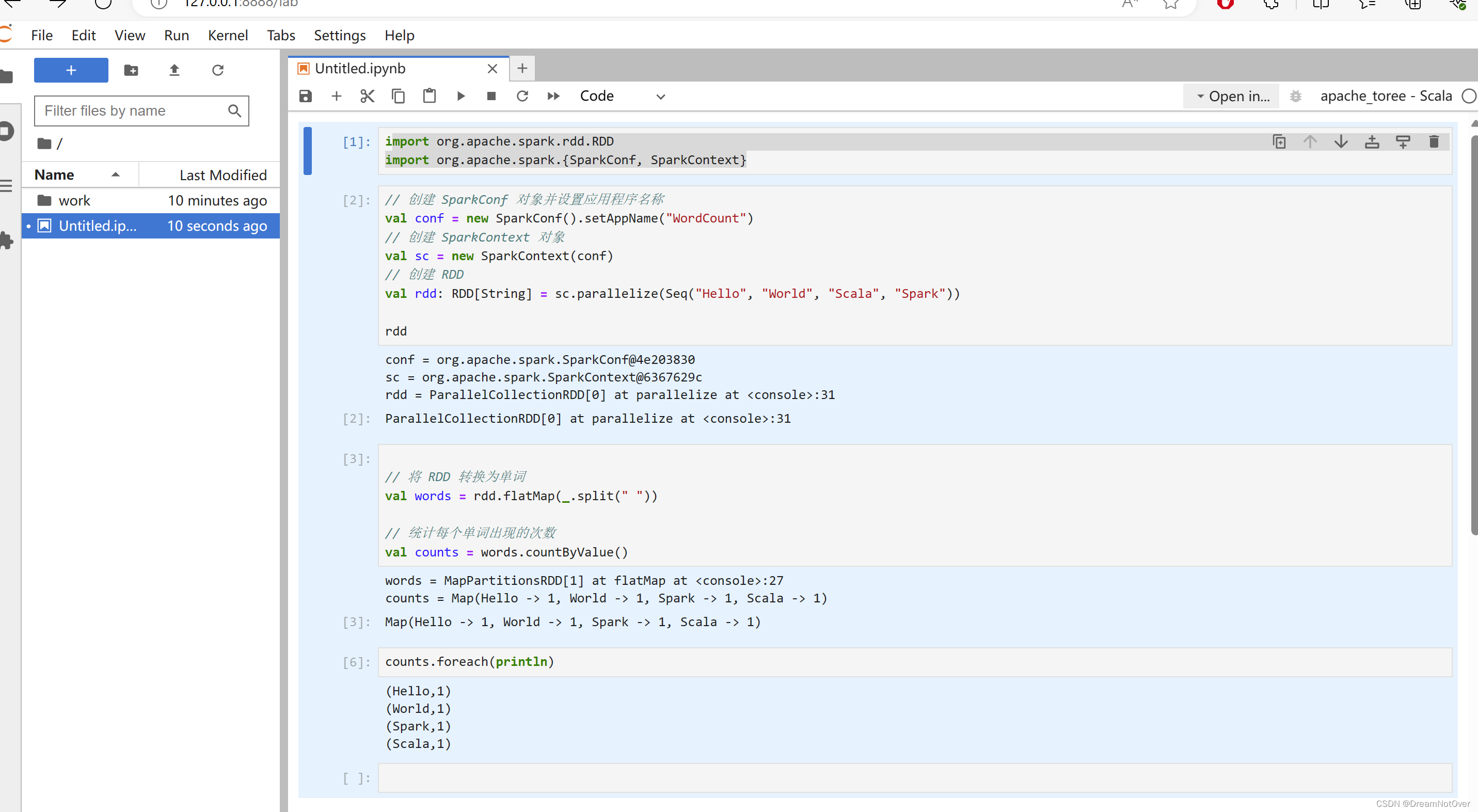

接下来,我们通过代码示例来演示如何在PyTorch中使用BCEWithLogitsLoss。

import torch

import torch.nn as nn

import torch.optim as optim

# 假设有一个batch的样本,每个样本有3个标签

num_samples = 10

num_labels = 3

# 随机生成logits,形状为[batch_size, num_labels]

logits = torch.randn(num_samples, num_labels)

# 随机生成标签,形状也为[batch_size, num_labels],每个标签为0或1

labels = torch.randint(0, 2, (num_samples, num_labels))

# 实例化BCEWithLogitsLoss

criterion = nn.BCEWithLogitsLoss()

# 计算损失

loss = criterion(logits, labels)

# 打印损失值

print(f"Loss: {loss.item()}")

在上面的代码中,我们创建了一个随机的logits张量和标签张量,并使用BCEWithLogitsLoss来计算损失。注意,logits和标签的形状都是[batch_size, num_labels],这是多标签分类任务中常见的形状。

🧠二、深入理解logits与标签的形状

在多标签分类任务中,每个样本可能同时属于多个类别。 因此,我们的模型需要为每个类别输出一个预测值(即logits),并且我们需要为每个类别提供一个标签。这就是为什么logits和标签的形状都是[batch_size, num_labels]的原因。

logits表示模型对每个类别的原始预测分数,而标签则表示每个样本真实所属的类别。在计算损失时,BCEWithLogitsLoss会对logits应用Sigmoid函数,并将其与标签进行比较,从而得到每个类别的损失,并最终将这些损失求和得到总损失。

🚀三、优化器与训练过程

在训练过程中,我们除了需要定义损失函数外,还需要一个优化器来更新模型的参数。以下是一个简单的训练循环示例:

# 定义模型

model = nn.Linear(input_dim, num_labels)

# 定义优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 假设我们有一些输入数据X

X = torch.randn(num_samples, input_dim)

# 训练循环

for epoch in range(num_epochs):

# 前向传播

logits = model(X)

# 计算损失

loss = criterion(logits, labels)

# 反向传播

optimizer.zero_grad()

loss.backward()

# 更新参数

optimizer.step()

# 打印损失值

print(f"Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}")

在这个示例中,我们定义了一个简单的线性模型,并使用Adam优化器进行参数更新。在每个epoch中,我们执行前向传播、计算损失、反向传播和参数更新。

📈四、评估模型性能

在训练过程中,我们通常会在验证集上评估模型的性能。对于多标签分类任务,我们可能会使用准确率、精确率、召回率或F1分数等指标来评估模型。这些指标可以帮助我们更全面地了解模型的表现。

在PyTorch中,我们可以使用sklearn.metrics模块来计算这些指标。以下是一个简单的示例:

from sklearn.metrics import classification_report

# 假设我们有模型在验证集上的预测结果preds和真实标签val_labels

preds = model(val_X) # val_X是验证集上的输入数据

preds = (preds > 0.5).float() # 应用阈值得到最终的预测标签

# 计算分类报告

report = classification_report(val_labels.view(-1).long(), preds.view(-1).long(), target_names=label_names)

print(report)

🎨五、优化BCEWithLogitsLoss的使用

虽然BCEWithLogitsLoss是一个强大的损失函数,但在实际使用中,我们可能需要进行一些调整以优化其性能。

首先,需要注意的是,BCEWithLogitsLoss在计算损失时已经内部集成了Sigmoid函数,因此在模型输出后不需要再手动应用Sigmoid。这有助于减少计算量并提高数值稳定性。

其次,对于不平衡的数据集,我们可能需要调整损失函数的权重。BCEWithLogitsLoss允许我们为每个类别指定不同的权重,以便更好地处理类别不平衡的问题。通过为少数类别分配更高的权重,我们可以使模型更加关注这些类别,并尝试提高它们的预测性能。

最后,我们还可以尝试调整损失函数的超参数,如权重衰减(weight decay)或正则化项,以进一步控制模型的复杂度并防止过拟合。

🔍六、调试与错误排查

在使用BCEWithLogitsLoss时,我们可能会遇到一些错误或异常。以下是一些常见的问题及其解决方案:

形状不匹配:确保logits和标签的形状完全匹配。它们都应该具有相同的batch_size和num_labels。

数据类型问题:logits和标签的数据类型应该是

torch.float。如果标签是整数类型,你需要将其转换为浮点数。数值稳定性:在某些情况下,logits的值可能非常大或非常小,这可能导致数值不稳定。你可以尝试对logits进行裁剪(clipping)或使用其他技术来提高数值稳定性。

梯度爆炸或消失:如果损失函数变得非常大或非常小,这可能会导致梯度爆炸或消失。你可以尝试调整学习率或使用其他优化技术来解决这个问题。

当遇到错误时,请仔细阅读错误信息并检查你的代码。使用打印语句(print statements)来检查logits和标签的形状和值,这有助于你定位问题所在。

📚七、总结与进一步学习

通过本博客的学习,我们深入了解了如何在PyTorch中使用BCEWithLogitsLoss来处理多标签分类任务。我们讨论了logits和标签的形状要求,并j展示了如何在训练循环中使用这个损失函数。此外,我们还探讨了优化损失函数使用的一些策略以及常见的调试和错误排查技巧。

为了进一步深入学习,你可以查阅PyTorch的官方文档以获取更多关于BCEWithLogitsLoss的详细信息。你还可以尝试将其应用于其他多标签分类任务,并探索不同的模型架构和优化策略。

希望本博客对你有所帮助,并激发你对深度学习和PyTorch的进一步探索的兴趣!😊