局部加权回归(Local Weighted Regression)是一种非参数回归方法,用于解决线性回归模型无法很好拟合非线性数据的问题。它通过给不同的样本赋予不同的权重,使得在拟合模型时更加关注靠近目标点附近的样本数据。

局部加权回归的基本思想是对于给定的目标点,通过定义一个权重函数,对样本点进行加权,并利用加权的样本点来拟合回归模型。在预测新的数据点时,同样使用权重函数,对附近的样本点进行加权平均得到预测值。

局部加权回归的权重函数通常选择高斯核函数或者三角核函数,这些函数都是以目标点为中心的对称函数。权重函数的选择决定了拟合模型时对不同样本点的关注程度。对于靠近目标点的样本点,赋予较高的权重;对于远离目标点的样本点,赋予较低的权重。

局部加权回归具有灵活性和非线性建模能力,但是它也有一些缺点。由于每个目标点的回归模型都是针对附近的样本点进行建模的,因此在预测新的数据时,需要重新计算权重并进行局部拟合,计算量较大。另外,由于每个样本点都有可能参与到不同的目标点的回归模型中,因此在整体上缺乏稳定性。

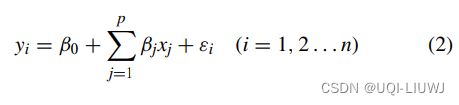

局部加权回归的原理如下:

1. 给定一个目标点(待预测的数据点)和样本数据集。

2. 定义一个权重函数,通常选择高斯核函数或者三角核函数。该权重函数以目标点为中心,根据距离进行加权。靠近目标点的样本点被赋予较大的权重,远离目标点的样本点被赋予较小的权重。

3. 对于每个目标点,根据样本数据集中的样本点与目标点的距离以及权重函数的值,计算样本点的权重。

4. 根据样本点的权重,使用加权最小二乘法进行回归模型的拟合。通常使用线性回归模型。

5. 得到回归模型后,预测新的数据点时,使用相同的权重函数计算目标点附近样本点的权重,根据权重对样本点进行加权平均,得到预测值。

局部加权回归的关键在于权重函数的选择和权重的计算。通常可以根据实际问题进行调整,使得模型更加适应数据的分布。需要注意的是,由于每个目标点的回归模型都是针对附近的样本点进行建模的,因此在预测新的数据时,需要重新计算权重并进行局部拟合,计算量较大。另外,由于每个样本点都有可能参与到不同的目标点的回归模型中,因此在整体上缺乏稳定性。

局部加权回归具有以下几个特点:

1. 非参数性:局部加权回归不需要对数据的分布做出任何假设,不需要对数据进行参数化建模。因此,它可以适用于各种类型的数据,适用于非线性关系的数据。

2. 非线性性:由于权重函数的存在,局部加权回归可以捕捉到数据中的非线性关系。通过调整权重函数的形状和参数,可以更好地适应数据的特点。

3. 高灵活性:由于每个目标点都有自己的回归模型,因此局部加权回归非常灵活。它可以根据数据的不同情况,对不同的目标点进行不同的回归拟合。

4. 局部性:局部加权回归仅使用附近的样本点来拟合目标点的回归模型。因此,它更关注目标点周围的局部特征,对离目标点较远的样本点的影响较小。这使得局部加权回归对异常值或离群点的影响相对较小。

5. 计算量大:由于每个目标点都需要重新计算权重并进行局部拟合,局部加权回归的计算量较大。尤其当样本数据集较大时,计算时间会显著增加。

6. 缺乏稳定性:每个样本点都有可能参与到不同的目标点的回归模型中,导致在整体上缺乏稳定性。这使得局部加权回归对样本点的选取和权重的确定比较敏感。

总之,局部加权回归是一种灵活且适应性强的方法,能够捕捉到非线性关系,对异常值不敏感,但在计算量和稳定性方面存在一定的问题。

局部加权回归在以下情况下常常被使用:

1. 非线性关系建模:当数据中存在着非线性关系时,局部加权回归可以更好地捕捉到这种关系。比如,当自变量和因变量之间存在着曲线形状的关系时,局部加权回归可以提供更准确的拟合。

2. 异常值处理:局部加权回归对于异常值或离群点的影响较小,因为它主要关注目标点周围的局部特征。因此,当数据中存在着异常值或离群点时,局部加权回归可以提供更稳健的回归结果。

3. 非参数回归:局部加权回归不需要对数据的分布做出任何假设,不需要参数化建模。因此,它适用于各种类型的数据,即使数据的分布不符合常见的统计模型,也可以通过局部加权回归进行拟合。

4. 非平稳数据分析:当数据具有局部非平稳性时,局部加权回归可以用于分析数据中的局部特征。例如,时间序列数据中可能存在着局部趋势、季节性或周期性,局部加权回归可以用来建模和预测这些局部特征。

5. 数据探索和可视化:局部加权回归可以用于对数据进行探索和可视化。通过在数据中绘制局部加权回归的拟合曲线,可以更直观地观察到数据的趋势和关系,帮助分析人员进行更深入的数据理解。

总而言之,局部加权回归是一种适用于多种场景的非参数回归方法,特别适用于非线性关系建模、异常值处理、非平稳数据分析以及数据探索和可视化等应用。

下面是一个简单的局部加权回归的Python代码示例,用于拟合一组带有噪声的非线性数据:

import numpy as np

import matplotlib.pyplot as plt

def local_weighted_regression(x, y, query_point, tau):

m = len(x)

weights = np.exp(-0.5 * ((x - query_point) / tau) ** 2)

X = np.column_stack((np.ones(m), x))

W = np.diag(weights)

theta = np.linalg.inv(X.T @ W @ X) @ X.T @ W @ y

return theta[0] + theta[1] * query_point

# 生成带噪声的非线性数据

np.random.seed(0)

x = np.linspace(-5, 5, 100)

y = np.sin(x) + np.random.normal(0, 0.2, 100)

# 设定tau参数

tau = 0.5

# 针对每个x点进行局部加权回归拟合

pred_y = [local_weighted_regression(x, y, query_point, tau) for query_point in x]

# 绘制原始数据和拟合曲线

plt.scatter(x, y, label='Original Data')

plt.plot(x, pred_y, color='red', label='Locally Weighted Regression')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.show()

该代码使用了高斯核函数作为权重,通过调整tau参数可以控制拟合曲线的平滑程度。在这个例子中,我们使用sin函数生成了带有噪声的非线性数据,并使用局部加权回归来拟合数据,最终将原始数据和拟合曲线绘制在同一张图上进行对比。