本文将深入探讨Spark DataFrame的底层逻辑、发展由来以及应用场景。通过了解DataFrame的底层逻辑,我们可以更好地理解其在Spark中的重要地位。同时,了解DataFrame的发展历程和应用场景,可以帮助我们更好地掌握这一强大的数据处理工具,并在实际工作中加以运用。

DataFrame的底层逻辑

- RDD基础:DataFrame基于RDD(弹性分布式数据集),是对RDD的进一步封装。RDD是Spark的核心数据结构,它代表一个不可变、可分区、里面的元素可计算的弹性数据集。

- 模式信息:与RDD相比,DataFrame提供了模式信息,即列的名称和类型。这种模式信息使得Spark SQL可以进行执行优化。

- DAG执行:DataFrame的各种变换操作采用惰性机制,只是记录了各种转换的逻辑转换路线图(DAG图),不会发生真正的计算。这个DAG图相当于一个逻辑查询计划,最终会被翻译成物理查询计划,生成RDD DAG,按照之前介绍的RDD DAG的执行方式去完成最终的计算得到结果。

DataFrame的发展由来

- 前身:SchemaRDD。在Spark 1.3.0之前,称为SchemaRDD,之后更名为DataFrame。

- 特点:DataFrame是Spark对大规模结构化数据处理需求的不断演进和优化的结果,为Spark提供了更高效、更灵活、更强大的数据操作能力。

- 优势:与RDD和Dataset相比,DataFrame提供了更丰富的数据操作功能和更高的查询效率。同时,DataFrame可以轻松集成多种数据源,如CSV、Excel、JSON、SQL等,为数据分析和处理提供了便利。

DataFrame的应用场景

- 数据清洗和处理:利用DataFrame提供的函数和操作,可以方便地处理缺失值、重复值和异常值,进行数据清洗和预处理。

- 数据探索和可视化:通过DataFrame,用户可以快速了解数据的分布、统计信息等,并进行可视化展示和图表制作。

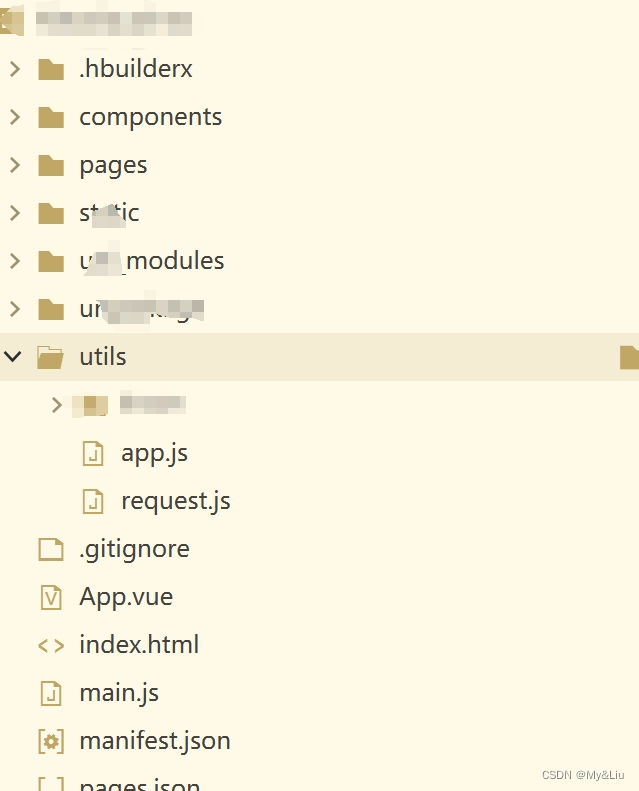

- 数据转换和整合:借助DataFrame的多数据源导入和导出功能,可以实现不同数据格式和来源的数据转换和整合。

- 机器学习和数据分析:通过DataFrame进行特征工程、模型训练和评估等操作,实现机器学习和数据分析任务。

- 批处理和流处理:利用DataFrame进行批处理和流处理,满足实时数据处理和分析的需求。