🏆作者简介,普修罗双战士,一直追求不断学习和成长,在技术的道路上持续探索和实践。

🏆多年互联网行业从业经验,历任核心研发工程师,项目技术负责人。

🎉欢迎 👍点赞✍评论⭐收藏

大数据知识专栏学习

文章目录

- 🏆初识大数据应用知识

-

- 🔎一、初识大数据应用知识(13)

-

- 🍁 🍁 01、Hdfs的写操作了解吗?

- 🍁 🍁 02、Hdfs的体系结构?

- 🍁 🍁 03、mapreduce的原理?

- 🍁 🍁 04、HBase的特点是什么?

- 🍁 🍁 05、Hive有哪些保存元数据的方式,各有什么特点?

- 🍁 🍁 06、如何创建topic,执行命令是什么?

- 🍁 🍁 07、Combiner出现在哪个过程?

- 🍁 🍁 08、HDFS写文件的步骤是什么?

- 🍁 🍁 09、Hdfs-site.xml的3个主要属性?

- 🍁 🍁 10、简述hive中的虚拟列的作用?使用它注意事项?

- 🍁 🍁 11、用mapreduce怎么处理数据倾斜问题?

- 🍁 🍁 12、怎么保证Kafka集群的负载均衡?

- 🍁 🍁 13、NAS(网络附加存储)和HDFS之间的主要区别是什么?

- 🍁 🍁 14、请描述一下开发过程中如何对上面的程序进行性能分析?

- 🍁 🍁 15、请简述mapreduce中的combine和partition的作用?

🏆初识大数据应用知识

🔎一、初识大数据应用知识(13)

🍁 🍁 01、Hdfs的写操作了解吗?

是的,我了解 HDFS 的写操作。

HDFS(Hadoop Distributed File System)是一个分布式文件系统,用于存储和处理大规模数据集。它的设计目标之一是支持高吞吐量的数据访问。

在 HDFS 中进行写操作通常包括以下步骤:

- 客户端连接到 HDFS,向 NameNode 发送写操作请求。

- NameNode 接收到写操作请求后,会进行一些处理,如验证权限和检查文件是否存在。

- 如果文件不存在或需要创建新文件,则 NameNode 会选择一个合适的 DataNode 来创建文件。

- 客户端与被选中的 DataNode 建立连接,并向其发送写入数据块的请求。

- DataNode 接收到写入数据块的请求后,会进行一些处理,如分配一个唯一的块 ID,并将块 ID 和待写入的数据块写入本地磁盘。

- 客户端将数据块分割成一个个数据包,并逐个发送给 DataNode。DataNode 接收到每个数据包后,会将其写入本地磁盘,并对写入的副本进行复制。

- 在完成数据包的发送和写入后,客户端发送一个写操作完成的请求给 NameNode。

- NameNode 接收到写操作完成的请求后,会更新文件的元数据,包括文件的最后修改时间和块信息。

HDFS 的写操作特点:

- 写入数据块是一步步进行的,先将数据块写入本地磁盘,然后再进行复制,这样可确保数据的持久性和可靠性。

- HDFS 支持数据块的并发写入,即多个客户端可以同时向不同的 DataNode 写入数据块,提高写入吞吐量。

- HDFS 通过默认的副本机制实现数据的冗余存储,确保数据的可靠性和容错性。

需要注意的是,HDFS 在设计上更适合进行大数据集的批量写入,对小文件频繁地写入操作可能效率较低。此外,HDFS 还提供了额外的文件追加和修改操作,用于在现有文件上追加或修改数据。

🍁 🍁 02、Hdfs的体系结构?

HDFS(Hadoop Distributed File System)的体系结构是一个基于主从架构的分布式文件系统,它将数据存储在由多个节点组成的集群中。

HDFS 的体系结构包括以下几个关键组件:

NameNode(名称节点):

- NameNode 是 HDFS 的主节点,负责管理文件系统的命名空间和存储元数据(metadata)。

- 它维护了所有文件和目录的层次结构,包括文件的名称、权限、位置等信息。

- NameNode 还负责调度和管理数据块的复制,以实现容错和可靠性。

DataNode(数据节点):

- DataNode 是 HDFS 的从节点,负责存储实际的数据块(data blocks)。

- 它根据 NameNode 的指令,将数据块写入本地磁盘,并对数据块进行复制和维护。

- DataNode 定期向 NameNode 汇报本地存储的状态和可用性。

Secondary NameNode(辅助名称节点):

- Secondary NameNode 并不是一个真正的备份 NameNode,而是一个辅助 NameNode。

- 它定期从 NameNode 处获取元数据的快照,并保存在本地磁盘上,用于在 NameNode 发生故障时进行恢复。

- Secondary NameNode 通过辅助 NameNode 修改 NameNode 的内存状态,以减少 NameNode 的内存使用量。

客户端:

- 客户端是与 HDFS 交互的应用程序或用户。

- 它们可以通过 HDFS 提供的 API,向 Hadoop 集群发送读、写或其他操作请求,并获取数据块或文件的内容。

HDFS 的工作流程:

- 客户端连接到 NameNode,并向其发送文件操作请求。

- NameNode 响应并提供所请求的文件的元数据,包括文件的块信息和 DataNode 的位置。

- 客户端直接与 DataNode 通信进行数据的读取或写入操作。

- DataNode 按照指令执行读写操作,并返回结果给客户端。

HDFS 的体系结构允许在大规模的集群上存储和处理大量的数据,同时提供了高可靠性和容错性,适用于适合批量处理和数据分析的场景。

🍁 🍁 03、mapreduce的原理?

MapReduce 是一种基于分布式计算的编程模型和计算框架,旨在处理大规模数据集。它采用两个主要阶段的计算:Map 和 Reduce,这两个阶段的计算可在大规模的集群上并行执行。

MapReduce 的处理过程可概括为以下四个步骤:

Input Split:

- 原始数据被拆分成大小相等的块(input splits),这使得它们可以并行处理。

Map:

- MapReduce 首先对这些块进行并行 Map 处理,在此阶段中,输入数据被转换为一组 Key/Value 对,并对每个 Key/Value 对执行一组 Map 函数。

- 可以通过 Map 函数实现对数据块的变换、过滤和提取。Map 函数将该输入数据集中的每个键值对映射到零个或多个新的键值对,并输出到另外一个集合中。

Shuffle and Sort:

- 在 Map 阶段输出的 Key/Value 对被分组并按 Key 进行排序,以生成为 Reduce 准备的 Partition 列表。

- Shuffle and Sort 阶段通过将 Map 输出分配到 Reduce 任务的基础框架中来协调 Map 和 Reduce 之间的数据交换,将 Map 的输出按照 Key 进行归并排序,并将结果输出到 Reduce 阶段。

Reduce:

- 最后,Reduce 阶段执行聚合操作,将所有具有相同 Key 的 Value 进行聚合并进行最终结果的输出。

- Reduce 函数通过迭代任务的 Key 列表并应用一组 Reduce 函数来处理所有这些分组数据,以产生输出值。

通过这些步骤,MapReduce 提供了一种可靠的方式来处理海量数据,同时在分布式环境中提供高可用性和高可扩展性。MapReduce 能够自动管理集群的分区、错误处理和重新执行,使得用户可以专注于业务逻辑的开发与算法的实现,而不必关心分布式环境的复杂性。

🍁 🍁 04、HBase的特点是什么?

HBase 是一个基于 Hadoop 的分布式、可扩展的列式数据库,具有以下特点:

高可靠性:HBase 借助 Hadoop HDFS 提供的容错机制,数据以多个副本存储在不同的节点上,确保数据的可靠性和持久性。当出现故障时,HBase 可自动复制数据并重新平衡。

高性能:HBase 使用列式存储,数据压缩以及内存缓存等技术,使得它非常适合存储和处理大规模数据集。同时,HBase 具备快速的写入和随机读取能力,能够满足实时数据访问的需求。

扩展性:HBase 的数据存储是水平分割的,可以在集群中添加更多的节点来扩展存储和处理能力,以适应不断增长的数据量和负载需求。

灵活的数据模型:HBase 是一个面向列的数据库,数据以表格形式组织,并且可以使用灵活的架构来定义表格和列族。这使得 HBase 可以存储非结构化和半结构化的数据,并且支持动态的模式演化。

稳定的一致性:HBase 使用 ZooKeeper 来进行分布式的协调和一致性管理,保证集群中的节点状态一致,并能在分区和故障恢复时提供保证。

支持大数据生态系统:HBase 作为 Hadoop 生态系统的一员,可以与其他 Hadoop 组件(如 MapReduce、Hive、Spark 等)无缝集成,实现全面的大数据处理和分析。

总的来说,HBase 是一个面向海量数据的高性能、可扩展的数据库,适用于需要高吞吐量和快速响应的应用场景,比如实时分析、日志处理、社交网络应用等。

🍁 🍁 05、Hive有哪些保存元数据的方式,各有什么特点?

Hive 是一个基于 Hadoop 的数据仓库工具,提供了类 SQL 查询的能力,并将查询转化为 MapReduce 或 Tez 任务在 Hadoop 集群上执行。Hive 存储元数据的方式有以下几种,各自具有不同的特点:

内嵌 Derby 数据库(Embedded Derby Database):

- 默认情况下,Hive 使用内嵌 Derby 数据库来保存元数据。

- Derby 是一个开源的 Java 关系数据库管理系统(RDBMS),适合存储小规模的元数据信息。

- 内嵌 Derby 数据库的优势在于轻量级和易于部署,适用于单机或开发、测试环境。

MySQL 或其他外部数据库:

- Hive 还支持将元数据存储在外部数据库中,如 MySQL、Oracle 等。

- 外部数据库能够处理更大规模的元数据,提供更好的性能和扩展性。

- 使用外部数据库的优势在于可以与其他数据库工具和管理系统集成,并且易于维护和管理。

自定义元数据存储方式:

- Hive 提供了自定义的元数据存储插件机制,可以通过实现自定义的元数据存储处理器(Metastore Handler)来扩展 Hive 的元数据存储方式。

- 这样可以将元数据存储在任何支持的数据库上,或者使用其他存储系统,如 Apache Cassandra 等。

选择适当的元数据存储方式取决于具体的需求和环境。如果是小规模的开发与测试环境,内嵌 Derby 数据库是一个简单方便的选择。如果需要处理大规模的元数据,或者与其他数据库工具进行集成,使用外部数据库会更为合适。同时,Hive 的自定义元数据存储方式提供了更大的灵活性和扩展性,可以根据实际情况进行定制。

🍁 🍁 06、如何创建topic,执行命令是什么?

要在 Apache Kafka 中创建一个 topic(主题),可以使用 Kafka 自带的命令行工具 kafka-topics.sh(或 kafka-topics.bat)。具体的命令是根据您所使用的操作系统而有所不同:

在 Linux 或 macOS 上,命令为:

./kafka-topics.sh --create --zookeeper <zookeeper_host:port> --topic <topic_name> --partitions <num_partitions> --replication-factor <replication_factor>

在 Windows 上,命令为:

kafka-topics.bat --create --zookeeper <zookeeper_host:port> --topic <topic_name> --partitions <num_partitions> --replication-factor <replication_factor>

其中,您需要设置以下参数:

<zookeeper_host:port>:指定 ZooKeeper 的主机名和端口,例如localhost:2181。<topic_name>:设置要创建的 topic 的名称。<num_partitions>:指定 topic 的分区数。<replication_factor>:指定每个分区的副本数。

例如,要创建一个名为 “mytopic”,有 3 个分区和副本因子为 2 的 topic,可以执行如下命令:

./kafka-topics.sh --create --zookeeper localhost:2181 --topic mytopic --partitions 3 --replication-factor 2

执行完上述命令后,如果一切正常,将创建一个名为 “mytopic” 的 topic,可用于 Kafka 消息的发布和订阅。

🍁 🍁 07、Combiner出现在哪个过程?

Combiner 是 Hadoop MapReduce 模型中的一个可选功能,它出现在 Map 过程和 Reduce 过程之间,用于在 Map 端对中间结果进行合并(合并相同 key 对应的 value),以减少带宽消耗和 Reduce 端的数据处理量。

通常情况下,Map 端会产生大量的中间结果,这些结果会经过网络传输,最终传送到 Reduce 端进行聚合和计算。如果中间结果很大,网络传输和 Reduce 端的计算负担将会很重,甚至可能导致集群性能的瓶颈。此时,可以使用 Combiner 来对 Map 端产生的结果进行预聚合,从而减少传输的数据量和 Reduce 端的计算负担。

Combiner 和 Reduce 过程类似,也可以对输入数据进行合并和计算,但是它只是在 Map 端执行的一个本地操作,不同于 Reduce 操作会触发网络传输。Combiner 可以对 Map 端产生的局部结果进行合并,本质上就是一个本地 Reduce 操作,因此它可以有效地减少网络传输带宽和 Reduce 端的计算量,提高 MapReduce 作业的性能。

需要注意的是,虽然使用 Combiner 可以提高 MapReduce 作业的性能,但是在数据分布不均匀、数据量较小或者 Combiner 功能有副作用的情况下,使用 Combiner 可能会降低作业的性能。因此,在使用 Combiner 前需要考虑可能产生的效果,并进行测试以确定使用 Combiner 是否会对作业性能产生积极影响。

🍁 🍁 08、HDFS写文件的步骤是什么?

HDFS(Hadoop Distributed File System)是 Hadoop 生态系统中的分布式文件系统,它将大文件拆分成多个块,并分布在多个节点上存储。下面是使用 HDFS 写文件的一般步骤:

Hadoop 客户端将要写入的文件切分为块(Block):文件被划分为固定大小的块,通常为默认的 128MB 或自定义的大小。

客户端与 NameNode 通信:客户端将要写入的文件元数据信息(如文件名、块大小、副本因子等)发送给 NameNode,请求写入文件。

NameNode 分配数据节点(DataNode):NameNode 响应客户端请求,并返回可以写入的数据节点信息。

客户端与 DataNode 建立连接:客户端通过网络连接到返回的 DataNodes。

客户端将数据块写入 DataNode:客户端将数据块按照指定的顺序写入到数据节点上的块存储文件。

DataNode 进行副本复制:DataNode 将接收到的数据块复制到其他数据节点上,以满足副本因子的要求。

客户端通知 NameNode 完成写入:当所有数据块都成功写入并复制后,客户端通知 NameNode 完成写文件的操作。

NameNode 更新文件系统元数据:NameNode 更新文件系统的元数据,包括文件的位置信息和复制状态。

以上是 HDFS 写文件的一般步骤。HDFS 通过数据块和复制机制来提供可靠性和容错性,并通过多个数据节点的并行写入来提高写入吞吐量。

🍁 🍁 09、Hdfs-site.xml的3个主要属性?

hdfs-site.xml 是 Hadoop 中的一个重要配置文件,用于配置 HDFS 相关参数。其中,比较重要的三个属性如下:

dfs.replication:指定文件的副本数,默认值为 3。当将数据写入 HDFS 时,HDFS 会对数据进行副本多次复制,以提高数据的可靠性和容错性。你可以通过这个属性来自定义文件的副本数。

dfs.namenode.name.dir:指定 NameNode 存储命名空间目录的位置。NameNode 存储的是整个文件系统的元数据,包括文件和目录的层次结构、文件的块信息和副本位置等,它将这些信息存储在文件系统的命名空间中。你可以通过这个属性来指定 NameNode 存储命名空间的位置,比如将其存储在本地磁盘或分布式文件系统中。

dfs.blocksize:指定 HDFS 块(Block)的大小,默认值为 64MB。当向 HDFS 写入大文件时,数据将被分割成固定大小的块,HDFS 会将这些块存储在不同的数据节点上,以提高数据读写的并行性。你可以通过这个属性来自定义 HDFS 块的大小,根据需要进行调整,例如,对于大量小文件的场景,可以适当调小块的大小,提高存储效率。

🍁 🍁 10、简述hive中的虚拟列的作用?使用它注意事项?

在 Hive 中,虚拟列是指不在数据源中存储的列,在查询时动态生成的列。Hive 中的虚拟列可以通过计算表达式、简单别名或系统函数生成。虚拟列的作用主要有以下两点:

计算衍生列:通过虚拟列,我们可以在查询时计算衍生列,比如将两列相加得到一个新的结果列,或者将一个日期列拆分为年、月、日三列。

应用常量计算:虚拟列也可以被用于应用常量计算,例如:将一列按照固定的比例划分为不同的等级。

使用虚拟列时需要注意以下点:

虚拟列只在查询时存在,不会真正在数据源中创建。

虚拟列可以被查询选择性地包含在结果集中。

虚拟列的计算会在查询中动态进行,所以可能会降低查询性能。

由于虚拟列是在查询时动态计算的,因此在使用时需要注意对数据的影响。比如,如果计算一个数值列的平方并将结果存储到一个新列中,那么这些数据可能无法被压缩和存储在分区和桶中。

总之,虚拟列在 Hive 中是一个比较有用的功能,可以帮助我们进行更复杂的计算和查询操作,但需要注意性能和数据影响的问题。

🍁 🍁 11、用mapreduce怎么处理数据倾斜问题?

数据倾斜问题在 MapReduce 中是一个常见的问题。数据倾斜指的是源数据的某个键(Key)分布不均匀,导致某些 Reducer 所处理的数据远远多于其他 Reducer,导致运行时间过长、效率下降或运行失败等问题。针对数据倾斜问题,我们可以采取以下方法:

预处理和采样:先进行预测和采样,针对预处理结果和采样数据进行调优。例如可以计算每个键(Key)的行数,针对行数较多的键进行采样优化,调整 Mapper 的并行度。

均匀切分:将源数据切分为更细的粒度,以均匀分布数据,同时需要保证每个数据块中所有的 key 个数是基本相同的。

桶分解:将原始数据分解成多个桶,每个桶单独进行 MapReduce 处理,处理完后,再将结果合并,遵循最重要的桶放到最后合并,或者将数据倾斜的键作为单独的桶处理,最后将结果合并。

动态分配样本:在Map阶段,通过采样的方法动态调整每个节点上的数据数量,从而实现数据均匀的分布。调整方案大致如下:针对 hot key 会被分配到同一个 reducer 的情况,可以在mapper阶段在每个key值后面增加随机数然后进行reduce;对于分布不均匀的数据,可以在map节点各自进行预先拆分后的伪装数据,最后在reduce端进行去重过滤。

以上是 MapReduce 处理数据倾斜的一些常见方法,可以根据实际情况进行选择和调整。

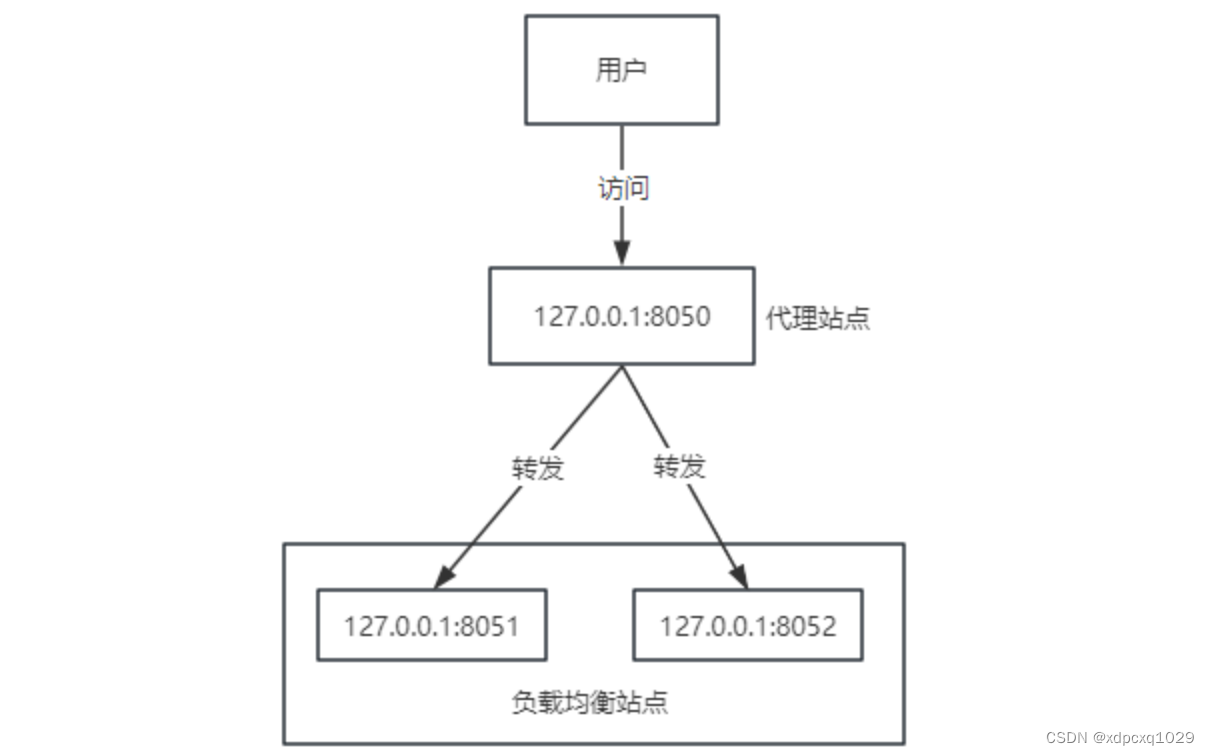

🍁 🍁 12、怎么保证Kafka集群的负载均衡?

保证 Kafka 集群的负载均衡需要考虑以下两个方面:

- Broker 负载均衡

Broker 负载均衡是指在 Kafka 集群中,每个 Broker 分担相同的负荷。要实现 Broker 负载均衡,可以采用以下几种策略:

手动分配 Partition:管理员手动将 Partition 分配给各个 Broker,确保每个 Broker 中的 Partition 数量相等。

使用自动分配器:Kafka 提供了一种自动分配器工具,该工具可以根据 Broker 的数量和 Workload 的差异来动态分配 Partition,保证负载均衡。

- Partition 负载均衡

Partition 负载均衡是指在 Kafka 集群中,每个 Partition 分担相同的负荷。要实现 Partition 负载均衡,可以采用以下几种策略:

手动创建 Partition:管理员可手动创建 Partition 来实现负载均衡。

自动创建 Partition:Kafka 默认会为 Topic 创建一个 Partition,你可以通过配置 Partition 数量或使用自动创建 Partition 策略来扩展 Partition,从而实现负载均衡。

综上,保证 Kafka 集群的负载均衡需要实现 Broker 和 Partition 的负载均衡,并且需要正确配置 Kafka Broker 和相关的生产者和消费者,才能实现良好的负载均衡。

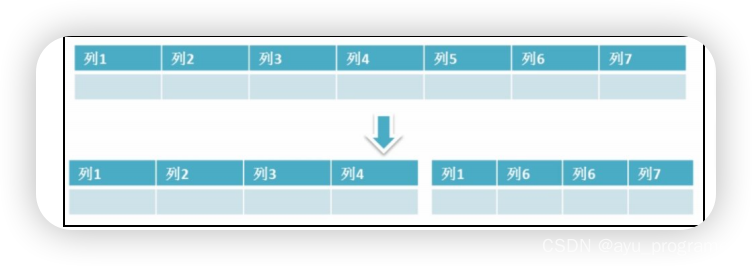

🍁 🍁 13、NAS(网络附加存储)和HDFS之间的主要区别是什么?

NAS(网络附加存储)和 HDFS(Hadoop分布式文件系统)是两种不同的存储技术,它们在实现方式和使用场景上有以下主要区别:

- 存储方式:

- NAS 是一种基于文件的存储技术,数据以文件的形式存储在中心存储设备上,并通过网络协议(如NFS、CIFS)与客户机进行通信。

- HDFS 是一种基于块的分布式文件系统,数据被切分成多个固定大小的数据块,并分布在 Hadoop 集群的不同节点上进行存储。

- 访问模式:

- NAS 提供了类似于本地文件系统的访问方式,可以通过文件路径直接访问和操作文件,支持对文件的随机读写。

- HDFS 采用了主从架构,由一个或多个 NameNode 负责管理文件系统元数据,并通过 DataNode 来存储实际的数据。HDFS 支持大数据量的顺序读写操作,较适合批量数据处理。

- 扩展性:

- NAS 是中心式存储架构,通常由单个存储设备提供存储服务,扩展性较有限。

- HDFS 是分布式存储架构,可以通过添加更多的节点来实现存储容量和吞吐量的扩展。

- 容错性:

- NAS 通常通过冗余设备(如 RAID)来提高可用性和容错性,但如果存储设备本身发生故障,可能导致文件无法访问。

- HDFS 利用 Hadoop 集群中的复制机制来实现数据的冗余和容错,在数据节点上复制多个数据副本,即使某个节点发生故障,仍然可以通过其他节点访问和恢复数据。

总体来说,NAS 更适合传统的文件存储和共享场景,而 HDFS 则更适用于大规模数据存储和批处理任务的分布式环境。

| 区别 | NAS | HDFS |

|---|---|---|

| 存储方式 | 文件存储 | 块存储 |

| 访问模式 | 文件路径访问 | 顺序读写 |

| 扩展性 | 有限 | 可扩展 |

| 容错性 | 依赖冗余设备 | 数据复制 |

| 使用场景 | 文件共享 | 大规模数据存储 |

这个表格总结并比较了 NAS 和 HDFS 之间的几个主要区别:

存储方式:NAS采用文件存储方式,而HDFS采用分块存储方式。

访问模式:NAS通过文件路径进行访问,支持随机读写;而HDFS主要支持顺序读写操作。

扩展性:NAS通过添加更多的存储设备来扩展容量,但扩展性受到限制;而HDFS是分布式存储,可以通过添加更多的节点来扩展存储容量和吞吐量。

容错性:NAS依赖于冗余设备(如RAID)提高容错性,但若存储设备发生故障,可能导致文件无法访问;HDFS通过数据节点上的数据副本实现冗余和容错,即使某个节点故障,仍可以通过其他节点访问和恢复数据。

使用场景:NAS适用于传统的文件共享和存储场景;HDFS适用于大规模数据存储和批处理任务的分布式环境。

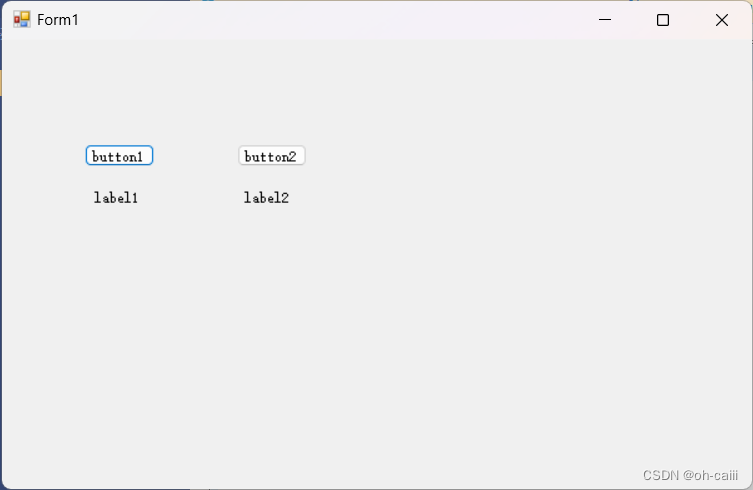

🍁 🍁 14、请描述一下开发过程中如何对上面的程序进行性能分析?

在开发过程中对程序进行性能分析和优化是非常重要的,下面是一般的性能分析和优化过程的概述:

建立性能基准:首先,需要建立一个性能基准,即记录程序在当前状态下的性能指标。可以使用性能测试工具(如JMH)运行代码,并收集性能数据,包括执行时间、内存使用、CPU利用率等。

分析性能瓶颈:通过分析收集到的性能数据,找出潜在的性能瓶颈。可以使用一些性能分析工具(如Profiler)来确定代码中的热点,找出执行时间较长的关键代码部分。

优化性能瓶颈:一旦发现性能瓶颈,可以采取以下一些常见的优化策略来改进程序性能:

- 算法和数据结构优化:通过优化算法和数据结构的选择,可以改善程序的时间和空间复杂度。

- 并发和并行处理:使用多线程、多进程或分布式处理来提高程序的并发性和并行度。

- I/O优化:缓存数据、批量读写数据、减少磁盘访问等方式来优化I/O操作。

- 内存管理优化:减少内存分配与释放次数,避免内存泄漏和过度使用内存等。

- 代码优化:考虑代码的可读性、可维护性和性能的平衡,优化关键代码段以提高执行效率。

进行性能测试:在应用优化策略后,再次运行性能测试,对比原始性能基准,评估优化策略的效果。如果效果不佳,可以回到第二步重新分析和优化。

迭代优化:性能优化是一个迭代的过程,需要重复以上步骤,对程序进行反复测试、分析和优化,以逐渐提高程序性能。

值得注意的是,性能分析和优化的过程应该是有针对性的,即根据具体情况进行分析和优化,并确保优化的代码改动不会引入新的问题。在处理性能问题时,要权衡资源消耗、可维护性和可扩展性等因素,以获得一个合理的解决方案。

🍁 🍁 15、请简述mapreduce中的combine和partition的作用?

在 MapReduce 中,Combine 和 Partition 是两个重要的概念和组件,它们分别用于在 Map 和 Reduce 阶段对数据进行中间处理和分发。下面是它们的简要作用说明:

1. Combine(合并函数):

Combine 函数是 MapReduce 中的一个可选操作。它在每个 Map 任务的输出结果之前调用,用于在 Map 阶段对输出结果进行局部聚合和压缩。Combine 函数可以将具有相同中间键(intermediate key)的数据进行合并,并减少数据传输量和磁盘写入,因此可以提高整体的 MapReduce 性能。Combine 函数通常用于执行一些轻量级的聚合操作,如求和、计数等。

2. Partition(分区函数):

Partition 是 MapReduce 框架中的一个关键操作。它将 Map 阶段输出的中间键值对根据中间键的哈希值进行分发,并将不同的键值对发送到不同的 Reduce 任务。Partition 的作用是将数据合理地分配给不同的 Reduce 任务,以便在 Reduce 阶段进行局部聚合和最终的结果生成。通过合理的分区策略,可以减少数据在网络上的传输量,提高计算的并行性和整体性能。

在 MapReduce 中,Combine 和 Partition 的作用是通过在 Map 阶段对输出数据进行局部聚合和合理分发,以减少数据的传输和磁盘写入,从而提高整体的性能和效率。Combine 和 Partition 的实现需要根据具体的业务需求和数据特点选择合适的函数和策略,以达到最佳的性能优化效果。

![[GKCTF 2020]cve版签到](https://img-blog.csdnimg.cn/direct/5c02c7b6ae0c48819484d4a43968af30.png#pic_center)