引言

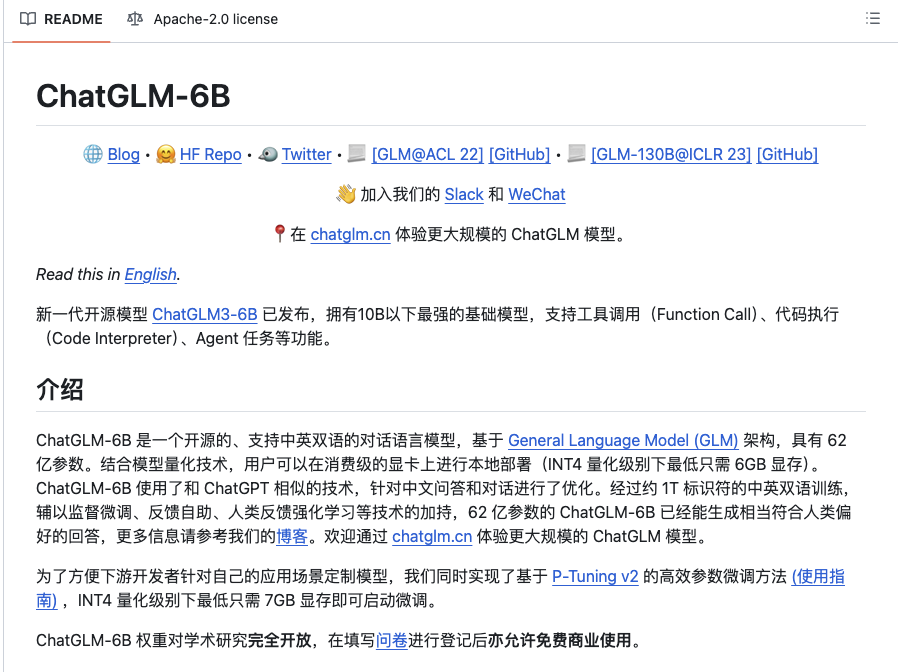

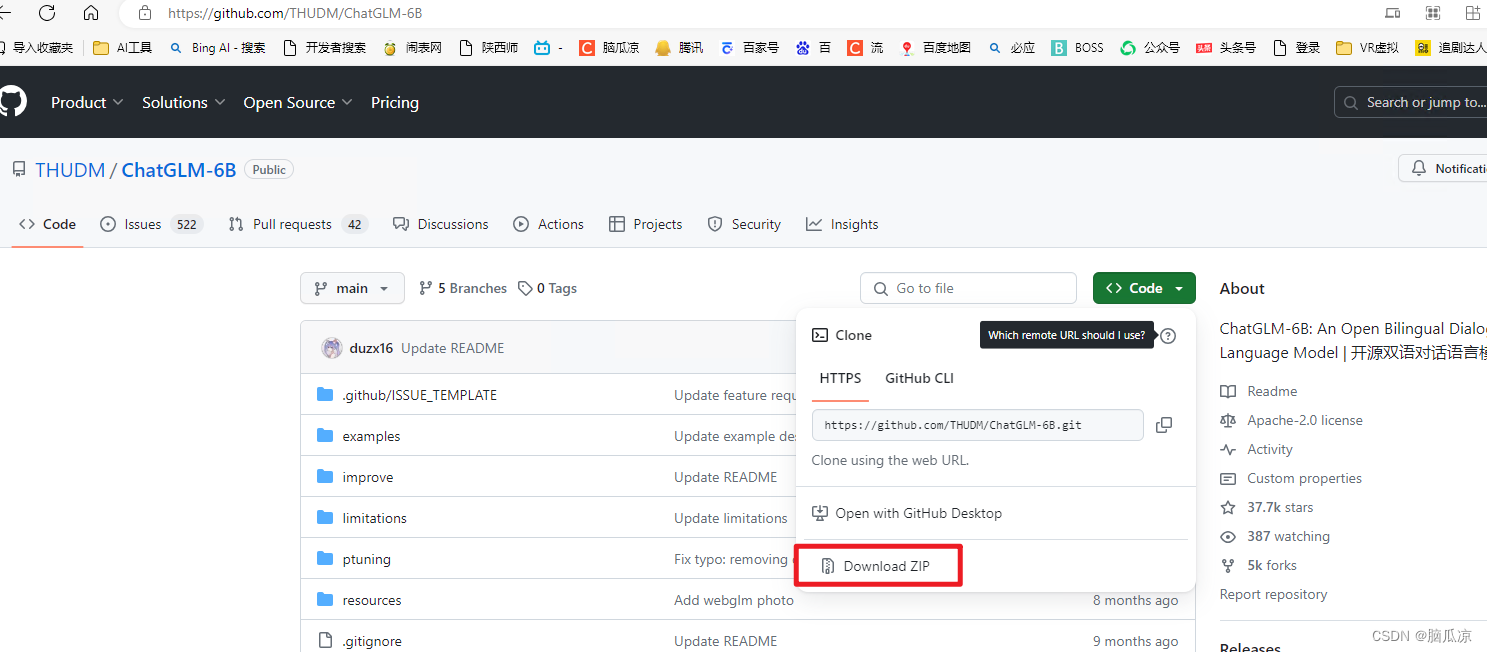

前段时间,清华公布了中英双语对话模型 ChatGLM-6B,具有60亿的参数,初具问答和对话功能。最!最!最重要的是它能够支持私有化部署,大部分实验室的服务器基本上都能跑起来。因为条件特殊,实验室网络不通,那么如何进行离线部署呢?

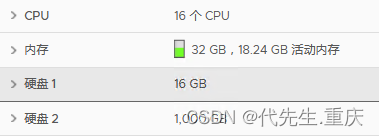

「部署环境」:CUDA Version 11.0,机器内存32G以上或者机器8G内存+8G显卡内存。

安装Miniconda,

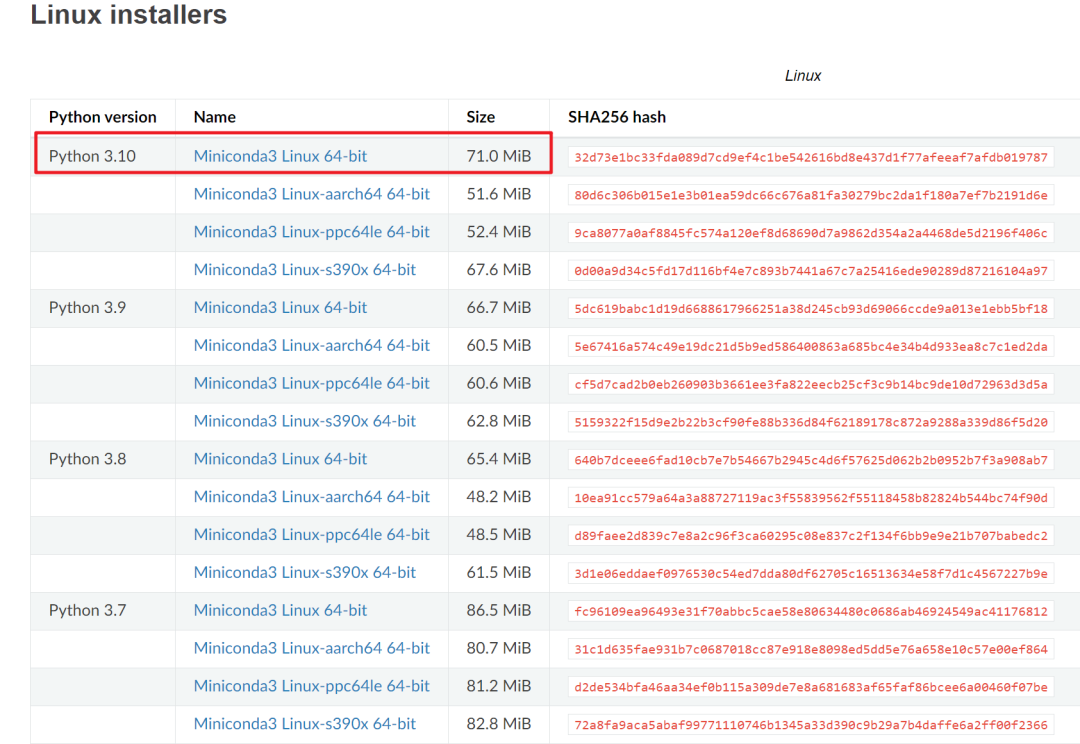

1.1 获取安装包

因为Miniconda自带python,所以要在官网下载python版本为3.10的Miniconda版本。下载地址为:https://docs.conda.io/en/latest/miniconda.html#linux-installers,具体截图如下。

1.2 安装 Miniconda

将Miniconda下载安装包放到你要放的目录,这里我放在:/home/work/miniconda 中,然后执行sh Miniconda3-latest-Linux-x86_64.sh 如下图所示: