之——RNN基础

杂谈

第一个对于序列模型的网络,RNN。

正文

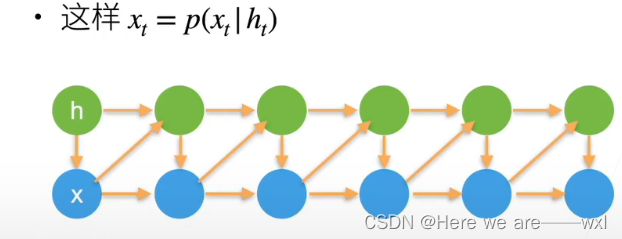

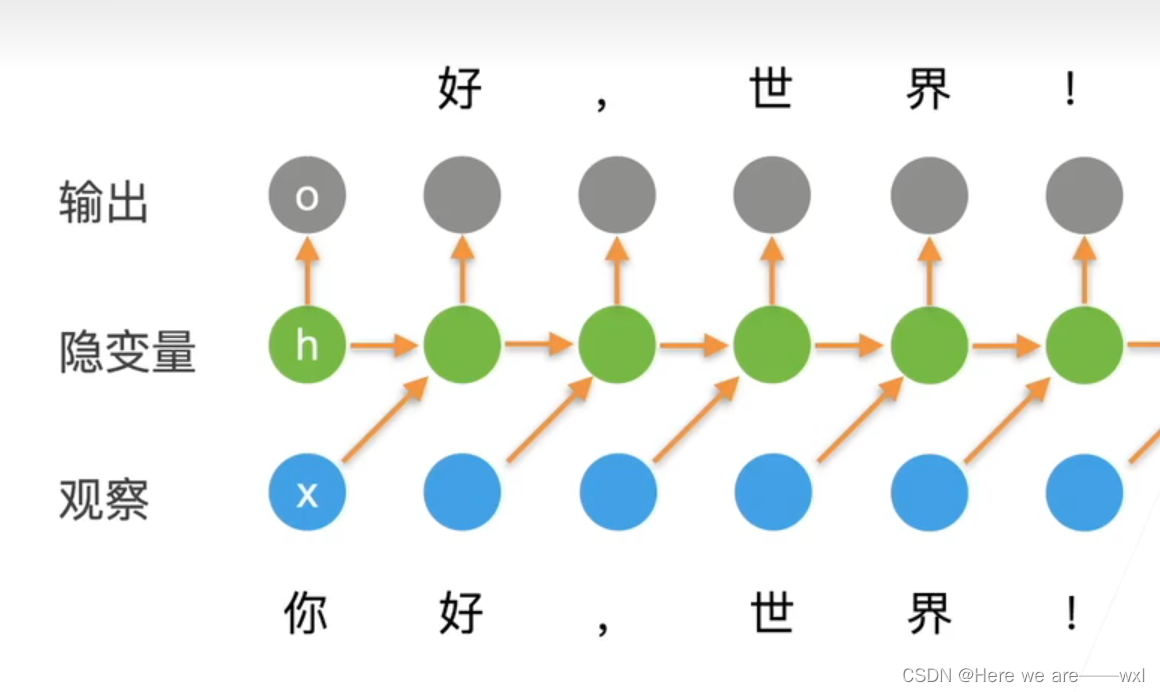

1.潜变量自回归模型

潜变量总结过去的信息,再和当前信息一起结合出新的信息。

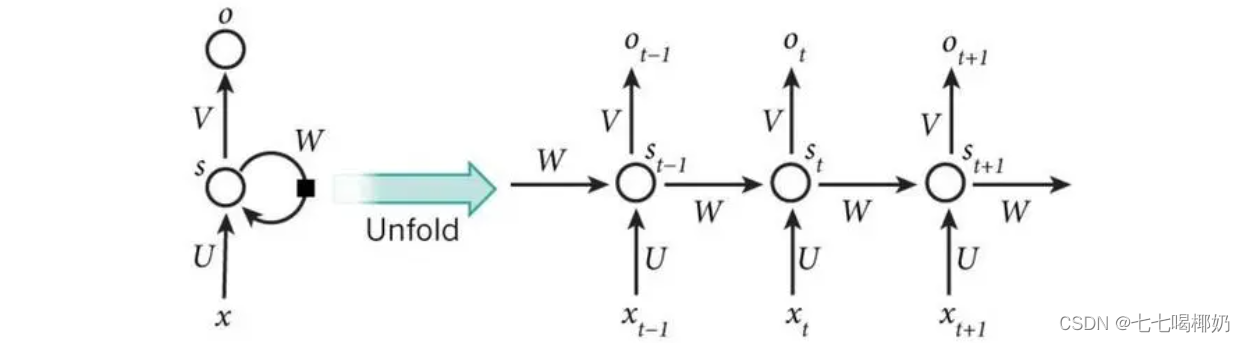

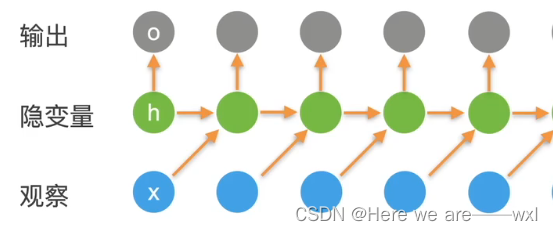

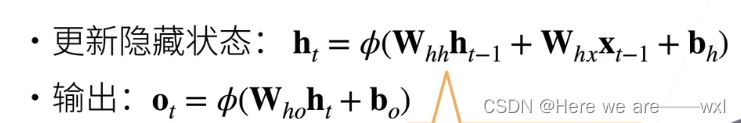

2.RNN

循环神经网络将观察作为x,与前层隐变量结合得到输出

其中Whh蕴含了整个模型的时序信息,Whx表征了对新的观察的方式。

它的学习的过程就是在观察当前字的时候要去以生成下一个字为目的地学习:

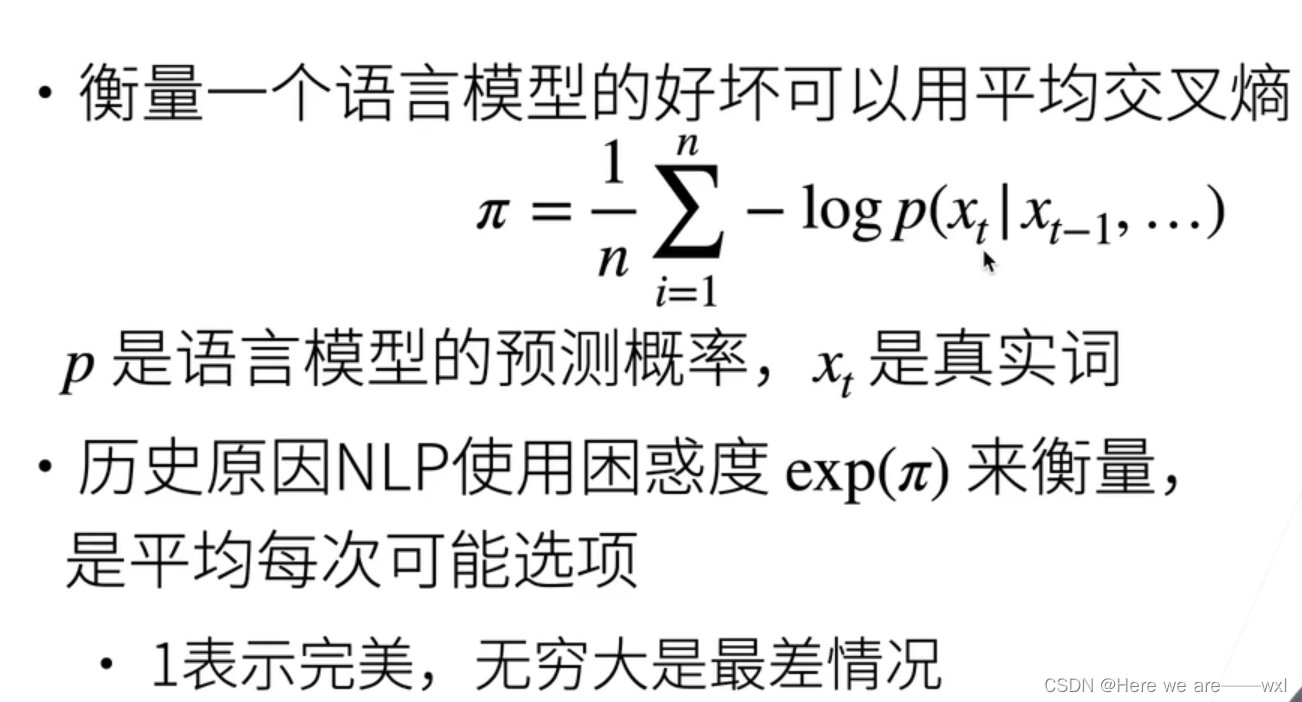

3.衡量语言模型

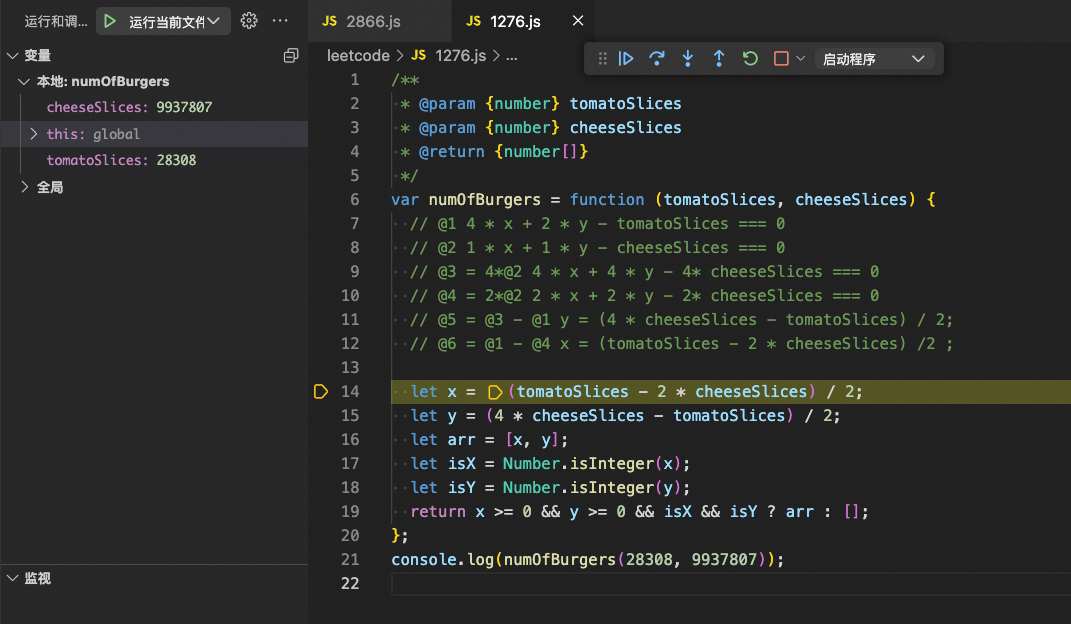

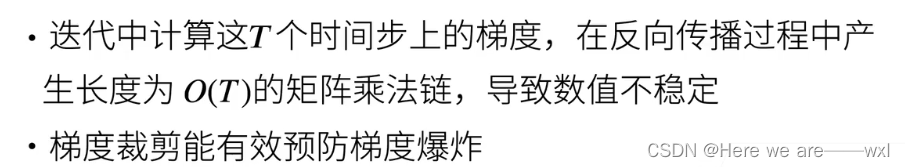

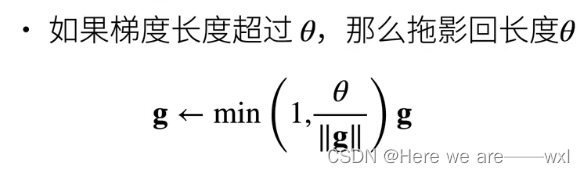

4.梯度裁剪

如果梯度超过阈值,就把梯度拖回阈值:

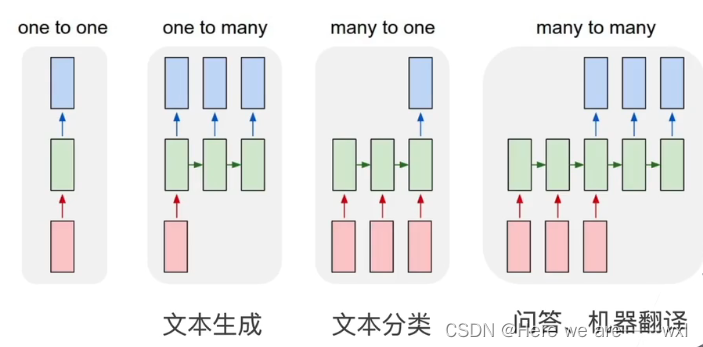

5.RNN更多应用

拓展

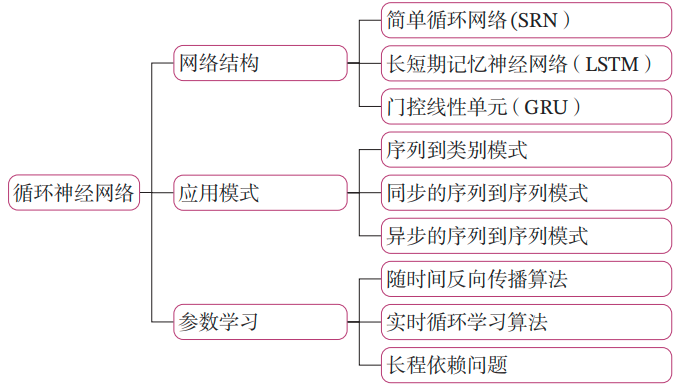

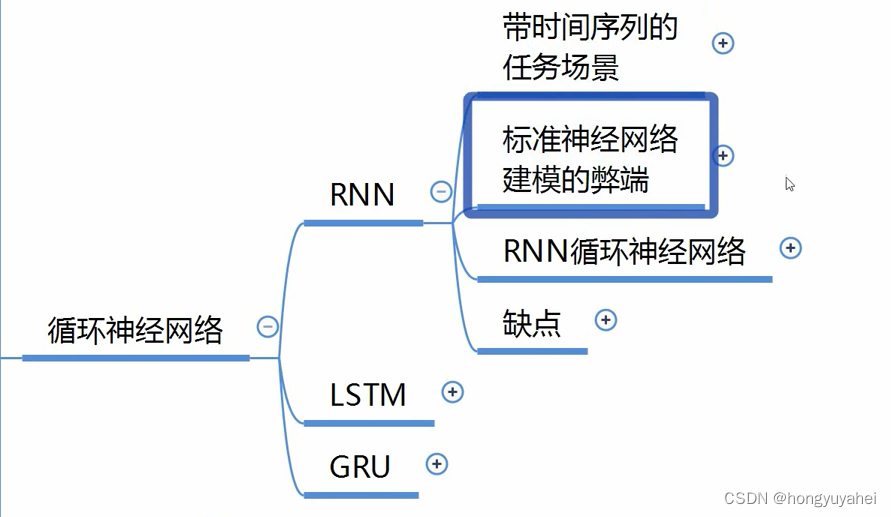

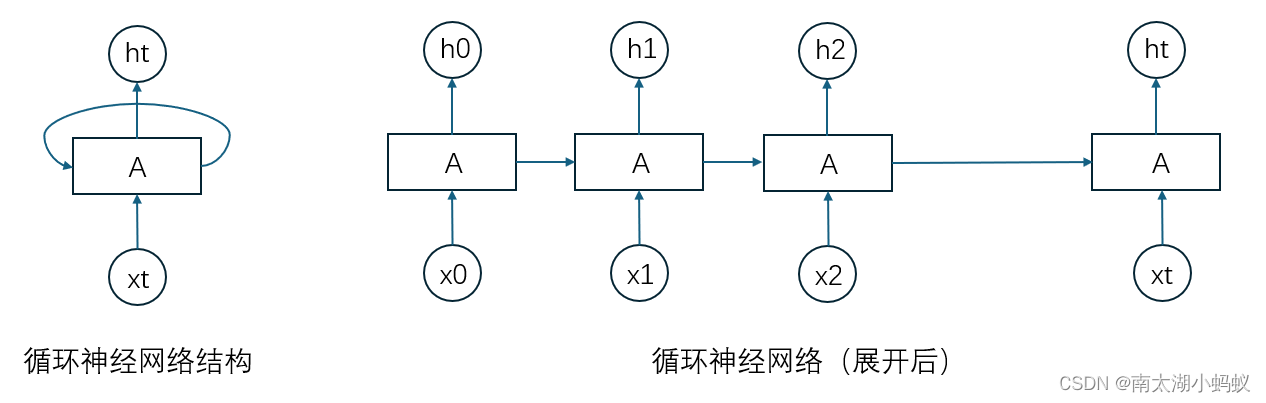

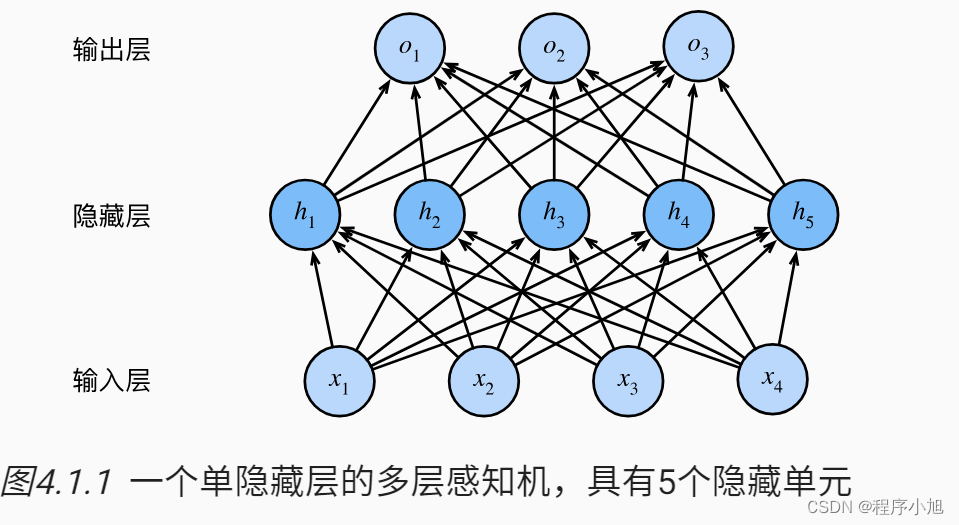

循环神经网络(Recurrent Neural Network,RNN)是一类专门设计用于处理序列数据的神经网络结构。与传统的前馈神经网络不同,RNN具有一种循环的结构,使得信息可以在网络内部传递,从而能够考虑到序列中的时间依赖关系。

RNN的基本结构:

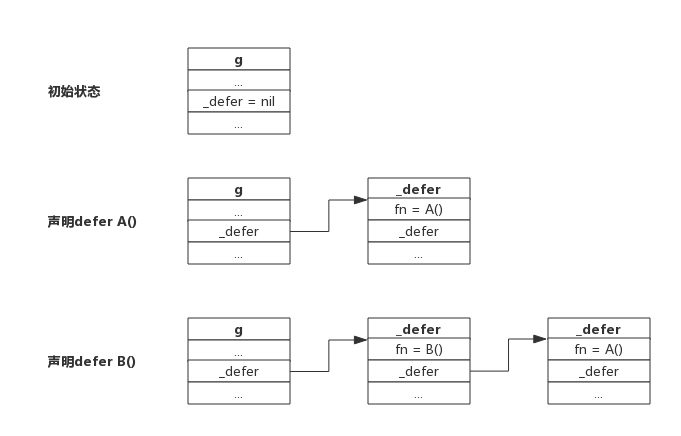

循环连接: RNN中包含循环连接,允许网络在处理序列数据时保留之前的信息,并将其传递到下一个时间步骤。这使得RNN适用于处理时间序列、自然语言处理等问题。

隐藏状态: 在每个时间步骤,RNN都有一个隐藏状态(hidden state),它包含了网络在处理过去序列时所学到的信息。隐藏状态是RNN中保存信息的关键部分。

权重共享: RNN在每个时间步骤都使用相同的权重参数,这使得网络可以学习捕捉序列中的模式。

RNN的问题:

尽管RNN在处理序列数据方面有很好的潜力,但它也存在一些问题,其中最主要的是梯度消失/爆炸问题。由于网络的反向传播算法,当序列变得非常长时,梯度可能会变得非常小或非常大,导致难以训练的情况。

应用领域:

自然语言处理(NLP): RNN广泛应用于语言建模、机器翻译、文本生成等任务,因为这些任务通常涉及到对序列数据的建模。

时间序列预测: RNN也常用于处理时间序列数据,如股票价格预测、天气预测等。

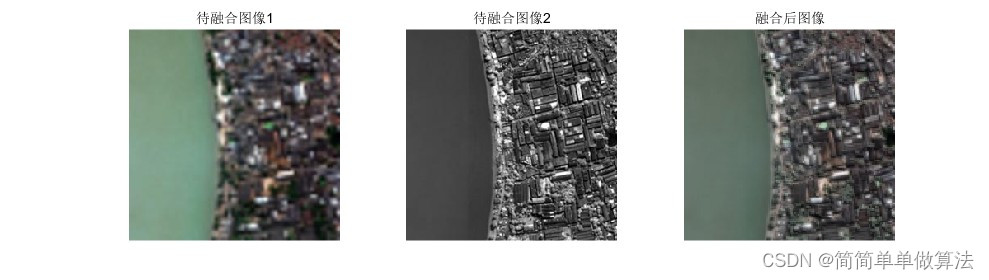

图像描述生成: 在图像处理中,RNN被用于生成图像描述,将图像内容转化为自然语言描述。

变体:长短期记忆网络(LSTM)和门控循环单元(GRU):

为了解决梯度消失/爆炸问题,研究者提出了一些改进型的循环神经网络,其中包括长短期记忆网络(LSTM)和门控循环单元(GRU),它们通过引入门控机制有效地改进了RNN的性能,尤其是在处理长序列时。