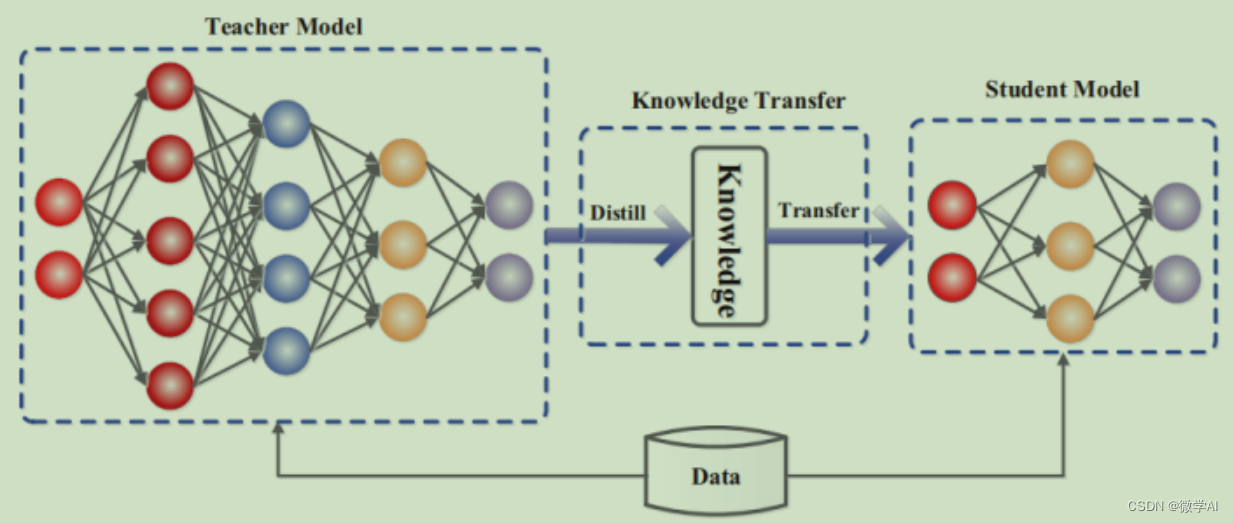

大家好,我是微学AI,今天给大家介绍一下深度学习技巧应用31-对卷积残差网络ResNet做知识蒸馏技术的实战应用,并加载真实数据集进行蒸馏训练。做模型压缩知识蒸馏是一种模型压缩技术,它通过将一个大模型(教师模型)的知识迁移到一个小模型(学生模型)中来实现模型的压缩。这种方法可以用于减少模型的大小,同时保持较高的准确率。

目录

一、为什么要知识蒸馏

二、知识蒸馏的过程

三、知识蒸馏的方法

四、知识蒸馏的数学原理

五、案例:教师模型 vs 学生模型

六、知识蒸馏的技巧的代码实现

七、总结

一、为什么要知识蒸馏

在深度学习中,通常会训练一个大型模型(教师模型)来获得较高的准确率。但是,这样的模型通常非常大,需要大量的计算资源和存储空间。知识蒸馏提供了一种方法,通过训练一个较小的模型(学生模型)来模仿大型模型的行为,从而减少资源需求。

二、知识蒸馏的过程

训练教师模型:首先训练一个大型模型(教师模型)来获得高准确率。

提取知识:通过教师模型对输入数据进行预测,并将预测结果作为“知识”存储在一个新的数据集中。

训练学生模型:使用从教师模型中提取的知识作为标签,训练一个较小的模型(学生模型)。

进行预测:使用学生模型进行预测