在Web开发和爬虫技术中,Cookies和Session是两个关键概念,它们被用来维护客户端(如浏览器)和服务器之间的状态信息。这对于爬虫来说特别重要,因为许多现代网站依赖于这些机制来保持用户登录状态、个性化内容等。下面我将详细讲解Cookies和Session的工作原理,以及它们在Python爬虫中的应用。

Cookies

Cookies是一种在客户端存储小量数据的技术。当你访问一个网站时,服务器可能会发送一些信息到你的浏览器,这些信息会被存储为Cookie。下次你访问同一个网站时,浏览器会自动将这些Cookies发送回服务器,这样服务器就可以识别你是谁,并基于这些信息提供定制的内容或服务。

Cookies的特点:

- 持久性:Cookies可以被设置为永久存储,也可以只在当前会话期间有效。

- 安全性:有些Cookies被认为是安全的,这意味着它们只能通过HTTPS协议发送。

- 大小限制:每个Cookie的大小有限制,通常不超过4KB。

- 多个Cookies:一个网站可以在客户端存储多个Cookies。

Session

Session是服务器端用来跟踪用户会话状态的技术。与Cookies不同,Session数据通常存储在服务器上,而不是客户端。当用户与网站交互时,服务器会创建一个Session,分配一个唯一的Session ID,并将其存储在用户的Cookie中。这样,每次用户发送请求时,服务器都可以通过Session ID来查找相应的Session数据,从而恢复用户的状态信息。

Session的特点:

- 安全性:由于Session数据存储在服务器端,因此比Cookies更安全,更不容易被篡改。

- 大小无限制:理论上,Session可以存储任意大小的数据,不过实际上也会受到服务器内存的限制。

- 生命周期管理:服务器可以控制Session的生命周期,包括何时创建、何时销毁。

在Python爬虫中的应用

在Python爬虫中,处理Cookies和Session通常涉及到使用requests库或更强大的requests.Session对象。requests.Session允许你跨请求保持某些参数,比如Cookies,这对于需要登录的网站尤其有用。

使用requests.Session:

import requests

# 创建Session对象

session = requests.Session()

# 登录操作,通常会设置Cookies

login_data = {

'username': 'your_username',

'password': 'your_password'

}

response = session.post('https://example.com/login', data=login_data)

# 访问需要登录才能访问的页面,此时会自动带上Cookies

response = session.get('https://example.com/private')

# 检查响应

print(response.text)

在这个例子中,一旦你使用session对象进行了登录,之后的所有请求都会自动携带登录时设置的Cookies,从而可以访问私有页面。

总结

Cookies和Session都是用于维护Web应用程序状态的重要机制。在编写爬虫时,理解并正确处理这些机制可以帮助你模拟真实的用户行为,绕过一些网站的登录限制,获取更全面的网页数据。在实际应用中,还需要注意遵守网站的使用条款和相关的法律法规,避免滥用爬虫技术。

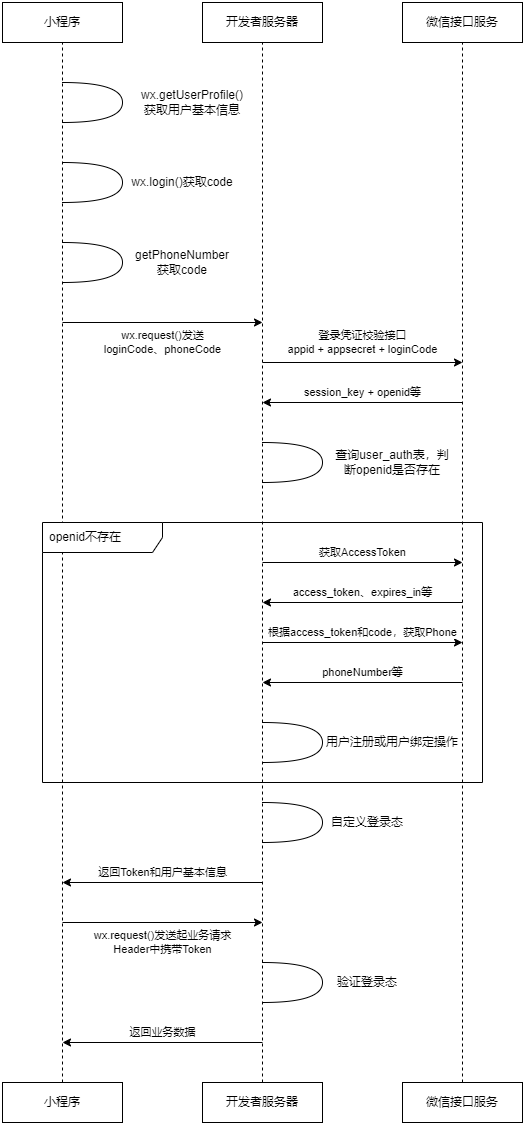

Cookies和Session在Web开发中是维持用户会话状态的关键技术,对于爬虫而言,了解并能恰当处理这些机制同样重要,尤其是当目标网站使用这些技术来保持用户登录状态、个性化设置或追踪用户行为时。下面,我将结合一个具体的案例来详细讲解Cookies和Session的使用,以及它们在Python爬虫中的应用。

案例:登录并抓取数据

假设我们要从一个在线论坛抓取帖子数据,而这个论坛需要用户登录后才能查看帖子的完整内容。我们的目标是登录论坛,然后抓取用户发布的所有帖子。

网站结构和登录流程

- 登录页面:

https://forum.example.com/login - 登录表单:包含用户名和密码字段

- 成功登录后:重定向到首页,并在浏览器中设置一个或多个Cookies,用于后续请求的身份验证。

使用requests.Session进行登录和数据抓取

首先,我们需要安装requests库,如果你还没有安装,可以通过pip来安装:

pip install requests

接下来,我们将使用requests.Session来管理登录过程和会话状态。以下是使用Python实现的一个示例代码:

import requests

# 创建Session对象

session = requests.Session()

# 登录信息

login_info = {

'username': 'your_username',

'password': 'your_password'

}

# 登录URL

login_url = 'https://forum.example.com/login'

# 发送登录请求

response = session.post(login_url, data=login_info)

# 检查是否登录成功

if response.status_code == 200:

print("登录成功!")

else:

print("登录失败!")

# 获取用户帖子列表的URL

posts_url = 'https://forum.example.com/user_posts'

# 发送请求获取帖子列表

response = session.get(posts_url)

# 检查响应

if response.status_code == 200:

posts_html = response.text

# 这里你可以使用BeautifulSoup或其他HTML解析库来解析posts_html,提取帖子数据

print(posts_html)

else:

print("获取帖子列表失败!")

在这个例子中,session对象被用来处理登录流程。当我们使用session.post发送登录请求时,任何在响应中设置的Cookies都会被保存在session对象中。随后,当我们使用session.get请求其他页面时,session会自动将这些Cookies包含在请求头中,从而使服务器能够识别出我们已经登录。

注意事项

- 登录表单数据:登录表单的具体字段可能因网站而异,你可能需要查看网站的登录表单HTML代码或使用开发者工具来确定正确的字段名。

- 安全性:在处理敏感信息如用户名和密码时,确保代码的安全性,避免硬编码凭证,考虑使用环境变量或配置文件来存储敏感信息。

- 遵守规则:在抓取数据时,务必遵守目标网站的robots.txt文件和使用条款,尊重网站的爬虫政策,避免频繁或大量请求导致的服务器压力。

通过上述案例,我们可以看到Cookies和Session在Python爬虫中的作用和应用,它们帮助我们保持登录状态,从而能够访问和抓取需要登录才能访问的网页数据。

这一次,我们将关注一个电子商务网站,比如假设我们正在抓取某知名电商网站的产品评论数据。这类网站往往需要用户登录后才能查看全部的评论,因此,理解Cookies和Session就变得尤为重要。

案例:抓取电商网站的产品评论

假设我们想要抓取的产品评论位于URL https://www.example-shop.com/product/1234/reviews,并且需要登录才能访问。我们的目标是登录网站,浏览产品页面,然后抓取所有的用户评论。

步骤1:登录网站

首先,我们需要使用requests.Session()来创建一个会话,这将允许我们跨请求保持Cookies。我们将向登录页面发送POST请求,并传递用户名和密码。登录页面的URL可能是https://www.example-shop.com/login。

import requests

from bs4 import BeautifulSoup

# 创建一个Session对象

session = requests.Session()

# 登录信息

login_info = {

'username': 'your_username',

'password': 'your_password'

}

# 登录URL

login_url = 'https://www.example-shop.com/login'

# 发送登录请求

response = session.post(login_url, data=login_info)

# 检查是否登录成功

if response.status_code == 200:

print("登录成功!")

else:

print("登录失败!")

步骤2:抓取产品评论

一旦登录成功,我们就可以利用保存在Session中的Cookies来访问需要登录才能查看的页面。我们将向产品评论页面发送GET请求。

# 产品评论页面URL

reviews_url = 'https://www.example-shop.com/product/1234/reviews'

# 发送GET请求获取评论页面

response = session.get(reviews_url)

# 检查响应状态

if response.status_code == 200:

# 解析HTML文档

soup = BeautifulSoup(response.text, 'html.parser')

# 假设评论容器为<div class="review">

reviews = soup.find_all('div', {'class': 'review'})

for review in reviews:

# 假设评论文本在<p class="comment-text">中

comment_text = review.find('p', {'class': 'comment-text'}).get_text()

print(comment_text)

else:

print("获取评论失败!")

注意事项:

- Cookies管理:

requests.Session()会自动管理Cookies,这意味着在登录后,后续的请求会自动包含登录时设置的Cookies,从而允许我们访问受保护的页面。 - 状态保持:Session对象会记住之前请求的状态,如登录状态、购物车信息等,这对于需要连续访问多个页面或执行一系列操作的爬虫来说非常重要。

- 错误处理:在实际操作中,应加入更详尽的错误处理逻辑,如重试机制、超时设定等,以应对网络不稳定或服务器响应异常的情况。

遵守法律和道德规范:

在进行网络爬虫活动时,一定要遵守目标网站的robots.txt文件,尊重网站的使用条款,避免过度抓取或不当使用数据,确保你的行为符合当地法律法规及道德标准。

通过以上案例,我们可以看到Cookies和Session在Python爬虫中的重要作用,它们帮助我们保持登录状态,从而能够抓取需要身份验证才能访问的数据。

![[webpack5]个人复盘笔记](https://img-home.csdnimg.cn/images/20230724024159.png?origin_url=https%3A%2F%2Fp0-xtjj-private.juejin.cn%2Ftos-cn-i-73owjymdk6%2F4477f771a5764880812985963fbcc2b1~tplv-73owjymdk6-watermark.image%3Fpolicy%3DeyJ2bSI6MywidWlkIjoiMTMxNTk3MTI3MzkxNjkzIn0%253D%26rk3s%3De9ecf3d6%26x-orig-authkey%3Df32326d3454f2ac7e96d3d06cdbb035152127018%26x-orig-expires%3D1721631206%26x-orig-sign%3DS8Dp7FiuwyQ21bgT0OzcJrMTgdc%253D&pos_id=img-0Al9ye8U-1721570933096)