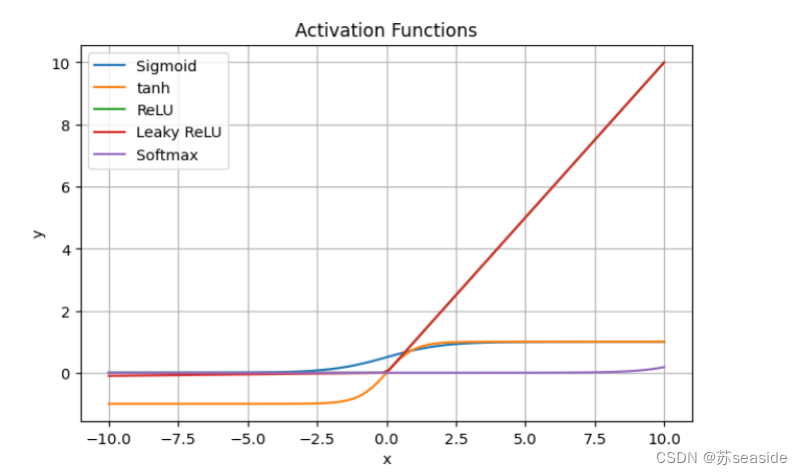

- sigmoid: \(\sigma(x)=1/(1+e^{-x})\);

- 优:将数值压缩到 0 1,导数为 \(\sigma(x)(1-\sigma(x))\) 好算。

- 劣:输出均值非0(0.5),梯度消失(Gradient vanishing)每次传过来的梯度都会乘上小于1的值,靠近输出的层 参数更新幅度大,而靠近输入的层 参数更新幅度小。

- ReLU: max(0, x) REctified Linear Unit

- 优:不饱和(梯度不会过小),计算量小

- 劣:输出均值非0,Dead ReLU:某层输入< 0,相应的输出值为0,那么此时该层就会"死亡",参数不会更新,而且不可逆转,神经元永远失效。

- Leaky ReLU: >0, 1 | <0, 0.1。解决 Dead ReLU。

- Tanh:

- 优:输出均值为0,原点附近与 y = x 函数相近;

- 劣:梯度消失(Gradient vanishing,但比 sigmoid 好),计算量大。

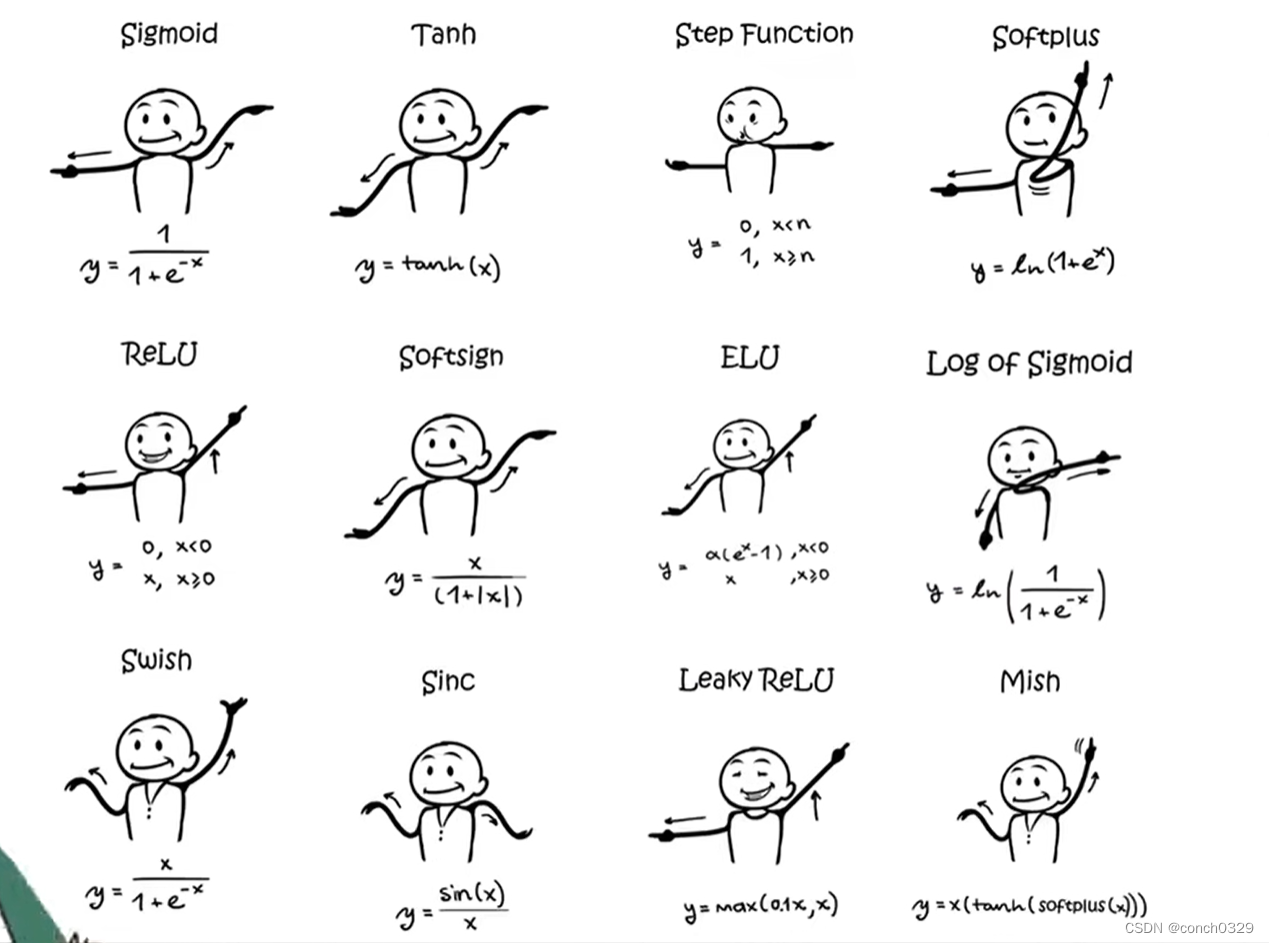

神经网络中的激活函数

2024-07-18 05:50:04 23 阅读