在深度学习领域,多任务学习(Multi-task Learning, MTL)是一种训练模型以同时执行多个任务的方法。这种方法可以提高模型的泛化能力,因为它允许模型在不同任务之间共享知识。近年来,Transformer模型因其在自然语言处理(NLP)中的卓越表现而成为研究的热点。本文将探讨Transformer模型在多任务学习中的应用,并展示一些代码示例。

1. Transformer模型简介

Transformer模型是由Vaswani等人在2017年提出的,它基于自注意力机制(Self-Attention)和位置编码(Positional Encoding),能够处理序列数据而无需循环或卷积结构。这种模型在机器翻译、文本摘要等任务中取得了突破性进展。

2. 多任务学习的基本概念

多任务学习的核心思想是让一个模型同时学习多个任务,这些任务可以是相似的,也可以是完全不同的。通过这种方式,模型可以在不同任务之间共享表示,从而提高学习效率和性能。

3. Transformer在多任务学习中的应用

Transformer模型可以通过共享底层表示来适应多任务学习。以下是几种常见的应用方式:

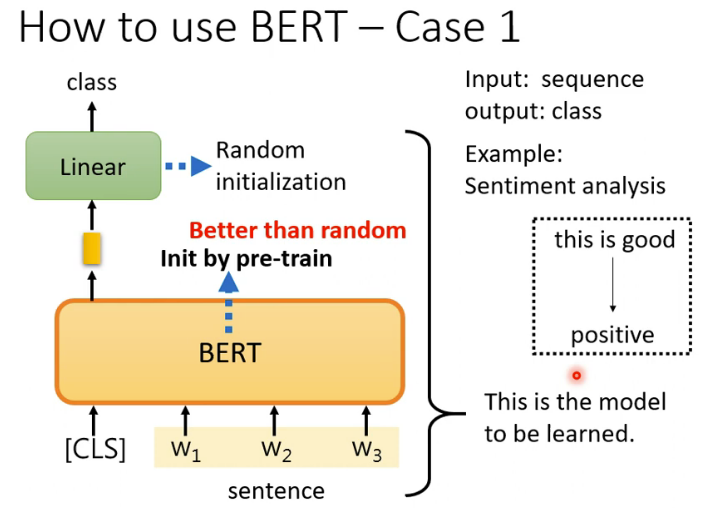

- 共享编码器:在多个任务中使用相同的Transformer编码器,然后在每个任务上使用特定的解码器或输出层。

- 任务特定的头:在Transformer的顶部添加任务特定的自注意力层,以学习特定于任务的特征。

- 并行输出:在模型的最后并行地添加多个输出层,每个输出层对应一个任务。

4. 代码示例

以下是一个简化的Transformer模型的代码示例,用于多任务学习:

import torch

import torch.nn as nn

from transformers import BertModel, BertConfig

class MultiTaskTransformer(nn.Module):

def __init__(self, num_tasks, config):

super(MultiTaskTransformer, self).__init__()

self.bert = BertModel(config)

self.classifier1 = nn.Linear(config.hidden_size, num_tasks[0])

self.classifier2 = nn.Linear(config.hidden_size, num_tasks[1])

# 可以继续添加更多的分类器

def forward(self, input_ids, attention_mask):

_, pooled_output = self.bert(input_ids, attention_mask=attention_mask, return_dict=False)

task1_output = self.classifier1(pooled_output)

task2_output = self.classifier2(pooled_output)

# 可以继续添加更多的任务输出

return task1_output, task2_output

# 配置和初始化模型

config = BertConfig.from_pretrained('bert-base-uncased')

num_tasks = [2, 3] # 假设有两个任务,分别有2个和3个类别

model = MultiTaskTransformer(num_tasks=num_tasks, config=config)

# 假设输入

input_ids = torch.tensor([[31, 51, 99], [15, 5, 0]]) # 示例输入

attention_mask = torch.tensor([[1, 1, 1], [1, 1, 0]]) # 对应的注意力掩码

# 前向传播

outputs = model(input_ids, attention_mask)

print(outputs)

5. 多任务学习的优势

使用Transformer模型进行多任务学习的优势包括:

- 知识共享:模型可以在不同任务之间共享知识,提高学习效率。

- 灵活性:可以轻松地添加或删除任务,而不影响其他任务。

- 泛化能力:通过学习多个任务,模型可以更好地泛化到未见过的数据。

6. 面临的挑战

尽管多任务学习有许多优势,但也存在一些挑战:

- 任务冲突:某些任务可能在特征表示上存在冲突,导致模型性能下降。

- 资源分配:模型需要平衡不同任务的学习,避免某些任务过度占据资源。

- 评估困难:评估多任务模型的性能可能比单任务模型更复杂。

7. 结论

Transformer模型在多任务学习中的应用展示了其强大的灵活性和泛化能力。通过适当的设计和调整,Transformer模型可以有效地处理多个任务,提高模型的实用性和效率。随着研究的深入,我们可以期待Transformer模型在多任务学习中发挥更大的作用。

这篇文章提供了Transformer模型在多任务学习中的一个概览,并提供了一个简单的代码示例来说明如何实现这种模型。随着深度学习技术的不断发展,我们有理由相信Transformer模型将在多任务学习领域发挥越来越重要的作用。