目录

4、DRL显著提高了学习速度,特别是在具有大状态和大动作空间的问题中

5、通信和网络中的其他几个问题,如网络物理攻击、干扰管理和数据卸载,可以建模为游戏

二、马尔科夫决策过程(Markov Decision Process)

2、部分可观测马尔科夫决策过程(Partially Observable Markov Decision Process,POMDP):

2、MDP和POMDP与深度强化学习DRL/强化学习RL间的关系

一、深度强化学习概述(DRL)

现代网络规模大、结构复杂,计算复杂度很快变得难以控制。因此,DRL一直在发展成为克服这一挑战的替代解决方案。一般来说,DRL方法提供以下优点:

1、DRL可以获得复杂网络优化的解决方案

因此,它使现代网络中的网络控制器,如基站,在没有完整准确的网络信息的情况下,解决联合用户关联、计算、传输调度等非凸复杂问题,达到最优解。

2、DRL允许网络实体学习和构建有关通信和网络环境的知识

因此,通过使用DRL,网络实体(例如移动用户)可以在不知道信道模型和移动模式的情况下学习最优策略,例如基站选择、信道选择、切换决策、缓存和卸载决策

3、DRL提供自主决策

使用DRL方法,网络实体可以在最小或不需要相互交换信息的情况下局部观察并获得最佳策略。这不仅减少了通信开销,而且提高了网络的安全性和健壮性。

4、DRL显著提高了学习速度,特别是在具有大状态和大动作空间的问题中

因此,在大型网络中,例如拥有数千台设备的物联网系统,DRL允许网络控制器或物联网网关动态控制大量物联网设备和移动用户的用户关联、频谱接入和传输功率

5、通信和网络中的其他几个问题,如网络物理攻击、干扰管理和数据卸载,可以建模为游戏

例如,非合作游戏。DRL最近被用作解决博弈的有效工具,例如,在没有完整信息的情况下找到纳什均衡

二、马尔科夫决策过程(Markov Decision Process)

MDP是一个离散的时间随机控制过程。MDP为决策问题的建模提供了一个数学框架,在这些问题中,结果是随机的,并且受决策者或代理的控制。MDP对于研究可以通过动态规划和强化学习技术解决的优化问题是有用的。

1、典型的马尔科夫过程建模(MDP)

首先,MDP被定义为一个元组。其中,S是状态的有限集合,A是动作的有限集合,p是指在动作a

执行后从状态s到状态s'的转移概率,并且r是执行动作a之后获得的即时奖励

。

我们将表示为一个策略,它是一个从状态到动作的映射。MDP的目标是找到一个使奖励函数最大化的最优策略。MDP可以是有限或无限的时间范围。对于有限时间范围MDP,使得期望总汇报最大化的最优策略

由

![]() 定义,其中,

定义,其中,,指的就是策略在st下选择动作at。对于无限时间范围MDP,目标可以是最大化预期的折扣总奖励或最大化平均奖励。折扣总奖励被定义为

![]() ,平均奖励被定义为

,平均奖励被定义为![]() 。其中

。其中表示的是折扣率,折现系数γ决定了未来奖励相比于当前奖励的重要性。

当

时,智能体只考虑当前利益,即最大化即时的奖励;相反,若

接近于1,智能体/代理agent将会争取长期更高的奖励。

2、部分可观测马尔科夫决策过程(Partially Observable Markov Decision Process,POMDP):

在MDP中,我们假设系统状态是被agent完全观察到的。然而,在许多情况,智能体agent仅能观察到系统状态的一部分,因此因此,部分可观察马尔可夫决策过程(POMDPs)可用于建模决策问题。

一个典型的POMDP模型可以被定义为六元组,其中,元组中的前面四个元素可以看到,与基本的MDP模型所代表的含义相同。这其中的

和O分别表示观测集合和观测概率。在每个时间点(at each time epoch),agent智能体处于状态s,基于它对当前状态s的信念b(s)选择一个动作a,并观察即时奖励r和当前观察值o。基于观察值o和它对当前状态的信念b(s),然后智能体更新关于新状态s'的信念b(s'),如下所示(as follows):

其中,O(o|s,a,s')指的是agent在状态s下采取动作a获得观测o的概率以及agent移动到状态s'。p(s'|s,a)的定义与MDP相同,表示在状态s下执行动作a从状态s到状态s'的转移概率。最后,agent获得的即时奖励r等于MDp中的r(s,a)。与MDP模型相类似,POMDP中的智能体也以寻找最优策略为目标,以最大化它的预期长期贴现奖励

![]()

3、对比MDP与POMDP:

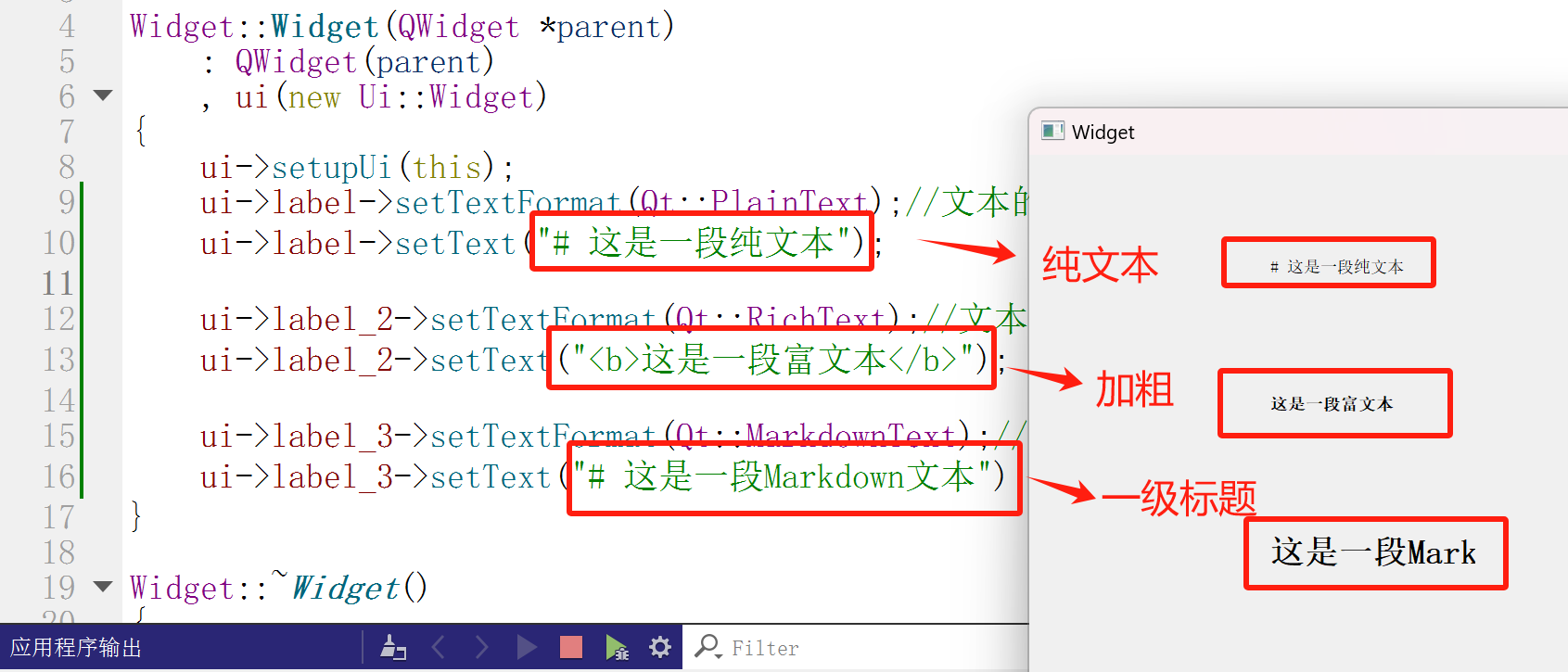

在下图fig3中,主要强调对比了MDP和POMDP模型。

对于MDP模型来说,当前智能体需要观测状态st,然后根据策略/值函数(V/Q函数)选出最优的动作并执行,此时会反馈一个即时的奖励rt,并且会进入到下一时刻的状态st+1。

对于POMDP模型来说,引入了观测空间O。由于在POMDP模型中,智能体无法直接观察到环境的状态,而是通过观察到的部分信息来推断环境的状态。观测到的信息可以是不完全的、模糊的,又或者是有噪声的,这就使得智能体需要在不完全信息的情况下做出决策。

三、总结

1、与Markov相关的四个概念

马尔科夫链(Markov Chain)、马尔科夫决策过程(Markov Decision Process,MDP)、部分可观察马尔科夫决策过程(Partially Obserable Markov Decision Process,POMDP)、隐马尔科夫模型(HMM)。

2、MDP和POMDP与深度强化学习DRL/强化学习RL间的关系

MDP和POMDP都是一种数学模型,它是现实中一部分问题的抽象表达形式;而深度强化学习则是一种利用深度学习技术解决强化学习问题的方法;强化学习是一种机器学习范式,旨在让智能体agent通过与环境的交互学习如何做出决策,以最大化长期奖励。

由此可见,MDP和POMDP都提供了强化学习问题的数学框架,而DRL是一种利用深度学习技术解决这些问题的方法,DRL可以应用于MDP和POMDP的求解,为解决复杂的问题提供了一种有效的途径。

参考论文:Applications of Deep Reinforcement Learning in Communications and Networking: A Survey.

还有一些其它方面已学习过的。

![二叉搜索树的实现[C++]](https://i-blog.csdnimg.cn/direct/698b703c2b5247cd9324e7cc92b5da8b.gif#pic_center)