标题:用于野外情绪识别的联合多模态Transformer

摘要

多模态情感识别(MMER)系统通常通过利用诸如视觉、文本、生理和听觉模态之间的跨模态和内模态关系,从而超越单模态系统的表现。本文提出了一种基于联合多模态变换器(Joint Multimodal Transformer,简称JMT)的MMER方法,该方法采用基于键的交叉注意力进行融合。此框架能够利用不同模态的互补特性,以提高预测准确性。独立的后端网络在视频序列中捕获每个模态内的时空依赖关系。随后,我们的JMT融合架构整合了个别模态的嵌入,使模型能有效捕捉跨模态和内模态的关系。广泛的实验在两个具有挑战性的情感识别任务上进行了验证:(1) 在Affwild2数据集上进行维度情感识别(包含面部和声音信息);以及(2) 在BioVid数据集上进行疼痛估计(包含面部和生物传感器信息)。实验结果表明,我们的JMT融合提供了一种成本效益高的MMER解决方案。实证结果证明,采用我们所提出的融合方式的MMER系统能够在相关基准和最先进方法之上取得更优的表现。

Keywords: Affective Computing, Multi-Modal Fusion,Audio-Visual Fusion, Transformers, Cross-Attention, Valence-Arousal Estimation.

方法

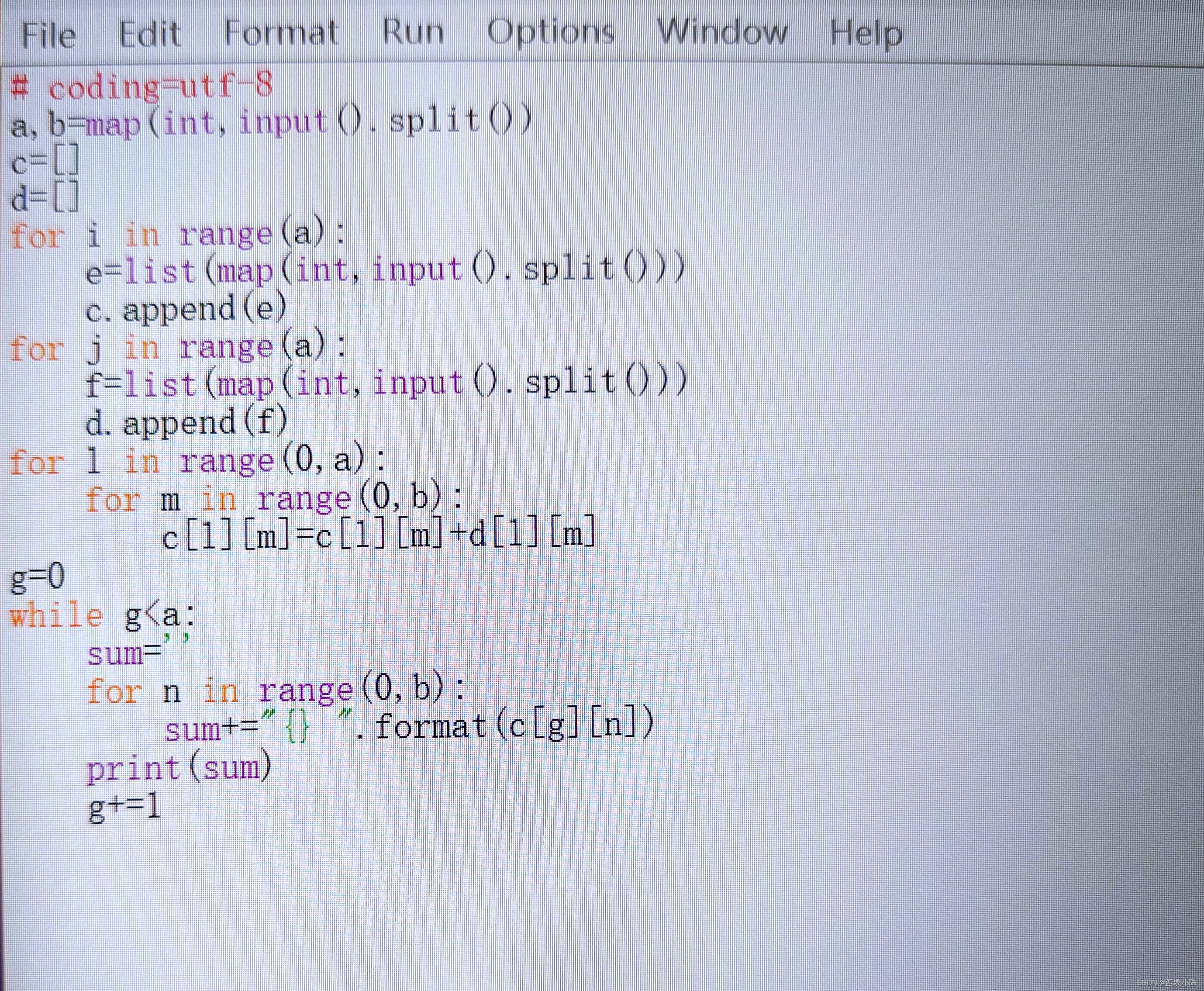

所提出的方法是一种层次化的融合机制,其中模态内部特征通过基于变换器(self-attention)的注意力机制进行组合,而跨模态特征则通过基于变换器(cross-attention)的注意力机制进行融合。此外,我们将第三个联合表示输入到联合变换器模块(Joint Transformer Module, JTM)中,以增强系统的鲁棒性。K(键矩阵)、V(值矩阵)和Q(查询矩阵)向量在这六个变换器块之间共享。最终,这六个块的输出再次送入一个变换器自注意力块,以便动态地加权最相关的表示。最后的预测是通过全连接(fully connected, FC)层来做出的。

1.特定模态的特征提取

在第一步中,使用特定的后端网络(backbones)提取模态特异性的特征。所提出的方法允许为每个模态结合多个后端网络,以此来提升系统的鲁棒性。从每个后端网络提取的特征向量被送入变换器自注意力(Transformer Self-Attention)块。组合后的特征向量代表了特定的模态。例如,为了捕捉一个人情绪状态的信息,我们可以使用预训练在Kinetics-400数据集上的R(2+1)D CNN来提取视觉特征。对于音频模态,我们可能使用带有门控循环单元(GRU)的ResNet18 CNN来提取特征。

2.多Transformer注意力融合

我们定义为从后端网络A中抽取的深度特征,以及

为从后端网络B中抽取的深度特征,如图2所示。给定

和

,联合特征表示是通过连接(concatenating)

和

特征向量获得的:

其中[·; ·] 表示一个连接操作。然后,这些连接的特征会被送入全连接层(FC层),对联合特征表示进行降维,产生。现在我们有三个关键的信息来源:

,

和

,它们具有相同的维度。

每种表示随后被送入一个特定的编码器。我们的模型由三个不同的编码器组成,分别对应于每种类型的特征,

,和

。每个编码器包含一个多头自注意力机制(见式2)随后是全连接前馈网络。在这些层周围执行残差连接和层归一化。键(Key)用于将序列关联到键值,值矩阵(Value Matrix)持有最终用于计算注意力机制输出的信息,查询矩阵(Query Matrix)代表一组用于查询键值对的向量。

K,V,Q矩阵这样计算:,

,

。X对应于一个信息源(

,

,和

),

,

,

分别是键、查询、值矩阵的权重。自注意力层的输出值由下式给出:

通过自注意力层(图中的Transformer Encoder),每个编码器独立地关注与其各自信息源相关的重要线索。之后,每个编码器的嵌入通过利用六个跨模态注意力层进行组合,在这些层中查询矩阵Q与其它信息源的键K和值V矩阵共享。在每个信息源之间共享这个矩阵帮助模型增加冗余并补充视觉和音频模态,从而提高其性能。在每个六跨注意力模块的输出,输出一个512维的特征向量。这六个特征向量随后堆叠形成一个序列,然后送入一个变换器自注意力块。这个块动态地选择和加权这些特征向量。最后,加权后的特征被送入一个全连接层进行最终预测。

模型的目标是最大化一致性相关系数(CCC)[30],这是在维度情感识别中常见的。为了实现这一点,我们最小化以下损失函数:

其中是预测与真实值之间的协方差,

和\( \rho^2_y \)分别是预测和真实值的方差,

和

)分别是预测和真实值的均值。

实现细节

Affwild2:在视觉模态中,使用数据集中提供的裁剪和对齐的面部图像[27]。视觉模态中缺失的帧用黑色帧(零像素)替换。这些图像随后被送入一个接受224×224输入大小的3D网络。使用长度为8的片段,构成一个由64帧组成的子序列。每个子序列包含八个片段。线性层中使用了0.8的丢弃率进行网络正则化。网络使用初始学习率为10^-3的随机梯度下降(SGD)迭代方法进行优化。视觉模态使用的批次大小为8。为了进一步泛化,随机裁剪和随机水平翻转被添加作为数据增强手段。最大训练轮次为50,使用早期停止策略进行模型选择。在音频模态中,每个视频的音频被分离并重采样至44 kHz。按照视觉模态的分段,提取对应片段长度的小语音段。使用ResNet18从频谱图中抽取特征。使用长度为1024的离散傅立叶变换,跳长度为10毫秒,窗口长度为20毫秒,以获取每个语音段的频谱图。频谱图的分辨率为64×107像素,对应视觉模态中的单个片段。频谱图的其他预处理包括均值和方差归一化,以及转换为对数功率谱。预训练ResNet模型中的第一个卷积层被调整以接收单通道的频谱图。使用1×10^-2的学习率和Adam优化器来优化网络。音频模态的批次大小设置为64。

音频和视觉后端网络被冻结以训练音频-视觉融合网络,仅训练整个基于变换器的融合模型。这些后端网络各自输出512维的深度特征向量。这些特征被拼接(以获得联合特征表示,即1024维的特征向量),然后送入全连接层以减少维度至512。这些特征被送入融合模型,如图2所示。在每个六个跨注意力模块的输出,输出512维的特征向量。这六个特征向量随后堆叠形成一个序列,然后送入一个变换器自注意力块。这个块动态地选择和加权这些特征向量。最终加权后的特征被送入全连接层进行最终预测。我们进行网格搜索以找到我们融合网络的最佳学习率和批次大小。因此,我们使用一系列的学习率:[8×10^-4, 6×10^-4, 3×10^-4],并使用SGD优化器优化融合网络。我们使用32的批次大小,最大训练轮次为5,使用早期停止策略进行融合模型选择。我们从前面列出的学习率中选择最佳模型。

BioVid:在视觉模态中,使用MTCNN进行人脸裁剪和对齐。我们应用帧保留策略处理不可见面部的缺失帧,此时MTCNN无法捕获任何帧。此外,为了确保视觉模型的无噪输入,我们剪切视频开头的前2秒和结尾的最后0.5秒,因为这段时间内被试没有表现出痛苦迹象。总帧数为75。提取的人脸被送入R3D模型作为视觉特征提取器。批次大小设置为64。网络使用SGD优化器单独优化,学习率为10^-3。

对于生理模态,使用电皮质活动(EDA)。信号被裁剪以对应视觉模态,并送入一个1D CNN。自定义1D-CNN的架构如表1所示。CNN输出一个512维的特征向量。模型使用学习率为10^-4的SGD优化器进行优化。生理后端网络的批次大小设置为1024。

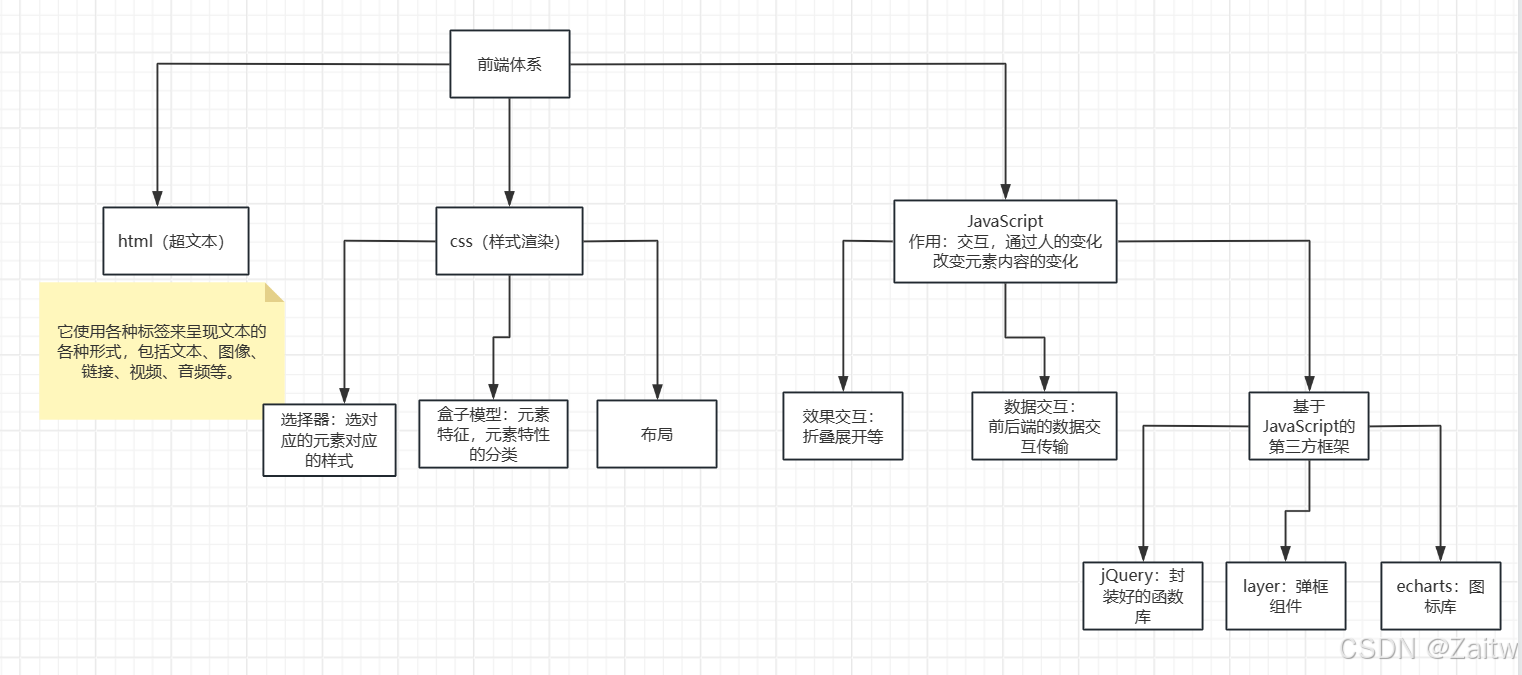

对于模态融合,两个特征向量和联合表示被送入联合变换器块,如图3所示。从后端训练阶段添加到两个后端的全连接层被移除。从视觉和生理后端获得512维的特征向量,并送入联合多模态变换器模块。后端网络被冻结,联合变换器块使用学习率为5×10^-6的ADAM优化器进行优化,批次大小设置为128。

图3:用于Biovid疼痛估计任务的拟议联合多模态变压器架构的说明。蓝色分支为视觉主干,黄色分支为生理主干。联合表示用红色块表示。将三个特征向量馈送到联合变压器块中。

结论

多模态情感识别系统相较于其单模态对手,在野外环境下的表现尤为突出。缺失和噪声模态是在野外环境中进行情感识别系统普遍面临的问题。文献中提出了许多基于注意力的方案来克服这一难题。这些方法旨在动态地对模态进行加权。本文介绍了一种用于情感识别的联合多模态变换器。基于变换器的架构引入了联合特征表示,以增加音频和视觉数据之间的冗余性和互补性。首先,使用独立的后端网络对两种模态进行编码,以提取模态内的时空依赖关系。接着,将两种模态的特征向量进行联合,同时将联合特征向量送入联合多模态变换器模块。这一联合表示提供了关于两种模态间互相关联的更为精细的信息。提出的模型在BioVid数据集上超越了现有技术,且在AffWild2数据集上相比基础的多模态变换器提高了6%的性能。未来的工作将包括引入更多模态以及更复杂的后端网络,以实现更有效的特征提取。这将有助于构建更全面、更精确的情感识别系统,能够更好地应对复杂多变的实际应用场景,尤其是在面对多种模态数据的挑战时。