理解CNN中的Batch Normalization - 知乎 (zhihu.com)

https://zhuanlan.zhihu.com/p/403073810

BN层常见有针对1d特征(全连接层后面的)

举一个简单的例子吧 解释在全连接层(Fully Connected Layer, FC Layer)后加 BN 层时,如何计算均值和方差。

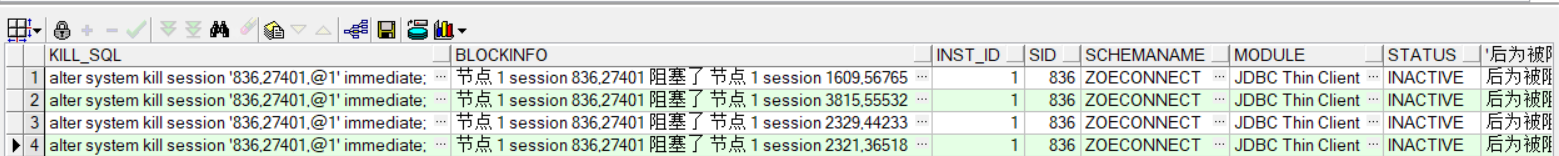

假设有一个全连接层的输出(一个 batch)如下:

这里,有 4 个样本(batch size = 4),每个样本有 3 个特征(feature dim = 3)。

计算均值和方差

对于每一个特征维度(每一列),分别计算均值和方差:

计算均值:

计算方差:

最后,通过 γ和 β 进行重新缩放和平移。比如,如果 γ1=1 和 β1=0,那么最终的输出就是标准化后的值;如果 γ1 和 β1是其他值,那么输出会相应地进行缩放和平移。

为什么需要可学习参数 γ 和 β?

虽然标准化可以使得特征的分布更加稳定,但对于深层神经网络而言,仅仅依赖标准化可能会限制模型的表达能力。因此,通过引入γ 和 β,我们可以让模型在保持数值稳定的前提下,灵活地学习到特征的最佳尺度和偏移,从而提高整体性能。

通过反向传播算法,BN 层的参数γ 和 β可以逐步优化,使得神经网络在训练过程中不仅能标准化特征,还能通过调整特征的尺度和偏移来更好地拟合数据,从而提高模型的表现。

神经网络中的其他参数(如权重和偏置)一样。以下是具体的学习过程:

![[学习笔记]<span style='color:red;'>知</span><span style='color:red;'>乎</span>文章-PyTorch<span style='color:red;'>的</span>Transformer](https://img-blog.csdnimg.cn/direct/6c4acc951fa34af68e82add16afe4313.png)