ELK 概述

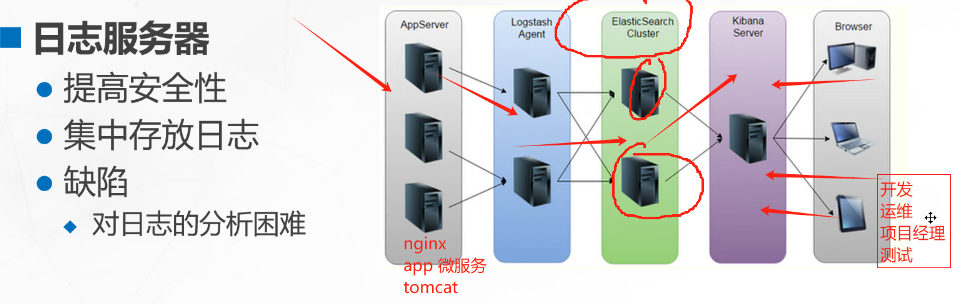

(1)我们为什么要使用 ELK ?

日志主要包括系统日志、应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

往往单台机器的日志我们使用grep、awk等工具就能基本实现简单分析,但是当日志被分散存储在不同的设备上。如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志。这样是不是感觉很繁琐和效率低下。当务之急我们使用集中化的日志管理,例如:开源的rsyslog,将所有服务器上的日志收集汇总。集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用grep、awk和wc等Linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量依然使用这样的方法难免有点力不从心。

一般大型系统是一个分布式部署的架构,不同的服务模块部署在不同的服务器上,问题出现时,大部分情况需要根据问题暴露的关键信息,定位到具体的服务器和服务模块,构建一套集中式日志系统,可以提高定位问题的效率。

(2)完整日志系统的基本特征

- 收集:能够采集多种来源的日志数据

- 传输:能够稳定的把日志数据解析过滤并传输到存储系统

- 存储:存储日志数据

- 分析:支持 UI 分析

- 警告:能够提供错误报告,监控机制

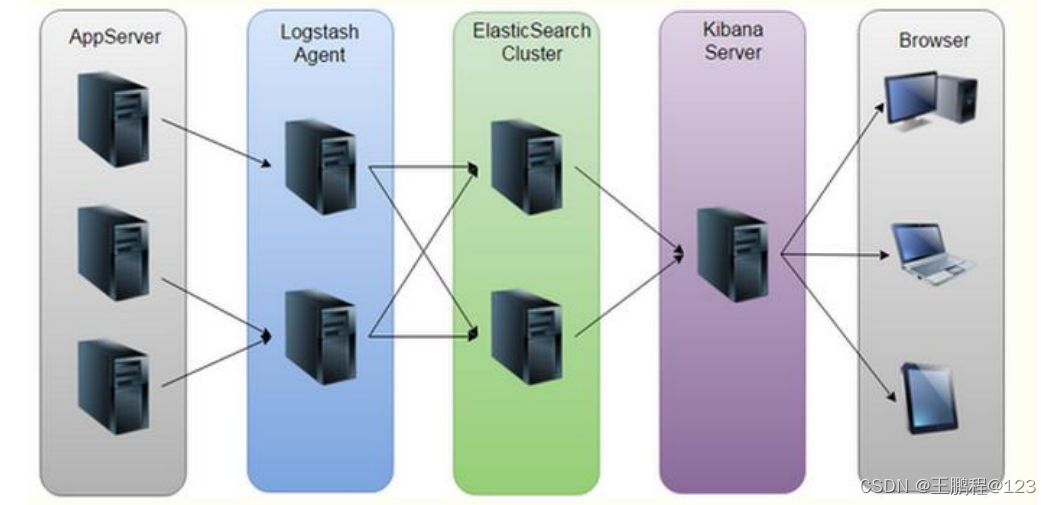

(3)ELK 的介绍

ELK平台是一套完整的日志集中处理解决方案,将 ElasticSearch、Logstash 和 Kiabana 三个开源工具配合使用, 完成更强大的用户对日志的查询、排序、统计需求。

- Logstash:负责日志数据的收集,还有通过插件对日志数据进行过滤和格式化处理,然后输出给ElasticSearch

- ElasticSearch:负责对日志数据进行分片、存储以及创建索引,便于全文检索

- Kiabana:用于接入ElasticSearch的数据源,将日志数据进行图形化展示,便于用户通过浏览器查看、搜索和分析日志

可以添加的其它组件:

- Filebeat:用于替代Logstash采集日志数据,相比较于Logstash,更加的轻量,消耗资源更少

- Fluentd:同样是一种Logstash的替代方案,可以用于替代Logstash采集日志数据和过滤转换等功能,常用于收集K8S环境中的容器日志

- Redis、Kafka、RabbitMQ等:作为消息队列MQ,实现流量销峰、缓冲以及应用解耦等功能

Filebeat 结合 Logstash 有什么益处?

- 通过 Logstash 具有基于磁盘的自适应缓冲系统,该系统会吸收传入的吞吐量,从而减轻 Elasticsearch 持续写入数据的压力

- 从其他数据源(例如数据库,S3对象存储或消息传递队列)中提取

- 将数据发送到多个目的地,例如S3,HDFS(Hadoop分布式文件系统)或写入文件

- 使用条件数据流逻辑组成更复杂的处理管道

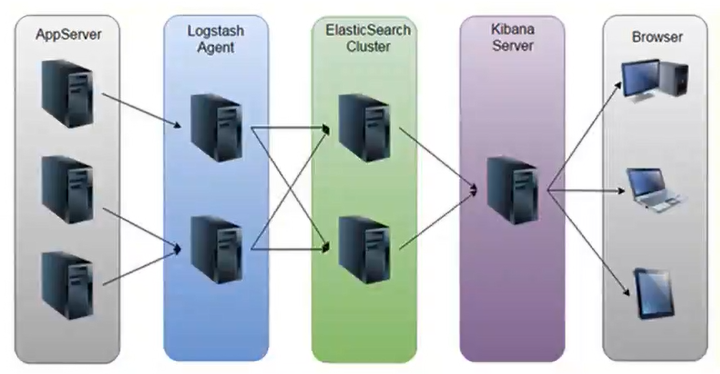

(4)ELK 的工作原理

- 在所有需要收集日志的服务器上部署 Logstash;或者先将日志进行集中化管理在日志服务器上,在日志服务器上部署 Logstash。

- Logstash 收集日志,将日志格式化并输出到 Elasticsearch 群集中。

- Elasticsearch 对格式化后的数据进行索引和存储。

- Kibana 从 ES 群集中查询数据生成图表,并进行前端数据的展示。

总结:

Logstash 作为日志搜集器,从数据源采集数据,并对数据进行过滤,格式化处理,然后交由 Elasticsearch 存储,Kibana 对日志进行可视化处理。

ELK Elasticsearch 集群部署

node1节点(2C/4G):node1/192.168.80.10 Elasticsearch

node2节点(2C/4G):node2/192.168.80.20 Elasticsearch

Apache节点:apache/192.168.80.30 Logstash Kibana Apache

初始化关闭防火墙

[root@localhost ~]# systemctl stop firewalld

[root@localhost ~]# setenforce 0

setenforce: SELinux is disabled

在Node1、Node2节点上操作

1.环境准备

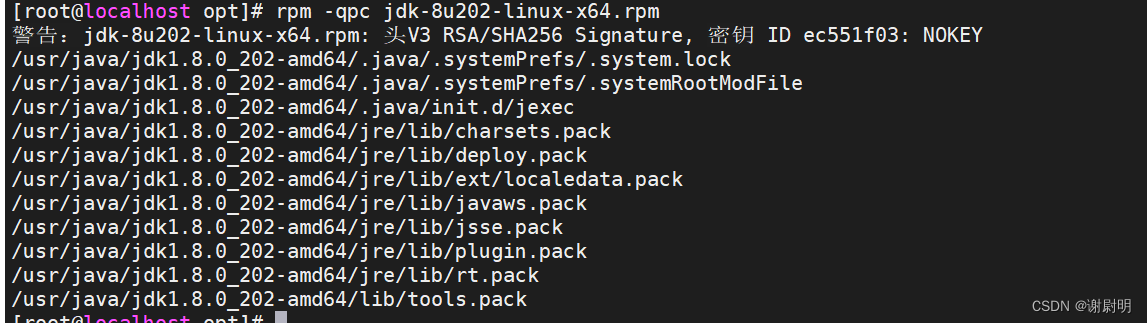

设置Java环境

[root@localhost ~]# java -version

openjdk version "1.8.0_332"

OpenJDK Runtime Environment (build 1.8.0_332-b09)

OpenJDK 64-Bit Server VM (build 25.332-b09, mixed mode)

2.部署 Elasticsearch 软件

(1)安装elasticsearch—rpm包

上传elasticsearch-6.7.2.rpm到/opt目录下

[root@localhost ~]# cd /opt/

[root@localhost opt]# ls

elasticsearch-6.7.2.rpm mysql-5.7.44 mysql-boost-5.7.44.tar.gz rh

[root@localhost opt]# rpm -ivh elasticsearch-6.7.2.rpm

警告:elasticsearch-6.7.2.rpm: 头V4 RSA/SHA512 Signature, 密钥 ID d88e42b4: NOKEY

准备中... ################################# [100%]

Creating elasticsearch group... OK

Creating elasticsearch user... OK

正在升级/安装...

1:elasticsearch-0:6.7.2-1 ################################# [100%]

### NOT starting on installation, please execute the following statements to configure elasticsearch service to start automatically using systemd

sudo systemctl daemon-reload

sudo systemctl enable elasticsearch.service

### You can start elasticsearch service by executing

sudo systemctl start elasticsearch.service

Created elasticsearch keystore in /etc/elasticsearch

(2)修改elasticsearch主配置文件

[root@localhost ~]# cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

[root@localhost ~]# vim /etc/elasticsearch/elasticsearch.yml

[root@localhost ~]# grep -v "^#" /etc/elasticsearch/elasticsearch.yml

cluster.name: my-elk-cluster

node.name: node1

node.master: true

node.data: true

path.data: /var/lib/elasticsearch

path.logs: /var/log/elasticsearch

bootstrap.memory_lock: true

network.host: 0.0.0.0

http.port: 9200

transport.tcp.port: 9300

discovery.zen.ping.unicast.hosts: ["192.168.80.10:9300", "192.168.80.20:9300"]

修改内容如下:

--17--取消注释,指定集群名字

cluster.name: my-elk-cluster

--23--取消注释,指定节点名字:Node1节点为node1,Node2节点为node2

node.name: node1

node.master: true #是否master节点,false为否

node.data: true #是否数据节点,false为否

--33--取消注释,指定数据存放路径

path.data: /var/lib/elasticsearch

--37--取消注释,指定日志存放路径

path.logs: /var/log/elasticsearch

--43--取消注释,将系统内存锁定到es进程中,以保证es能够维护一定的内存空间,避免es使用swap交换分区

bootstrap.memory_lock: true

--55--取消注释,设置监听地址,0.0.0.0代表所有地址

network.host: 0.0.0.0

--59--取消注释,ES 服务的默认监听端口为9200

http.port: 9200 #指定es集群提供外部访问的接口

transport.tcp.port: 9300 #指定es集群内部通信接口

--68--取消注释,集群发现通过单播实现,指定要发现的节点

discovery.zen.ping.unicast.hosts: ["192.168.80.10:9300", "192.168.80.11:9300"](3)es 性能调优参数

优化最大内存大小和最大文件描述符的数量

[root@localhost ~]# vim /etc/security/limits.conf

添加以下内容:

......

* soft nofile 65536

* hard nofile 65536

* soft nproc 32000

* hard nproc 32000

* soft memlock unlimited

* hard memlock unlimited[root@localhost ~]# vim /etc/systemd/system.conf

添加以下内容:

DefaultLimitNOFILE=65536 #51行修改

DefaultLimitNPROC=32000 #53行修改

DefaultLimitMEMLOCK=infinity #54行修改[root@localhost ~]# vim /etc/sysctl.conf

#一个进程可以拥有的最大内存映射区域数,参考数据(分配 2g/262144,4g/4194304,8g/8388608)

添加以下内容:

vm.max_map_count=262144

[root@localhost ~]# sysctl -p

vm.max_map_count = 262144

[root@localhost ~]# reboot #重启

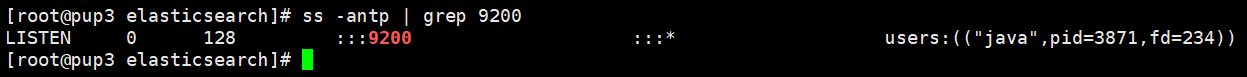

(4)启动elasticsearch是否成功开启

[root@localhost ~]# systemctl start elasticsearch.service

[root@localhost ~]# systemctl enable elasticsearch.service

Created symlink from /etc/systemd/system/multi-user.target.wants/elasticsearch.service to /usr/lib/systemd/system/elasticsearch.service.

[root@localhost ~]# netstat -antp | grep 9200

#JVM优化

[root@localhost ~]# cd /etc/elasticsearch/

[root@localhost elasticsearch]# vim jvm.options

......

22行 -Xms2g #设置为物理内存的一般

23行 -Xmx2g #设置为物理内存的一般

[root@localhost elasticsearch]# systemctl restart elasticsearch.service

[root@localhost elasticsearch]# netstat -antp | grep 9200

tcp6 0 0 :::9200 :::* LISTEN 2491/java

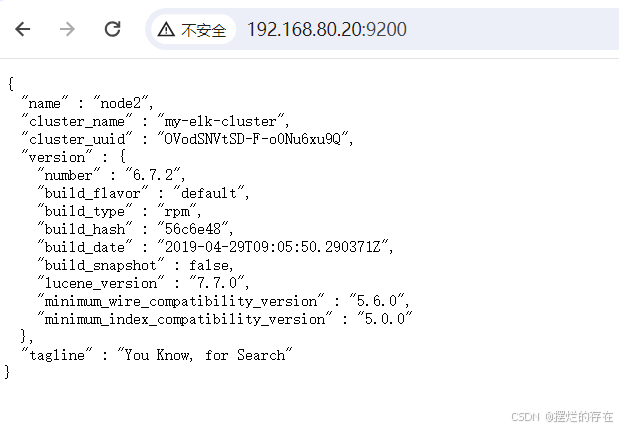

(5)查看节点信息

浏览器访问 http://192.168.80.10:9200 、 http://192.168.80.20:9200 查看节点 Node1、Node2 的信息

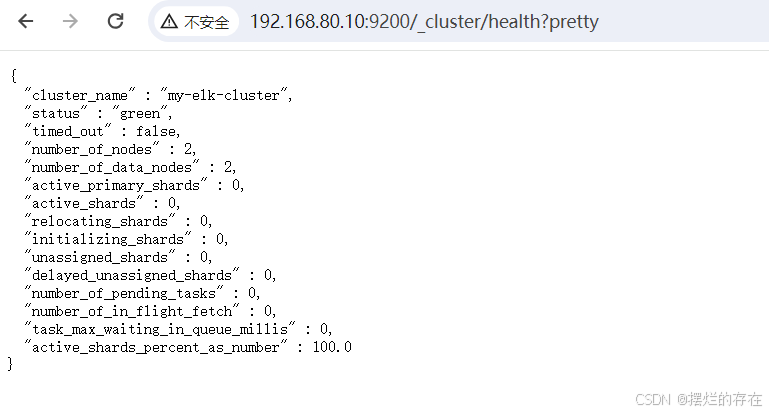

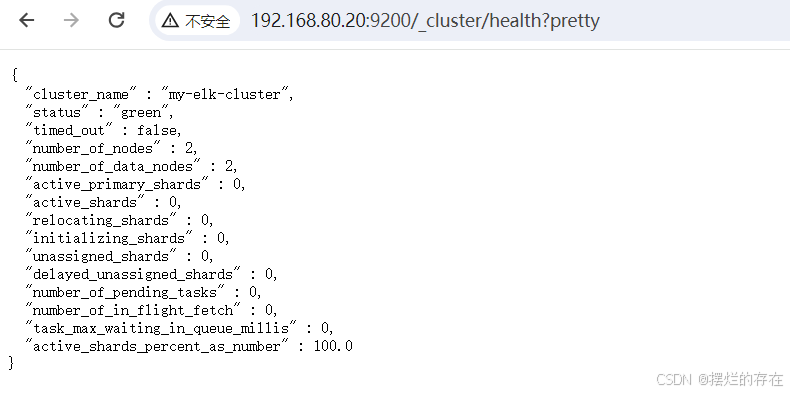

浏览器访问 http://192.168.80.10:9200/_cluster/health?pretty 、 http://192.168.80.11:9200/_cluster/health?pretty查看群集的健康情况,可以看到 status 值为 green(绿色), 表示节点健康运行

浏览器访问 http://192.168.80.10:9200/_cluster/state?pretty 检查群集状态信息

#使用上述方式查看群集的状态对用户并不友好,可以通过安装 Elasticsearch-head 插件,可以更方便地管理群集

3.安装 Elasticsearch-head 插件

(1)编译安装 node

上传软件包 node-v8.2.1.tar.gz 到/opt

[root@localhost elasticsearch]# cd /opt

[root@localhost opt]# mount /dev/dr0 /mnt

[root@localhost opt]# yum install gcc gcc-c++ make -y

[root@localhost opt]# tar xf node-v8.2.1.tar.gz

[root@localhost opt]# cd node-v8.2.1/

[root@localhost node-v8.2.1]# ./configure

(2)安装 phantomjs

上传软件包 phantomjs-2.1.1-linux-x86_64.tar.bz2 到/opt

[root@localhost node-v8.2.1]# cd /opt/

[root@localhost opt]# tar xf phantomjs-2.1.1-linux-x86_64.tar.bz2

[root@localhost opt]# cd /opt/phantomjs-2.1.1-linux-x86_64/bin

[root@localhost bin]# ls

phantomjs

[root@localhost bin]# cp phantomjs /usr/local/bin

(3)安装 Elasticsearch-head 数据可视化工具

上传软件包 elasticsearch-head-master.zip 到/opt

[root@localhost opt]# unzip elasticsearch-head-master.zip

[root@localhost opt]# cd elasticsearch-head-master/

[root@localhost elasticsearch-head-master]# npm install #安装依赖包

(4)修改 Elasticsearch 主配置文件

[root@localhost elasticsearch-head-master]# vim /etc/elasticsearch/elasticsearch.yml

末尾添加以下内容:

......

http.cors.enabled: true #开启跨域访问支持,默认为 false

http.cors.allow-origin: "*" #指定跨域访问允许的域名地址为所有

[root@localhost elasticsearch-head-master]# systemctl restart elasticsearch

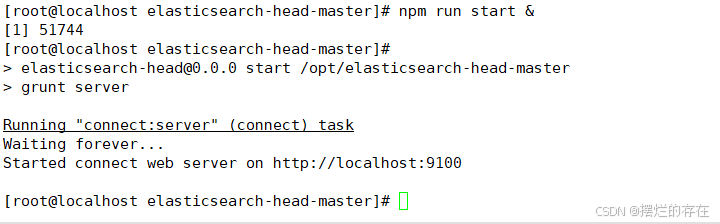

(5)启动 elasticsearch-head 服务

必须在解压后的 elasticsearch-head-master 目录下启动服务,进程会读取该目录下的 gruntfile.js 文件,否则可能启动失败。

[root@localhost elasticsearch-head-master]# npm run start &

[1] 51744

[root@localhost elasticsearch-head-master]#

> elasticsearch-head@0.0.0 start /opt/elasticsearch-head-master

> grunt server

Running "connect:server" (connect) task

Waiting forever...

Started connect web server on http://localhost:9100

elasticsearch-head 监听的端口是 9100

[root@localhost elasticsearch-head-master]# netstat -natp |grep 9100

tcp 0 0 0.0.0.0:9100 0.0.0.0:* LISTEN 51754/grunt

(6)通过 Elasticsearch-head 查看 Elasticsearch 信息

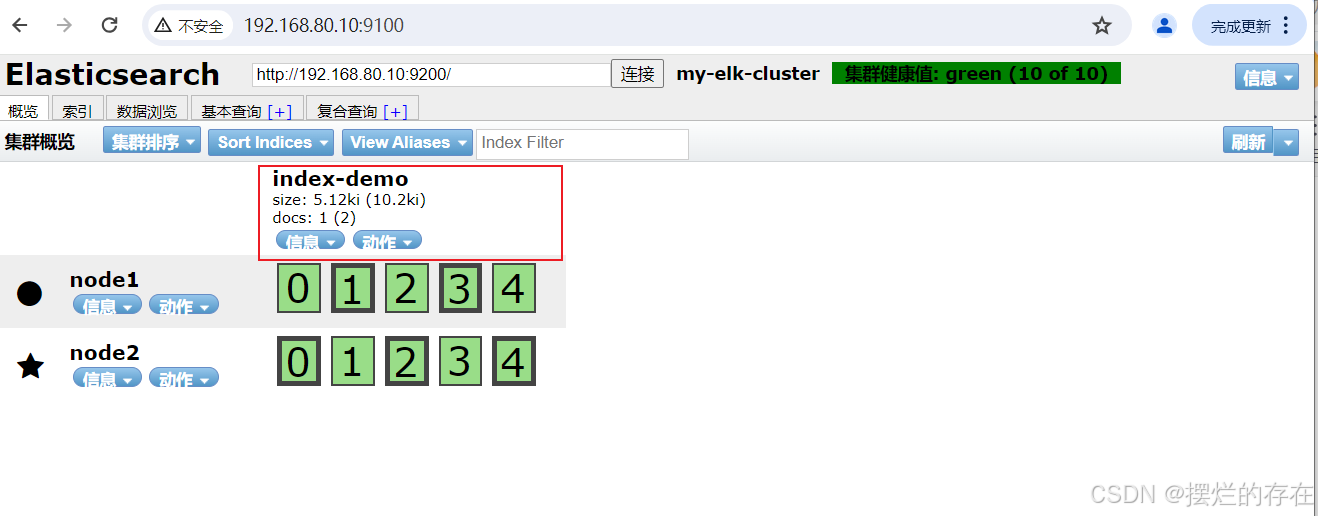

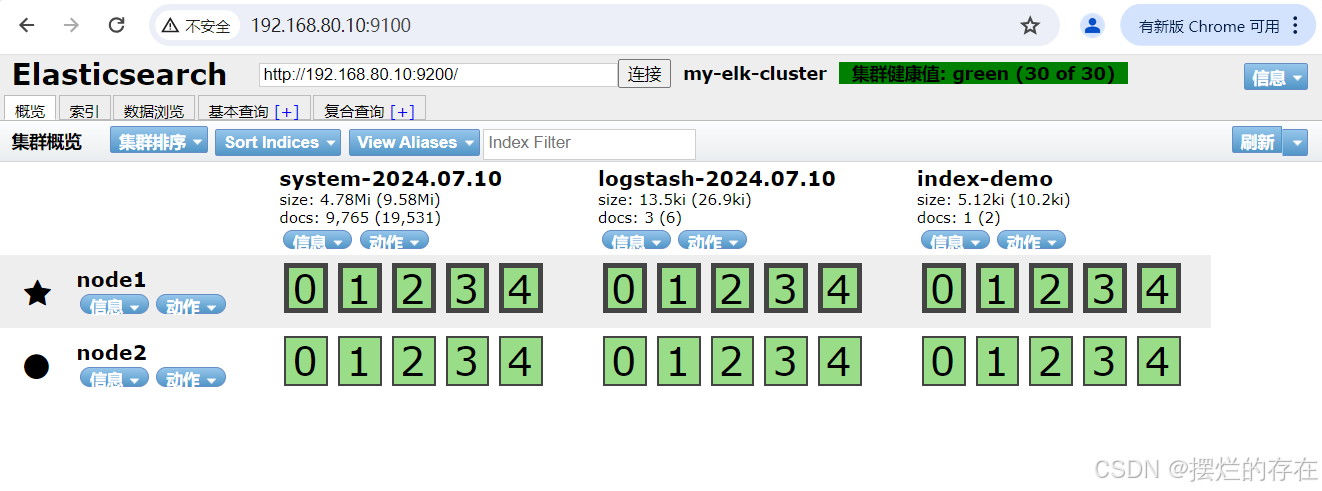

通过浏览器访问 http://192.168.80.10:9100/ 地址并连接群集。如果看到群集健康值为 green 绿色,代表群集很健康。

(7)创建索引

API基本格式:http://ip:port/<索引>/<类型>/<文档id>

#通过命令创建一个测试索引,索引为 index-demo,类型为 test。

[root@localhost elasticsearch-head-master]# curl -X PUT 'localhost:9200/index-demo/test/1?pretty&pretty' \

> -H 'content-Type: application/json' \

> -d '{"user":"zhangsan","mesg":"hello world"}' #输出结果如下所示:

{

"_index" : "index-demo",

"_type" : "test",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 2,

"failed" : 0

},

"_seq_no" : 0,

"_primary_term" : 1

}

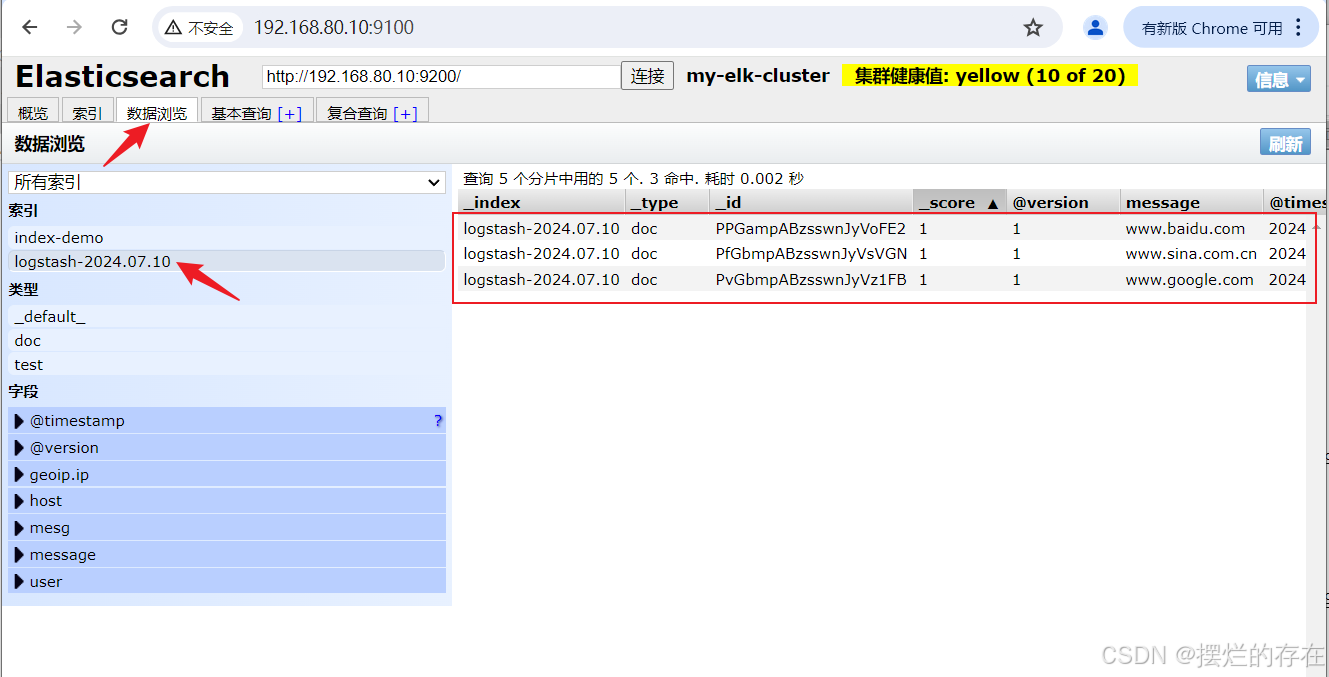

浏览器访问 http://192.168.80.10:9100/ 查看索引信息,可以看见索引默认被分片5个,并且有一个副本

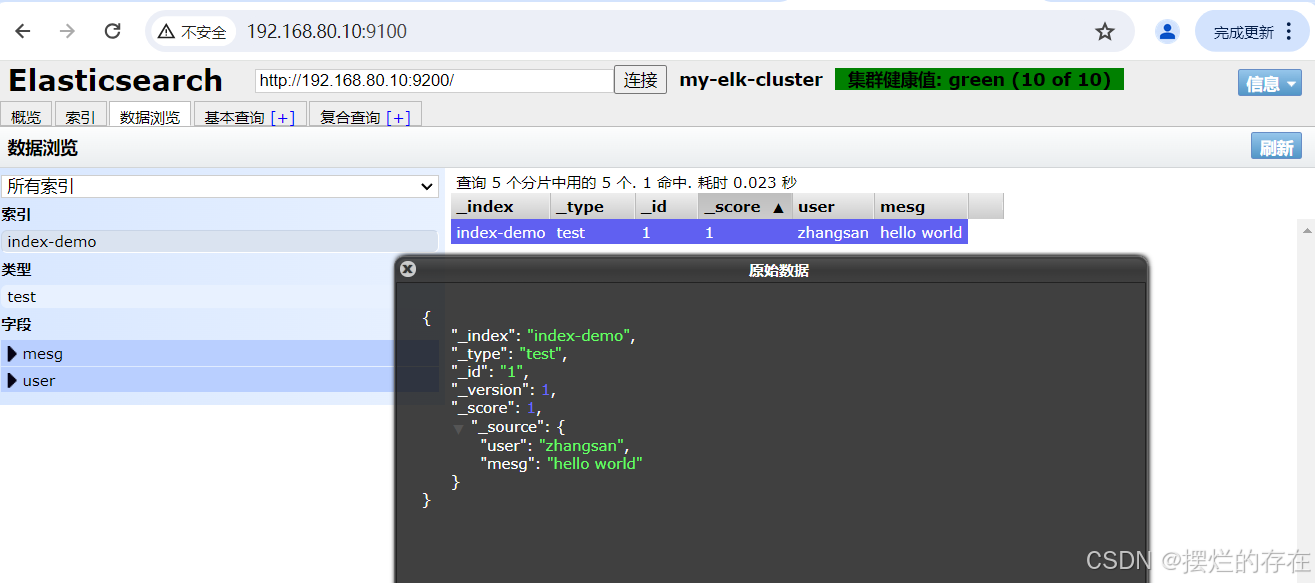

点击“数据浏览”,会发现在node1上创建的索引为 index-demo,类型为 test 的相关信息

Elasticsearch索引管理

(1)命令行管理方式

①创建索引

curl -X PUT 'http://ES-IP:9200/<索引名>/<类型>/<ID>?pretty&pretty' \

-H 'content-Type: application/json' -d '{"键1":"值1","键2":"值2"}'②删除索引

curl -X DELETE 'http://ES-IP:9200/<索引名>'③查看索引配置

curl -X GET 'http://ES-IP:9200/<索引名>/_settings'

④修改索引配置

curl -X PUT 'http://ES-IP:9200/<索引名>/_settings' \

-H 'content-Type: application/json' -d '{"键":"值"}'⑤创建索引别名

curl -X POST 'http://ES-IP:9200/_aliases' \

-H 'Content-Type: application/json' -d '{"actions":[{"add":{"index":"索引名","alias":"索引别名"}}]}'

⑥删除索引别名

curl -X POST 'http://ES-IP:9200/_aliases' \

-H 'Content-Type: application/json' -d '{"actions":[{"remove":{"index":"索引名","alias":"索引别名"}}]}'

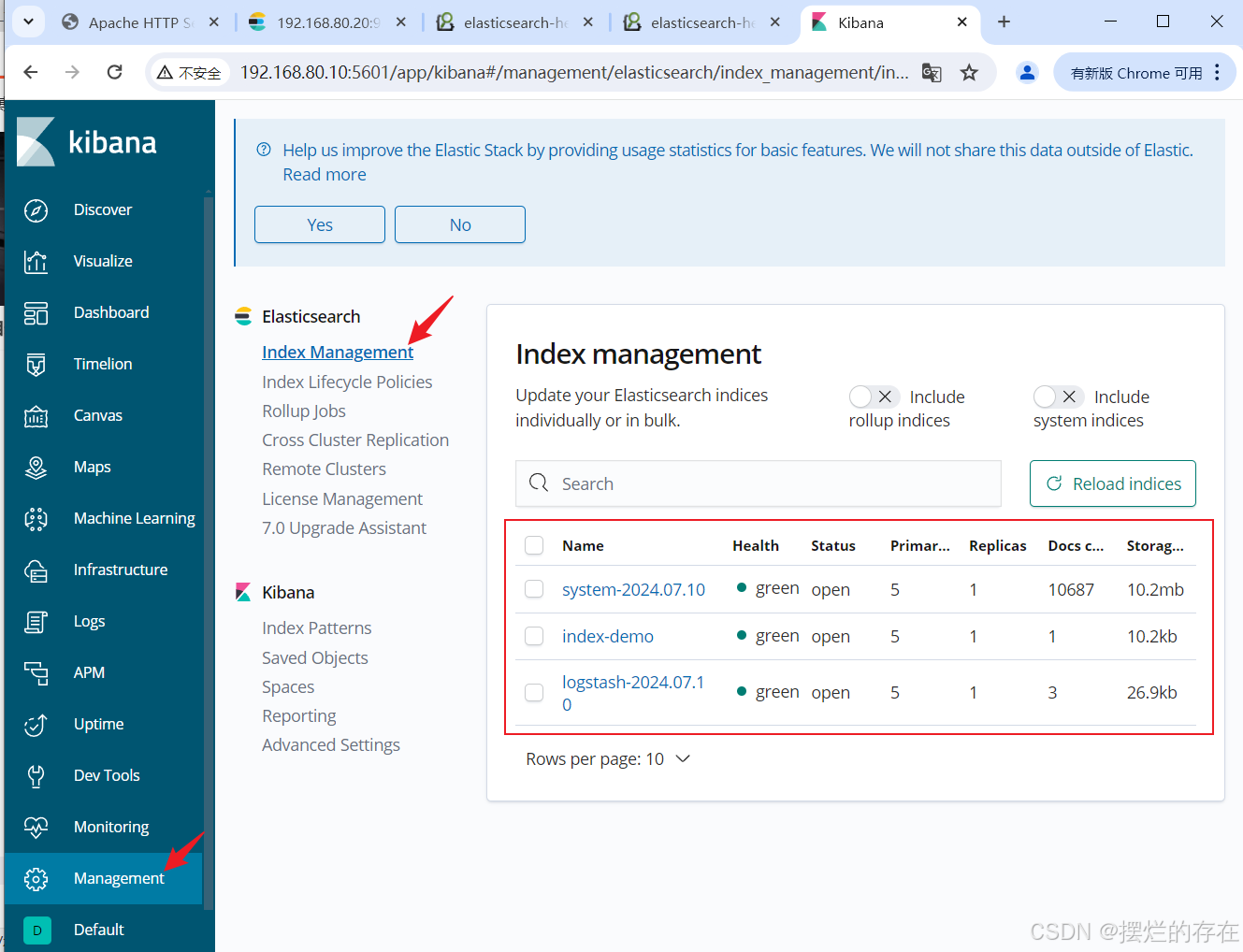

(2)图形化管理方式

使用 Kibana 接入 Elasticsearch ,可在 Kibana 的 Web 页面【管理】-【索引管理】中图形化管理索引

ELK Logstash 部署(在 Apache 节点上操作)

1.更改主机名

[root@localhost ~]# hostnamectl set-hostname apache

[root@localhost ~]# bash

[root@apache ~]#

2.安装Apahce服务(httpd)

[root@apache ~]# yum -y install httpd

已加载插件:fastestmirror, langpacks

Loading mirror speeds from cached hostfile

软件包 httpd-2.4.6-97.el7.centos.5.x86_64 已安装并且是最新版本

无须任何处理

[root@apache ~]# systemctl start httpd

3.安装Java环境

[root@apache ~]# yum -y install java-1.8.0-openjdk*

[root@apache ~]# java -version

openjdk version "1.8.0_332"

OpenJDK Runtime Environment (build 1.8.0_332-b09)

OpenJDK 64-Bit Server VM (build 25.332-b09, mixed mode)

4.安装logstash

上传软件包 logstash-6.7.2.rpm 到/opt目录下

[root@apache ~]# cd /opt/

[root@apache opt]# rpm -ivh logstash-6.7.2.rpm

警告:logstash-6.7.2.rpm: 头V4 RSA/SHA512 Signature, 密钥 ID d88e42b4: NOKEY

准备中... ################################# [100%]

正在升级/安装...

1:logstash-1:6.7.2-1 ################################# [100%]

Using provided startup.options file: /etc/logstash/startup.options

/usr/share/logstash/vendor/bundle/jruby/2.5.0/gems/pleaserun-0.0.30/lib/pleaserun/platform/base.rb:112: warning: constant ::Fixnum is deprecated

Successfully created system startup script for Logstash

[root@apache opt]# systemctl start logstash.service

[root@apache opt]# systemctl enable logstash.service

Created symlink from /etc/systemd/system/multi-user.target.wants/logstash.service to /etc/systemd/system/logstash.service.

[root@apache opt]# ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

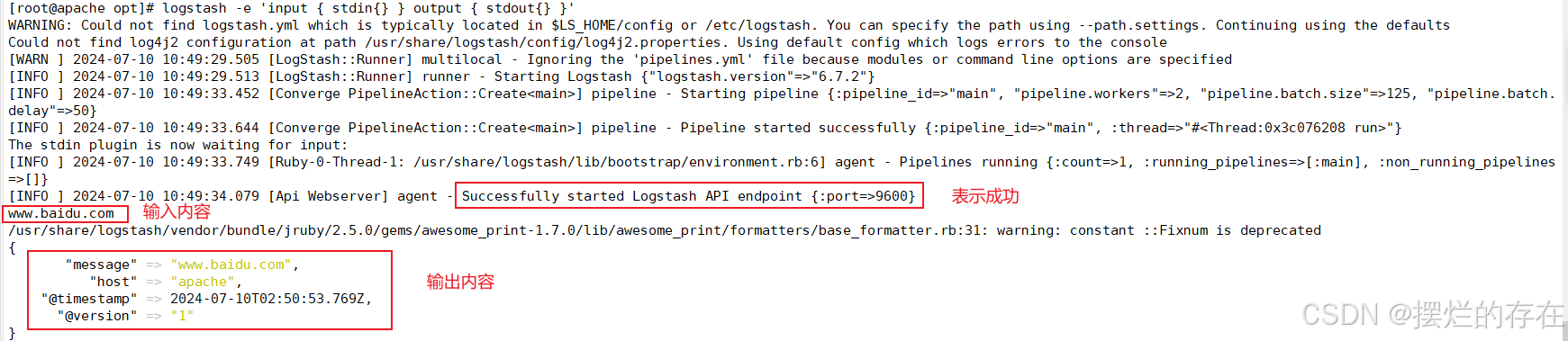

5.测试 Logstash

使用 rubydebug 输出详细格式显示,codec 为一种编解码器

logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }'

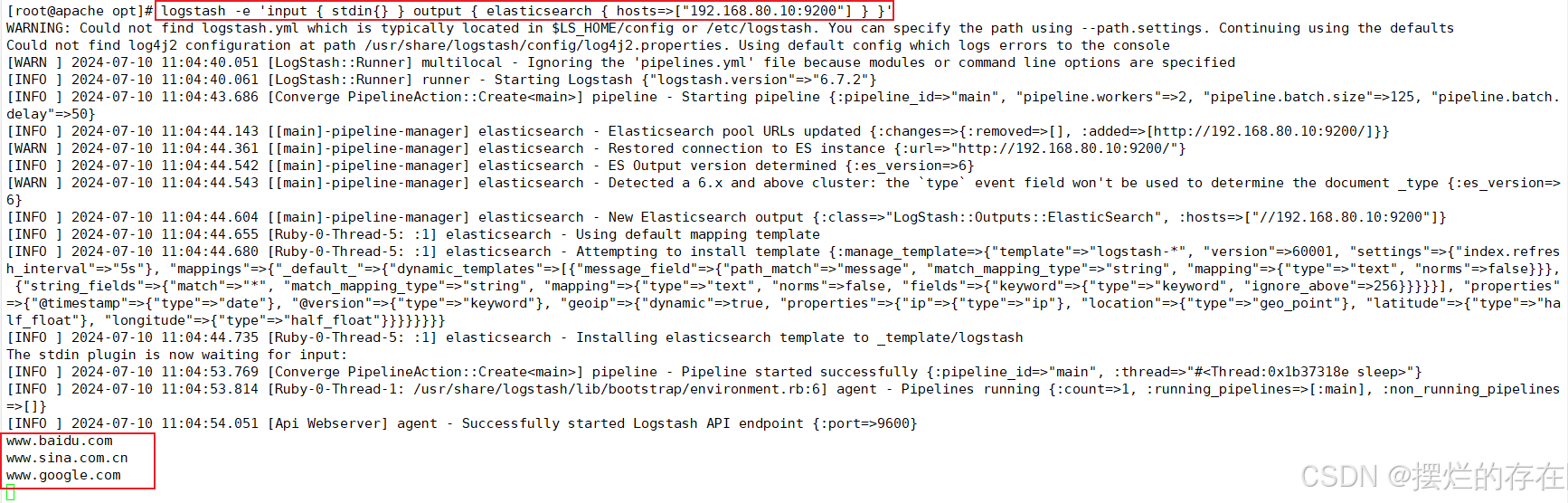

使用 Logstash 将信息写入 Elasticsearch 中

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.80.10:9200"] } }'

结果不在标准输出显示,而是发送至 Elasticsearch 中,可浏览器访问 http://192.168.80.10:9100/ 查看索引信息和数据浏览。

6.定义 logstash配置文件

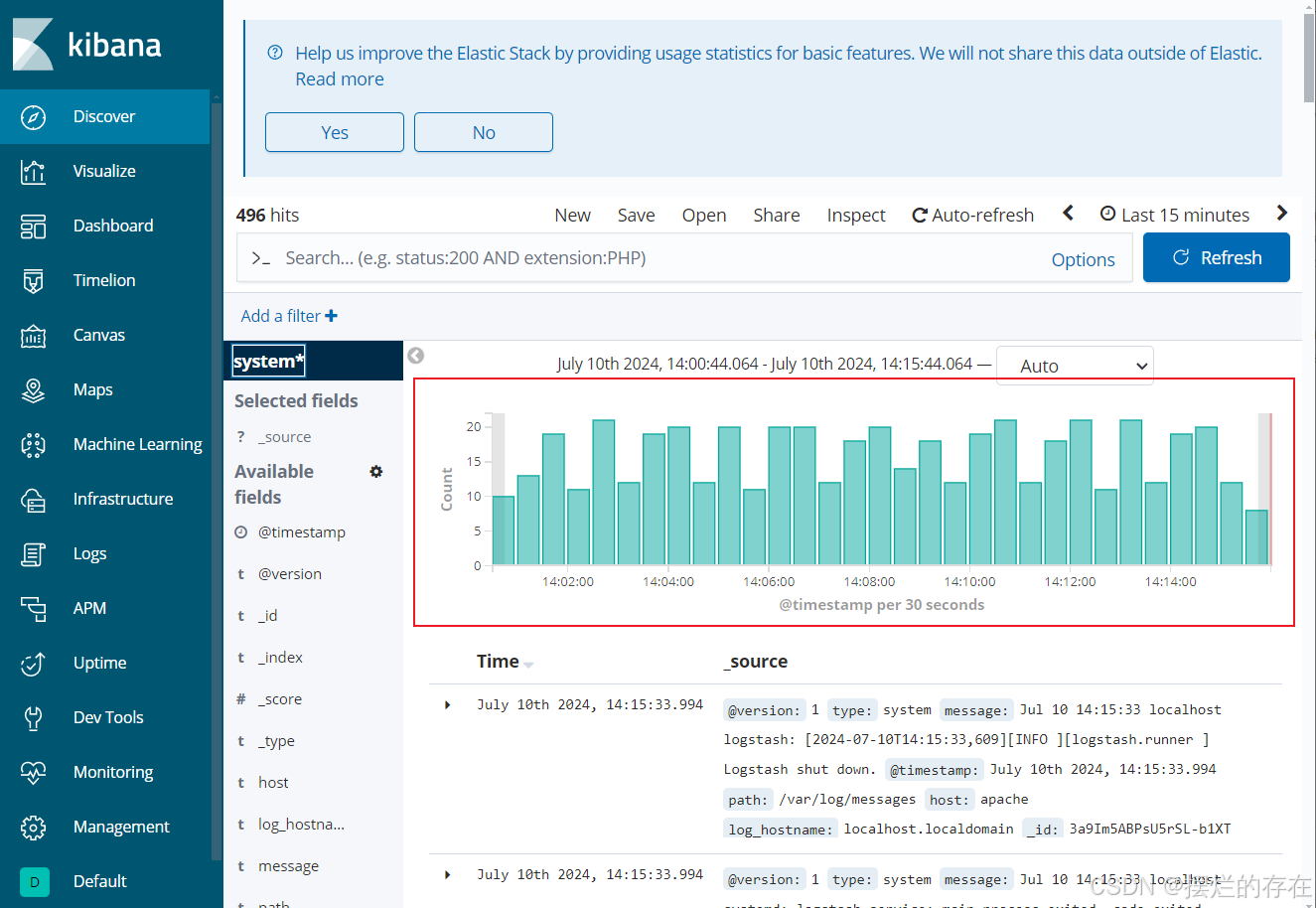

(1)修改 Logstash 配置文件,让其收集系统日志/var/log/messages,并将其输出到 elasticsearch 中

[root@apache opt]# chmod +r /var/log/messages #让 Logstash 可以读取日志

[root@apache opt]# cd /etc/logstash/conf.d/

[root@apache conf.d]# vim system.conf

添加内容如下:

input {

file{

path =>"/var/log/messages"

type =>"system"

start_position =>"beginning"

# ignore_older => 84600

sincedb_path => "/etc/logstash/sincedb_path/log_progress"

add_field => {"log_hostname"=>"${HOSTNAME}"}

}

}

output {

elasticsearch { #输出到 elasticsearch

hosts => ["192.168.80.10:9200","192.168.80.20:9200"] #指定 elasticsearch 服务器的地址和端口

index =>"system-%{+yyyy.MM.dd}" #指定输出到 elasticsearch 的索引格式

}

}(2)sincedb_path 必须指定一个文件而不是目录

[root@apache conf.d]# mkdir /etc/logstash/sincedb_path/

[root@apache conf.d]# touch /etc/logstash/sincedb_path/log_progress

[root@apache conf.d]# chown logstash:logstash /etc/logstash/sincedb_path/log_progress

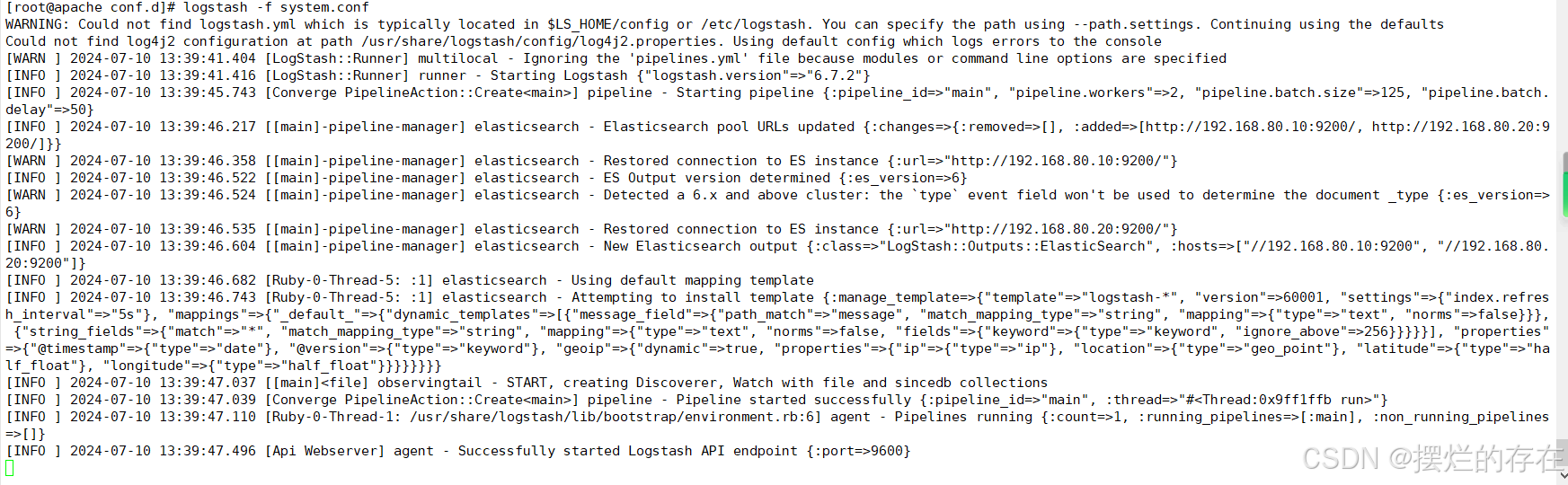

[root@apache conf.d]# logstash -f system.conf

浏览器访问 http://192.168.80.10:9100/ 查看索引信息

Logstash

Logstash 命令常用选项

-f:通过这个选项可以指定 Logstash 的配置文件,根据配置文件配置 Logstash 的输入和输出流。

-e:从命令行中获取,输入、输出后面跟着字符串,该字符串可以被当作 Logstash 的配置(如果是空,则默认使用 stdin 作为输入,stdout 作为输出)。

-t:测试配置文件是否正确。

-w:指定filter线程数量,默认线程数是 5

-l:指定日志文件名称定义输入和输出流

输入采用标准输入,输出采用标准输出(类似管道),新版本默认使用 rubydebug 格式输出

logstash -e 'input { stdin{} } output { stdout{} }'logstash配置文件

Logstash 配置文件基本由三部分组成:input、output 以及 filter(可选,根据需要选择使用)

- input:表示从数据源采集数据,常见的数据源如Kafka、日志文件等

file beats kafka redis stdin- filter:表示数据处理层,包括对数据进行格式化处理、数据类型转换、数据过滤等,支持正则表达式

grok 对若干个大文本字段进行再分割成一些小字段 (?<字段名>正则表达式) 字段名: 正则表达式匹配到的内容

date 对数据中的时间格式进行统一和格式化

mutate 可以重命名,删除,替换和修改事件中的字段。比如对一些无用的字段进行剔除,或增加自定义的字段

multiline 对多行数据进行统一编排,将多行数据汇总为一个单一的行- output:表示将Logstash收集的数据经由过滤器处理之后输出到Elasticsearch。

elasticsearch stdout格式如下:

input {...}

filter {...}

output {...}在每个部分中,也可以指定多个访问方式。例如,若要指定两个日志来源文件,则格式如下:

input {

file { path =>"/var/log/messages" type =>"syslog"}

file { path =>"/var/log/httpd/access.log" type =>"apache"}

}ELK Kiabana 部署(在 Node1 节点上操作)

1.安装 Kiabana

上传软件包 kibana-6.7.2-x86_64.rpm 到/opt目录

[root@localhost elasticsearch-head-master]# cd /opt

[root@localhost opt]# rpm -ivh kibana-6.7.2-x86_64.rpm

警告:kibana-6.7.2-x86_64.rpm: 头V4 RSA/SHA512 Signature, 密钥 ID d88e42b4: NOKEY

准备中... ################################# [100%]

正在升级/安装...

1:kibana-6.7.2-1 ################################# [100%]

2.设置 Kibana 的主配置文件

[root@localhost opt]# vim /etc/kibana/kibana.yml

修改内容如下:

--2--取消注释,Kiabana 服务的默认监听端口为5601

server.port: 5601

--7--取消注释,设置 Kiabana 的监听地址,0.0.0.0代表所有地址

server.host: "0.0.0.0"

--28--取消注释,配置es服务器的ip,如果是集群则配置该集群中master节点的ip

elasticsearch.hosts: ["http://192.168.80.10:9200","http://192.168.80.11:9200"]

--96--取消注释,配置kibana的日志文件路径(需手动创建),不然默认是messages里记录日志

logging.dest: /var/log/kibana.log

--113--取消注释,指定页面字符格式为中文

i18n.locale: "zh-CN"3.创建日志文件,启动 Kibana 服务

[root@localhost opt]# touch /var/log/kibana.log

[root@localhost opt]# chown kibana:kibana /var/log/kibana.log

[root@localhost opt]#

[root@localhost opt]# systemctl start kibana.service

[root@localhost opt]# systemctl enable kibana.service

Created symlink from /etc/systemd/system/multi-user.target.wants/kibana.service to /etc/systemd/system/kibana.service.

[root@localhost opt]#

[root@localhost opt]# netstat -natp | grep 5601

tcp 0 0 0.0.0.0:5601 0.0.0.0:* LISTEN 5066/node

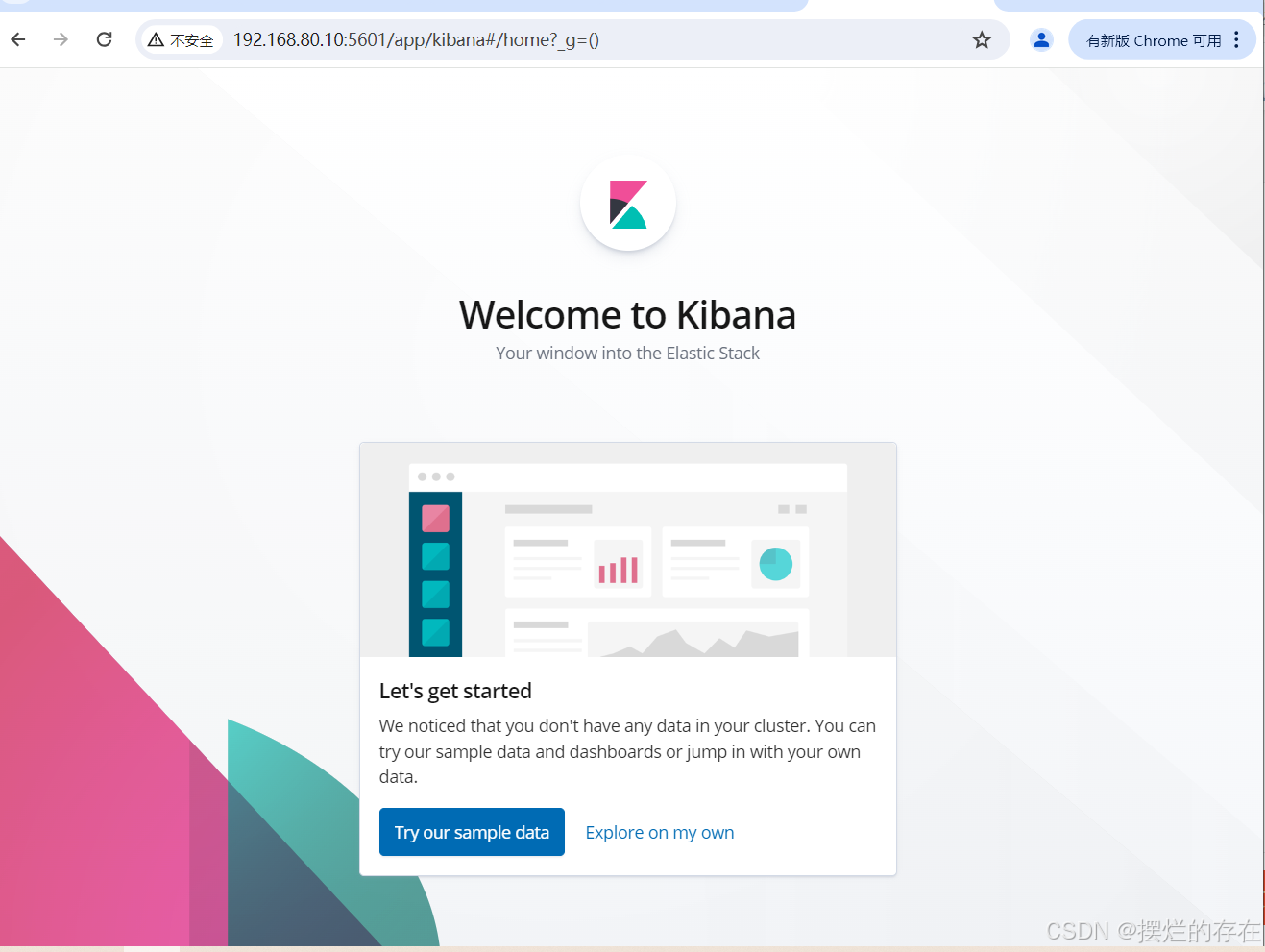

4.验证 Kibana

浏览器访问 http://192.168.80.10:5601

左侧[管理],点击【管理菜单】,点击【索引管理】即可在其中进行索引管理

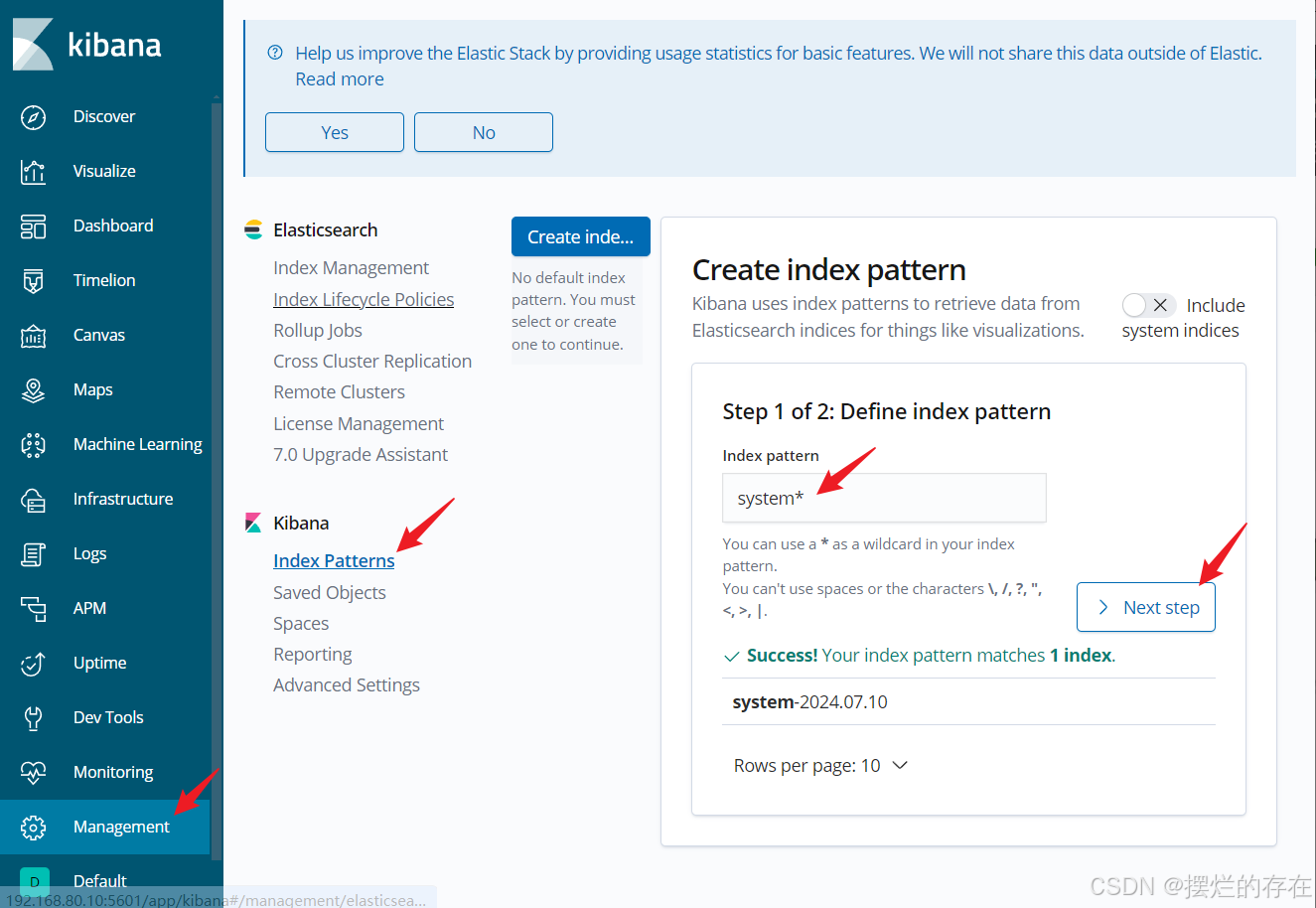

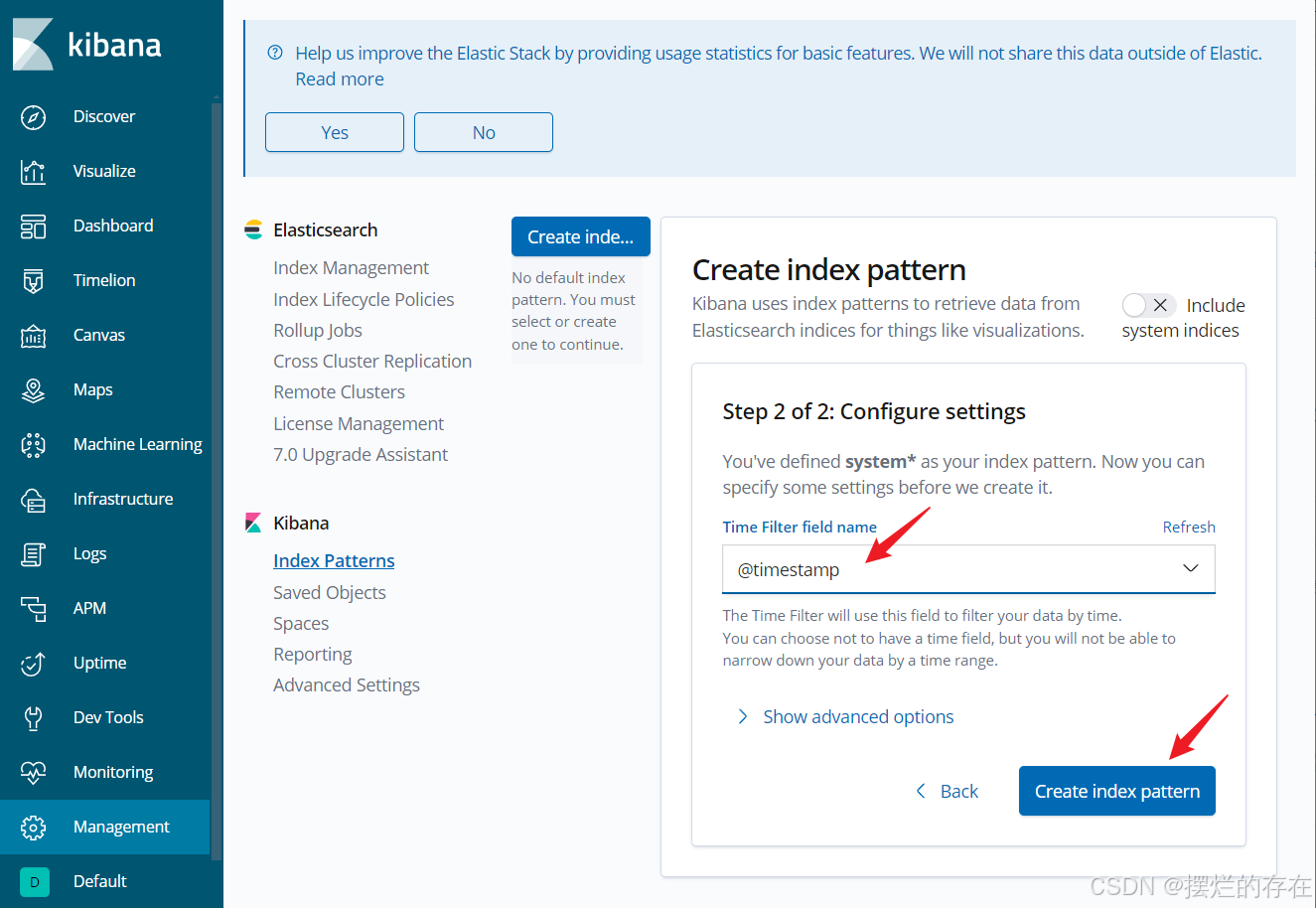

创建索引模式:左侧[管理],点击【管理菜单】,点击【索引模式】,索引模式下对索引进行搜索

ELK优化

logstash优化

①加大服务器内存和JVM堆内存

②用多实例做负载均衡

③使用filebeat替代logstash采集日志数据

elasticsearch优化

①对索引进行优化:优化fsync,适当加大刷盘间隔时间

②优化write线程池配置,减少拒绝任务的情况:修改ES配置文件elasticsearch.yml,设置write线程为 CPU核数+1

③锁定内存,不让ES使用swap:swapoff -a ,关闭swap

④适当的减少索引的分片数、副本数

![[<span style='color:red;'>ELK</span>] <span style='color:red;'>ELK</span><span style='color:red;'>企业</span><span style='color:red;'>级</span><span style='color:red;'>日志</span><span style='color:red;'>分析</span><span style='color:red;'>系统</span>](https://img-blog.csdnimg.cn/direct/60736bbe35b746dc9fb04629ec01b9b3.png)

![[Python学习篇] Python模块和包](https://i-blog.csdnimg.cn/direct/5d2220e96d09450b981b6ac6780087b1.png)