Attention

理解注意力机制与多头注意力:深度学习中的“聚焦术”

在人类处理信息的过程中,注意力允许我们聚焦于环境中的某些关键部分,而忽略其他不重要的信息。这种机制在深度学习领域被模拟并应用,以提高模型对数据的处理效率和效果。本文将详细解释什么是注意力机制,以及它的一种扩展——多头注意力机制,这些技术如何帮助深度学习模型更加精准地“聚焦”并处理大量数据。

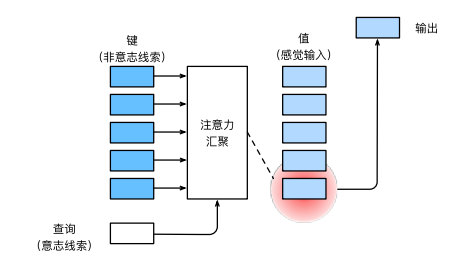

什么是注意力机制?

注意力机制最初是受人类视觉注意力启发的一种技术,用于增强神经网络对输入数据中重要部分的敏感性。简单来说,注意力机制允许模型动态地调整内部资源的分配,对重要的输入信息给予更多的关注,而忽略不相关的信息。

核心思想

在深度学习中,注意力机制通常通过为不同的输入部分分配不同的“权重”实现,这些权重决定了各部分在模型学习过程中的重要性。例如,在处理一个句子时,模型可能会更加关注对当前任务更重要的词语,如关键动词或名词,而非填充词。

什么是多头注意力机制?

多头注意力机制是注意力机制的一个扩展,它在2017年由Google的研究人员在论文《Attention is All You Need》中提出。这种机制通过“分头”处理信息,可以让模型在多个子空间并行地学习不同方面的信息,从而增强模型的学习能力和性能。

工作原理

多头注意力机制将输入数据分割成多个较小的部分,每个部分由一个独立的注意力“头”处理。这些头并行工作,每个头都会输出自己的注意力分数和处理结果。最后,这些结果被合并起来,形成一个统一的输出。这种结构允许模型在多个表示子空间中捕捉到丰富的信息。

多头注意力的优势

- 增强的表征能力:通过并行处理多个注意力头,模型能够从不同的角度理解数据,这比单一的注意力视角能更全面地捕捉数据的特性。

- 灵活的信息融合:不同头学习到的信息在合并时可以相互补充,增强了模型对复杂数据的处理能力。

- 提高并行处理能力:多头结构天然适合并行计算,可以有效利用现代硬件平台的计算资源,提高训练和推理的效率。

应用领域

多头注意力机制已经成为许多现代NLP(自然语言处理)模型的核心组件,例如BERT、Transformer等。它也被广泛应用于图像处理、语音识别和其他需要模型理解复杂数据关系的领域。

结论

注意力机制和多头注意力机制是当今深度学习领域的重要工具,它们通过模拟人类的注意力聚焦机制,极大地提高了神经网络处理信息的能力。随着技术的发展,这些机制正变得越来越复杂和强大,开启了深度学习新的可能性。