在当前人工智能高速发展的时代,我们对于上层的应用层开发都比较熟悉,对于一些主流的深度学习框架也有了非常多的经验,能快速上手。但是,对于深度学习的底层源码实现,最关键的必然是卷子算子部分了,本篇内容中,我们将学习卷积算子的原理,以及当前主流深度学习框架的加速原理。

卷积算子的原理

卷积算子是深度学习中提取局部特征的核心工具,广泛应用于图像、文本和语音处理。

卷积算子的基本操作可以通过以下几个方面来理解:

卷积操作:

输入张量(Input Tensor):

通常是一个多维数组,例如在图像处理中,输入张量的维度为(batch size, channels, height, width)。

卷积核(Kernel or Filter):

也是一个多维数组,其维度为(out_channels, in_channels, kernel_height, kernel_width)。卷积核在输入张量上进行滑动窗口操作。

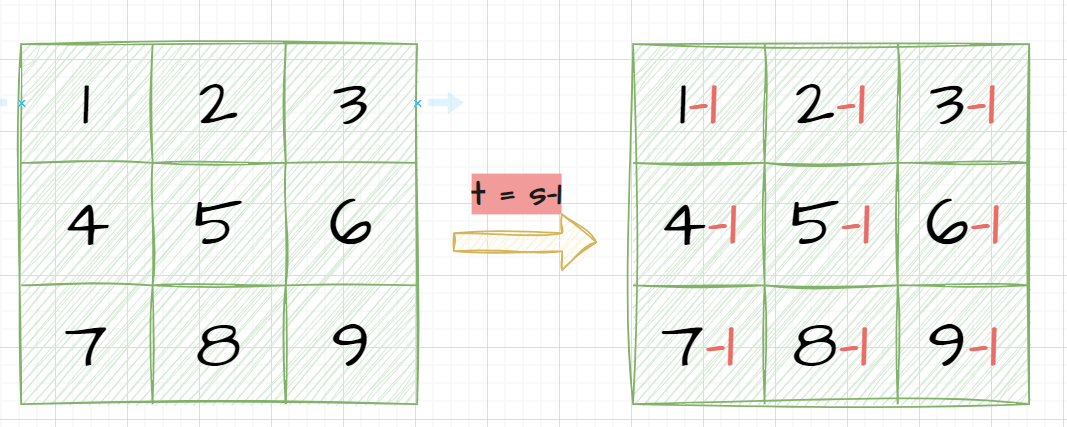

滑动窗口(Sliding Window):

卷积核在输入张量上按照一定的步幅(stride)移动,每次移动时计算卷积核与输入张量当前位置局部区域的点积。

每次点积结果生成一个输出元素,形成输出特征图。

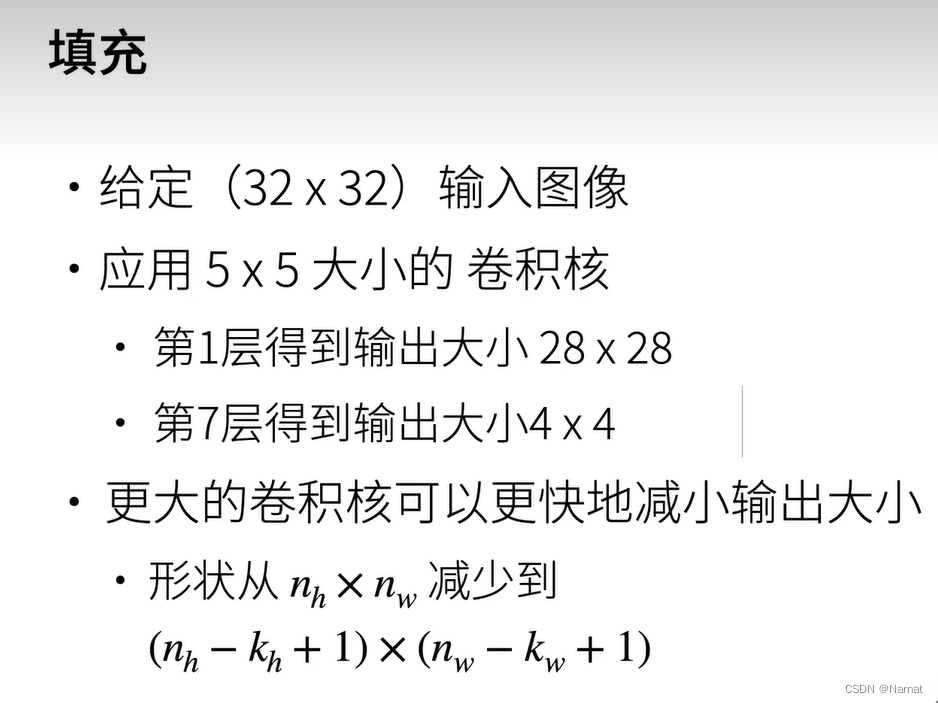

填充(Padding):

为了控制输出特征图的尺寸,可以在输入张量的边缘添加额外的零值填充(zero padding)。

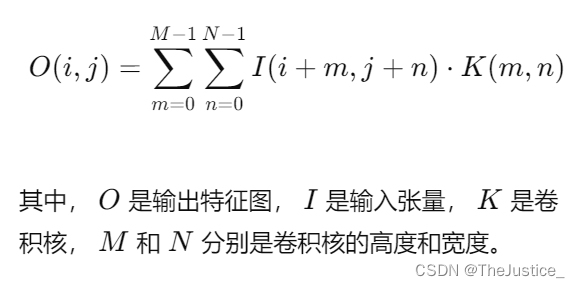

数学表达:

二维卷积的数学表达式为:

一些基础的代码实现如下:

import numpy as np

# 示例输入张量 (4D: batch_size, channels, height, width)

input_tensor = np.random.rand(10, 3, 32, 32)

# 示例卷积核张量 (4D: num_filters, channels, kernel_height, kernel_width)

conv_kernel = np.random.rand(16, 3, 3, 3)

该代码为数据准备部分

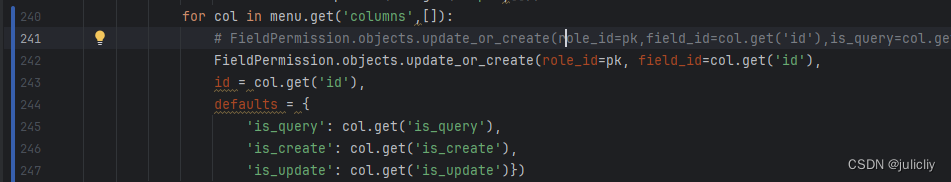

def conv2d(input_tensor, conv_kernel):

batch_size, in_channels, in_height, in_width = input_tensor.shape

out_channels, _, kernel_height, kernel_width = conv_kernel.shape

out_height = in_height - kernel_height + 1

out_width = in_width - kernel_width + 1

output_tensor = np.zeros((batch_size, out_channels, out_height, out_width))

for b in range(batch_size):

for c in range(out_channels):

for i in range(out_height):

for j in range(out_width):

output_tensor[b, c, i, j] = np.sum(

input_tensor[b, :, i:i+kernel_height, j:j+kernel_width] * conv_kernel[c, :, :, :]

)

return output_tensor

该代码为基本卷积运算实现

GPU加速的原理

GPU(图形处理单元)是专为并行计算设计的硬件,加速深度学习任务的原理包括以下几个方面:

并行计算架构:

多核心架构:GPU拥有成千上万个小型处理核心,能够同时执行大量并行计算任务。

SIMD(Single Instruction, Multiple Data)架构:单条指令可以并行作用于多个数据单元,特别适合矩阵和向量运算。

高吞吐量内存访问:

GPU具有高速显存(VRAM),支持大规模数据并行访问。

每个计算核心组(称为“线程块”)可以共享内存,用于高效的数据交换和缓存。

CUDA和cuDNN:

CUDA:NVIDIA开发的并行计算平台和编程模型,使开发者能够使用C/C++在GPU上编写并行程序。

cuDNN:NVIDIA的深度神经网络库,提供高度优化的深度学习算子,如卷积、池化和归一化等。

优化算法和技术:

操作融合:将多个简单操作组合成一个复杂操作,减少内存访问次数,提高计算效率。

算法优化:使用Strassen算法、Winograd算法等优化矩阵乘法和卷积运算。

混合精度训练:使用FP16和FP32浮点数进行计算,提升计算速度并减少显存占用。

以下是一个使用CUDA编写的卷积运算示例,展示了如何在GPU上进行高效的卷积计算:

__global__ void conv2d_kernel(float *input, float *kernel, float *output, int in_channels, int out_channels, int in_height, int in_width, int kernel_height, int kernel_width, int out_height, int out_width) {

int b = blockIdx.x; // Batch index

int c = blockIdx.y; // Output channel index

int h = threadIdx.x; // Output height index

int w = threadIdx.y; // Output width index

float value = 0.0;

for (int i = 0; i < in_channels; ++i) { // Loop over input channels

for (int kh = 0; kh < kernel_height; ++kh) {

for (int kw = 0; kw < kernel_width; ++kw) {

int h_offset = h + kh;

int w_offset = w + kw;

if (h_offset < in_height && w_offset < in_width) {

value += input[b * in_channels * in_height * in_width + i * in_height * in_width + h_offset * in_width + w_offset] *

kernel[c * in_channels * kernel_height * kernel_width + i * kernel_height * kernel_width + kh * kernel_width + kw];

}

}

}

}

output[b * out_channels * out_height * out_width + c * out_height * out_width + h * out_width + w] = value;

}

void conv2d(float *input, float *kernel, float *output, int batch_size, int in_channels, int out_channels, int in_height, int in_width, int kernel_height, int kernel_width) {

int out_height = in_height - kernel_height + 1;

int out_width = in_width - kernel_width + 1;

float *d_input, *d_kernel, *d_output;

cudaMalloc(&d_input, batch_size * in_channels * in_height * in_width * sizeof(float));

cudaMalloc(&d_kernel, out_channels * in_channels * kernel_height * kernel_width * sizeof(float));

cudaMalloc(&d_output, batch_size * out_channels * out_height * out_width * sizeof(float));

cudaMemcpy(d_input, input, batch_size * in_channels * in_height * in_width * sizeof(float), cudaMemcpyHostToDevice);

cudaMemcpy(d_kernel, kernel, out_channels * in_channels * kernel_height * kernel_width * sizeof(float), cudaMemcpyHostToDevice);

dim3 blocks(batch_size, out_channels);

dim3 threads(out_height, out_width);

conv2d_kernel<<<blocks, threads>>>(d_input, d_kernel, d_output, in_channels, out_channels, in_height, in_width, kernel_height, kernel_width, out_height, out_width);

cudaMemcpy(output, d_output, batch_size * out_channels * out_height * out_width * sizeof(float), cudaMemcpyDeviceToHost);

cudaFree(d_input);

cudaFree(d_kernel);

cudaFree(d_output);

}

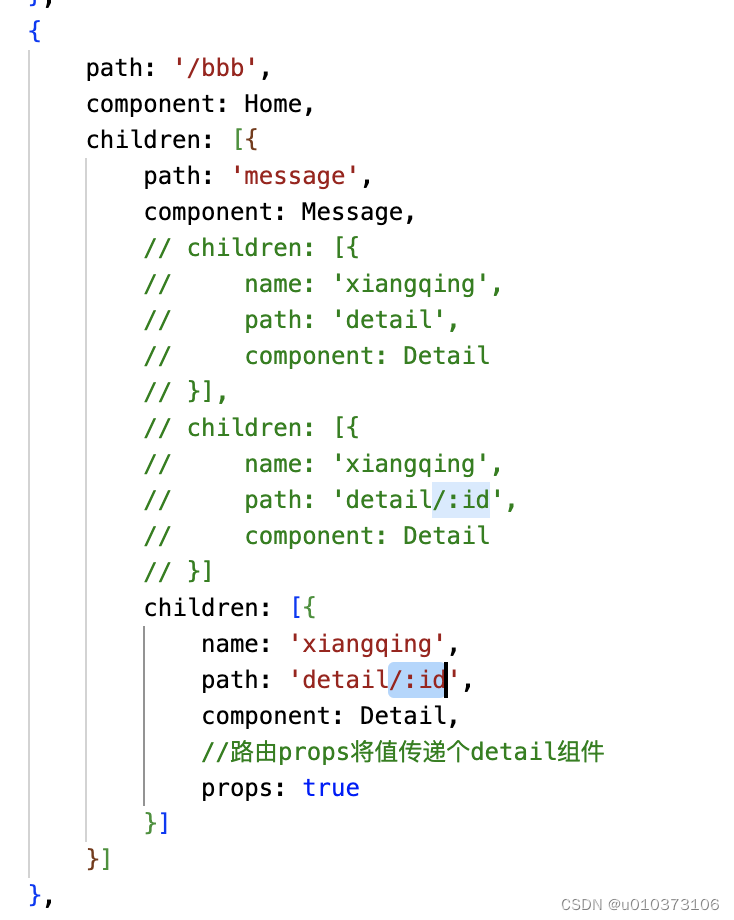

PyTorch和TensorFlow的GPU加速原理

PyTorch的GPU加速

自动微分:

- 使用autograd模块进行动态计算图构建和梯度计算。

CUDA集成:

- 使用CUDA库和cuDNN库实现高效的张量计算和卷积运算。

- PyTorch提供方便的接口,如

.cuda()方法,将张量和模型移动到GPU进行计算。

混合精度训练:

- 通过NVIDIA的Apex库或torch.cuda.amp模块支持混合精度训练,提高计算速度并减少显存占用。

自定义CUDA内核:

- 开发者可以编写自定义CUDA内核,以进一步优化特定计算任务。

TensorFlow的GPU加速

静态计算图:

- 使用静态计算图在编译时进行优化,如操作融合和内存复用。

XLA编译器:

- 对计算图进行进一步优化,生成高度优化的机器代码,特别是在使用TPU时提升性能。

自动微分:

- 自动微分功能在静态图构建阶段跟踪张量操作,高效计算梯度。

cuDNN集成:

- 利用cuDNN库的优化算法,实现高效的卷积和其他深度学习操作。

总结

卷积算子通过在输入数据上进行滑动窗口操作,提取局部特征;而GPU加速利用其强大的并行计算能力和高效内存架构,显著提升计算速度。PyTorch和TensorFlow分别通过动态计算图和静态计算图、自动微分、混合精度训练、操作融合等技术,实现深度学习任务的高效计算。这些优化技术在大规模深度学习任务中发挥着关键作用,确保模型训练和推理的高效性和准确性。

![[<span style='color:red;'>深度</span><span style='color:red;'>学习</span>]<span style='color:red;'>卷</span><span style='color:red;'>积</span>理解](https://i-blog.csdnimg.cn/direct/2a84ba8d5e204f48956b8f83e50b8b53.png)