AMB82 MINI Arduino的方法迭代更新十分及时,github维护也十分频繁。最新推出的4.0.7版本开始支持SD卡加载模型。有的网友装了4.0.6版本是看不到摄像头和模型加载选项的。

用这个实例来呈现RTSP视频流AI识别图像,同时展示对声音进行分类效果。

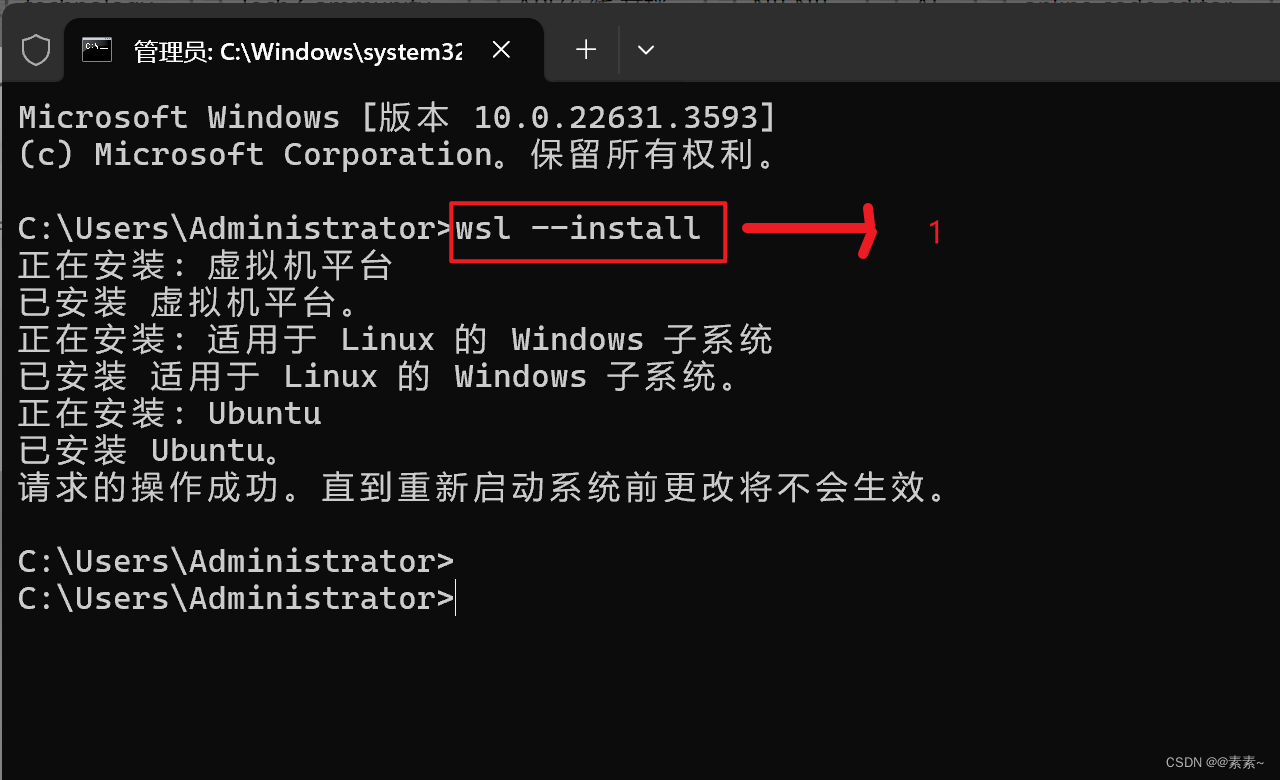

SDK升级到4.0.7b

怎么获得官方提供的各种训练好的模型

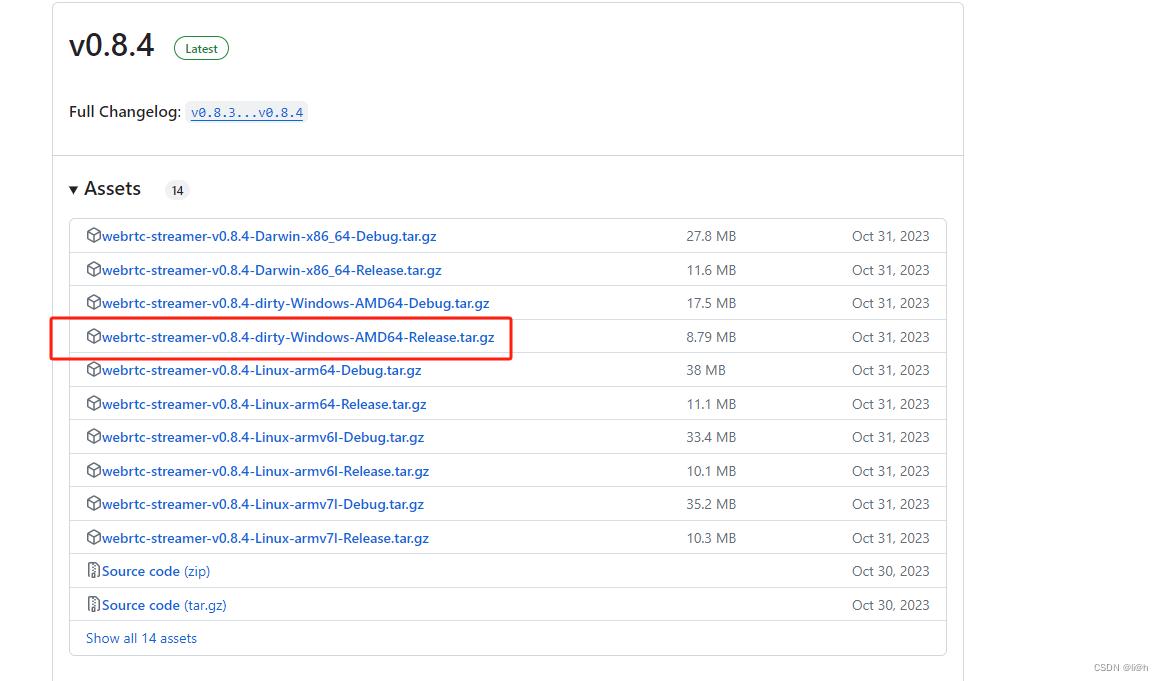

去github上下载Ambiot发布的最新版Arduino SDK ,解压以后训练好的模型文件在\Ameba_misc\All_NN_models里面。

SD卡加载模型文件

SD卡用sd-memory-card格式化一下,在根目录创建NN_MDL文件夹,然后将yamnet.nb和yolov7_tiny.nb两个模型文件复制进去。这两个模型的文件12.7M,可见瑞昱半导体增加sd卡加载模型是为了方便用户使用尺寸比较大的模型资料,功能也日臻完善。

介绍YAMNet和YOLOv7 Tiny

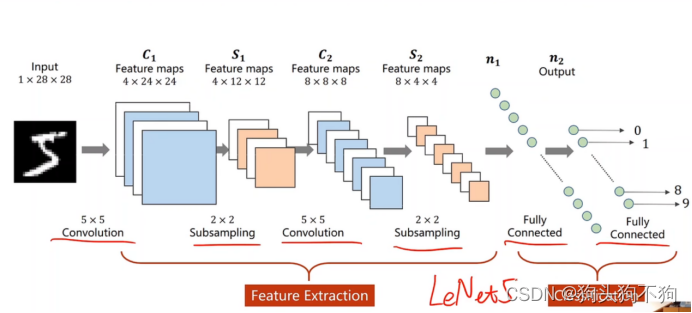

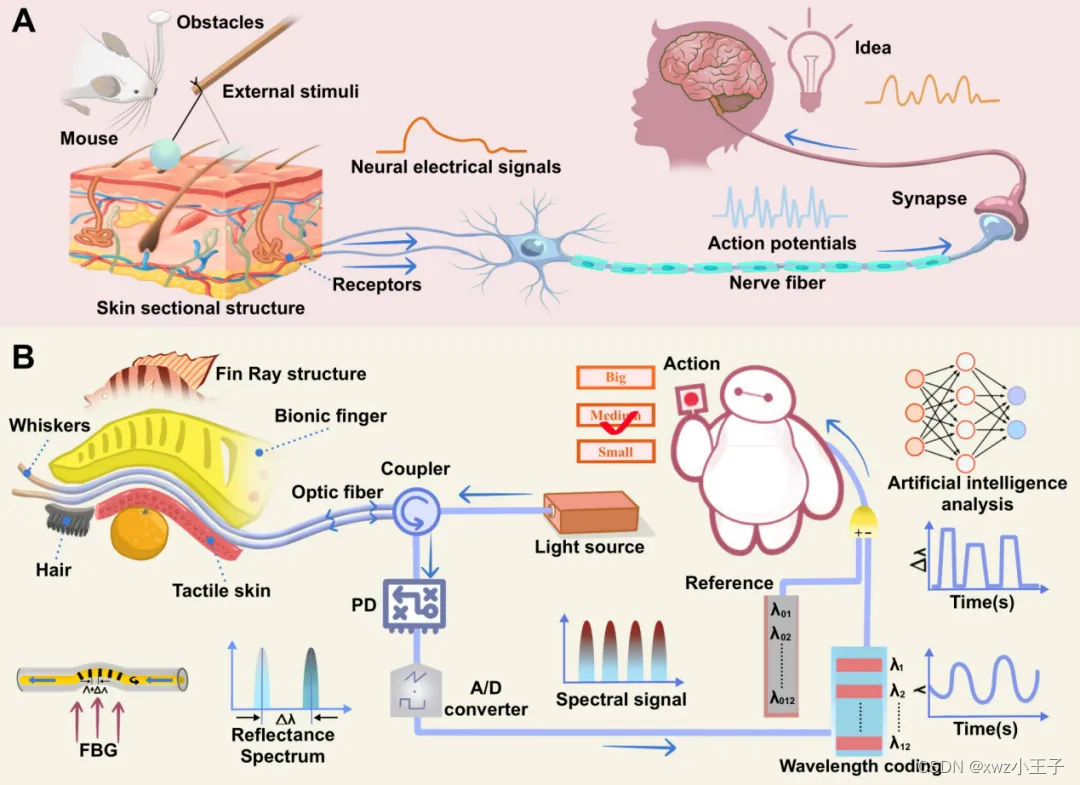

YAMNet(Yet Another Multi-Task Network)是一个用于音频事件检测的深度学习模型,由谷歌开发。它是基于卷积神经网络(CNN)的,能够识别音频中的多种声音事件,如狗吠、汽车喇叭声、电话铃声等。YAMNet 模型可以应用于各种音频分析任务,包括声音识别、环境声音分类和音频场景理解等。

YAMNet 模型的特点包括:

多任务学习:YAMNet 不仅能识别音频中的特定声音事件,还能同时进行音频特征提取等任务。

端到端模型:YAMNet 从原始音频波形直接学习到声音事件的识别,无需手动特征提取。

可扩展性:YAMNet 可以扩展到不同的音频数据集和任务,具有很好的泛化能力。

实时性能:YAMNet 模型设计时考虑了实时处理的需求,可以在实时或近实时环境中使用。

YOLOv7 Tiny 是 YOLO(You Only Look Once)系列目标检测算法的一个变体,专为需要在资源受限的环境中使用而设计。YOLOv7 是 YOLO 系列的第七代版本,它在速度和精度上都有所提升。“Tiny” 版本意味着它是一个轻量级的模型,适用于计算能力较低的设备,如移动设备或嵌入式系统。

YOLOv7 Tiny 保持了 YOLO 算法的核心特点,即快速和高效,同时在以下几个方面进行了改进:

网络结构优化:YOLOv7 Tiny 采用了更高效的网络结构,以减少计算量和模型大小。

性能提升:通过改进的网络结构和训练技术,YOLOv7 Tiny 在保持较小模型大小的同时,仍然能够提供较高的检测精度。

多尺度检测:YOLOv7 Tiny 支持多尺度输入,可以处理不同大小的图像,提高检测的灵活性。

实时性能:YOLOv7 Tiny 特别适合需要实时处理的应用场景,如视频监控、自动驾驶等。

YOLOv7 Tiny 通常使用较小的输入图像尺寸,并减少网络层的数量,以降低模型的复杂度。这样虽然可能会牺牲一些精度,但可以显著提高运行速度,使其更适合在资源受限的设备上运行。

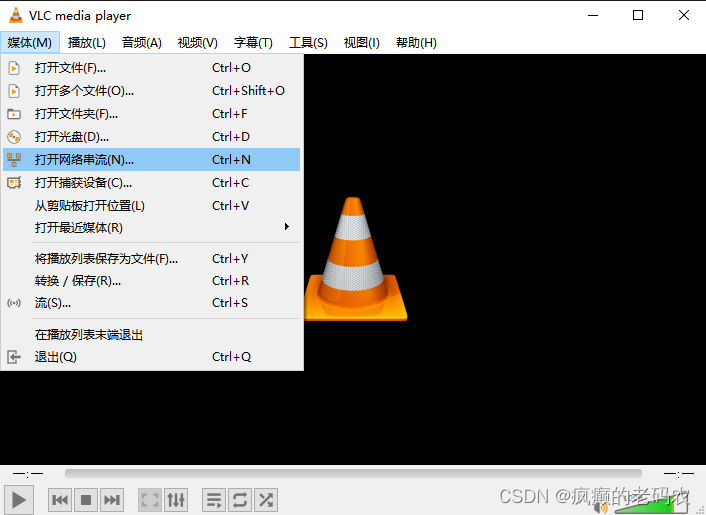

安装VLC播放器和SSCOM串口工具

因为AMB82 MINI采集使用的RTSP视频流通过无线网络传递,为了便于观察电脑或者手机上安装VLC播放器 ,并且为了观察串口输出要去Microsoft Store安装SSCOM串口工具。

程序如下:

#include "WiFi.h"

#include "StreamIO.h"

#include "VideoStream.h"

#include "RTSP.h"

#include "NNAudioClassification.h"

#include "AudioClassList.h"

#include "NNObjectDetection.h"

#include "VideoStreamOverlay.h"

#include "ObjectClassList.h"

#define CHANNEL 0

#define CHANNELNN 3

// 较低的分辨率用于神经网络处理

#define NNWIDTH 576

#define NNHEIGHT 320

//神经网络音频分类需要16KHz

VideoSetting config(VIDEO_FHD, 30, VIDEO_H264, 0);

VideoSetting configNN(NNWIDTH, NNHEIGHT, 10, VIDEO_RGB, 0);

AudioSetting configA(16000, 1, USE_AUDIO_AMIC); // 采样率,通道计数,麦克风类型

Audio audio;

NNAudioClassification audioNN;

NNObjectDetection ObjDet;

RTSP rtsp;

StreamIO videoStreamer(1, 1);

StreamIO audioStreamerNN(1, 1); // 1输入音频-> 1输出Audio Classification

StreamIO videoStreamerNN(1, 1);

char ssid[] = "您的WiFi名称";

char pass[] = "您的WiFi密码";

int status = WL_IDLE_STATUS;

IPAddress ip;

int rtsp_portnum;

void setup() {

//为音频数据格式配置音频外设

Serial.begin(115200);

// 尝试连接Wifi网络:

while (status != WL_CONNECTED) {

Serial.print("Attempting to connect to WPA SSID: ");

Serial.println(ssid);

status = WiFi.begin(ssid, pass);

// 休息呀2秒

delay(2000);

}

ip = WiFi.localIP();

//配置摄像机视频通道和视频格式信息

//根据你的WiFi网络质量调整比特率

config.setBitrate(2 * 1024 * 1024); // 建议使用2Mbps的RTSP流,避免网络拥塞

Camera.configVideoChannel(CHANNEL, config);

Camera.configVideoChannel(CHANNELNN, configNN);

Camera.videoInit();

// 配置RTSP,配置相应的视频格式信息

rtsp.configVideo(config);

rtsp.begin();

rtsp_portnum = rtsp.getPort();

audio.configAudio(configA);

audio.begin();

audioNN.configAudio(configA);

audioNN.setResultCallback(ACPostProcess);

audioNN.modelSelect(AUDIO_CLASSIFICATION, NA_MODEL, NA_MODEL, NA_MODEL, CUSTOMIZED_YAMNET);

audioNN.begin();

//使用相应的视频格式信息配置对象检测

//选择神经网络(NN)任务和模型

ObjDet.configVideo(configNN);

ObjDet.setResultCallback(ODPostProcess);

ObjDet.modelSelect(OBJECT_DETECTION, CUSTOMIZED_YOLOV7TINY, NA_MODEL, NA_MODEL);

ObjDet.begin();

//配置StreamIO对象将数据从视频通道流到RTSP

videoStreamer.registerInput(Camera.getStream(CHANNEL));

videoStreamer.registerOutput(rtsp);

if (videoStreamer.begin() != 0) {

Serial.println("StreamIO link start failed");

}

Camera.channelBegin(CHANNEL);

// 配置StreamIO对象以将数据从音频流到音频分类

audioStreamerNN.registerInput(audio);

audioStreamerNN.registerOutput(audioNN);

if (audioStreamerNN.begin() != 0) {

Serial.println("StreamIO link start failed");

}

// 配置StreamIO对象将数据从RGB视频通道流到对象检测

videoStreamerNN.registerInput(Camera.getStream(CHANNELNN));

videoStreamerNN.setStackSize();

videoStreamerNN.setTaskPriority();

videoStreamerNN.registerOutput(ObjDet);

if (videoStreamerNN.begin() != 0) {

Serial.println("StreamIO link start failed");

}

// 为NN启动视频频道

Camera.channelBegin(CHANNELNN);

// 在RTSP视频通道上启动OSD绘图

OSD.configVideo(CHANNEL, config);

OSD.begin();

}

void loop() {

}

// 用户回调函数

void ACPostProcess(std::vector<AudioClassificationResult> results) {

printf("No of Audio Detected = %d\r\n", audioNN.getResultCount());

if (audioNN.getResultCount() > 0) {

for (int i = 0; i < audioNN.getResultCount(); i++) {

AudioClassificationResult audio_item = results[i];

int class_id = (int)audio_item.classID();

if (audioNames[class_id].filter) {

int prob = audio_item.score();

printf("%d class %d, score: %d, audio name: %s\r\n", i, class_id, prob, audioNames[class_id].audioName);

}

}

}

}

//用户回调函数对目标检测结果进行后处理

void ODPostProcess(std::vector<ObjectDetectionResult> results) {

uint16_t im_h = config.height();

uint16_t im_w = config.width();

Serial.print("Network URL for RTSP Streaming: ");

Serial.print("rtsp://");

Serial.print(ip);

Serial.print(":");

Serial.println(rtsp_portnum);

Serial.println(" ");

printf("Total number of objects detected = %d\r\n", ObjDet.getResultCount());

OSD.createBitmap(CHANNEL);

if (ObjDet.getResultCount() > 0) {

for (uint32_t i = 0; i < ObjDet.getResultCount(); i++) {

int obj_type = results[i].type();

if (itemList[obj_type].filter) { // check if item should be ignored

ObjectDetectionResult item = results[i];

//结果坐标为0.00到1.00之间的浮点数

//与RTSP分辨率相乘得到坐标像素

int xmin = (int)(item.xMin() * im_w);

int xmax = (int)(item.xMax() * im_w);

int ymin = (int)(item.yMin() * im_h);

int ymax = (int)(item.yMax() * im_h);

// 绘制边界框

printf("Item %d %s:\t%d %d %d %d\n\r", i, itemList[obj_type].objectName, xmin, xmax, ymin, ymax);

OSD.drawRect(CHANNEL, xmin, ymin, xmax, ymax, 3, OSD_COLOR_WHITE);

// 打印识别文本

char text_str[20];

snprintf(text_str, sizeof(text_str), "%s %d", itemList[obj_type].objectName, item.score());

OSD.drawText(CHANNEL, xmin, ymin - OSD.getTextHeight(CHANNEL), text_str, OSD_COLOR_CYAN);

}

}

}

OSD.update(CHANNEL);

}

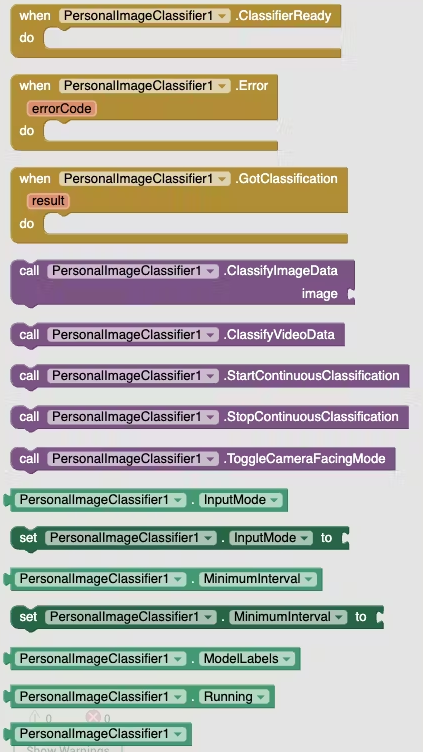

如何修改模型文件名称

如果需要修改模型名称请移步到C:\Users\用户名\AppData\Local\Arduino15\packages\realtek\hardware\AmebaPro2\4.0.7-build20240610\libraries\NeuralNetwork\src\SD_Model.CPP 里面做修改。

烧录和观察实验效果

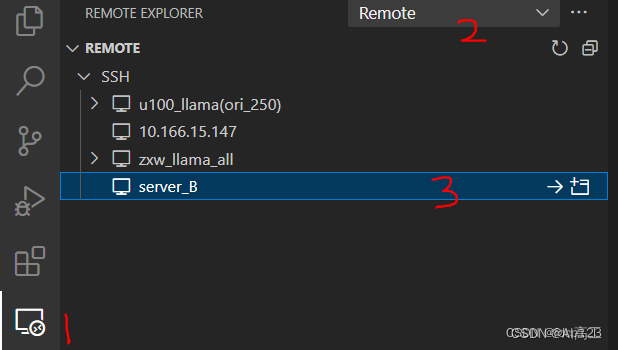

烧录程式到AMB82 MINI 的Arduino IDE设置见下图:

程序烧录好以后,按一下rest键重启一下AMB82 MINI 开发板,打开SSCOM串口工具可以可能到RTSP视频流的地址,譬如 rtsp://192.168.3.18:554 ,然后在VLC media player输入该地址就可以看到AMB82 MINI 开发板拍摄到的视频了。

如果您对着水杯,在视频流中就会用方框框住并标注。同时SSCOM串口工具也会输出图像和声音的识别情况。