1. 引言

1.1 DGGAN是什么?

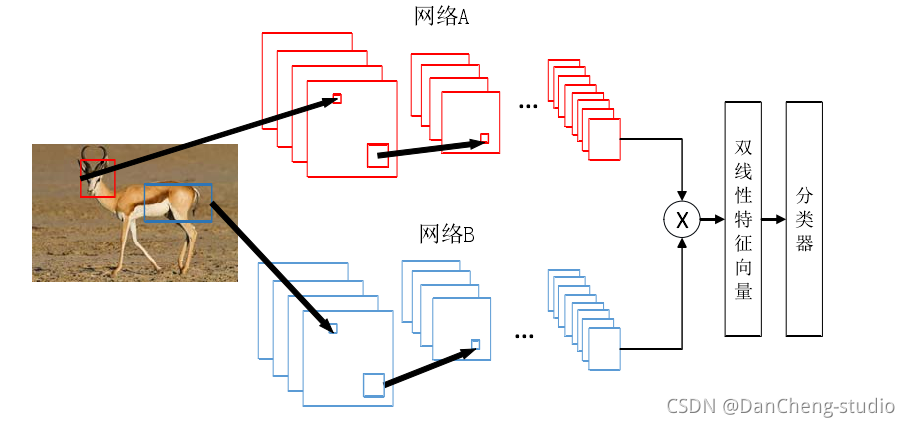

DGGAN(Directed Graph embedding framework based on Generative Adversarial Network)是一种基于生成对抗网络(GAN)的有向图嵌入方法:

基本定义:DGGAN是一种结合了对抗学习原理的图嵌入方法,旨在通过生成对抗网络来优化有向图的嵌入表示。

主要思想:

- DGGAN基于对抗学习设计了一个判别器和两个生成器。

- 对于给定的节点,两个生成器分别从相同的分布中生成该节点的虚假的目标和源邻居节点。

- 判别器的任务是区分输入的邻居节点是真实存在于图中的,还是由生成器生成的虚假节点。结构特点:由于两个生成器并不是独立的,而是被结合到一个统一的框架中,因此它们可以互相增强以学习到质量更高的源向量和目标向量。

应用场景:DGGAN在多个有向图挖掘任务中持续且显著地优于现有的最新技术。

技术效果:通过大量的实验表明,DGGAN能够有效地保留节点之间的有向边信息,并为有向图挖掘任务提供高质量的嵌入表示。

与其他GAN的区别:相较于传统的GAN模型,DGGAN特别针对有向图的数据结构进行了优化,通过引入两个生成器来分别处理源向量和目标向量的生成,从而更好地捕捉有向图中的复杂关系。

DGGAN是一种基于生成对抗网络的有向图嵌入方法,它通过设计判别器和两个生成器来优化有向图的嵌入表示,并在多个有向图挖掘任务中表现出优异的效果。

1.2 深度卷积概述

1.2.1 定义与概念

深度卷积是深度学习领域中一种重要的技术,特别是在计算机视觉领域。它基于卷积运算,通过构建多层的卷积神经网络(Convolutional Neural Networks, CNNs)来学习和提取图像中的特征。

1.2.2 工作原理

- 卷积层:深度卷积的核心是卷积层,它通过卷积核对输入图像进行滑动窗口式的操作,以捕获图像的局部特征。每个卷积层可以学习不同层次的特征,从简单的边缘、线条到复杂的形状和模式。

- 池化层:在卷积层之间,通常会加入池化层(Pooling Layers),用于降低数据的维度和复杂度,同时保留主要特征。常见的池化操作包括最大池化和平均池化。

- 激活函数:在卷积层和池化层之后,通常会使用激活函数(如ReLU、Sigmoid等)来增加网络的非线性,使得网络能够学习更加复杂的特征。

- 全连接层:在多个卷积和池化层之后,通常会使用全连接层(Fully Connected Layers)来将学到的特征映射到样本标记空间,起到分类器的作用。

1.2.3 应用与优势

- 图像识别与分类:深度卷积在图像识别与分类任务中表现出色,能够准确地识别出图像中的物体、场景等。

- 目标检测与跟踪:深度卷积还可以用于目标检测与跟踪任务,通过训练网络来识别图像中的目标,并对其进行定位和跟踪。

- 图像分割:在图像分割任务中,深度卷积可以学习图像中的像素级特征,实现对图像的精细分割。

- 数据增强:深度卷积在数据增强方面也有应用,可以通过对图像进行旋转、裁剪、缩放等操作来增强数据集的多样性,提高模型的泛化能力。

1.2.4 技术拓展

- 深度可分离卷积:一种优化的卷积方式,将标准的卷积操作分解为深度卷积和逐点卷积两个步骤,以减少参数量和计算量。

- 分组卷积:将输入的特征图分为若干组,然后在每个组内分别进行卷积操作,以减少计算量和提高模型的并行性。

- 空洞卷积(Dilated Convolution):通过增加卷积核的空洞率(dilation rate),使卷积核能够覆盖更大的感受野,同时保持计算量不变。这种技术常用于语义分割任务中。

总之,深度卷积作为一种重要的深度学习技术,在计算机视觉领域有着广泛的应用。随着技术的不断发展和完善,深度卷积将会在更多的领域中展现出其独特的优势和潜力。

1.3 图像生成

图像生成是一个涉及计算机视觉和人工智能的广泛领域,它利用不同的技术和模型来生成或修改图像。以下是关于图像生成技术的清晰概述:

1.3.1 定义与背景

图像生成是指运用人工智能技术,根据给定的数据进行单模态或跨模态生成图像的过程。它涵盖了从简单的图像合成到复杂的图像生成技术,如根据文本描述生成图像等。

1.3.2 主要技术与应用

GANs(生成对抗网络)

- GANs是最知名的图像生成模型之一,它通过生成器和判别器之间的博弈训练来提升生成图像的质量。

- GANs可以生成非常逼真的图像,广泛应用于艺术创作、虚拟现实等领域。

- 优点:生成的图像质量高,逼真度高。

- 缺点:训练不稳定,可能陷入局部最优解,需要大量计算资源。VAEs(变分自编码器)

- VAEs是一种基于概率的生成模型,通过编码和解码过程学习数据的潜在表示。

- VAEs可以产生符合潜在分布的、无限数量的样本,适用于产生大量新样本的场景。

- 优点:训练相对稳定,易于产生新样本。

- 缺点:生成的图像创新性不足,可能相对单一。Diffusion Models(扩散模型)

- Diffusion models通过逐步“混合”真实数据和生成的样本来生成新的图像。

- 优点:高效生成高质量图像,保持一定创新性。

- 缺点:需要大量计算资源,创新性相对较弱。应用示例

- Midjourney:全球知名的AI图片生成工具,用户可通过聊天指令快速获得高质量图像。

- boardmix AI:在线白板AI绘画工具,支持图生图、AI抠图等功能。

- Lexica:基于Stable Diffusion进行微调的AI图像生成网站。

- StarryAI:深度学习技术与GAN生成对抗网络工具,用于艺术创作。

1.3.3 图像生成的类型

- 图像合成:根据现有的图片生成新图像。

- 图像到图像:将一种图像类型转换为另一种图像类型,如灰度图到彩色图。

- 文本到图像:根据文本描述生成符合语义的图像。

1.3.4 技术发展趋势

随着深度学习技术的不断发展,图像生成领域将继续迎来创新和突破。新的模型和技术将不断涌现,为图像生成带来更高的质量和更广泛的应用。

图像生成是一个充满活力和潜力的领域,它涵盖了从简单的图像合成到复杂的跨模态生成技术。随着技术的不断发展,我们有理由相信,图像生成将在未来为我们带来更多的惊喜和可能性。

2. 图像生成过程

2.1 设置

import keras

import tensorflow as tf

from keras import layers

from keras import ops

import matplotlib.pyplot as plt

import os

import gdown

from zipfile import ZipFile

2.2 数据预处理

2.2.1 加载数据

import os

from zipfile import ZipFile

import gdown

# 创建目录(如果不存在)

os.makedirs("celeba_gan", exist_ok=True)

# 定义下载链接和输出文件路径

url = "https://drive.google.com/uc?id=1O7m1010EJjLE5QxLZiM9Fpjs7Oj6e684"

output = "celeba_gan/data.zip"

# 使用gdown下载文件

gdown.download(url, output, quiet=True)

# 解压ZIP文件到指定目录

with ZipFile(output, "r") as zipobj:

zipobj.extractall("celeba_gan")

# (可选)删除ZIP文件以节省空间

# os.remove(output)

2.2.2 数据缩放

从文件夹中创建一个数据集,并将图像缩放到[0-1]范围:

使用Keras的image_dataset_from_directory函数从文件夹中加载了图像数据集,并设置了标签模式为None,图像大小为(64, 64),以及批次大小为32。接下来,您需要将图像数据缩放到[0, 1]的范围。

import tensorflow as tf

from tensorflow.keras.preprocessing import image_dataset_from_directory

# 加载数据集

dataset = image_dataset_from_directory(

"celeba_gan",

label_mode=None,

image_size=(64, 64),

batch_size=32,

# 如果需要,可以添加shuffle=True以及seed参数来随机打乱数据

)

# 使用map函数将图像数据缩放到[0, 1]范围

dataset = dataset.map(lambda x: x / 255.0, num_parallel_calls=tf.data.AUTOTUNE)

# 如果需要,可以设置缓存数据集以提高性能

# dataset = dataset.cache()

# 如果需要,可以设置预取以改善性能

# dataset = dataset.prefetch(buffer_size=tf.data.AUTOTUNE)

2.2.3 可视化数据

从dataset中迭代并显示一个图像。但是,由于dataset是一个批次数据集(tf.data.Dataset),每次迭代都会返回一个批次的数据。使用[0]索引时,实际上是在访问该批次中的第一个图像。

import matplotlib.pyplot as plt

import tensorflow as tf

# 假设dataset已经被正确创建并且是一个图像数据集

# 使用tf.data.Dataset的take方法来只获取一个批次的数据

# 这里我们假设数据集已经被shuffle过,因此'take(1)'将给我们一个随机的样本批次

one_batch = dataset.take(1)

# 迭代这个批次(虽然它只包含一个批次)

for x in one_batch:

# 注意:x是一个tensor,表示一个批次的图像(例如32张图像)

# 我们只显示第一张图像

plt.axis("off")

# 使用TensorFlow的numpy函数来获取numpy数组

image = x.numpy()[0] # 获取第一张图像(索引为0)

# 如果图像是灰度图,则可能只有一个通道,但如果是彩色图,则可能有三个通道

# 我们假设它是彩色图,并且像素值在[0, 1]范围内,因此我们需要将其转换到[0, 255]

image_scaled = (image * 255).astype("uint8")

# 使用imshow显示图像

plt.imshow(image_scaled)

break # 因为我们只需要显示一个图像,所以在这里中断循环

# 显示图像

plt.show()

2.3 创建判别器

判别器将64x64的图像映射到一个二元分类得分。

在深度学习中,特别是在生成对抗网络(GANs)中,判别器(或称为“鉴别器”)通常是一个神经网络,它负责区分输入数据是来自真实数据分布(真实图像)还是来自生成器(生成的图像)。在二元分类的上下文中,判别器将尝试为真实图像输出接近1的得分,而为生成的(或假的)图像输出接近0的得分。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Input, Conv2D, LeakyReLU, Flatten, Dropout, Dense

# 创建判别器模型

discriminator = Sequential(

[

Input(shape=(64, 64, 3)),

Conv2D(64, kernel_size=4, strides=2, padding="same"),

LeakyReLU(negative_slope=0.2),

Conv2D(128, kernel_size=4, strides=2, padding="same"),

LeakyReLU(negative_slope=0.2),

Conv2D(128, kernel_size=4, strides=2, padding="same"),

LeakyReLU(negative_slope=0.2),

Flatten(),

Dropout(0.2),

Dense(1, activation="sigmoid"),

],

name="discriminator",

)

# 显示模型结构

discriminator.summary()

Model: "discriminator"

┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━┓

┃ Layer (type) ┃ Output Shape ┃ Param # ┃

┡━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━┩

│ conv2d (Conv2D) │ (None, 32, 32, 64) │ 3,136 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ leaky_re_lu (LeakyReLU) │ (None, 32, 32, 64) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ conv2d_1 (Conv2D) │ (None, 16, 16, 128) │ 131,200 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ leaky_re_lu_1 (LeakyReLU) │ (None, 16, 16, 128) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ conv2d_2 (Conv2D) │ (None, 8, 8, 128) │ 262,272 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ leaky_re_lu_2 (LeakyReLU) │ (None, 8, 8, 128) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ flatten (Flatten) │ (None, 8192) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ dropout (Dropout) │ (None, 8192) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ dense (Dense) │ (None, 1) │ 8,193 │

└─────────────────────────────────┴───────────────────────────┴────────────┘

Total params: 404,801 (1.54 MB)

Trainable params: 404,801 (1.54 MB)

Non-trainable params: 0 (0.00 B)

2.4 创建生成器

创建生成器,它通常与判别器的架构相反,用Conv2DTranspose(也被称为转置卷积或反卷积)层替换Conv2D层。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Input, Dense, Reshape, Conv2DTranspose, LeakyReLU

# 定义潜在空间的维度

latent_dim = 128

# 创建生成器模型

generator = Sequential(

[

# 输入层,接受一个形状为 (latent_dim,) 的向量

Input(shape=(latent_dim,)),

# 第一个全连接层(Dense),将潜在向量映射到一个大的特征空间

Dense(8 * 8 * 128),

# 重塑层,将特征映射到一个 8x8 的特征图上,每个位置有 128 个通道

Reshape((8, 8, 128)),

# 使用 Conv2DTranspose 进行上采样

# 注意:这里通常不使用 LeakyReLU 在 Conv2DTranspose 后,因为 Conv2DTranspose 类似于卷积的反向操作,而不是激活函数

Conv2DTranspose(128, kernel_size=4, strides=2, padding="same"),

LeakyReLU(alpha=0.2),

# 再次上采样,并增加特征图的通道数

Conv2DTranspose(256, kernel_size=4, strides=2, padding="same"),

LeakyReLU(alpha=0.2),

# 继续上采样,通道数进一步增加

Conv2DTranspose(512, kernel_size=4, strides=2, padding="same"),

LeakyReLU(alpha=0.2),

# 最后的卷积层,不使用 Conv2DTranspose,因为此时已经到达了目标图像大小

# 激活函数使用 'tanh' 而不是 'sigmoid',因为 'tanh' 的输出范围在 -1 到 1 之间,这在图像生成中更为常见

Conv2D(3, kernel_size=5, padding="same", activation="tanh"),

],

name="generator",

)

# 显示模型结构

generator.summary()

模型结构:

输入层:

Input(shape=(latent_dim,))接受一个形状为(latent_dim,)的向量,这是从潜在空间(latent space)中随机采样的点。全连接层(Dense):将输入的潜在向量映射到一个大的特征空间,该空间将被重塑为

(8, 8, 128)的特征图。重塑层(Reshape):将全连接层的输出重塑为

(8, 8, 128)的三维特征图,这是进行卷积转置操作(即上采样)前的准备。转置卷积层(Conv2DTranspose):也称为反卷积或分数步长卷积,用于将特征图的大小增大(即上采样)。这里我们连续使用了三个

Conv2DTranspose层来逐步增大特征图的大小,并增加特征图的通道数。LeakyReLU 激活函数:在每个

Conv2DTranspose层之后使用LeakyReLU激活函数,以增加模型的非线性并帮助解决梯度消失的问题。输出层:最后一个层是一个常规的

Conv2D层(而不是Conv2DTranspose),因为它将特征图映射到最终的输出图像大小。使用tanh激活函数是因为它在 -1 到 1 的范围内,这通常更适合于图像生成任务。模型名称:

name="generator"为模型提供了一个明确的名称,以便于在训练或评估过程中引用。

最后,通过调用 generator.summary() 可以打印出模型的概述,包括每一层的名称、输出形状和参数数量。

Model: "generator"

┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━┓

┃ Layer (type) ┃ Output Shape ┃ Param # ┃

┡━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━┩

│ dense_1 (Dense) │ (None, 8192) │ 1,056,768 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ reshape (Reshape) │ (None, 8, 8, 128) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ conv2d_transpose │ (None, 16, 16, 128) │ 262,272 │

│ (Conv2DTranspose) │ │ │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ leaky_re_lu_3 (LeakyReLU) │ (None, 16, 16, 128) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ conv2d_transpose_1 │ (None, 32, 32, 256) │ 524,544 │

│ (Conv2DTranspose) │ │ │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ leaky_re_lu_4 (LeakyReLU) │ (None, 32, 32, 256) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ conv2d_transpose_2 │ (None, 64, 64, 512) │ 2,097,664 │

│ (Conv2DTranspose) │ │ │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ leaky_re_lu_5 (LeakyReLU) │ (None, 64, 64, 512) │ 0 │

├─────────────────────────────────┼───────────────────────────┼────────────┤

│ conv2d_3 (Conv2D) │ (None, 64, 64, 3) │ 38,403 │

└─────────────────────────────────┴───────────────────────────┴────────────┘

Total params: 3,979,651 (15.18 MB)

Trainable params: 3,979,651 (15.18 MB)

Non-trainable params: 0 (0.00 B)

2.5 自定义训练步骤

import tensorflow as tf

from tensorflow.keras import layers, losses, metrics, Model, random

from tensorflow.keras.optimizers import Adam

class GAN(Model):

def __init__(self, discriminator, generator, latent_dim):

super(GAN, self).__init__()

# 初始化判别器和生成器

self.discriminator = discriminator

self.generator = generator

self.latent_dim = latent_dim # 潜在空间的维度

def compile(self, d_optimizer, g_optimizer, loss_fn):

super(GAN, self).compile()

# 编译模型,设置判别器和生成器的优化器及损失函数

self.d_optimizer = d_optimizer

self.g_optimizer = g_optimizer

self.loss_fn = loss_fn

# 初始化判别器和生成器的损失度量

self.d_loss_metric = metrics.Mean(name="d_loss")

self.g_loss_metric = metrics.Mean(name="g_loss")

@property

def metrics(self):

# 返回模型度量

return [self.d_loss_metric, self.g_loss_metric]

def train_step(self, real_images):

# 定义一个训练步骤

batch_size = tf.shape(real_images)[0] # 获取批次大小

random_latent_vectors = tf.random.normal(shape=(batch_size, self.latent_dim)) # 从潜在空间采样

# 生成假图像

generated_images = self.generator(random_latent_vectors)

# 将生成的假图像与真实图像合并

combined_images = tf.concat([generated_images, real_images], axis=0)

# 创建真实和假图像的标签

labels = tf.concat([tf.ones((batch_size, 1)), tf.zeros((batch_size, 1))], axis=0)

# 给标签添加噪声,提高模型的泛化能力

labels += 0.05 * tf.random.uniform(tf.shape(labels))

# 训练判别器

with tf.GradientTape() as tape:

predictions = self.discriminator(combined_images) # 判别器预测

d_loss = self.loss_fn(labels, predictions) # 计算判别器损失

grads = tape.gradient(d_loss, self.discriminator.trainable_variables) # 计算梯度

self.d_optimizer.apply_gradients(zip(grads, self.discriminator.trainable_variables)) # 更新判别器权重

# 训练生成器

random_latent_vectors = tf.random.normal(shape=(batch_size, self.latent_dim)) # 再次从潜在空间采样

misleading_labels = tf.zeros((batch_size, 1)) # 生成器的目标是让判别器认为假图像为真

with tf.GradientTape() as tape:

predictions = self.discriminator(self.generator(random_latent_vectors)) # 生成器生成的图像被判别器预测

g_loss = self.loss_fn(misleading_labels, predictions) # 计算生成器损失

grads = tape.gradient(g_loss, self.generator.trainable_variables) # 计算梯度

self.g_optimizer.apply_gradients(zip(grads, self.generator.trainable_variables)) # 更新生成器权重

# 更新判别器和生成器的损失度量

self.d_loss_metric.update_state(d_loss)

self.g_loss_metric.update_state(g_loss)

# 返回当前步骤的损失

return {"d_loss": self.d_loss_metric.result(), "g_loss": self.g_loss_metric.result()}

上述代码生成对抗网络(GAN)的实现,使用Keras框架。GAN由两部分组成:生成器(generator)和判别器(discriminator)。生成器的目标是生成尽可能接近真实数据的假数据,而判别器的目标是区分真实数据和生成器生成的假数据:

首先,定义了一个GAN类,它继承自

keras.Model。这个类初始化时需要传入生成器(generator)、判别器(discriminator)以及潜在空间的维度(latent_dim)。在

compile方法中,设置了判别器和生成器的优化器(d_optimizer, g_optimizer)以及损失函数(loss_fn)。同时,还定义了两个度量(metrics)来记录判别器和生成器的损失。train_step方法定义了训练过程中的一个步骤。这个方法首先从潜在空间中采样(random_latent_vectors),然后生成假图像(generated_images)。将生成的假图像与真实图像(real_images)合并,并创建相应的标签(labels)。标签中,真实图像的标签为1,假图像的标签为0。此外,为了增加模型的鲁棒性,标签中加入了一些随机噪声。

使用

tf.GradientTape来计算判别器的梯度,并使用优化器更新判别器的权重。再次从潜在空间采样(random_latent_vectors),并生成假图像。这次,所有生成的图像都被标记为假图像(misleading_labels)。

计算生成器的损失,使用优化器更新生成器的权重。注意,这一步不更新判别器的权重。

更新判别器和生成器的损失度量(metrics)。

返回一个包含判别器和生成器损失的字典。

2.6 建立自定义回调函数保存生成的图像

在TensorFlow中,为了创建一个自定义的回调来定期保存生成的图像,您需要在tf.keras.callbacks.Callback的基础上实现特定的方法,比如on_epoch_end或on_train_batch_end(如果您希望在每个批次结束时保存图像)。

在给出的GANMonitor类中,目的是在GAN(生成对抗网络)训练的每个epoch结束时,使用GAN的生成器部分来生成一些随机图像,并将这些图像保存为文件。

import os

from tensorflow.keras.callbacks import Callback

from tensorflow.keras.utils import array_to_img

import numpy as np

class GANMonitor(Callback):

def __init__(self, num_img=3, latent_dim=128, save_dir='generated_images/'):

self.num_img = num_img

self.latent_dim = latent_dim

self.save_dir = save_dir

# 确保保存目录存在

if not os.path.exists(self.save_dir):

os.makedirs(self.save_dir)

def on_epoch_end(self, epoch, logs=None):

# 生成随机潜向量

random_latent_vectors = np.random.normal(size=(self.num_img, self.latent_dim))

# 假设model是一个GAN模型,它有一个名为'generator'的方法或属性

# 调用生成器来生成图像

generated_images = self.model.generator.predict(random_latent_vectors)

# 如果生成器的输出在[-1, 1]范围内,则需要将其缩放到[0, 255]

generated_images = ((generated_images + 1) * 127.5).astype(np.uint8)

# 保存生成的图像

for i in range(self.num_img):

img = array_to_img(generated_images[i])

img_path = os.path.join(self.save_dir, f"generated_img_{epoch:03d}_{i}.png")

img.save(img_path)

# 示例用法:

# 假设你有一个训练好的GAN模型,并且这个模型有一个名为'generator'的方法或属性

# model = ... # 这里是你的GAN模型

# monitor = GANMonitor(num_img=5, latent_dim=100, save_dir='path/to/save/images')

# model.fit(x_train, y_train, epochs=100, callbacks=[monitor])

上述代码主要功能是自定义回调函数并保存生成的图像:

在

__init__方法中,我添加了一个save_dir参数,它指定了保存生成图像的目录。我使用了

numpy的np.random.normal来生成随机潜向量,而不是keras.random.normal,因为keras.random.normal通常用于TensorFlow张量操作,而在这里我们直接使用NumPy数组。我假设

self.model.generator是一个可调用的对象(方法或函数),它接受潜向量作为输入并返回生成的图像。我们使用predict方法来调用它(如果generator是一个Keras模型或层)。如果生成器的输出在[-1, 1]范围内(这是常见的归一化范围),则需要将其缩放到[0, 255]范围以保存为图像文件。我使用了

((images + 1) * 127.5).astype(np.uint8)来进行缩放。我使用

os.path.join来确保图像文件被保存在正确的目录中,并使用f-string来格式化文件名,包括epoch数和图像索引。最后,我添加了示例用法注释,展示了如何在训练GAN模型时使用这个回调。请注意,你需要将

model替换为你自己的GAN模型,并确保它有一个名为generator的方法或属性。

2.7 训练端到端模型

“端到端模型”指的是一种机器学习模型,这种模型直接从原始输入数据映射到期望的输出,无需进行过多的预处理或后处理。例如,在图像识别任务中,一个端到端模型可以直接从原始图像中识别出对象,而不需要手动提取特征或进行其他复杂的图像预处理步骤。

import tensorflow as tf

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.losses import BinaryCrossentropy

from tensorflow.keras.datasets import mnist # 假设我们使用MNIST数据集作为示例

# 假设您已经定义了discriminator和generator

# discriminator = ...

# generator = ...

# latent_dim = ...

# 假设dataset是已经加载并预处理的MNIST数据集

(train_images, _), (test_images, _) = mnist.load_data()

train_images = train_images.reshape(train_images.shape[0], 28, 28, 1).astype('float32') / 255.

dataset = tf.data.Dataset.from_tensor_slices(train_images).shuffle(10000).batch(32)

# GAN类(这里只是一个占位符,您已经有了这个类)

class GAN:

def __init__(self, discriminator, generator, latent_dim):

self.discriminator = discriminator

self.generator = generator

self.latent_dim = latent_dim

# 假设compile和fit方法已经被正确实现

def compile(self, d_optimizer, g_optimizer, loss_fn):

# ... 实现compile方法 ...

pass

def fit(self, dataset, epochs, callbacks=None):

# ... 实现fit方法 ...

pass

# 实例化GAN

gan = GAN(discriminator=discriminator, generator=generator, latent_dim=latent_dim)

# 编译GAN模型

gan.compile(

d_optimizer=Adam(learning_rate=0.0002, beta_1=0.5), # 通常对于GAN,我们可能需要调整Adam的参数

g_optimizer=Adam(learning_rate=0.0002, beta_1=0.5),

loss_fn=BinaryCrossentropy(from_logits=True), # 对于GAN的判别器,通常使用logits

)

# 在实践中,您可能想要使用更多的epochs,但这里我们仍然使用1个epoch作为示例

epochs = 1

# 创建一个GANMonitor实例,并添加到callbacks中

gan_monitor = GANMonitor(num_img=10, latent_dim=latent_dim)

# 训练GAN模型

gan.fit(

dataset, epochs=epochs, callbacks=[gan_monitor]

)

上述代码主要进行设置一个GAN(生成对抗网络)模型,并尝试对其进行训练:

数据集准备:我使用了MNIST数据集作为示例,并将其归一化到[0, 1]范围,并转换为float32格式。然后,我将数据集转换为一个

tf.data.Dataset对象,以便在训练过程中使用。GAN类:我假设您已经有一个名为

GAN的类,该类封装了判别器和生成器,并提供了compile和fit方法。在这个示例中,我仅展示了如何实例化这个类并调用它的方法。编译GAN模型:在编译GAN模型时,我们为判别器和生成器分别提供了优化器,并指定了损失函数。对于GAN的判别器,我们通常使用从logits(即未经过sigmoid或softmax激活函数的原始输出)计算的损失,因此需要将

from_logits参数设置为True。训练GAN模型:我们使用

fit方法来训练GAN。在这里,我仅使用了一个epoch作为示例,但在实践中,您可能需要使用更多的epochs来确保模型能够充分训练。此外,我还添加了一个GANMonitor实例到回调列表中,以便在每个epoch结束时保存生成的图像。

2/6332 [37m━━━━━━━━━━━━━━━━━━━━ 9:54 94ms/step - d_loss: 0.6792 - g_loss: 0.7880

WARNING: All log messages before absl::InitializeLog() is called are written to STDERR

I0000 00:00:1704214667.959762 1319 device_compiler.h:186] Compiled cluster using XLA! This line is logged at most once for the lifetime of the process.

6332/6332 ━━━━━━━━━━━━━━━━━━━━ 557s 84ms/step - d_loss: 0.5616 - g_loss: 1.4099

<keras.src.callbacks.history.History at 0x7f251d32bc40>

3. 总结和展望

3.1 总结

生成对抗网络(GAN)是一种强大的图像生成模型,它通过判别器和生成器的相互竞争来提高生成图像的质量。本文首先介绍了DGGAN,这是一种专门针对有向图的图嵌入方法,它通过两个生成器和一个判别器的协作,优化了有向图的嵌入表示,从而在相关挖掘任务中取得了显著的成果。

接着,本文深入探讨了深度卷积技术,这是深度学习在计算机视觉领域的核心应用之一。深度卷积通过多层卷积神经网络提取图像特征,已成功应用于图像识别、目标检测和分割等多个领域。此外,文中还涉及了图像生成的多种技术,包括GANs、VAEs和扩散模型等,这些技术能够根据给定数据生成新的图像或修改现有图像。

最后,本文详细介绍了使用Keras框架进行GAN模型构建和训练的全过程。从数据预处理、模型构建、自定义训练步骤到训练过程中的回调函数设置,文中提供了详尽的代码示例和步骤说明。特别是自定义的GANMonitor回调函数,它允许我们在训练的每个epoch结束时保存并观察生成图像的变化。整个过程不仅展示了GAN的训练方法,也体现了端到端模型训练的实践应用。通过这些步骤,可以实现一个能够生成高质量图像的GAN模型。

3.2 展望

生成对抗网络(GAN)作为一种创新的深度学习模型,其发展前景备受期待。以下是对GAN未来发展的整合展望:

模型发展与技术创新:未来GAN的研究将继续推动模型架构和训练方法的创新。研究者可能会开发新的网络结构来提高生成图像的质量和多样性,同时探索更有效的正则化技术来提升训练过程的稳定性。此外,计算效率的提升也是GAN发展的关键,预计会有更多的研究集中在减少资源消耗和提高模型运行速度上。

应用领域的扩展与深化:GAN技术的应用前景广阔,预计将进一步拓展至医疗成像、虚拟现实、艺术创作等多个领域。特别是在3D图像和视频生成方面,GAN有望实现更加真实和动态的视觉效果。同时,跨模态转换技术的发展将为内容创作和信息检索带来新的机遇,推动多学科融合和创新。

伦理、安全性与可解释性:随着GAN技术的发展,如何确保生成内容的安全性、合规性以及保护用户隐私将变得越来越重要。研究者需要在设计和训练GAN模型时考虑伦理问题,并提高模型的可解释性和控制性。此外,开源工具和平台的发展将进一步促进GAN技术的普及,降低技术门槛,使更多人能够利用GAN进行创新和应用。

综上所述,GAN技术的未来研究将不仅局限于技术层面的突破,还将涉及伦理、安全性和应用领域的广泛拓展。随着技术的不断成熟和应用的不断深化,GAN有望在多个领域发挥重要作用,推动人工智能技术的进一步发展。