基于ChatGLM3的本地问答机器人部署流程

前言

部署完成后视频演示

https://www.bilibili.com/video/BV1fV3XePEi4/?spm_id_from=333.1007.top_right_bar_window_dynamic.content.click&vd_source=c5d972a40f6877b991f3c691467df568

参考链接:

https://github.com/THUDM/ChatGLM3

https://github.com/chatchat-space/Langchain-Chatchat

#微调

https://github.com/THUDM/ChatGLM3/blob/main/finetune_demo/README.md

https://zhipu-ai.feishu.cn/wiki/QiLtwks1YioOSEkCxFIcAEWNnzb

https://github.com/chatchat-space/Langchain-Chatchat/wiki/

#基于ChatGLM3的本地测井问答机器人设计文档

https://download.csdn.net/download/qq_51985653/89406695

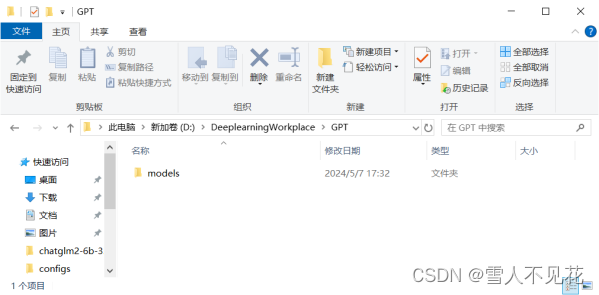

一、确定文件结构

1.新建文件夹储存本地模型

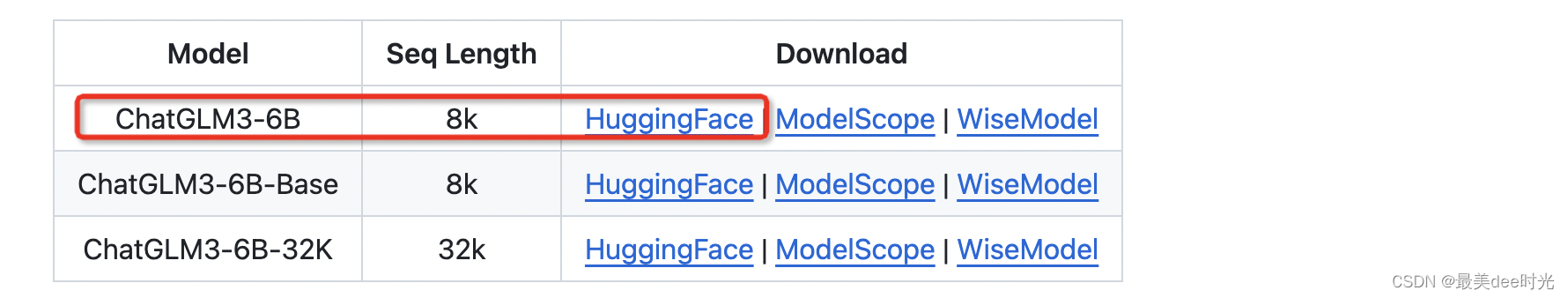

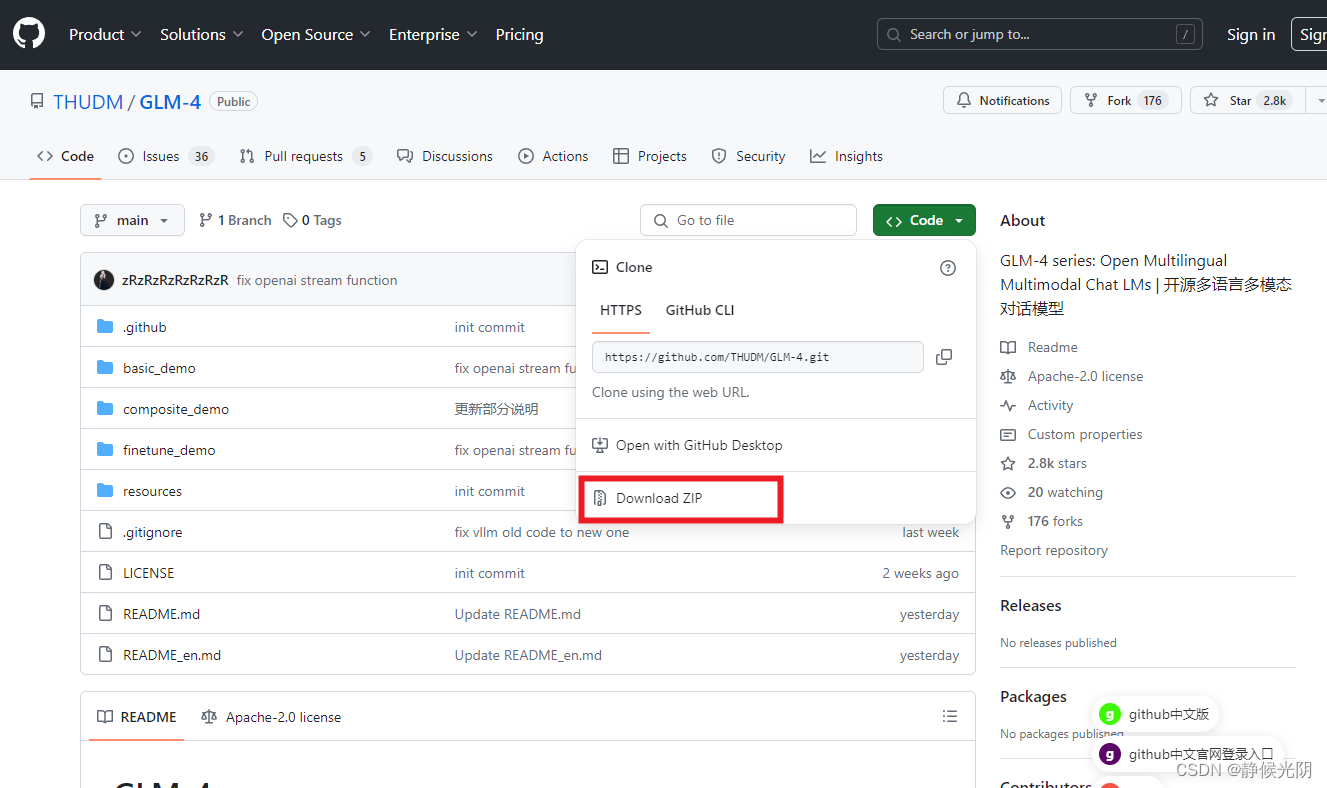

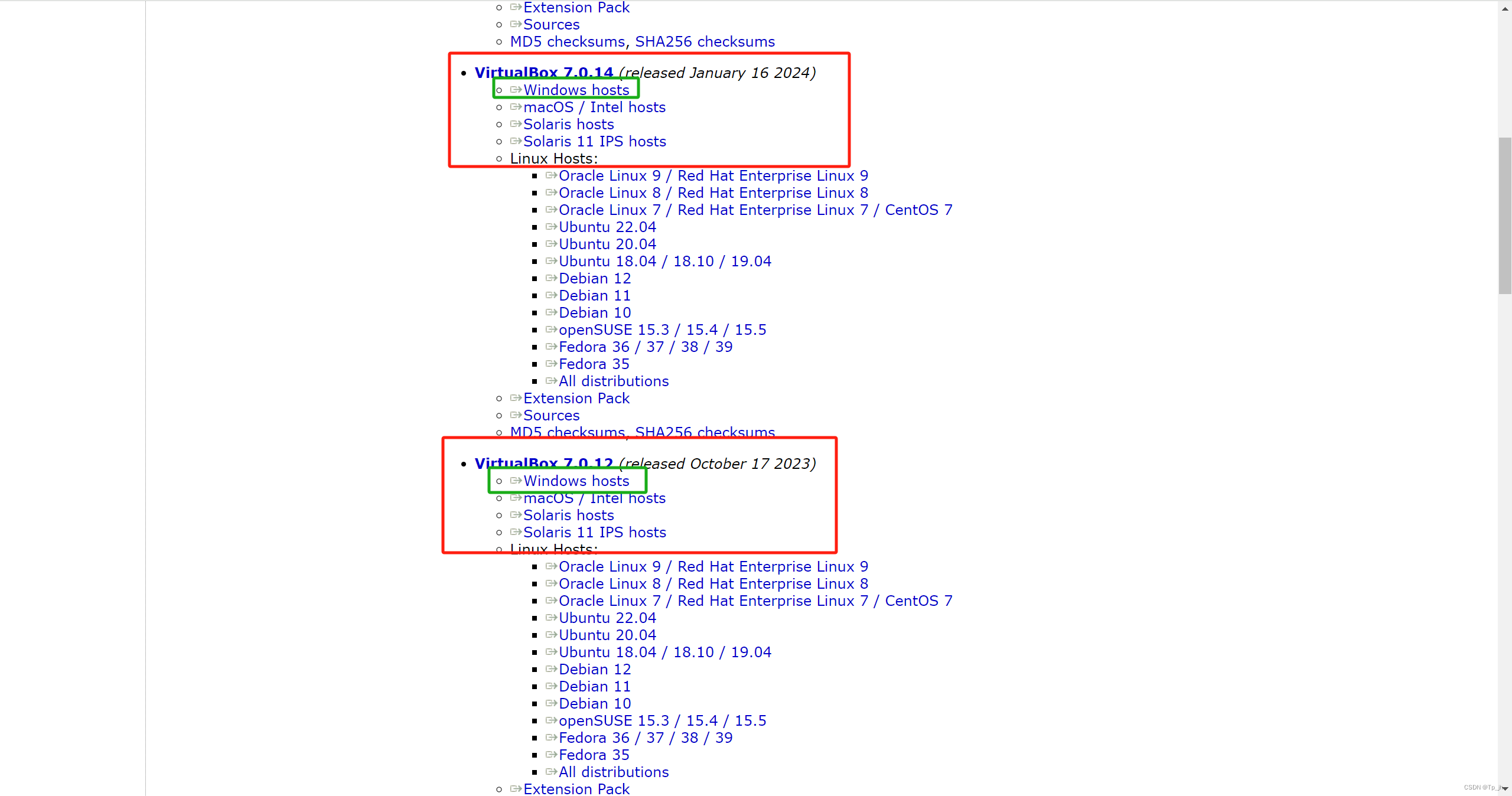

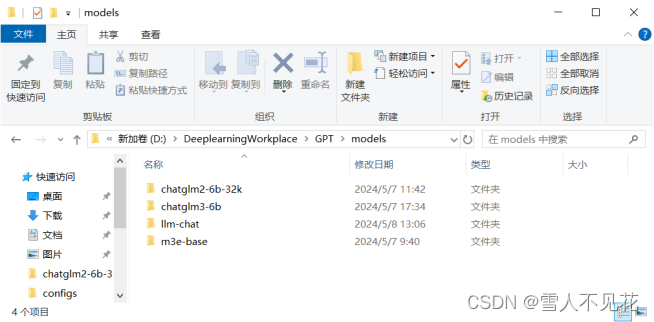

2.下载源码和模型

#若下载较慢也可复制链接手动下载到本地

git clone https://huggingface.co/THUDM/chatglm2-6b-32k

git clone https://huggingface.co/moka-ai/m3e-base

git clone https://github.com/chatchat-space/Langchain-Chatchat.git

下载完成后的文件结构

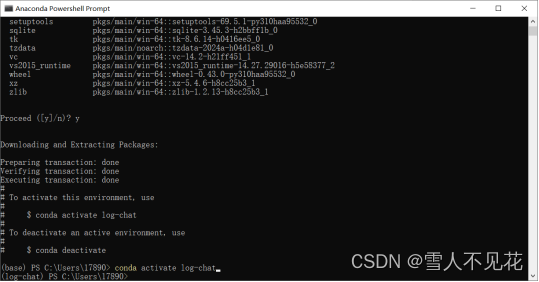

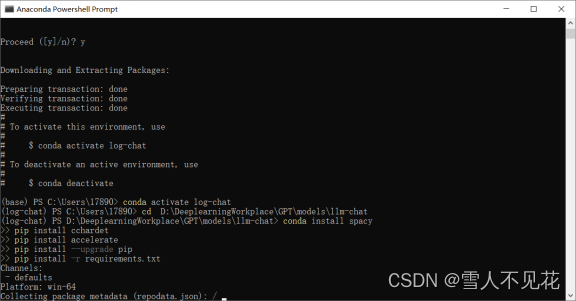

二、Anaconda环境搭建

1.创建anaconda环境

打开anaconda终端,创建并激活环境

conda create -n log-chat python=3.10

conda activate log-chat

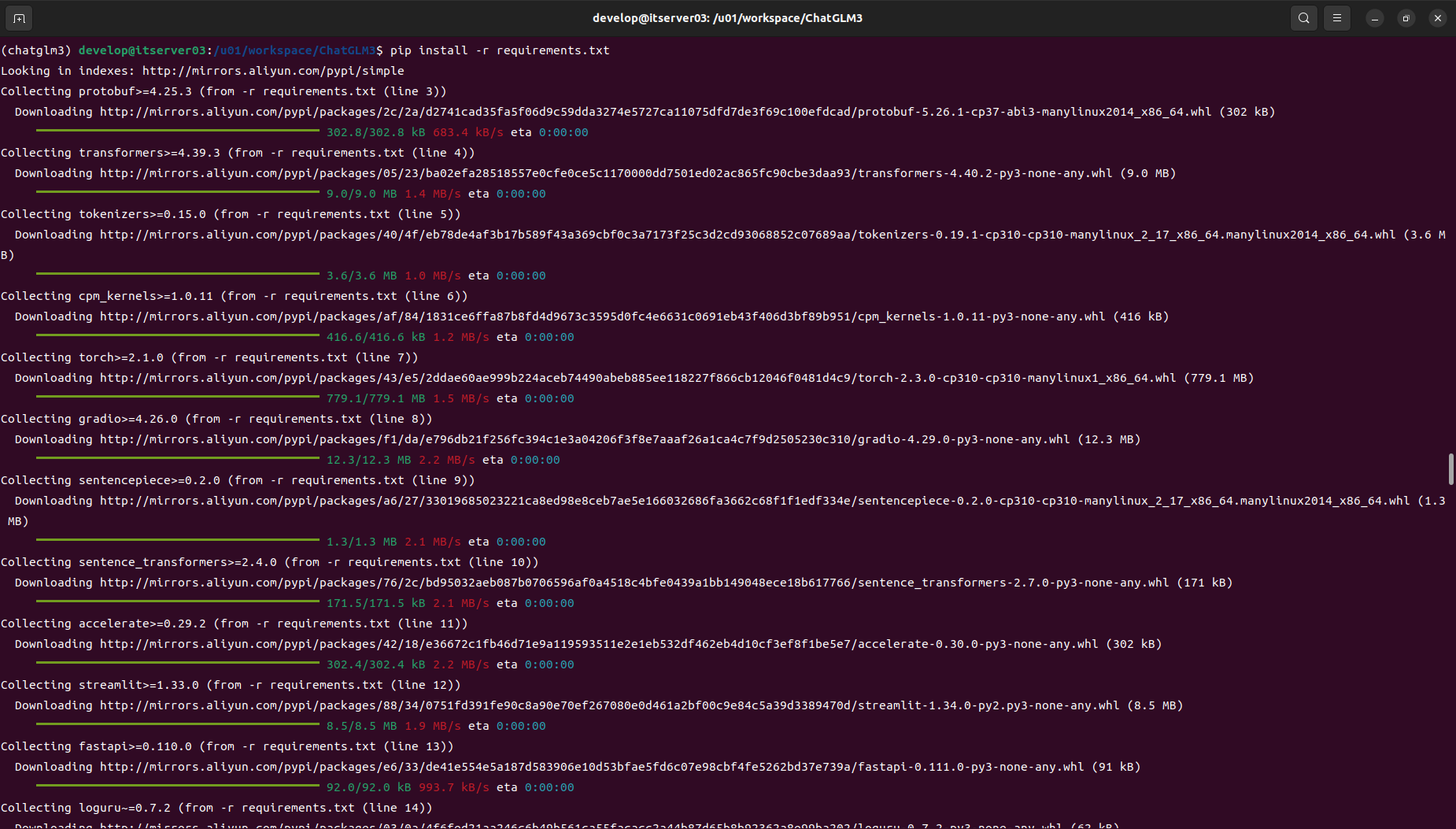

2.安装相关库

conda install spacy

pip install cchardet

pip install accelerate

pip install --upgrade pip

pip install -r requirements.txt

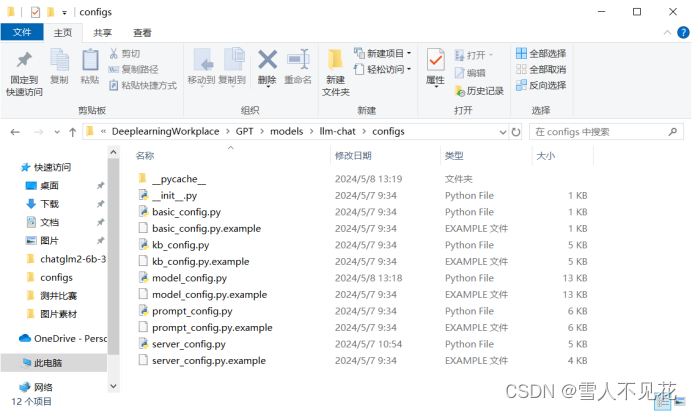

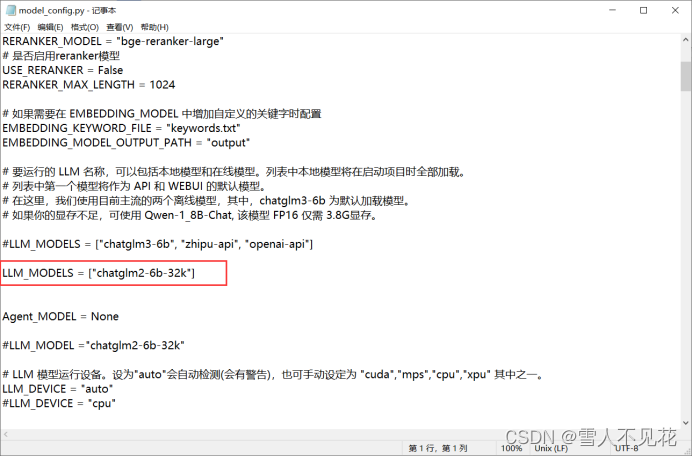

3.设置本地模型路径

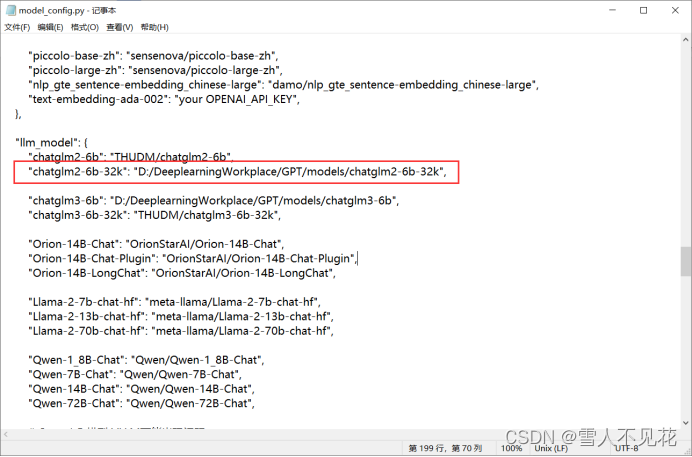

来到llm-chat模型的configs文件夹下,修改model_config.py的内容

将LLM_MODELS设置为本地下载的模型文件

LLM_MODELS = ["chatglm2-6b-32k"]

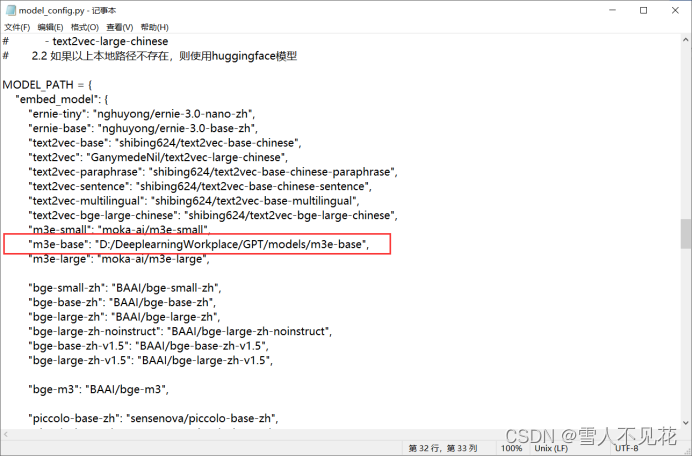

在MODEL_PATH 中将m3e-base设置为本地路径

将llm_model中的chatglm2-6b-32k设置为本地模型路径,若本地有其他模型文件则同理

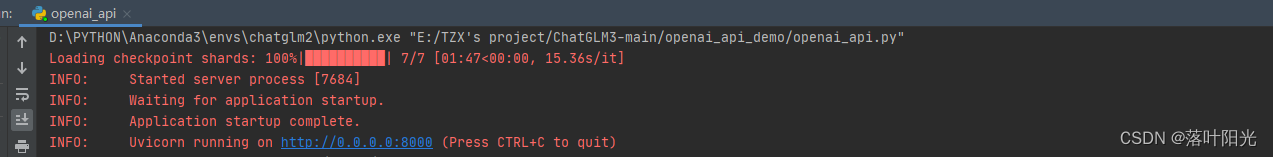

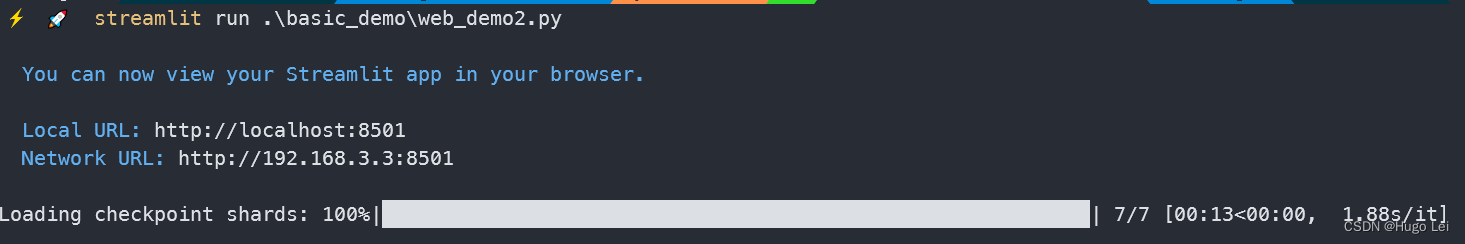

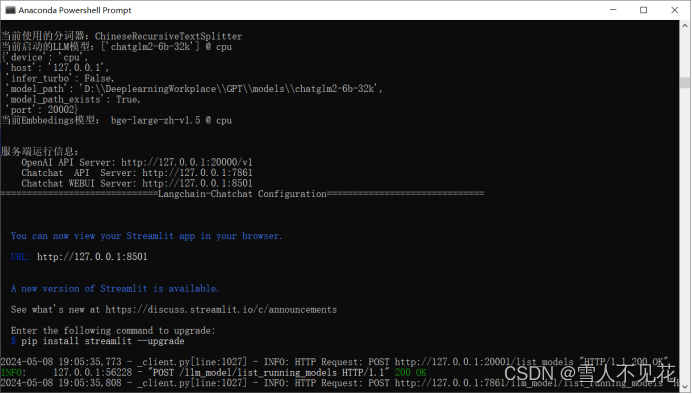

4.启动

在anaconda终端中进行启动

cd D:\DeeplearningWorkplace\GPT\models\llm-chat

python startup.py --all-webui

三、构建本地知识库

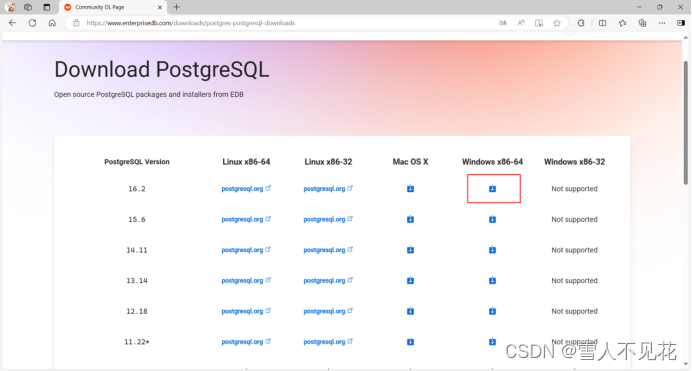

1.下载并安装postgresql

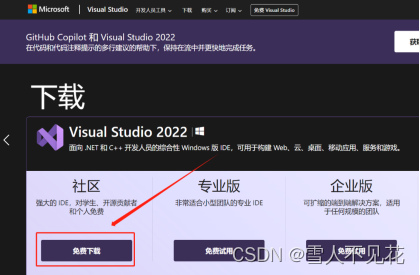

2.安装c++库

3.配置向量插件

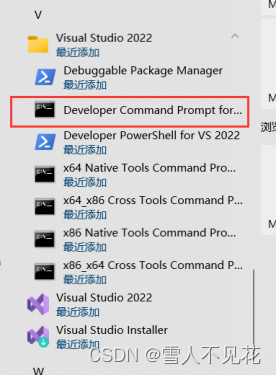

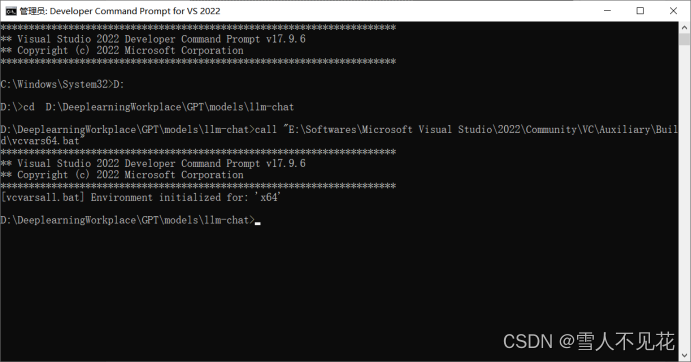

在Developer Command Prompt for Vs 2022终端进入源码目录下并执行call命令

cd D:\DeeplearningWorkplace\GPT\models\llm-chat

call “E:\Softwares\Microsoft Visual tudio\2022\Community\VC\Auxiliary\Build\vcvars64.bat”

set "PGROOT=E:\Softwares\PostgreSQL\16"

git clone -branch v0.4.4 https://github.com/pgvector/pgvector.git

cd pgvector

nmake /F Makefile.win

nmake /F Makefile.win install

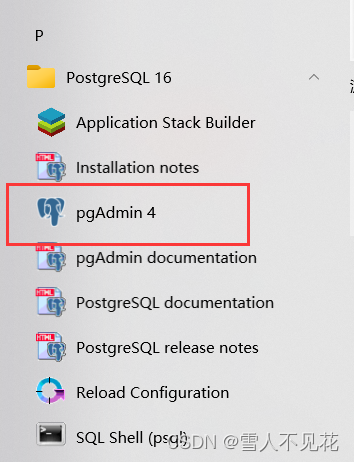

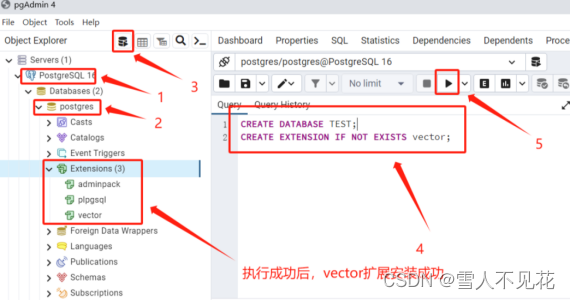

#打开pgAdmin4,创建数据库并安装向量插件

四、线上运行

服务器租赁:https://www.autodl.com/

#autodl部署启动命令

cd /root/Langchain-Chatchat/

conda activate /root/pyenv

python startup.py -a

#服务器连接本地参考命令

ssh -CNg -L 8501:127.0.0.1:8501 featurize@workspace.featurize.cn -p 56656

ssh -CNg -L 6006:127.0.0.1:6006 root@123.125.240.150 -p 42151

#其中root@123.125.240.150和42151分别是实例中SSH指令的访问地址与端口,

#请找到自己实例的ssh指令做相应替换。

#6006:127.0.0.1:6006是指代理实例内6006端口到本地的6006端口。

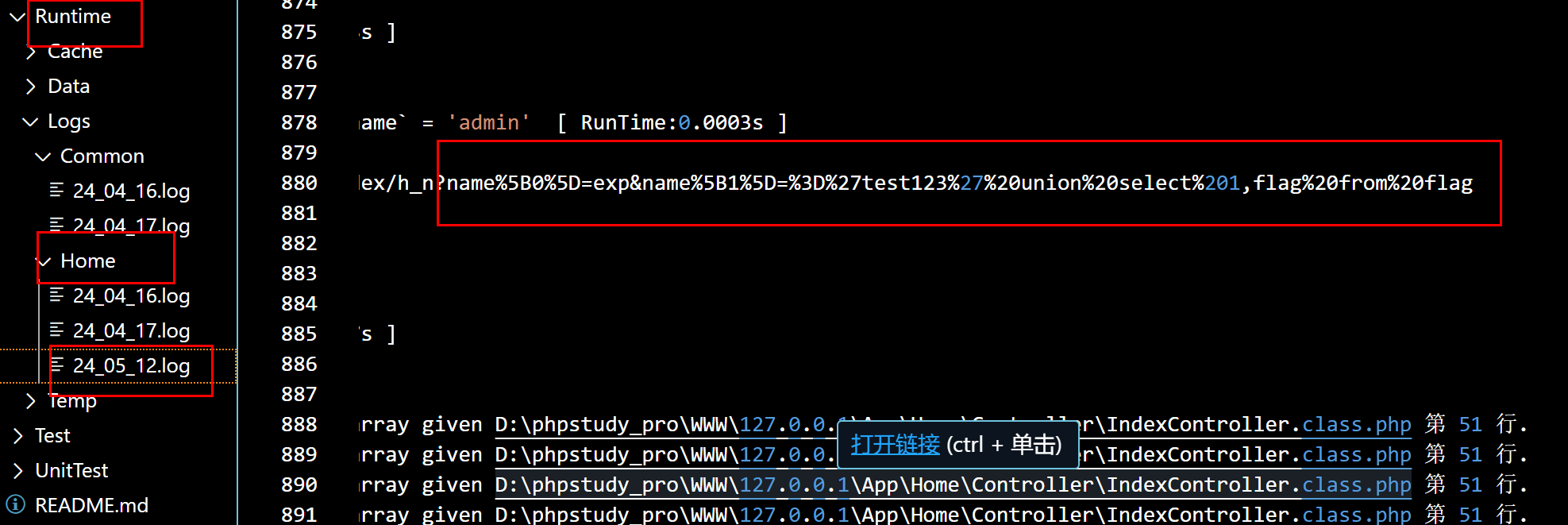

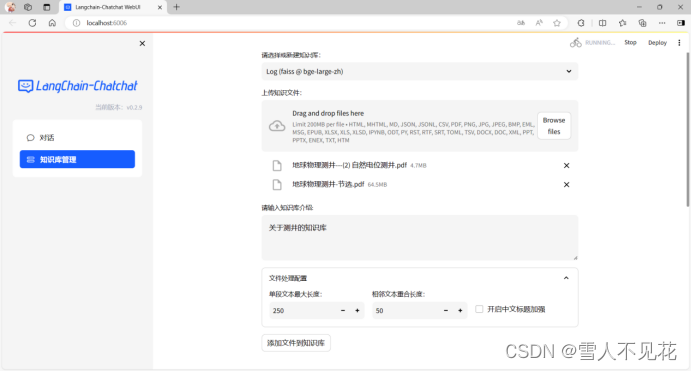

添加本地文件到知识库

五、 全部命令

#完成建立放置本地模型文件夹后在Anaconda终端执行下述命令

#其中相关路径要修改为自己对应的本地路径

#下载模型

git clone https://huggingface.co/THUDM/chatglm2-6b-32k

git clone https://huggingface.co/moka-ai/m3e-base

git clone https://github.com/chatchat-space/Langchain-Chatchat.git

#创建并激活conda环境

conda create -n log-chat python=3.10

conda activate log-chat

#在模型对应路径下安装相关库

cd D:\DeeplearningWorkplace\GPT\models\llm-chat

conda install spacy

pip install cchardet

pip install accelerate

pip install --upgrade pip

pip install -r requirements.txt

cd configs

cp ./model_config.py.example ./model_config.py

cp ./server_config.py.example ./server_config.py

cp ./basic_config.py.example ./basic_config.py

cp ./kb_config.py.example ./kb_config.py

cp ./prompt_config.py.example ./prompt_config.py

#修改llm-chat配置文件使其使用本地模型

#修改model_config.py文件内容

#anaconda中启动

conda activate log-chat

cd D:\DeeplearningWorkplace\GPT\models\llm-chat

python startup.py --all-webui

#下载postgresql

#https://www.enterprisedb.com/downloads/postgres-postgresql-downloads

#下载visualstudio 安装c++环境

#https://visualstudio.microsoft.com/zh-hans/downloads

#在Developer Command Prompt for Vs 2022终端进入源码目录下

cd D:\DeeplearningWorkplace\GPT\models\llm-chat

#执行call命令

call “E:\Softwares\Microsoft Visual Studio\2022\Community\VC\Auxiliary\Build\vcvars64.bat”

#执行下述命令

set "PGROOT=E:\Softwares\PostgreSQL\16"

git clone -branch v0.4.4 https://github.com/pgvector/pgvector.git

cd pgvector

nmake /F Makefile.win

nmake /F Makefile.win install

#打开pgAdmin4,创建数据库并安装向量插件

CREATE DATABASE TEST;

CREATE EXTENSION IF NOT EXISTS vector;

#打开anaconda终端

conda activate log-chat

cd D:\DeeplearningWorkplace\GPT\models\llm-chat\configs

python -m spacy download en_core_web_sm

python -m spacy download zh_core_web_sm

pip install psycopg2

pip install pgvetor

cd D:\DeeplearningWorkplace\GPT\models\llm-chat\

python init_database.py --recreate-vs

#启动

python startup.py -a

#之后在网页端上传知识库文件即可