混合训练(Mixed Precision Training)是一种优化深度学习模型训练过程的技术,其中梯度缩放(Gradient Scaling)是混合训练中常用的一项技术。

在深度学习中,梯度是用于更新模型参数的关键信息。然而,当使用低精度数据类型(如半精度浮点数)进行训练时,梯度的计算可能会受到数值溢出或下溢的影响,导致训练不稳定或无法收敛。

1. 梯度缩放基本概念

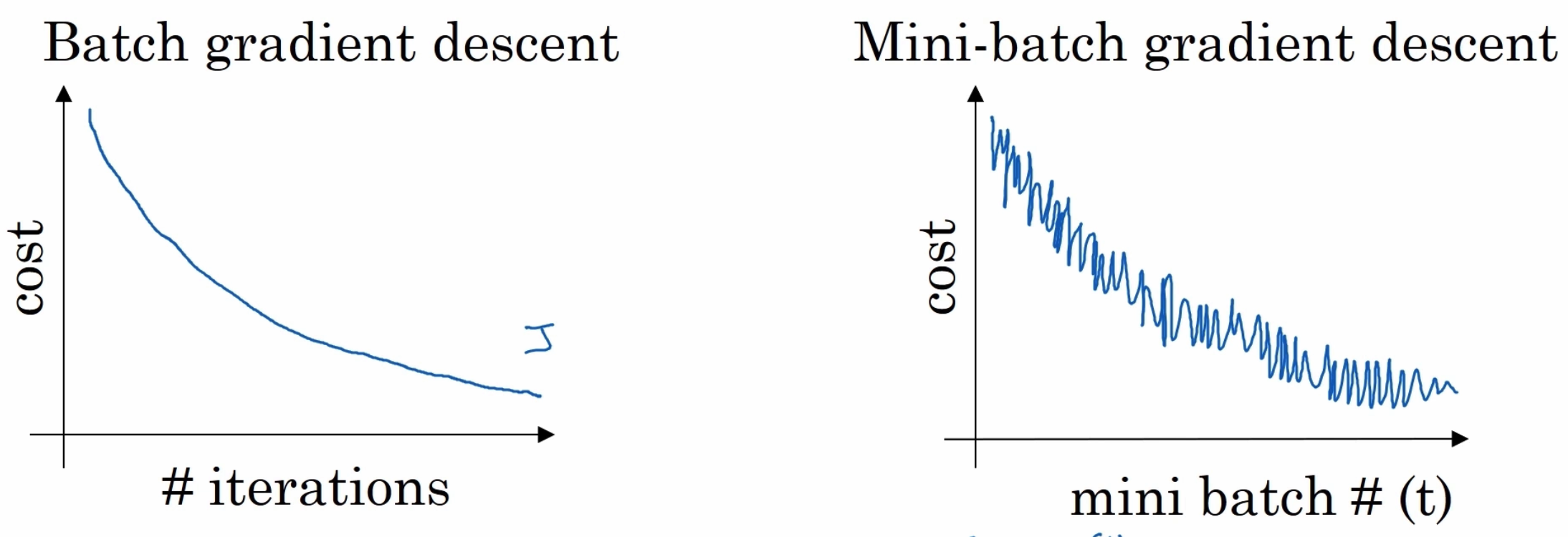

梯度缩放是一种通过缩放梯度值的方法来解决这个问题。具体而言,梯度缩放将梯度乘以一个缩放因子,使其适应于所使用的低精度数据类型的动态范围。缩放因子通常是一个小的常数,例如 0.5 或 0.1,可以根据实际情况进行调整。

梯度缩放的过程可以简单描述如下:

计算模型的梯度:根据训练数据和当前的模型参数,计算模型的梯度。

缩放梯度:将计算得到的梯度乘以一个缩放因子。

更新模型参数:使用缩放后的梯度更新模型的参数。

通过梯度缩放,可以减小梯度的幅度,使其适应于低精度数据类型的范围,并提高模型训练的稳定性和收敛性。

2. 使用示例

下面是一个示例代码,展示了如何在混合训练中使用梯度缩放:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义模型

model = nn.Linear(10, 1)

# 定义数据和目标

input_data = torch.randn(32, 10)

target = torch.randn(32, 1)

# 定义优化器

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 定义缩放因子

scale_factor = 0.5

# 迭代训练

for epoch in range(10):

optimizer.zero_grad() # 清除梯度

# 前向传播

output = model(input_data)

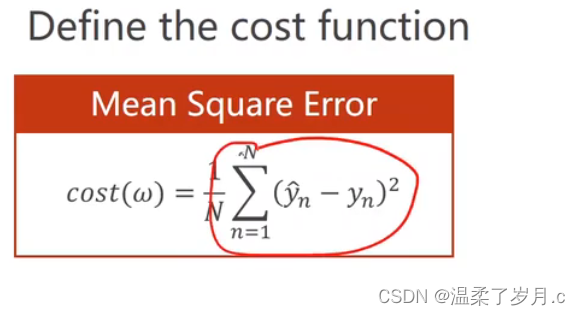

loss = nn.MSELoss()(output, target)

# 反向传播

loss.backward()

# 梯度缩放

for param in model.parameters():

param.grad *= scale_factor

# 更新模型参数

optimizer.step()在上述示例中,首先定义了一个简单的线性模型 model,然后使用随机数据进行训练。在每个训练迭代中,先清除梯度,然后进行前向传播和反向传播。在反向传播后,通过循环遍历模型的参数,并将梯度乘以缩放因子 scale_factor。最后,使用优化器进行参数更新。

需要注意的是,在实际应用中,缩放因子的选择需要根据具体情况进行调整。如果梯度溢出或下溢较为严重,可以选择较小的缩放因子;如果梯度范围较小,可以选择较大的缩放因子。对于不同的模型和任务,可能需要进行一些实验来确定最佳的缩放因子。

梯度缩放通常与混合精度训练一起使用,其中权重参数使用低精度(如半精度浮点数,FP16),而梯度计算和累积使用高精度(如单精度浮点数,FP32)。这种组合可以提高训练速度和效率,并在一定程度上保持模型性能。

总结起来,梯度缩放是深度学习中一种常用的优化技术,通过缩放梯度的数值范围来解决梯度溢出或下溢的问题。它可以提高训练的稳定性和收敛性,并与混合精度训练等技术结合使用,进一步优化深度学习模型的训练过程。

3.GradScaler函数介绍

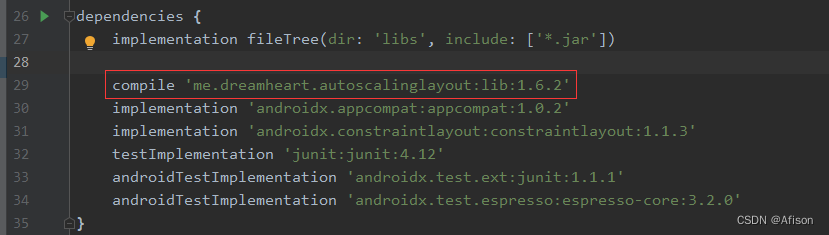

在yolov8中使用GradScaler函数进梯度缩放。

self.scaler = amp.GradScaler(enabled=self.amp) #创建一个 scaler 对象,用于在混合精度训练中缩放梯度GradScaler 类的实现是在 PyTorch 的 torch.cuda.amp 模块中。它用于管理梯度缩放,以确保在混合精度训练中梯度的数值范围适当,并防止梯度溢出或下溢。

下面是一个简化版的 GradScaler 类的实现,用于说明其工作原理:

class GradScaler:

def __init__(self, enabled=True):

self.enabled = enabled

self._scale = None

def scale(self, loss):

if self.enabled:

self._scale = torch.float32

loss = loss * self._scale

return loss

def step(self, optimizer):

if self.enabled:

optimizer.step()

def update(self):

if self.enabled:

self._scale = None在这个简化的实现中,GradScaler 类有三个主要方法:

- scale(self, loss): 这个方法用于梯度缩放。如果梯度缩放被启用(self.enabled 为 True),它会将损失乘以一个缩放因子,这个缩放因子在这里表示为 self._scale。缩放因子的类型为 torch.float32,确保梯度计算在高精度上进行。最后,它返回缩放后的损失。

- step(self, optimizer): 这个方法用于执行参数更新。如果梯度缩放被启用,它会直接调用优化器的 step() 方法,对模型参数进行更新。

- update(self): 这个方法用于在训练迭代结束后更新缩放器的状态。如果梯度缩放被启用,它会将缩放因子 self._scale 设置为 None,以便在下一次迭代中重新计算缩放因子。

在实际使用中,GradScaler 类通常与 torch.cuda.amp.autocast 上下文一起使用,以自动将计算转换为所需的精度。梯度缩放的目的是确保在混合精度训练中,梯度计算和参数更新能够在适当的精度上进行,从而提高训练效率和稳定性。

需要注意的是,上述是一个简化的实现,实际的 GradScaler 类可能包含更多的功能和优化,以适应更复杂的训练场景。

![[羊城杯 2021]BabySmc](https://img-blog.csdnimg.cn/direct/a6bde2965ef448218a7b5c1e95918846.png)