👀时空之门👀

🔍引言

随着信息技术的飞速发展,机器学习已经成为人工智能领域中的关键技术之一。在机器学习的众多分支中,深度学习以其强大的特征表示能力和高效的计算模型,成为解决复杂问题的有力工具。然而,在实际应用中,标注数据的获取往往成本高昂且耗时,这限制了深度学习模型的训练和应用。因此,如何在有限标注数据的情况下提高深度学习模型的性能,成为了一个重要的研究问题。半监督学习作为一种介于监督学习和非监督学习之间的方法,为解决这一问题提供了新的思路。本文将从半监督学习的视角出发,探讨机器学习在深度学习领域中的作用,分析其基本原理、应用场景以及面临的挑战,并通过代码示例展示半监督学习的实际应用。

🎈半监督学习概述

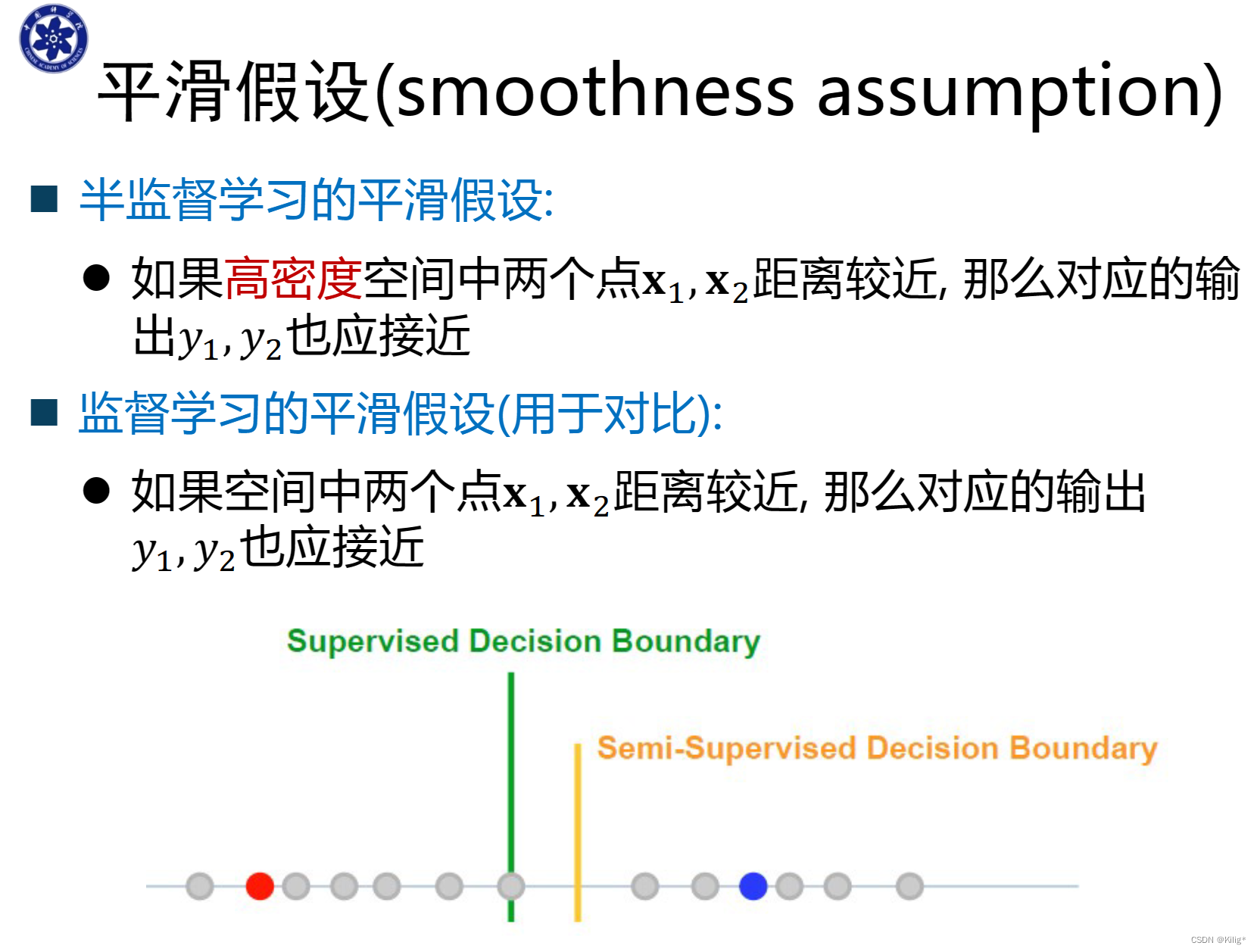

半监督学习是一种结合了监督学习和非监督学习的机器学习技术,旨在利用少量标注数据和大量未标注数据来提高学习器的性能。在实际应用中,标注数据的获取往往需要人工参与,成本高昂且耗时。而大量的未标注数据则相对容易获取,但难以直接用于监督学习。半监督学习通过利用未标注数据中的信息,辅助标注数据进行模型训练,从而提高了模型的泛化能力和准确性。

半监督学习的方法主要包括自训练(Self-training)、生成模型(Generative Models)、图模型(Graph-based Models)和协同训练(Co-training)等。这些方法各有特点,适用于不同的应用场景。其中,自训练方法通过迭代地利用模型对未标注数据进行预测和标注,逐步扩大标注数据集;生成模型方法则通过假设数据服从某种分布,利用未标注数据估计分布参数,进而对标注数据进行建模;图模型方法则利用数据之间的相似性关系构建图结构,通过图上的信息传播来辅助标注数据进行模型训练;协同训练方法则通过训练多个分类器,利用分类器之间的差异性来辅助标注数据进行模型训练。

🚝机器学习在深度学习领域中的作用

☘特征提取与表示学习

深度学习以其强大的特征提取和表示学习能力,在机器学习领域发挥着重要作用。在半监督学习中,深度学习模型同样可以利用其层次化的特征提取方式,从标注数据和未标注数据中提取出更加丰富的特征表示。这些特征表示不仅可以用于提高模型的分类性能,还可以用于其他相关任务,如聚类、降维等。

🍀复杂任务建模

深度学习模型具有强大的建模能力,可以处理更加复杂的数据和任务。在半监督学习中,深度学习模型可以利用未标注数据中的信息,辅助标注数据进行模型训练,从而实现对复杂任务的建模。例如,在图像识别领域,深度学习模型可以通过卷积神经网络(CNN)自动学习到图像中的局部特征和空间结构信息;在自然语言处理领域,深度学习模型可以通过循环神经网络(RNN)或Transformer等结构学习到文本中的序列依赖关系和语义信息。这些复杂的任务建模能力使得深度学习在各个领域都取得了显著的成果。

❀结合半监督学习提升性能

在半监督学习中,深度学习模型可以通过以下方式提升性能:

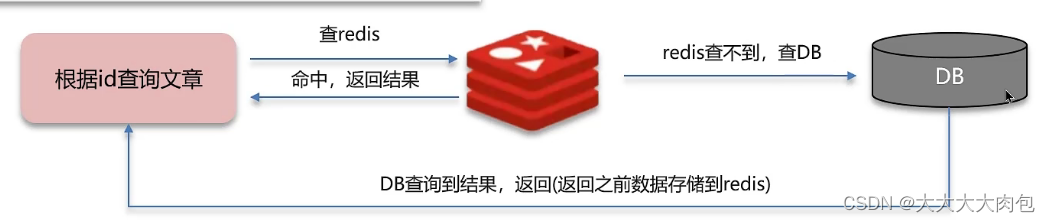

利用未标注数据扩大训练集:深度学习模型通常需要大量的标注数据进行训练。然而,在实际应用中,标注数据的获取往往成本高昂且耗时。半监督学习可以通过利用未标注数据来扩大训练集,从而提高模型的泛化能力和准确性。例如,可以使用自训练方法将未标注数据作为模型的输入,利用模型的预测结果作为标注数据来扩大训练集。

利用未标注数据辅助标注数据进行训练:在半监督学习中,标注数据和未标注数据往往具有相似的分布。因此,可以利用未标注数据中的信息来辅助标注数据进行模型训练。例如,可以使用生成模型方法假设数据服从某种分布,利用未标注数据估计分布参数,进而对标注数据进行建模;或者使用图模型方法利用数据之间的相似性关系构建图结构,通过图上的信息传播来辅助标注数据进行模型训练。

结合多种半监督学习方法:不同的半监督学习方法各有特点,适用于不同的应用场景。因此,可以结合多种半监督学习方法来提高深度学习模型的性能。例如,可以同时使用自训练方法和协同训练方法,通过迭代地利用模型对未标注数据进行预测和标注,以及利用多个分类器之间的差异性来辅助标注数据进行模型训练。

🚀半监督学习在深度学习中的应用场景

📕图像识别与计算机视觉

在图像识别领域,半监督学习可以通过利用未标注图像中的信息来辅助标注图像进行模型训练。例如,可以使用自训练方法将未标注图像作为模型的输入,利用模型的预测结果作为标注数据来扩大训练集;或者使用图模型方法利用图像之间的相似性关系构建图结构,通过图上的信息传播来辅助标注图像进行模型训练。这些方法可以提高深度学习模型在图像识别任务中的性能。

图像识别与计算机视觉:自训练方法

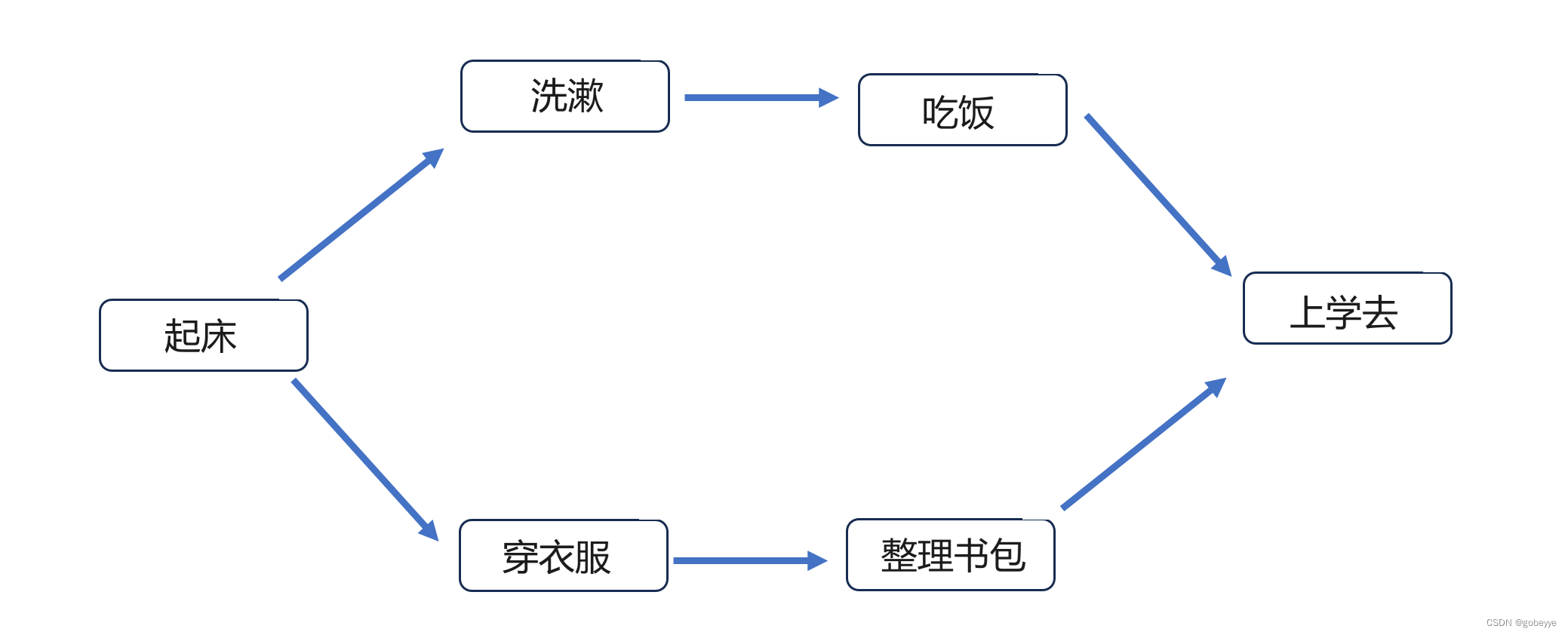

在图像识别任务中,我们可以使用自训练方法(Self-training)来利用未标注的图像数据辅助标注数据进行深度学习模型的训练。自训练方法的基本思想是先使用有限的标注数据训练一个初始模型,然后用这个模型对未标注数据进行预测,将预测结果置信度较高的样本加入到训练集中,再重新训练模型。这样迭代进行,逐步扩大训练集,提高模型的性能。

以下是一个使用Keras实现的自训练方法代码示例:

import keras

from keras.datasets import cifar10

from keras.models import Sequential

from keras.layers import Dense, Dropout, Flatten

from keras.layers import Conv2D, MaxPooling2D

from keras.utils import to_categorical

from sklearn.model_selection import train_test_split

# 加载CIFAR-10数据集

(x_train_full, y_train_full), (x_test, y_test) = cifar10.load_data()

# 假设我们只有少量标注数据

n_labeled = 1000

x_train, y_train = x_train_full[:n_labeled], y_train_full[:n_labeled]

y_train = to_categorical(y_train, 10)

# 剩余数据作为未标注数据

x_unlabeled = x_train_full[n_labeled:]

# 初始模型

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', padding='same', input_shape=(32, 32, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Conv2D(64, (3, 3), activation='relu', padding='same'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(512, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(10, activation='softmax'))

# 编译模型

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 初始训练

model.fit(x_train, y_train, epochs=10, batch_size=64)

# 自训练迭代

n_iterations = 5

for iteration in range(n_iterations):

# 使用当前模型对未标注数据进行预测

predictions = model.predict(x_unlabeled)

# 选择置信度较高的样本(例如,选择预测概率最高的类别概率大于某个阈值的样本)

# 这里简单起见,我们假设选择预测概率最高的前100个样本

confidence_scores = predictions.max(axis=1)

top_indices = confidence_scores.argsort()[-100:][::-1]

x_new_labeled = x_unlabeled[top_indices]

y_new_labeled = predictions[top_indices].argmax(axis=1)

y_new_labeled = to_categorical(y_new_labeled, 10)

# 扩大训练集

x_train = np.concatenate((x_train, x_new_labeled), axis=0)

y_train = np.concatenate((y_train, y_new_labeled), axis=0)

# 重新训练模型

model.fit(x_train, y_train, epochs=10, batch_size=64)

# 最终模型在测试集上的评估

loss, accuracy = model.evaluate(x_test, to_categorical(y_test, 10))

print(f'Test loss: {loss}, Test accuracy: {accuracy}')

注意:上述代码示例为了简化,直接使用了CIFAR-10数据集的一部分作为未标注数据,实际应用中可能需要根据具体情况来获取未标注数据。

🐱自然语言处理

在自然语言处理领域,半监督学习同样具有广泛的应用。例如,在文本分类任务中,可以使用协同训练方法训练多个分类器,利用分类器之间的差异性来辅助标注文本进行模型训练;或者在命名实体识别任务中,可以使用生成模型方法假设文本数据

自然语言处理:协同训练方法

在自然语言处理任务中,协同训练方法(Co-training)可以利用多个不同的特征视图(例如,词语、词性、句法结构等)来训练多个分类器,并通过这些分类器之间的差异性来辅助标注数据进行模型训练。以下是一个简化的协同训练方法代码示例:

from sklearn.datasets import fetch_20newsgroups

from sklearn.model_selection import train_test_split

from sklearn.feature_extraction.text import Tfidf

💖半监督学习的未来与发展

- 理论与算法的创新:随着研究的深入,半监督学习的理论与算法将不断得到创新和完善。这将进一步提高半监督学习的性能和应用范围。

- 应用领域的拓展:随着技术的不断进步,半监督学习将在更多领域得到应用。例如,在医疗健康、金融、自动驾驶等领域,半监督学习将发挥重要作用。

- 与其他技术的融合:半监督学习将与其他技术如强化学习、迁移学习等进行融合,形成更加先进的人工智能技术。这将进一步推动人工智能技术的发展和应用。