Python库之Scrapy的简介、安装、使用方法详细攻略

简介

Scrapy是一个快速的、高层次的web抓取和web抓取框架,用于抓取网站数据并从页面中提取结构化的数据。Scrapy用途广泛,可以用于数据挖掘、信息处理或存储历史数据,以及各种其他用途。

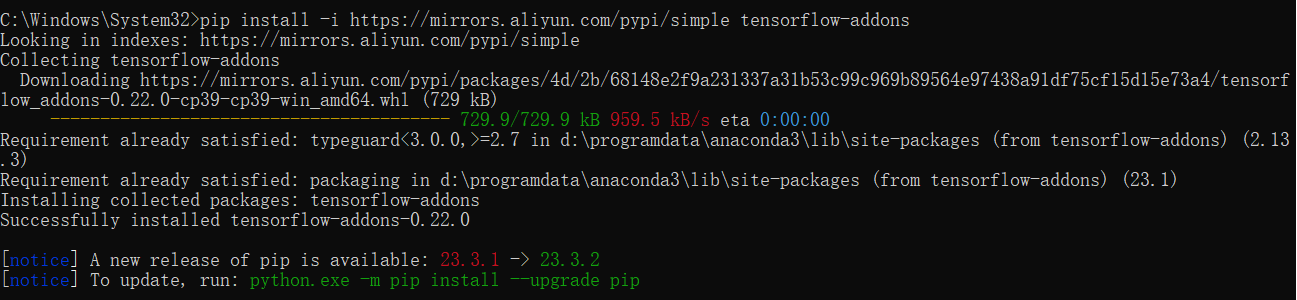

安装

Scrapy可以通过Python的包管理工具pip进行安装,以下是安装命令:

pip install scrapy

确保你已经安装了pip。如果还没有安装pip,可以参照官方文档进行安装。

使用方法

初始化Scrapy项目

创建一个新的Scrapy项目,可以通过以下命令:

scrapy startproject myproject

这将会创建一个名为myproject的目录,其中包含项目的骨架代码。

定义Item

在Scrapy中,Item是一个Python类,用于定义爬取的数据结构。编辑myproject/items.py文件来定义你的Item。

import scrapy

class MyItem(scrapy.Item):

title = scrapy.Field()

description = scrapy.Field()

# 定义其他字段...

创建Spider

Spider是Scrapy中用于定义爬取逻辑的类。每个Spider对应一个或多个特定网站。在myproject/spiders目录下创建一个新的Spider文件,例如example.py,并定义你的Spider类。

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

allowed_domains = ['example.com']

start_urls = ['http://www.example.com']

def parse(self, response):

# 解析响应并提取数据...

pass

编写Parser

在parse方法中编写解析逻辑,提取Item中定义的数据。

def parse(self, response):

item = MyItem()

item['title'] = response.xpath('//h1/text()').get()

item['description'] = response.xpath('//p/text()').get()

return item

运行Spider

使用以下命令运行Spider:

scrapy crawl example

这里的example是Spider类中的name属性值。

存储爬取的数据

Scrapy支持多种方式来存储爬取的数据,包括JSON、CSV、XML等格式,也可以直接存储到数据库。

存储为JSON

scrapy crawl example -o output.json

存储为CSV

scrapy crawl example -o output.csv

中间件和Pipeline

Scrapy提供了中间件和Pipeline来处理请求和响应,以及处理Item。

中间件

在myproject/middlewares.py中定义请求和响应的中间件。

Pipeline

在myproject/pipelines.py中定义Pipeline,用于处理Spider返回的Item。

设置和配置

Scrapy的设置和配置可以在myproject/settings.py文件中进行。

高级用法

Scrapy还支持许多高级用法,如:

- 并发处理:使用

Scrapy的异步处理能力。 - 分布式爬取:结合

Scrapy-Redis实现分布式爬虫。 - API开发:使用Scrapy的Web API进行远程爬取。

- 动态内容处理:使用Selenium集成处理动态加载的内容。

总结

Scrapy是一个功能强大的爬虫框架,它提供了丰富的特性来简化爬虫的开发和维护。通过本文的介绍,你应该能够安装Scrapy、创建项目、定义Item、编写Spider、运行爬虫以及存储数据。Scrapy的学习曲线可能稍微陡峭,但一旦掌握,它将大大提高你的爬虫开发效率。

参考文献

- Scrapy官方文档:https://docs.scrapy.org/

- Scrapy GitHub仓库:https://github.com/scrapy/scrapy