本文是LLM系列文章,针对《The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits》的翻译。

1位LLM时代:所有大型语言模型都是1.58位

摘要

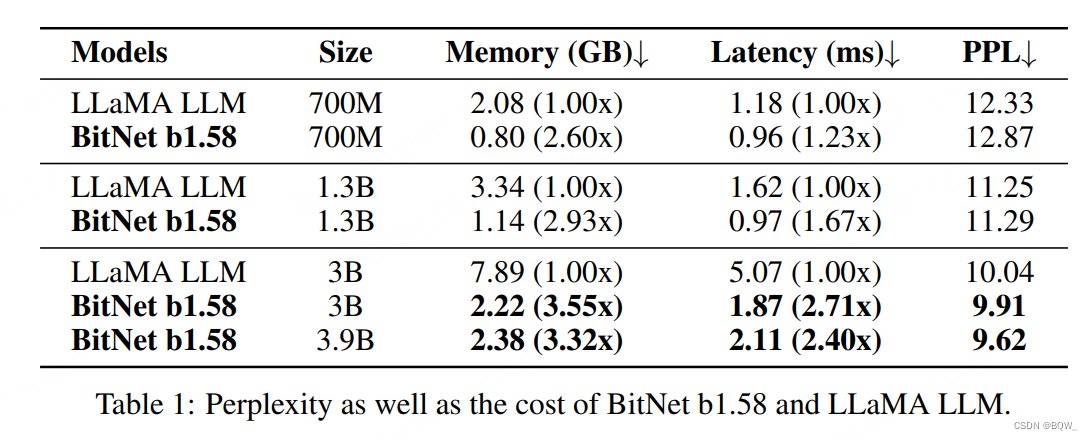

最近的研究,如BitNet,正在为1位大型语言模型(LLM)的新时代铺平道路。在这项工作中,我们引入了一个1位LLM变体,即BitNet b1.58,其中LLM的每个单个参数(或权重)都是三元{-1,0,1}。它在困惑和最终任务性能方面与具有相同模型大小和训练token的全精度(即FP16或BF16)Transformer LLM相匹配,同时在延迟、内存、吞吐量和能耗方面显著更具成本效益。更深入地说,1.58位LLM定义了一种新的缩放定律和配方,用于训练新一代的LLM,这些LLM既高性能又具有成本效益。此外,它实现了一种新的计算范式,并为设计针对1位LLM优化的特定硬件打开了大门。

![[<span style='color:red;'>BIZ</span>] - <span style='color:red;'>1</span>.金融交易系统特点](https://img-blog.csdnimg.cn/direct/6489c57a78dd4a3986cb1269c4e6dd2e.png)