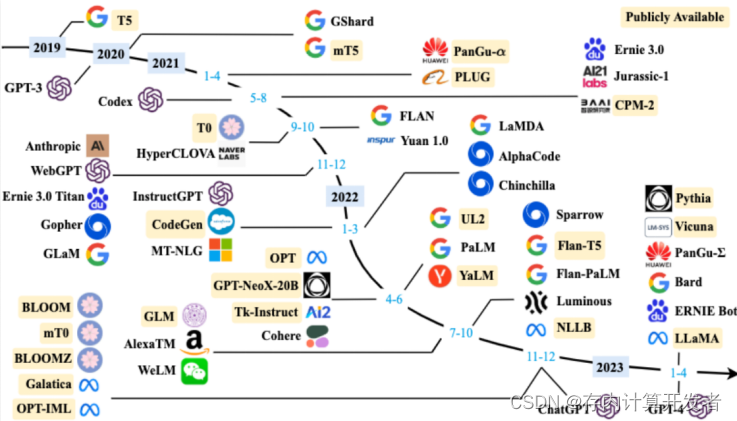

A Survey on Efficient Inference for Large Language Models

1.概述

论文分析并总结了如何提高大型语言模型(LLM)在推断阶段的效率。文中指出,尽管LLM在多种任务中表现出色,但它们在资源有限的环境中的部署却面临着由于模型大小、注意力机制的复杂性和自回归解码过程所带来的计算和存储成本的挑战。文章通过建立一个包含数据层面、模型层面和系统层面优化的全面分类体系,探讨了当前文献中的不同优化策略,并进行了一系列比较实验,以提供定量见解。最后,文中还总结了现有知识并讨论了未来的研究方向。

2.背景知识

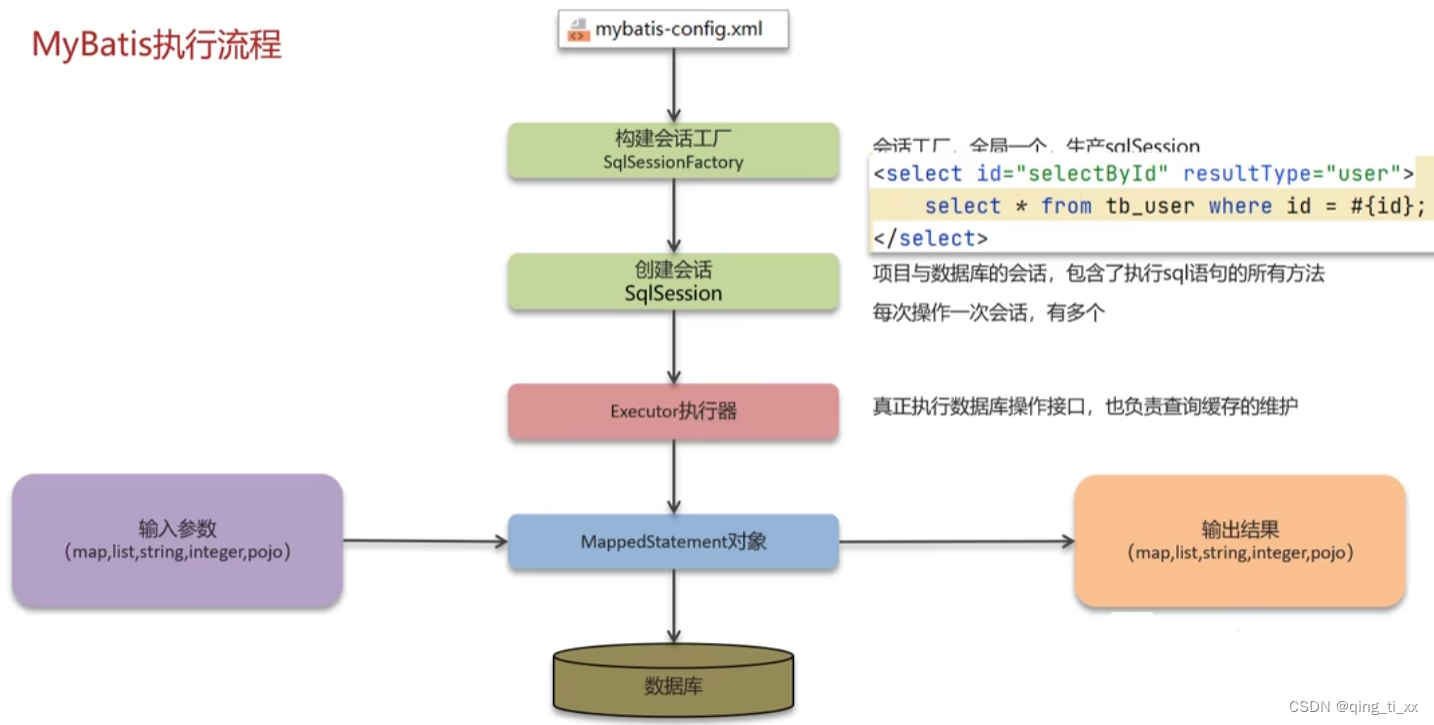

(1)Transformer

Transformer由注意力机制和FFN层构成,自注意力机制带来大量的计算量,计算复杂性随着输入长度的增加而呈二次方增长,而FFN层带来了巨大的参数量。

![[NSSCTF]prize_p1](https://img-blog.csdnimg.cn/direct/ce7aa1b1709d45859204557b7a9c99cb.png)