WebLlama是一个基于Meta Llama 3构建的代理,专门为了网页导航和对话进行了微调。它是由McGill University的自然语言处理团队开发的研究项目,旨在通过对话进行网页浏览的智能代理[1][2]。WebLlama的目标是构建有效的人为中心的代理,帮助用户浏览网页,而不是取代用户。它在WebLINX基准测试中超越了GPT-4V(零样本)18%,展示了其在网页导航任务中的卓越性能[1]。此外,WebLlama还发布了名为Llama-3-8B-Web的强大行动模型,进一步推动了基于Llama的代理程序的发展[5]。该项目提供了训练脚本、优化配置等资源,以便开发者能够轻松地训练、评估和部署Llama-3代理[9][10]。总的来说,WebLlama是一个旨在提升网页浏览体验的智能助手,通过与用户的连续对话互动,理解并执行用户的指令,以实现高效的人本化网页导航[6]。

WebLlama的具体技术架构和工作原理是什么?

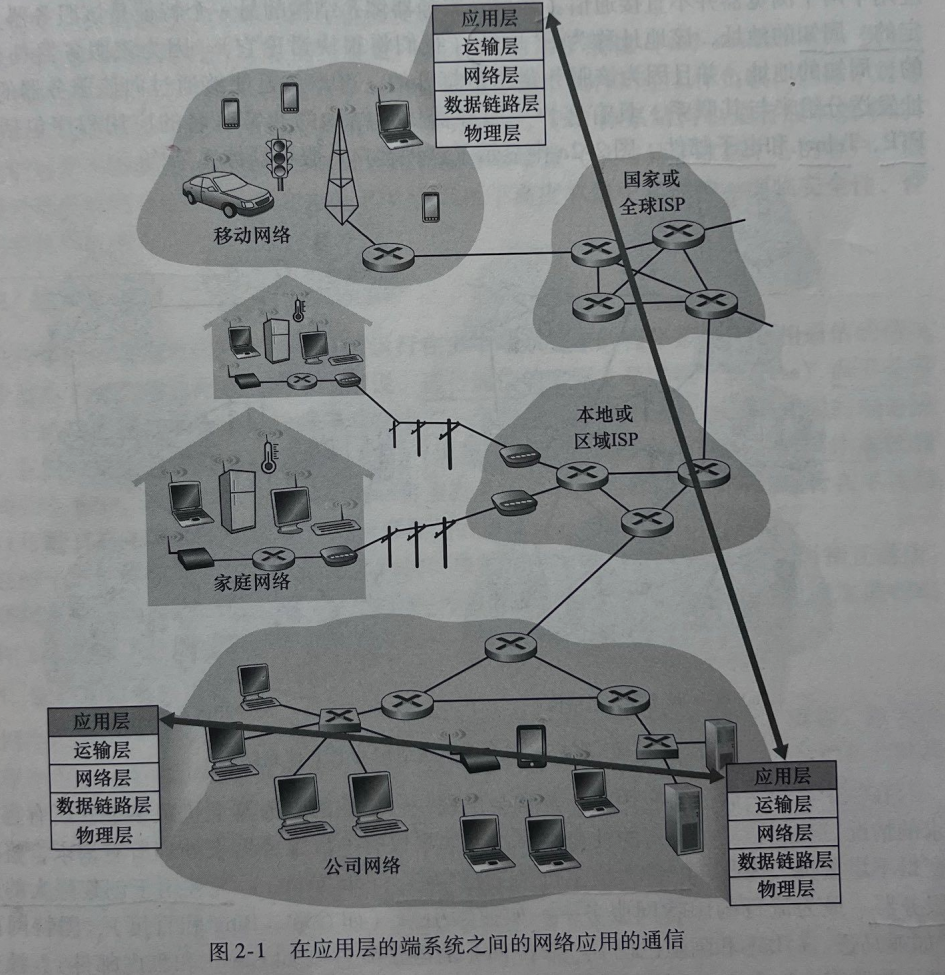

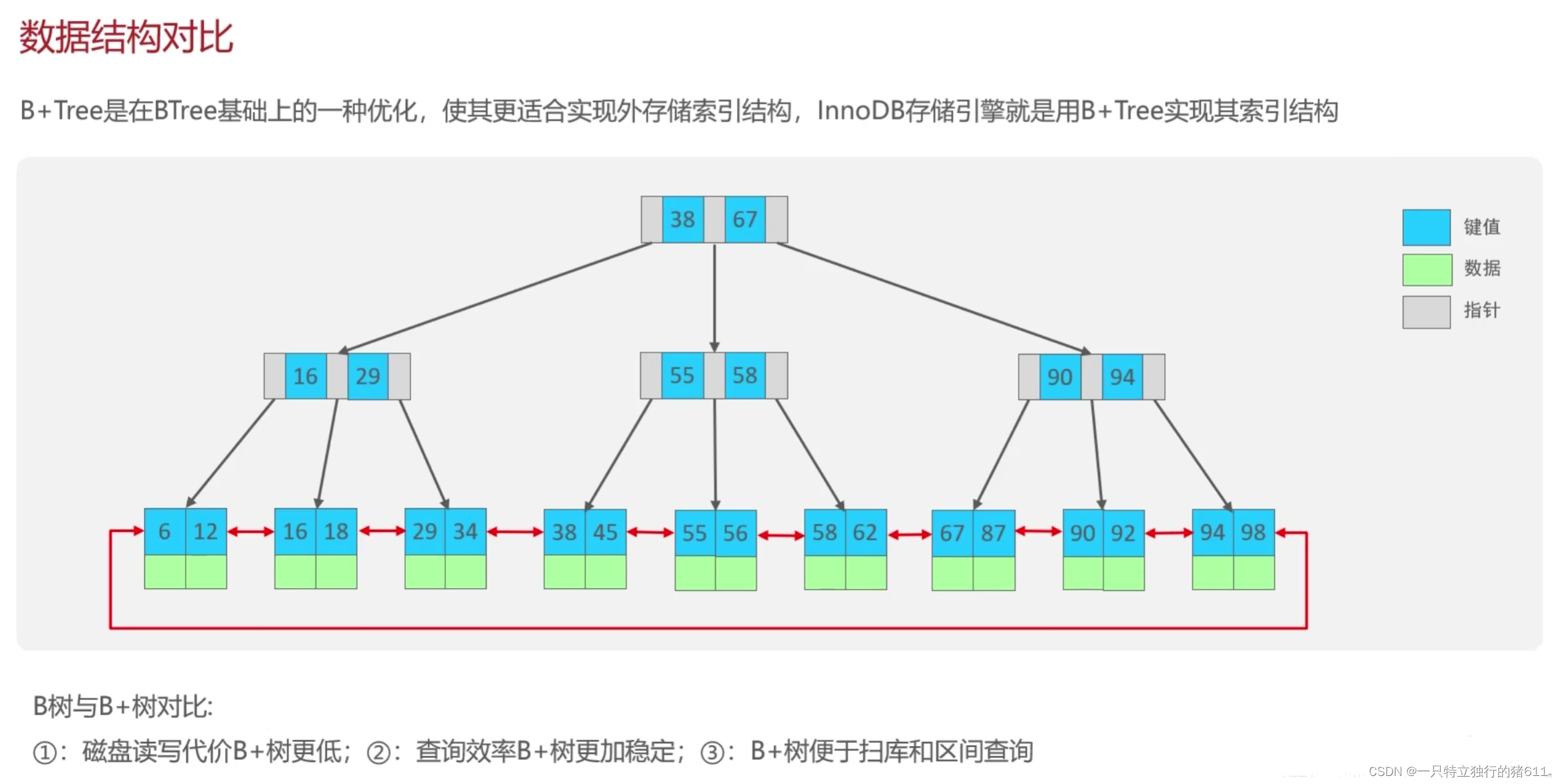

WebLlama的技术架构和工作原理主要基于Llama3模型,这是一个由Meta推出的开源大型语言模型。Llama模型能够通过大量文本训练,学会一些人类思维模式,预测下一个词,并且支持多种语言[14]。WebLlama利用这一模型的能力,实现了浏览网页、遵循指令等功能[12][16]。它采用Transformer解码器架构,具有分组查询的功能,这使得它能够处理连续的对话并听取用户的指令[17]。

这意味着WebLlama不仅仅是一个简单的浏览器或搜索引擎,而是一个能够理解用户指令并根据这些指令在互联网上进行有效导航的人工智能助手。

总结来说,WebLlama的技术架构和工作原理是基于Llama3模型的,利用Transformer解码器架构和分组查询功能,通过训练能够理解和执行网页导航任务的Llama代理,为用户提供一个能够遵循指令、浏览网页的人工智能助手。

WebLlama在WebLINX基准测试中的具体表现和超越GPT-4V的详细数据是什么?

WebLlama在WebLINX基准测试中的具体表现是超过了GPT-4V 18%[22]。WebLINX是一个大规模的基准测试,涵盖了2300个专家演示的100K次交互,这些交互覆盖了超过150个真实世界网站上的广泛模式,可以用来训练和评估在多样化场景中的代理[24][26]。尽管Llama 3是一个规模较小的模型,但它在大多数高级推理测试中表现出色,并且在遵循用户指令方面做得比GPT-4更好。Llama 3具有更小的上下文长度(8K个令牌),但展示了准确的检索能力[25]。

然而,证据中没有提供超越GPT-4V的具体数据细节,如超越的具体百分比、超越的领域或任务等。因此,我们只能确定WebLlama在WebLINX基准测试中整体上超越了GPT-4V 18%,并且在某些高级推理测试和遵循用户指令方面表现得更好,但缺乏具体的超越细节。

Llama-3-8B-Web行动模型与原版Llama模型有哪些主要区别和改进?

Llama-3-8B-Web行动模型与原版Llama模型相比,主要的区别和改进包括:

- 技术架构的改进:Llama 3采用了相对标准的仅解码器Transformer架构,并在Llama 2的基础上进行了关键改进[27]。这表明Llama-3-8B在技术架构上进行了优化,以提高性能。

- 训练数据量的增加:Llama 3基于超过15T token的训练,相当于Llama 2数据集的7倍还多[30]。这意味着Llama-3-8B能够处理和学习更多的信息,从而提高其理解和生成文本的能力。

- 支持更长的文本和更大的词汇量:Llama 3支持8K长文本,改进的tokenizer具有128K token的词汇量[30]。这一改进使得Llama-3-8B能够更好地理解和生成长篇幅的内容,同时能够处理更广泛的词汇。

- 性能的显著提升:根据Meta发布的测评报告,Llama-3-8B的性能优于之前的Llama-2-70B模型[29]。这表明即使是在参数较少的情况下,Llama-3-8B也能够实现更高的效率和更好的性能。

- 新能力范畴的引入:Llama 3引入了增强的推理和代码能力等新能力范畴[30]。这些新能力的加入,使得Llama-3-8B不仅在文本生成方面表现出色,也在逻辑推理和编程任务上展现了强大的能力。

- 训练效率的提高:Llama 3的训练效率比Llama 2高3倍[30]。这意味着在相同的时间内,Llama-3-8B能够完成更多的训练任务,从而更快地达到预期的性能水平。

- 新版信任和安全工具:Llama 3带有Llama Guard 2、Code Shield和CyberSec Eval 2的新版信任和安全工具[30]。这些工具的加入,提高了模型的安全性和可靠性,使其在实际应用中更加稳定和可信。

Llama-3-8B-Web行动模型相比于原版Llama模型,在技术架构、训练数据量、文本处理能力、性能、新能力范畴、训练效率以及安全性和可靠性等方面都有显著的改进和提升。

如何使用WebLlama训练脚本进行开发,包括必要的步骤和代码示例?

使用WebLlama训练脚本进行开发,首先需要了解WebLlama是一个基于Meta Llama 3技术的强大工具,它允许开发者通过Python代码轻松地利用Huggingface的transformers库加载并运行WebLlama模型,以处理特定的网页状态和执行模型建议的操作[37]。以下是进行开发的一些必要步骤和代码示例:

- 环境准备:确保你的开发环境中安装了Python以及必要的库。根据[36],你需要安装transformers库,可以通过以下命令安装:

pip3 install git+https://github.com/huggingface/transformers.git@main accelerate -i https://mirrors.cloud.tencent.com/pypi/simple

这里还提到了accelerate,这是一个用于加速训练的库,可以根据需要选择是否安装。

- 模型选择与加载:WebLlama提供了多种模型,包括通用的代码生成和理解(Code Llama)、专门为Python设计的模型(Code Llama - Python)以及遵循指令的安全模型(Code Llama - Instruct)[36]。你可以根据项目需求选择合适的模型。例如,如果你的项目是关于Python代码生成或理解,可以选择Code Llama - Python模型。

- 编写代码:使用Huggingface的transformers库加载选定的WebLlama模型,并编写代码来处理特定的网页状态或执行模型建议的操作。以下是一个简单的代码示例,展示了如何加载一个模型并使用它:

from transformers import pipeline

# 加载模型

model = pipeline("text-generation", model="webllama")

# 使用模型生成文本

response = model("你的输入文本")

print(response)

在这个例子中,我们使用了pipeline函数来加载一个名为webllama的模型,然后将输入文本传递给模型,最后打印出模型生成的文本响应。

- 本地部署与量化:如果你需要在本地部署WebLlama模型或者对模型进行量化以提高效率,可以参考官方发布的相关教程和指南。虽然具体的部署和量化步骤没有在我搜索到的资料中详细说明,但通常这涉及到配置服务器环境、调整模型参数等操作。

- 跟踪Github趋势:为了更好地利用WebLlama进行开发,你可以跟踪相关的Github仓库,如McGill-NLP / webllama项目[35]。这些项目可能提供了更多的资源、示例代码和开发教程,帮助你更深入地理解和使用WebLlama。

总之,使用WebLlama训练脚本进行开发需要准备适当的开发环境,选择合适的模型,编写代码来实现特定的功能,并可能涉及到模型的本地部署和量化。通过参考相关的文档和社区资源,你可以更有效地利用WebLlama进行自动化网页浏览或其他开发任务。

WebLlama在实际应用中的用户体验和效果评价是怎样的?

WebLlama在实际应用中的用户体验和效果评价主要体现在以下几个方面:

- 技术层面的改进:Llama-2相比前代模型Llama-1,在技术层面进行了多项改进,包括使用Group-Query-Attention (GQA)提高模型推理效率,语境长度增加,预训练语料量增加,以及在监督微调阶段注重数据集质量等,这些改进带来了性能、推理效率以及安全性的有效提升[38]。

- 性能对比:LLaMa模型在参数量较小的情况下,其性能在多个基准测试中优于或可媲美大型模型如GPT-3、Chinchilla-70B和PaLM-540B。例如,130亿参数的LLaMA模型在解释笑话、零样本分类和代码生成等任务上胜过参数量达1750亿的GPT-3[39][42]。

- 用户体验:有用户分享了对LLaMA-2 fine-tuning的使用体验,认为过程简单,但同时也提到了过多的RLHF(Reinforcement Learning from Human Feedback)可能会带来一些问题[40]。

- 应用场景:WebLlama被设计为一个智能网页浏览代理,基于Llama-3-8B模型,旨在提供高效的以人为本的Web浏览体验。

WebLlama在实际应用中展现出了良好的技术改进和性能表现,尤其是在模型推理效率、安全性以及与人类交互的能力方面。然而,用户体验方面的具体反馈较为有限,且存在一些关于过度使用RLHF可能带来的负面影响的讨论。总体来看,WebLlama作为一个基于Llama模型的智能网页浏览代理,其发展前景被看好,但仍需进一步的实际应用和用户反馈来全面评估其用户体验和效果。

参考资料

1. WebLlama: 人性化网页导航和对话代理工具 - AICMTY [2024-04-28]

2. WebLlama:基于Llama-3-8B 能通过对话进行网页浏览的智能代理 [2024-04-27]

3. WebLlama使用入口地址Ai模型最新工具和软件app下载 - AIbase

4. rohanpaul_ai(@rohanpaul_ai):Llama-3-8B-Web是一个行动模型 ... [2024-04-24]

5. WebLlama:基于Llama的Web智能助手新进展 - DataLearner AI [2024-04-25]

6. WebLlama:基于Llama-3-8B的智能网页浏览代理 - 站长网 [2024-04-29]

7. webllama.github.io - ️ WebLlama

9. webllama McGill-NLP - MyGit [2024-04-20]

10. Llama-3-8B-Web: How to Connect Llama to the Web

11. 更强的Llama 2开源,可直接商用:一夜之间,大模型格局变了 [2023-07-19]

14. Llama 模型初学者指南 - 智源社区 [2023-08-19]

22. 在MMLU上得分75.3,接近70B的SOTA模型;资讯:对话蚂蚁 ...

25. Llama 3 vs GPT-4: Meta Challenges OpenAI on AI Turf - Beebom [2024-04-20]

26. WebLINX Dataset | Papers With Code

27. 全球最强开源大模型Llama 3重磅发布:深度解析与展望 - 知乎 [2024-04-19]

29. Llama3-8B到底能不能打?实测对比 - 知乎 - 知乎专栏 [2024-04-22]

30. 开源大模型Llama 3王者归来!最大底牌4000亿参数,性能直逼GPT-4 | 机器之心 [2024-04-19]

32. Llama-3-8B and Llama-3-70B: A Quick Look at Meta's Open Source LLM ... [2024-04-21]

33. Llama3 (8B/70B/400B) 技术细节 & 亮点分析 - 知乎 - 知乎专栏 [2024-04-18]

34. 大佬出走后首个发布!Stability官宣代码模型Stable Code ...

35. 毕业设计-使用GithubActions跟踪Github趋势项目.zip资源

36. LLM系列 | 22 : Code Llama实战(下篇):本地部署、量化及GPT-4对比 - 知乎

37. WebLlama是一个强大的工具,利用Meta Llama 3的最新技术 ...

38. Llama-2首个全方位评测,国内外开源模型大比拼 - 知乎

39. 聊聊Meta开源的LLaMa到底如何 - 知乎 - 知乎专栏

40. Meta 发布开源可商用模型 Llama 2,实际体验效果如何? - 知乎 [2023-07-18]

41. 新一代旗舰端侧模型:面壁MiniCPM 2.0 发布

42. Meta开源的LLaMA性能真如论文所述吗?如果增加RLHF,效果会提升吗? [2023-03-08]

43. Playground发布最新文生图模型v2.5 提升人像细节