Meta Llama 3(8B) Instruct model performance

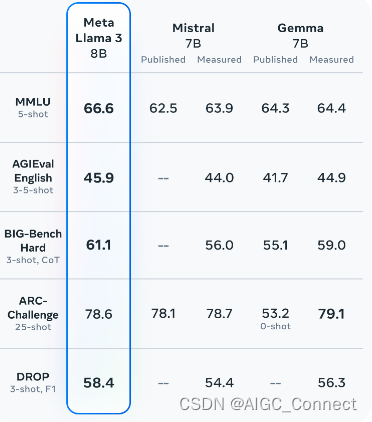

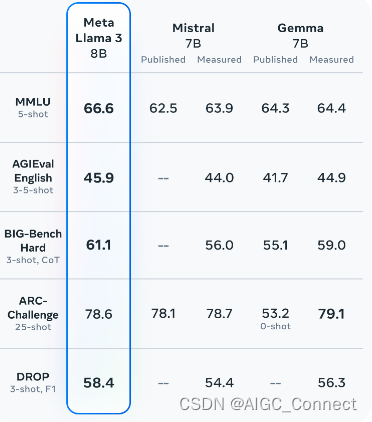

Meta Llama 3(8B) Pre-trained model performance

使用 Ollama 运行 Llama3

访问 Tags · llama3,选择你想运行的模型,例如,8b-instruct-q8_0

拷贝并运行命令,ollama run llama3:8b-instruct-q8_0,

访问 Tags · llama3,选择你想运行的模型,例如,8b-instruct-q8_0

拷贝并运行命令,ollama run llama3:8b-instruct-q8_0,