ollama-在线安装,运行速度相当不错

环境

系统:CentOS-7

CPU: 14C28T

显卡:Tesla P40 24G

驱动: 515

CUDA: 11.7

cuDNN: 8.9.2.26

安装

curl -fsSL https://ollama.com/install.sh | sh

等待下载

下载运行模型

ollama run qwen:0.5b-chat-v1.5-q4_1

国内也可以下载的

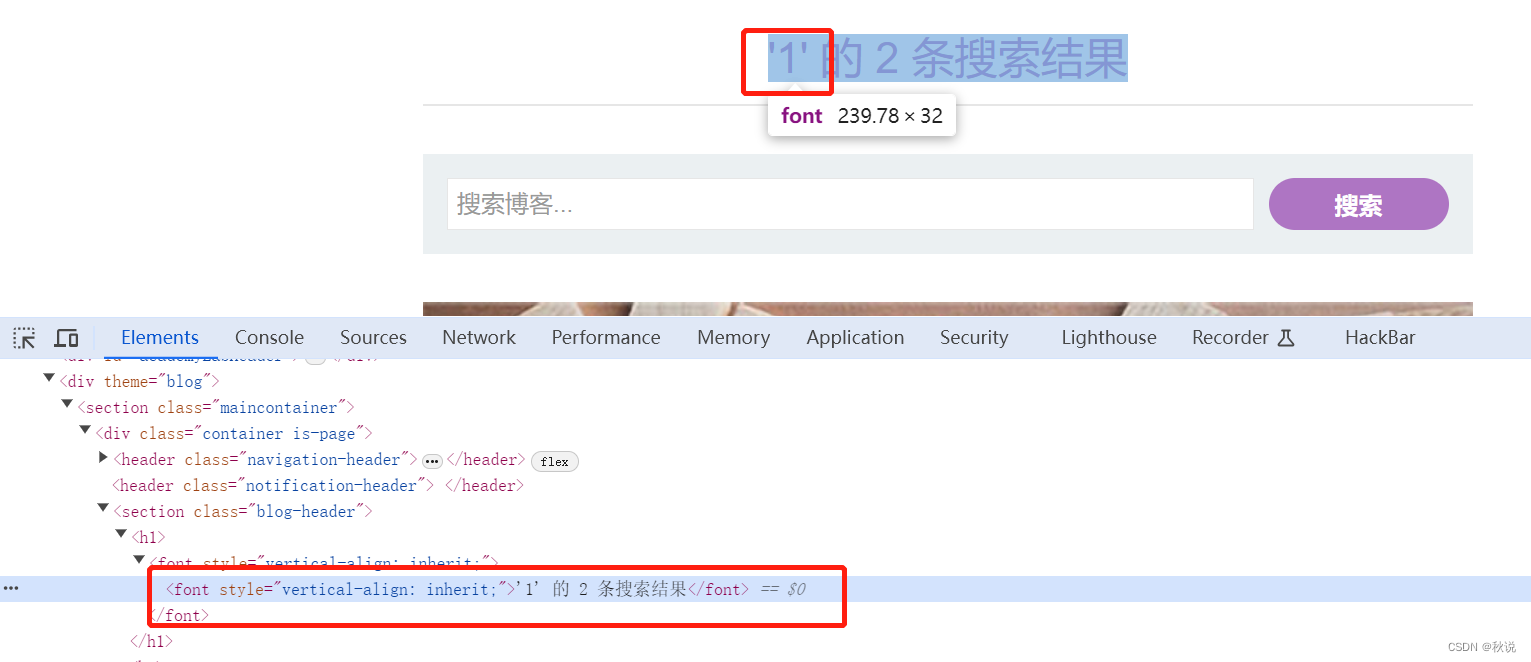

看到如下内容

success

>>>

可以输入对话内容了

比如

介绍自己

open-api请求

curl http://localhost:11434/api/chat -d '{

"model": "qwen:0.5b-chat-v1.5-q4_1",

"messages": [

{ "role": "user", "content": "介绍一下北京景点?" }

]

}'

curl http://localhost:11434/api/generate -d '{

"model": "qwen:0.5b-chat-v1.5-q4_1",

"prompt":"介绍一下北京景点?"

}'

性能

1C2G服务器上运行qwen0.5b-v1.5速度超快,1.8B就不行了很慢,如何升级更高

4c8G服务器上运行

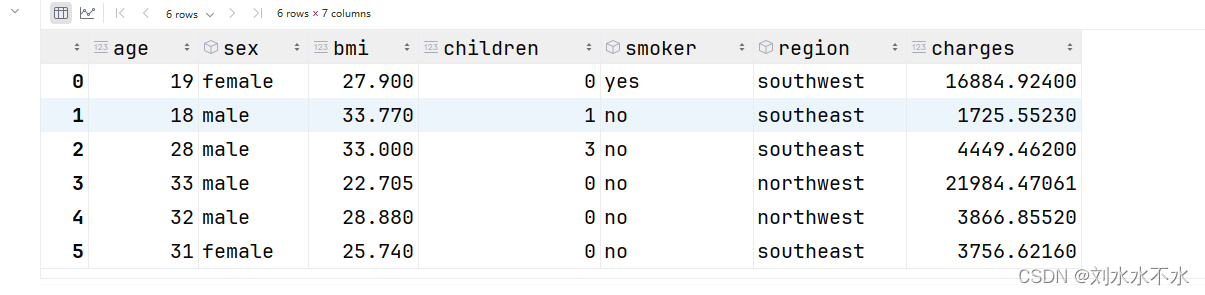

模型版本信息获取

https://ollama.com/library

可以在这里找打所有模型,并查看指定版本命令