大语言模型的提示词

随着ChatGPT等大语言模型的问世,我们获取知识的方式从单一的搜索引擎如Google转变为类似ChatGPT这种通过 Q & A 方式提供的方法。

我们尝试对比一下不同提示词,对应的模型输出

ChatGPT无提示词

API: ChatGPT 3.5

Prompt: Please give a simple explanation of Transformer in LLM.

Answer:

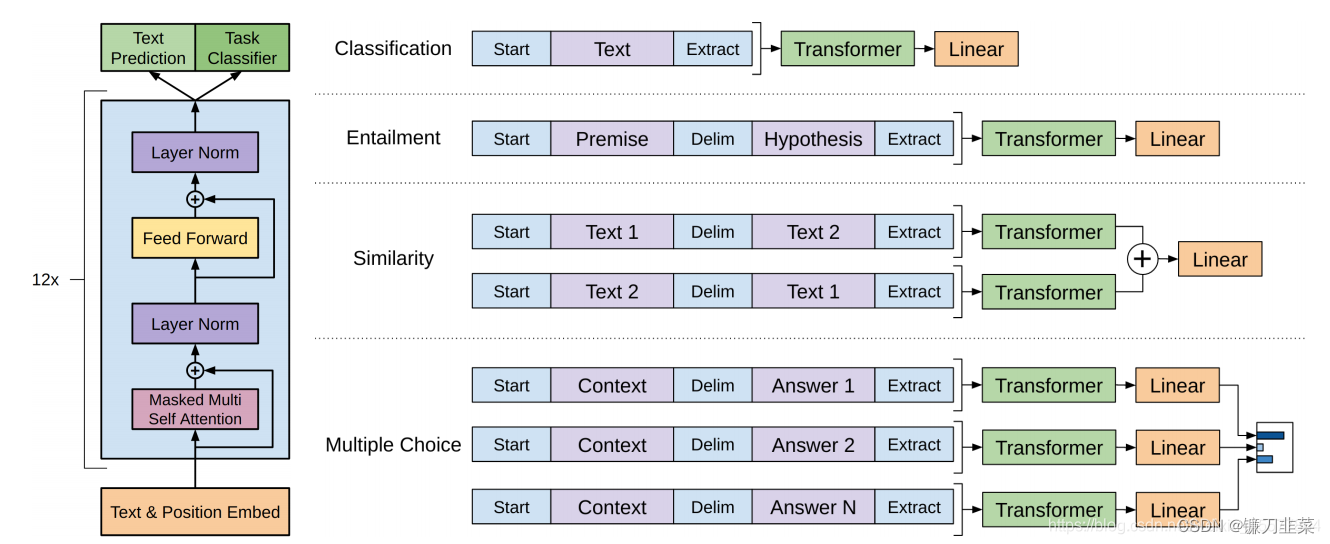

Sure! In a Language Model like the one I'm based on, a Transformer is a powerful neural network architecture specifically designed for processing sequential data, like sentences or paragraphs. It's particularly good at tasks involving understanding and generating text.

Here's a simple breakdown:

1. **Attention Mechanism**: Transformers use an attention mechanism that allows them to focus on different parts of the input text. This means they can weigh the importance of each word or token in the context of the entire input sequence.

2. **Self-Attention**: This is a special type of attention where the model can relate different words to each other within the same input sequence. It helps the model understand dependencies and relationships between words.

3. **Layers of Transformers**: Transformers consist of multiple layers stacked on top of each other. Each layer processes the input data independently before passing it on to the next layer. This hierarchical structure allows the model to learn complex patterns and representations of the input text.

4. **Feedforward Neural Networks**: In addition to the self-attention mechanism, each layer of the Transformer also includes feedforward neural networks. These networks help the model capture non-linear relationships and further refine the representations of the input text.

5. **Positional Encoding**: Since Transformers process sequences of tokens without any inherent notion of order, positional encoding is used to provide information about the position of each token in the sequence. This allows the model to understand the sequential nature of the data.

Overall, Transformers have proven to be highly effective in various natural language processing tasks such as language translation, text summarization, and sentiment analysis, among others. They've become a cornerstone in the field of deep learning for natural language understanding and generation.

现在我们尝试优化LLM(大语言模型)的输出质量:调整提示词

ChatGPT-优化提示词-简化输出

Requirement: 我希望可以对transformer模型更简单的输出

Prompt: Please give a brief explanation of the Transformer in LLM. The

answer has only 50 words.

Answer:

The Transformer in a Large Language Model (LLM) is a neural network architecture optimized for processing sequential data like text. It employs self-attention mechanisms to weigh the importance of words and layers of transformers to capture complex patterns. This enables effective natural language understanding and generation tasks.

DALL E 未优化提示词

API: ChatGPT Plus会员中集成的DALL · E模型

Prompt: A mouse running on the desert.

DALL E 优化提示词

我们尝试加上一些形容词和细节描述,例如:可爱的、穿着帽子、毛衣

Requirement: More information of the mouse

Prompt: A cute mouse running on the desert wearing a knitted hat and

sweater.

总结

我们发现通过给LLM详细的要求和更多的细节信息,LLM输出的质量明显提高。但是,这个过程通常是我们手动完成的。如果能够让这个过程 自动化,那将更加强大和高效。

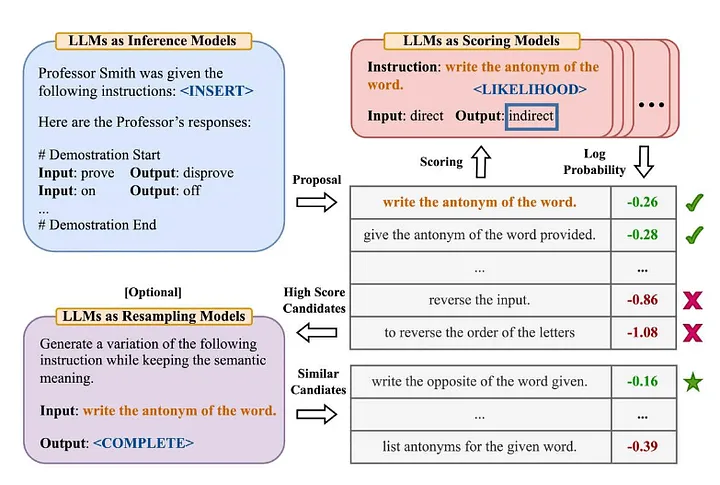

如何自动优化提示词?

我们首先尝试将手动优化的提示词进行 数学表示 ,这为机器学习模型中参数的自动调整铺平了道路。提示词的参数化,通过符号 ( p ) 表示,使得原本固定的文本片段变成了动态可调的输入变量。这样的表示不仅增加了操作的灵活性,还为在机器学习模型中自动调整这些参数提供了可能。

为了精细控制这些提示词,我们引入了 “提示空间”(Prompt Space ( Λ ))的概念,其中汇集了所有可用于提示的词或短语。在这个多维空间中,我们不仅考虑了选择最优的离散单词,还探讨了如何在连续的维度上调整参数,以精细调校模型的反应。实际上,连续参数的调整在模型的嵌入空间中找到了应用,允许我们微调模型对不同上下文的敏感性,而离散参数则直接对应于具体的提示词选择。

借助这种表示,机器学习算法可以在训练过程中自动调整提示参数,以达到提升模型性能的目的。无论是零阶梯度方法、策略梯度方法还是贝叶斯优化,这些算法都可以在该框架下应用,来探索最优的提示参数设置。通过这种方式,我们能够将原本依赖于直觉和试错的手动提示词优化转变为一个 精确且高效的自动化过程。

为什么要在多维度中调整参数?

多维度中的参数调整反映了提示词在嵌入空间中的表示。在机器学习模型,尤其是自然语言处理中,单词或短语通常被映射到高维空间(即嵌入空间),其中每个维度捕捉不同的语言特征或上下文含义。通过调整这些嵌入向量中的数值,我们可以微调提示词对模型的影响,以期提高模型的性能。多维度调整也允许我们利用复杂的非线性关系,来优化提示词的选择和组合。提示空间是什么?

提示空间是一个概念上的空间,包含了所有可能用于提示的词或短语。在这个空间中,每个维度都代表一个可能的提示词或属性,而在连续空间中,每个维度代表一个属性或语义特征的程度。提示空间的主要功能是提供一个结构化的方法来探索和选择最有效的提示词组合,无论是通过直接选择特定的词,还是通过优化在连续空间中的表示。机器学习算法可以在这个空间中搜索最优提示,以改善模型的性能。连续变量如何在实际中应用?

在实际操作中,连续变量通常指的是在高维嵌入空间中的位置,可以通过微调这些连续变量来改变模型的行为。例如,改变某个嵌入向量中的值可能会影响模型对特定上下文的理解。而离散变量通常对应具体的单词或短语,在选择提示词时直接作为候选集。

引入损失函数

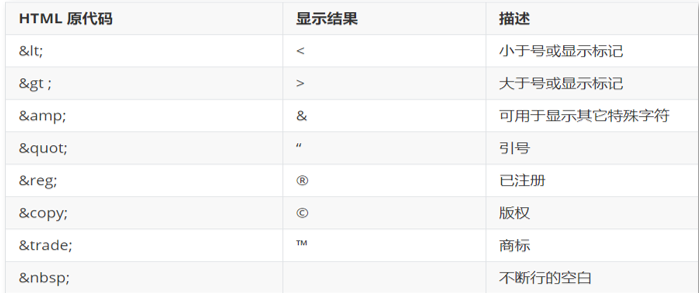

损失函数 (Loss):

- 这是评估模型输出与真实标签之间差异的函数,根据问题任务而定。在这里,例如提到的01损失(0-1 loss),是一种特别的损失函数,当预测正确时损失为0,预测错误时损失为1。

- 对于每个句子,我们有一个正确的标签,这是评估损失的基准。

目标函数 (Objective Function):

- 实证风险 ( ) 表示为所有样本损失的平均值,是损失函数对所有数据点的应用结果的平均。

- 这里的目标函数是通过最小化这个实证风险来优化的。

提示学习 (PL):

- 提示学习的目标是优化目标函数,即找到参数 ( p ) 的最优值,这样可以使得损失函数值最小化。在提示空间 ( Λ ) 中,我们寻找可以最小化实证风险的参数 ( p )。

在自动优化提示词的探索过程中,我们不仅需要考虑提示词的选择和参数化,而且需要关注模型性能的具体评价方式。为此,引入损失函数(Loss)成为了衡量性能的关键。损失函数 L ( p , x i , y i ) L(p, x_i, y_i) L(p,xi,yi) 对于每个句子 ( x_i ) 和其对应的真实标签 ( y_i ),评估了给定提示词参数 ( p ) 时模型输出的准确性。例如,01损失是一种特殊的损失函数,它在模型的预测错误时赋予损失值1,在正确时赋予0。

定义目标函数

接下来,为了优化模型性能,我们定义了目标函数(Objective Function),通常是实证风险 L ( p ) \mathcal{L}(p) L(p)它是对 所有样本损失函数值的平均 。通过最小化实证风险,我们可以使模型对于所给数据和任务表现更好。

这导向了提示学习(Prompt Learning, PL)的核心目标:优化目标函数 min p ∈ Λ L ( p ) \min_{p \in \Lambda} \mathcal{L}(p) p∈ΛminL(p)这一优化过程涉及到在提示空间中搜索那些能够 最小化实证风险的提示词参数 。通过这种方式,我们可以使用机器学习算法来自动发现和调整那些最能提高模型预测性能的提示词。

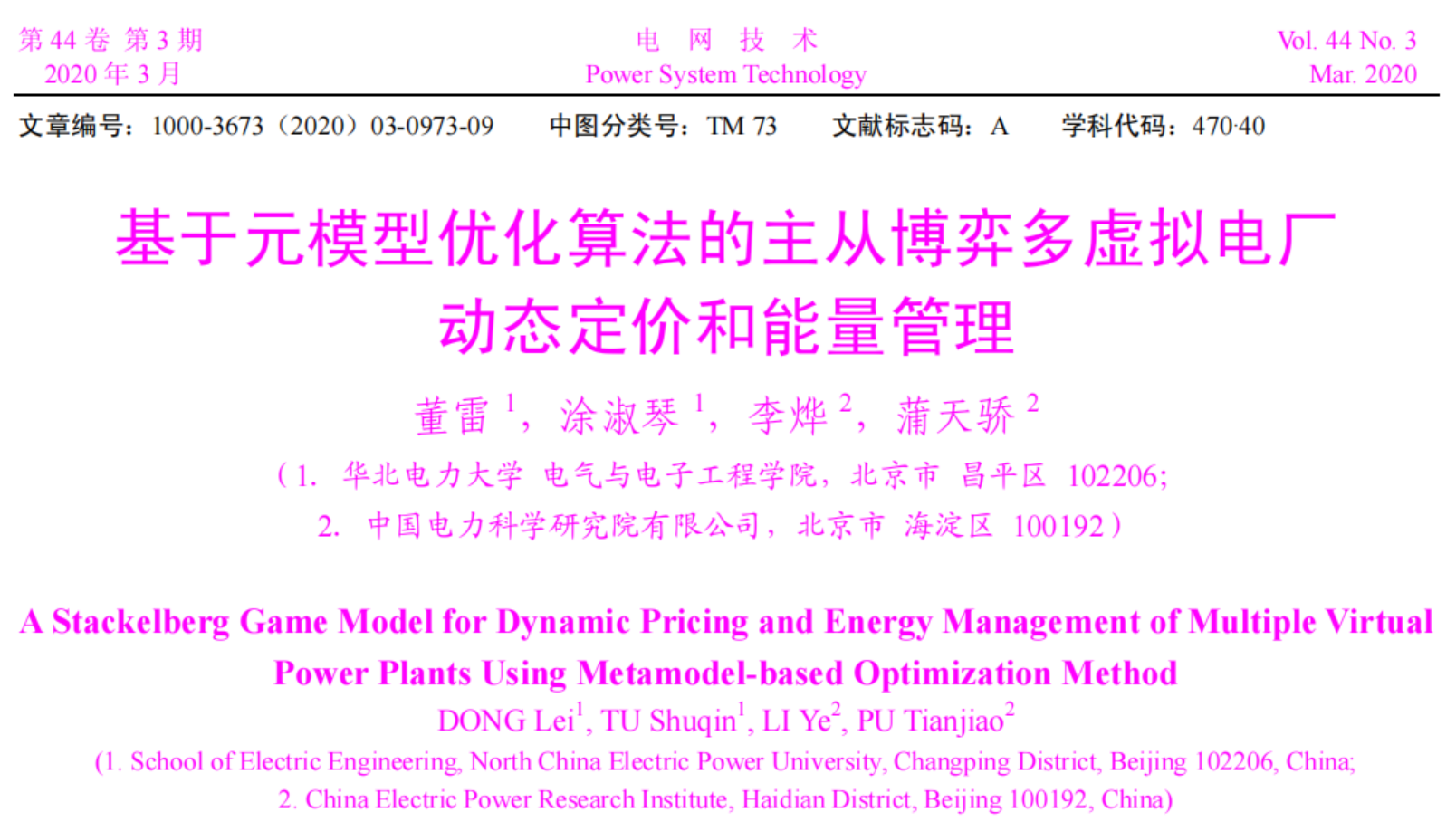

在我们对于如何优化提示词的自动化过程中,一个自然而然的扩展是 微调预训练语言模型(PLM) ,使其在特定任务上性能更优。PLM,作为大型语言模型(LLM)的实际应用实例,已经在广泛的下游任务中显示出其多功能性和强大的适应能力。

针对具体任务进行微调

当我们希望提升预训练模型(如GPT或BERT)在特定任务上的性能时,我们需要采取“微调”(Fine-tuning)的策略。这意味着我们需要调整整个模型的参数,以便更好地适应任务的特性。微调过程涵盖以下关键点:

使用任务特定数据进行调整:微调模型通常要求有大量的任务 特定标注数据 。这些数据使模型能够学习和适应任务特有的模式和特征。

调整模型参数:在微调阶段,模型的权重会根据任务特定数据进行调整。这不仅涉及到提示词的选择和优化,还包括对模型本身参数的优化,以提高任务的准确性。

学习任务特定的模式:通过这种精细的调整,模型能够识别出任务相关的细微模式,从而在执行任务时展现出更高的性能。

在实践中,微调涉及对模型进行额外的训练周期,使用如交叉熵损失函数来指导参数的更新,以便更好地预测任务特定数据的标签。通过这个过程,预训练模型可以转变为一个高度定制化的工具,专门针对我们的任务进行优化。

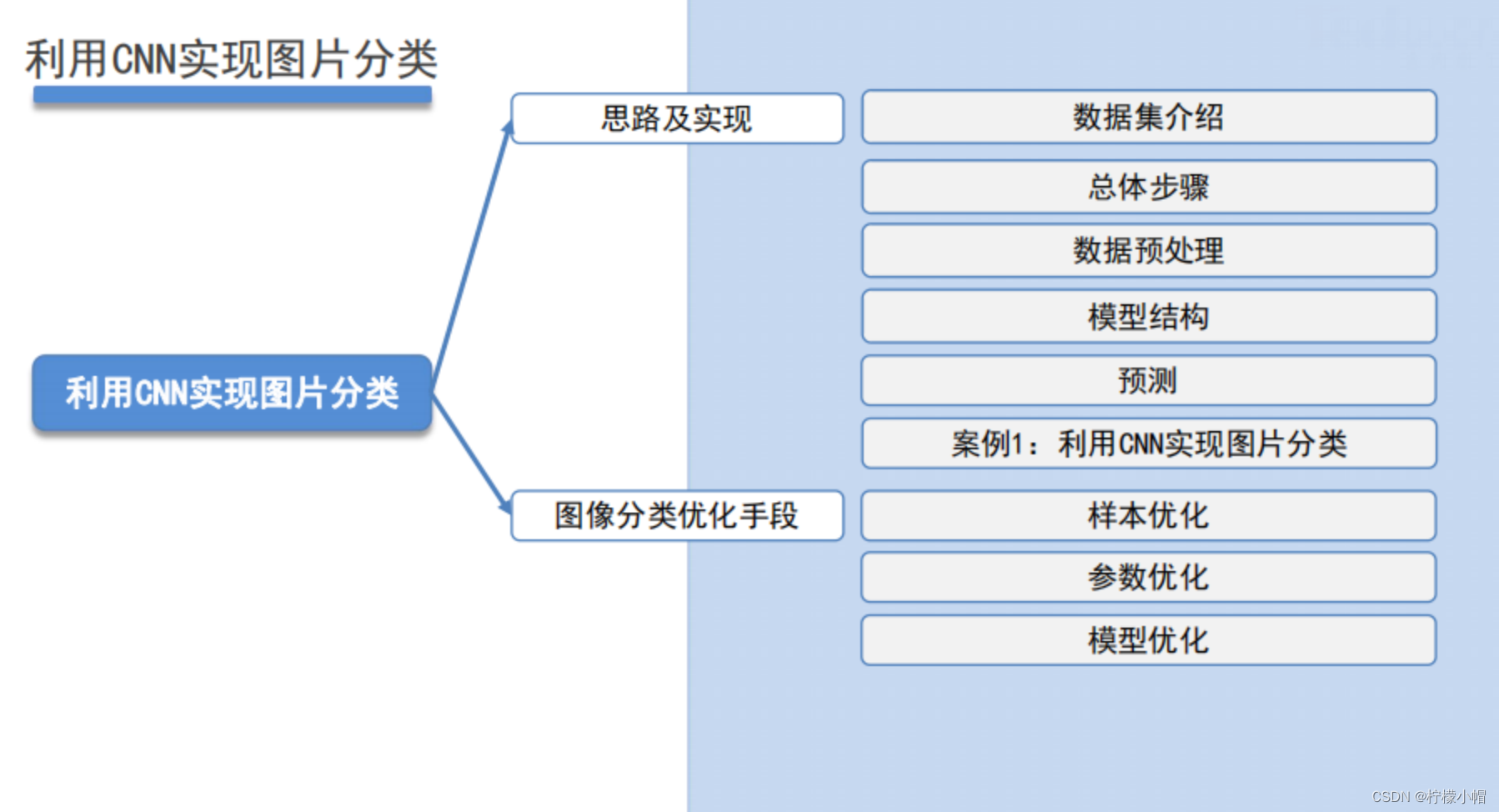

在LLM中进行提示学习

微调方法虽然有效,但通常需要大量的任务特定标注数据来重新训练模型的所有参数。而 提示学习(Prompt Learning) 提供了一种更灵活的替代方案。在提示学习中,我们不是调整模型的所有参数,而是改变输入给模型的提示词,从而引导模型的行为。这种方法的优点包括:

- 任务设计的灵活性:通过修改提示词的设计,我们能够生成特定于任务的输出,而不需要对整个模型进行广泛的重训练。

- 适应多样化任务的能力:提示学习通过使用特定的提示词来适应多种任务,无需大量任务特定数据。

在某些情况下,当我们面临标注数据 有限 或需要模型 快速适应 新任务的情况时,提示学习尤为有用。

黑盒优化

在实现了自动化的提示词优化后,我们面临的下一个挑战是如何将这些技术应用于实际环境,尤其是在我们无法直接访问或调整模型参数的情况下。这种情况在商业API的应用中非常普遍,我们必须在不了解模型内部机制的情况下,依赖模型对我们输入的响应来进行优化。这引出了一个新的领域——黑盒优化。

在自动化优化提示词的背景下,黑盒优化的目的是:

提高模型输出质量:自动发现和调整能够生成最佳输出的提示词,而不需要人工干预,从而使模型的输出更加精确和有用。

降低使用门槛:自动化的过程减少了用户需要理解和操作模型的复杂性,使得非专家用户也能有效利用先进的技术。

加速任务适应性:快速找到最佳的提示词可以帮助模型迅速适应新的任务和数据类型,特别是在数据受限的情况下。

提高效率:减少了手动调整提示词所需的时间和努力,自动化优化能够快速迭代并找到最优解。

在商业API的情况下,我们通常只能控制输入(提示词)和观察输出,因此自动化的黑盒优化变得尤为重要,它通过智能算法调整输入来尝试改善输出。这不仅对于终端用户来说是减少了学习成本,也为开发者提供了更为强大的工具,以便更好地集成和利用大型语言模型,提供更加优质的服务。

面对黑盒优化的挑战

当模型作为商业API提供服务时,通常我们只能通过API进行查询和获取输出,无法接触到模型的内部工作。在这种情况下,提示学习就变成了一种 黑盒优化问题,我们的目标是找到能够产生最佳响应的提示词。

这种黑盒优化带来了特殊的挑战:

- 我们只能观察到模型对于不同提示词的响应,而没有更深入的模型内部机制的了解。

- 需要设计智能算法来探索最佳提示词,这可能涉及到复杂的搜索策略和优化技术。

结论

综合了自动化提示词优化和面对黑盒优化挑战的策略,我们不仅可以提高大型语言模型在理想条件下的表现,也可以在数据受限和无法访问模型内部时,通过智能地调整输入来提升性能。在深入了解模型内部结构并不可行的商业应用中,黑盒优化成为了一个不可或缺的工具,它允许我们在实际环境中有效地利用复杂的机器学习模型。尽管这一路径充满挑战,但它也潜藏着通过创新方法解锁模型潜力的巨大机会。

疑问

问题一:怎么确保模型生成的提示词就是优化好的?而不会更差呢?

确保模型生成的提示词经过优化且不会退化到更差的表现,主要依赖于监督学习的方法。在监督学习中,我们使用带标签的数据来训练模型。这意味着对于每个输入(例如,文本提示或问题),我们已经知道期望的输出(正确的回答或结果)。这样的训练方法使得我们能够比较模型的预测输出与真实的标签,从而评估模型的性能。

训练和优化过程

损失函数: 在训练模型时,我们定义一个损失函数来衡量模型的预测输出与真实标签之间的差异。损失函数的选择直接影响到优化的方向和效果。例如,如果我们使用0-1损失,模型将被激励去减少分类错误的数量。

优化算法: 使用如梯度下降等优化算法来调整模型参数,目标是最小化损失函数。在提示学习中,这可能涉及调整输入提示的结构或内容,以使模型输出尽可能接近于目标标签。

验证和测试: 除了训练数据外,还应使用独立的验证集和测试集来评估模型的泛化能力。这些独立数据集帮助我们理解模型在未见过的数据上的表现,从而检验其实际效用。

确保优化的有效性

过拟合监控: 在训练过程中,需要小心监控模型是否过度学习训练数据的特点而忽视了泛化能力。使用诸如交叉验证等技术可以帮助识别过拟合。

超参数调整: 模型的性能通常依赖于多个超参数的选择(如学习率、批处理大小、模型结构的深度和宽度等)。调整这些参数至关重要,以确保模型达到最佳性能。

绩效评估指标: 选用适当的评估指标(如准确率、召回率、F1分数等)来全面评估模型的性能,确保优化结果不仅限于训练数据,也适用于广泛应用。

自动化和反馈循环

通过机器学习算法自动调整提示词,我们可以设置一个反馈循环,通过不断的实验和调整,找到生成最佳模型输出的提示词。这一过程可以是动态的,模型基于新数据不断学习和适应,从而优化其性能。

![[lesson58]类模板的概念和意义](https://img-blog.csdnimg.cn/direct/c8504f9b8a054f8587d075f73a19473d.png#pic_center)