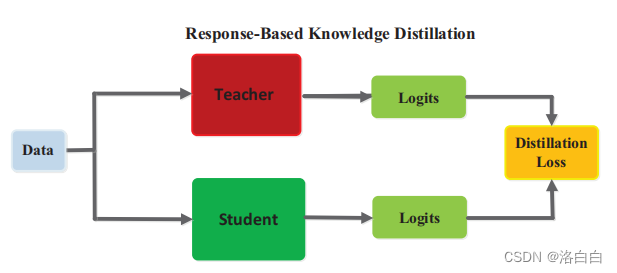

知识蒸馏(Knowledge distillation)是一种模型压缩技术,旨在将一个复杂的模型(通常称为“教师模型”)的知识转移给一个较简单的模型(通常称为“学生模型”),以降低模型的计算复杂度和存储需求,同时保持模型的性能。

这个过程通常可以分为以下几个步骤:

- 训练教师模型: 首先,使用大量的数据和计算资源来训练一个复杂的模型,例如深度神经网络,以解决特定的任务。

- 利用教师模型指导学生模型: 接下来,使用教师模型来指导学生模型的训练。通常,学生模型的架构比教师模型简单,拥有更少的参数和计算量。学生模型尝试模仿教师模型的输出,以便在尽可能保持性能的情况下减少复杂度。

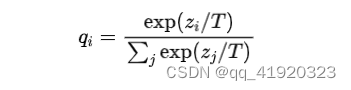

- 设计目标函数: 在知识蒸馏中,通常会设计一个包含两部分的目标函数。一部分用于衡量学生模型的预测结果与教师模型的预测结果之间的相似度,另一部分用于传统的损失函数,如交叉熵,用于衡量学生模型在任务上的性能。

- 训练学生模型: 最后,使用标注数据来训练学生模型,优化设计的目标函数。在训练过程中,学生模型会尝试在两个方面取得良好的表现:与教师模型的输出相似度和任务性能。

知识蒸馏可以应用于各种深度学习任务,包括图像分类、目标检测、语义分割等,以减少模型的计算和存储开销,提高模型在资源受限环境下的可部署性。