iclr 2024 oral reviewer评分 5668

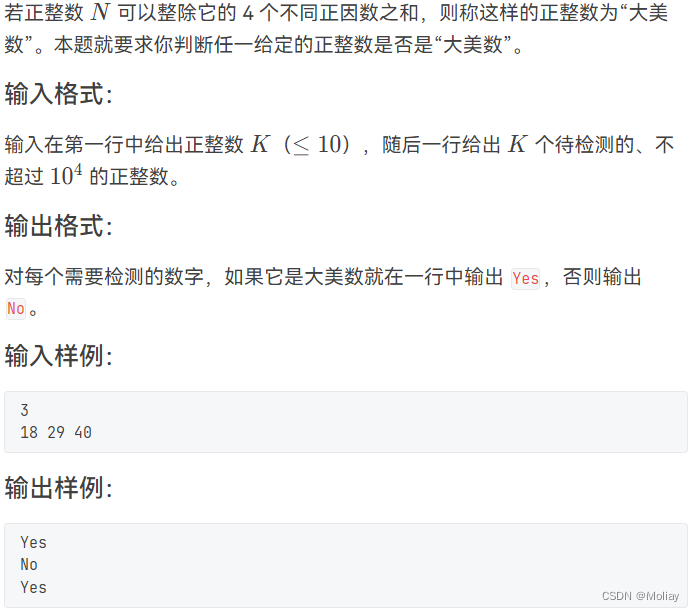

- 现有的语言模型(LMs)的基准测试已经饱和,无法捕捉到最先进的语言模型能做什么和不能做什么的前沿。

- ——>要具有挑战性的基准测试

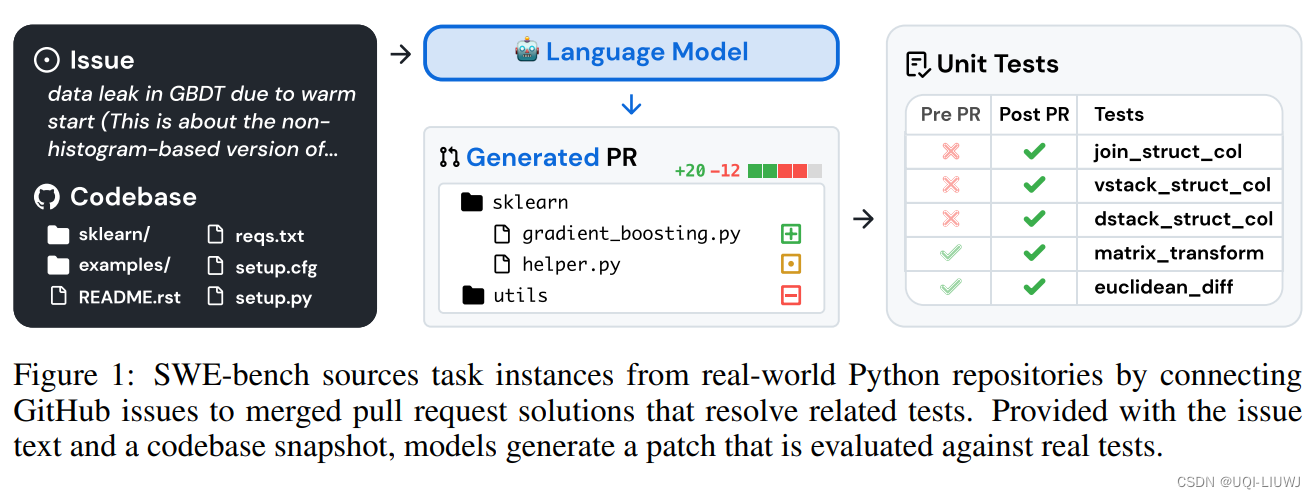

- 论文引入了SWE-bench

- 在现实软件工程环境中评估语言模型的基准测试

- 模型的任务是解决提交到热门GitHub仓库的问题(通常是bug报告或功能请求)

- 每个任务都需要生成描述对现有代码库应用的更改的补丁。

- 然后,使用仓库的测试框架评估修订后的代码库

- 修复一个bug可能涉及导航一个大型仓库,理解不同文件中的功能之间的相互作用,或者在复杂的代码中发现一个小错误

- 这个是现有的编码基准测试不具备的

- HumanEval主要涉及自包含问题,这些问题可以在几行代码内解决

- 在现实软件工程环境中评估语言模型的基准测试

- SWE-bench相较于现有的LM编程基准测试具有多个优势

- 利用用户提交的问题和解决方案的现实设置

- 从12个仓库中提取的独特代码问题的多样输入

- 基于执行的评估的强大框架

- 能够持续用新实例更新基准测试,几乎不需要人工干预

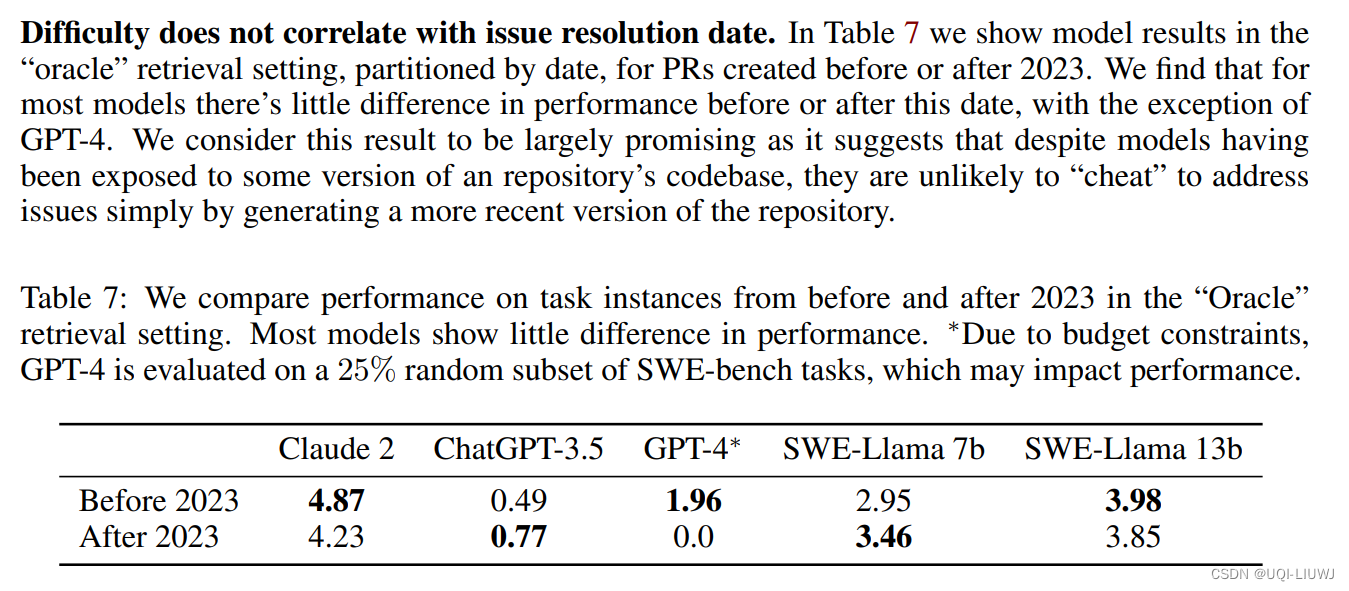

- 论文对多个最先进的语言模型在SWE-bench上进行了评估,发现它们除了最简单的问题外,都未能解决

- 使用BM25检索器,Claude 2只能解决1.96%的问题

- 除了SWE-bench外,论文的贡献还包括发布了一个训练数据集,SWE-bench-train,这对于在这一挑战领域推进开放模型的发展至关重要。

- 这个数据集包括从37个仓库中派生的19,000个非测试任务实例

- 利用SWE-bench-train,论文发布了两个微调模型,SWE-Llama 7b和13b,基于CodeLlam模型

- 在某些设置中,SWE-Llama 13b与Claude 2竞争,并且能够处理超过100,000个标记的上下文