上下文向量(context vector)与表示学习(representation learning)紧密相关,尤其是在自然语言处理(NLP)领域。表示学习是指通过学习将数据映射到一个合适的特征空间,使得在这个空间中可以更容易地进行数据分析和机器学习任务。上下文向量是表示学习的一种形式,它能够捕捉输入数据在特定上下文中的语义信息。

以下是上下文向量在表示学习中的一些关键应用和特点:

上下文感知:上下文向量能够根据单词或短语在特定上下文中的使用情况来调整其表示,这使得模型能够处理一词多义的现象。

动态生成:在一些模型中,如Transformer和BERT,上下文向量是动态生成的,这意味着每次模型处理一个新的输入序列时,都会计算一个新的上下文向量。

预训练和微调:上下文向量通常在预训练阶段学习得到,然后在微调(fine-tuning)阶段针对特定任务进行调整。

多头注意力机制:在Transformer架构中,上下文向量可以通过多头注意力机制(Multi-Head Attention)来生成,这允许模型在不同的表示子空间中捕捉不同的上下文信息。

并行处理:与循环神经网络(RNN)等序列处理模型相比,基于上下文向量的模型可以并行处理输入数据,这大大提高了计算效率。

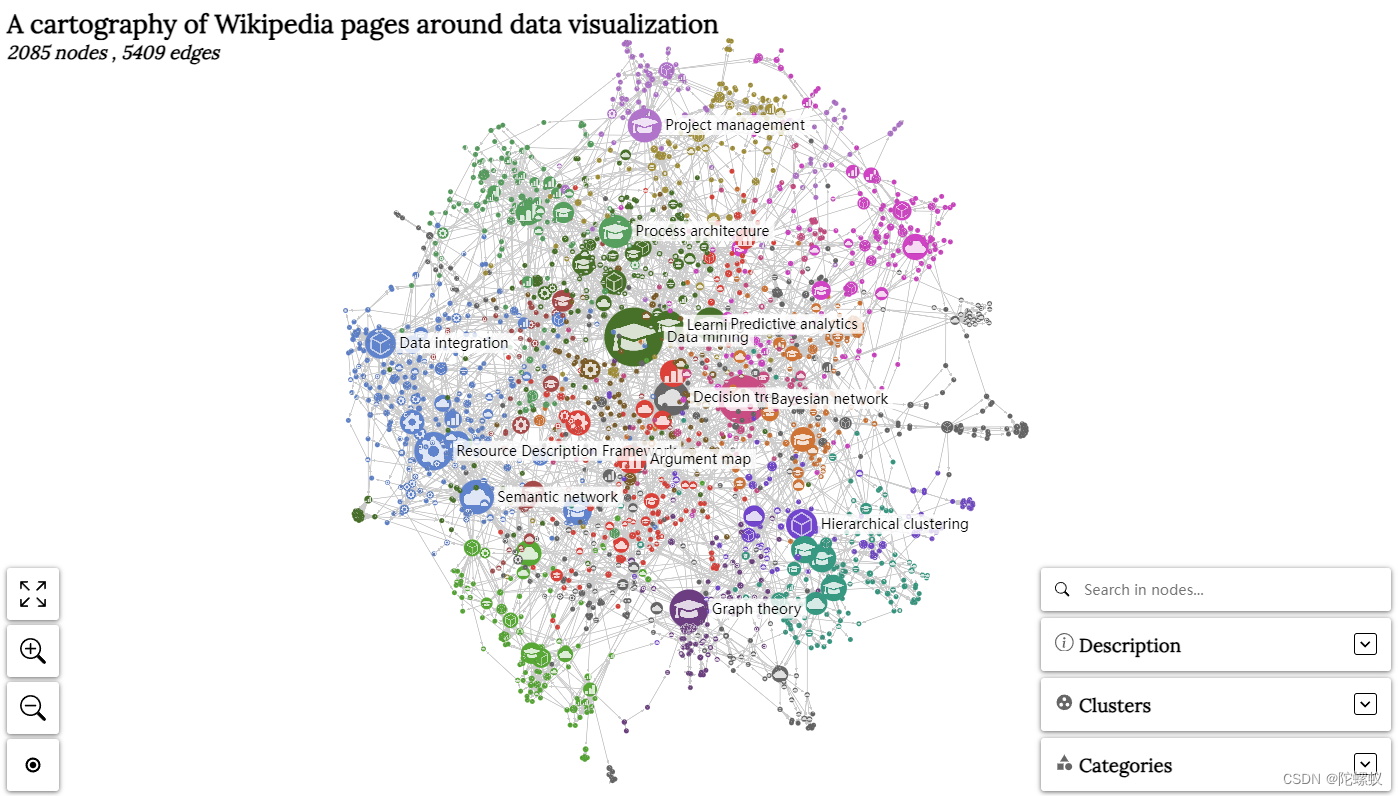

跨模态应用:上下文向量不仅用于文本,还可以用于图像、声音等其他类型的数据,实现跨模态的表示学习。

知识图谱表示学习:在知识图谱领域,上下文向量可以用来捕捉实体和关系的复杂交互,提升知识推理和图谱补全的性能。

计算效率:上下文向量可以通过矩阵运算高效计算,特别是当使用预训练模型如BERT时,可以利用其在大量文本上学习到的通用语言表示。

任务导向:上下文向量可以根据特定任务的需求进行定制,例如,可以通过微调来增强模型在情感分析、文本分类或机器翻译中的表现。

可解释性:上下文向量及其生成的注意力权重可以提供模型决策过程的可解释性,帮助理解模型是如何关注输入数据的不同部分的。

搜索结果中提到的一些论文和资源,如“Context Vectors: A Step Toward a 'Grand Unified Representation'”,讨论了上下文向量如何作为表示学习的一部分,用于文档检索和词义消歧等任务。另外,还有研究如“In-Context Learning State Vector with Inner and Momentum Optimization”探索了如何通过内部优化和动量优化来改进上下文向量,以提高模型在各种下游任务上的性能。

总的来说,上下文向量是表示学习中的一个强大工具,它使模型能够更好地理解和处理数据的语义信息,从而在多种NLP任务中取得更好的性能。

1、上下文向量(context vector)是表示学习(representation learning)的一种形式

上下文向量是表示学习的一种形式。表示学习的目标是将复杂的数据结构转换成一种格式或者编码,这种格式能够在机器学习模型中更有效地被使用。在NLP中,这通常意味着将单词、短语或整个文档转换成数值型向量形式,以便模型可以处理和学习。

上下文向量通过考虑单词在特定上下文中的含义来生成每个单词或实体的表示。这种表示能够捕捉到语言的丰富性和多义性,因为同一个单词在不同的上下文中可能有不同的含义。以下是上下文向量作为表示学习形式的一些关键特点:

上下文依赖:上下文向量不仅仅是单词的静态表示,它还包含了单词在特定上下文中的语义信息。

动态计算:在一些模型(如Transformer和BERT)中,上下文向量是动态计算的,这意味着每次模型处理一个新的输入序列时,都会生成一个新的上下文向量。

注意力机制:上下文向量常常通过注意力机制来计算,这允许模型在序列的不同部分之间分配不同的关注度。

预训练与微调:上下文向量通常在预训练阶段学习得到,这个阶段模型在大量文本上学习语言的通用特征。之后,在微调阶段,模型可以根据特定任务进一步调整这些向量。

多模态兼容性:尽管上下文向量的概念最初主要用于文本数据,但它也可以扩展到其他类型的数据,如图像或声音,实现多模态学习。

知识图谱:在知识图谱表示学习中,上下文向量可以用来表示实体和关系,帮助模型理解和推理知识图谱中的知识。

计算效率:上下文向量可以通过高效的矩阵运算来计算,尤其是在使用预训练模型时,可以利用其在大量数据上学习到的通用语言表示。

任务定制:上下文向量可以根据特定任务的需求进行定制和优化,以提高模型在该任务上的性能。

可解释性:上下文向量及其相关的注意力权重可以提供模型决策过程的可解释性,帮助理解模型是如何关注输入数据的不同部分的。

上下文向量作为表示学习的一种形式,它通过提供丰富的上下文信息,使得深度学习模型能够更好地理解和处理复杂的语言现象。

2、Attention 机制生成上下文向量(context vector)

Attention 机制的核心目标之一就是生成一个上下文向量(context vector)。这个上下文向量能够捕捉输入序列中与当前处理位置最相关的信息。以下是上下文向量的生成过程和它在不同应用中的作用:

生成上下文向量的过程

计算注意力分数:对于序列中的每个元素,模型计算一个与当前处理位置相关的注意力分数。这通常通过将输入向量与可学习的权重矩阵相乘,然后使用一个激活函数(如 softmax)来实现。

生成注意力权重:将注意力分数通过 softmax 函数转换成权重,这些权重能够表示每个输入元素在生成上下文向量时的重要性。

加权求和:使用这些权重对输入序列进行加权求和,得到上下文向量。这个过程可以表示为:

\[ c = \sum_{i=1}^{n} \alpha_i x_i \]

其中,\( c \) 是上下文向量,\( x_i \) 是输入序列中的第 \( i \) 个元素,\( \alpha_i \) 是通过 softmax 函数计算得到的第 \( i \) 个元素的注意力权重。

上下文向量的作用

信息聚合:上下文向量聚合了输入序列中所有元素的信息,但权重不同,反映了不同元素的相关性。

处理长距离依赖:在序列模型中,上下文向量有助于捕捉序列中距离较远的元素之间的关系,这对于理解语言和生成准确的输出至关重要。

提高模型的解释性:通过分析注意力权重,我们可以了解模型在做出决策时更关注输入序列的哪些部分。

增强模型的灵活性:上下文向量使得模型能够动态地关注输入序列中的不同部分,而不是固定地处理每个元素。

Attention 机制的变体

不同的 Attention 机制变体在生成上下文向量的方式上有所不同:

Soft Attention:生成的权重是连续的,并且可以通过梯度下降法进行优化。

Hard Attention:使用随机或确定性的方法生成离散的权重,通常需要特殊的优化方法。

Self-Attention:每个元素的权重是基于其与其他所有元素的关系计算的,常用于 Transformer 模型。

Multi-Head Attention:将 Self-Attention 应用于多个“头”上,每个头学习输入序列的不同表示,然后将这些表示合并起来。

上下文向量是 Attention 机制的关键组成部分,它使得模型能够灵活地处理序列数据,并在各种复杂的任务中取得优异的性能。

3、Attention 机制和上下文向量(context vector)的关系

Attention 机制

Attention 机制是一种资源分配策略,它允许模型在处理序列数据时,动态地聚焦于输入序列中当前最相关的部分。这种机制的核心思想是,对于序列中的每个元素,在生成输出时,模型应该给予其不同的关注程度。

上下文向量(Context Vector)

上下文向量是 Attention 机制的一个直接产物,它是一个固定长度的向量,用来表示输入序列中所有元素的加权表示。这个向量是通过将输入序列中的每个元素与其对应的注意力权重相乘,然后求和得到的。上下文向量捕捉了输入序列的全局信息,并且可以用于后续的模型计算。

Attention 机制与上下文向量的关系

生成上下文向量:Attention 机制通过计算输入序列中每个元素的注意力权重,然后生成一个上下文向量。这个向量是输入序列的一个加权和,其中权重反映了每个元素的重要性。

信息压缩:上下文向量将输入序列的信息压缩成一个固定长度的向量,这有助于简化模型的计算,尤其是在处理长序列时。

动态聚焦:上下文向量使得模型能够动态地聚焦于输入序列中最重要的部分。这种聚焦是根据不同的操作(如翻译、分类或生成)和当前处理的位置动态调整的。

模型性能:上下文向量提供了一种有效的方式来处理序列数据中的长距离依赖问题,这通常可以提高模型在各种任务上的性能。

解释性:通过分析上下文向量和注意力权重,我们可以更好地理解模型的决策过程,即模型在做出预测时更关注输入序列的哪些部分。

示例:Seq2Seq 模型中的 Attention

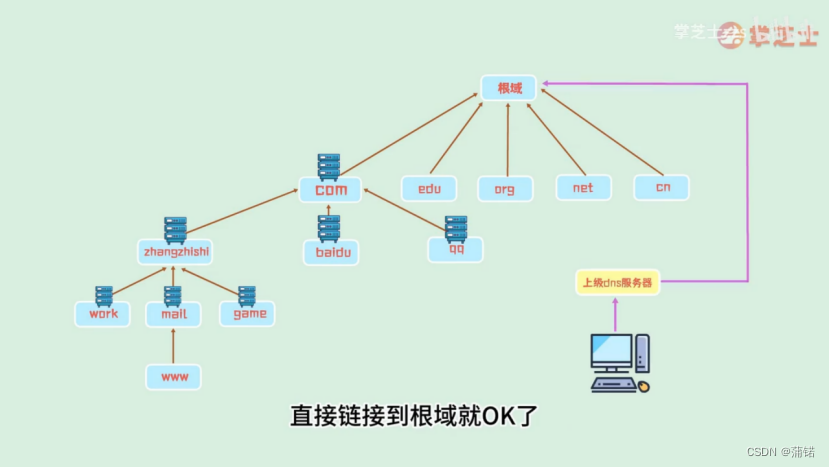

在序列到序列(Seq2Seq)模型中,比如机器翻译任务,Attention 机制通常用于改善模型对源序列(如输入句子)的编码能力。模型首先使用一个编码器(如循环神经网络 RNN 或长短期记忆网络 LSTM)来处理源序列,并生成一系列的隐藏状态。然后,对于目标序列(如输出句子)中的每个元素,模型使用一个解码器(同样可以是 RNN 或 LSTM)来计算注意力权重,这些权重决定了在生成当前目标元素时,应该给予源序列中每个隐藏状态多少关注。最后,模型使用这些权重来生成一个上下文向量,该向量被用来辅助生成目标序列的下一个元素。

结论

Attention 机制和上下文向量共同构成了一种强大的工具,它使得深度学习模型能够更加精细和有效地处理序列数据,尤其是在自然语言处理领域。通过动态地聚焦于输入序列中的关键部分,模型能够生成更加准确和有意义的输出。

![[InternLM训练营第二期笔记]4. XTuner 微调 LLM:1.8B、多模态、Agent](https://img-blog.csdnimg.cn/direct/57e34f733ca44480a76ca2d2a28ad5d8.png)