上篇文章我们使用ollama进行本地的部署,其ollama只是一个后台服务,而ollama并没有提供一个可视化的界面。当然我们可以使用cmd终端窗口里面跟llama2大模型进行沟通交流,但是其界面只有一个黑色的框,并不美观。本期我们就介绍一下Lobe Chat,一个漂亮的UI可视化界面

Lobe Chat简介

现代化设计的开源 ChatGPT/LLMs 聊天应用与开发框架;支持语音合成、多模态、可扩展的(function call)插件系统;一键免费拥有你自己的 ChatGPT/Gemini/Claude/Ollama 应用

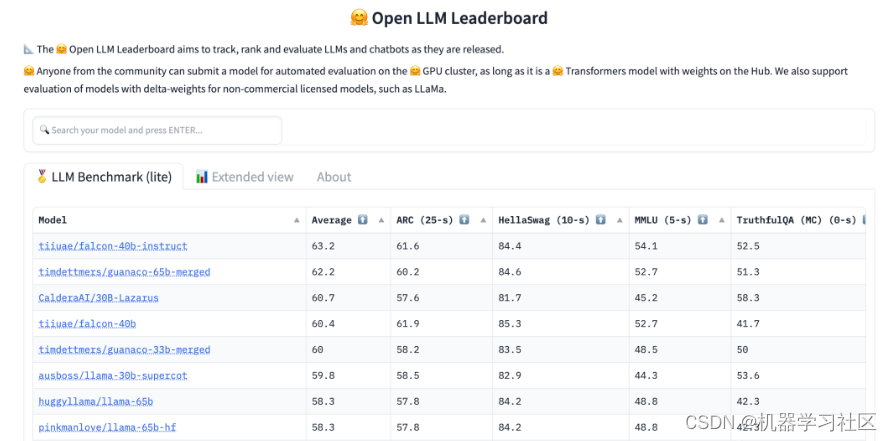

多模型服务商支持

- AWS Bedrock:集成了 AWS Bedrock 服务,支持了 Claude / LLama2 等模型,提供了强大的自然语言处理能力。

- Google AI (Gemini Pro、Gemini Vision):接入了 Google 的 Gemini 系列模型,包括 Gemini 和 Gemini Pro,以支持更高级的语言理解和生成。

- Anthropic (Claude):接入了 Anthropic 的 Claude 系列模型,包括 Claude 3 和 Claude 2,多模态突破,超长上下文,树立行业新基准。

- ChatGLM:加入了智谱的 ChatGLM 系列模型(GLM-4/GLM-4-vision/GLM-3-turbo),为用户提供了另一种高效的会话模型选择。

- Moonshot AI (月之暗面):集成了 Moonshot 系列模型,这是一家来自中国的创新性 AI 创业公司,旨在提供更深层次的会话理解。

- Together.ai:集成部署了数百种开源模型和向量模型,无需本地部署即可随时访问这些模型。

- 01.AI (零一万物):集成了零一万物模型,系列 API 具备较快的推理速度,这不仅缩短了处理时间,同时也保持了出色的模型效果。

- Groq:接入了 Groq 的 AI 模型,高效处理消息序列,生成回应,胜任多轮对话及单次交互任务。

- OpenRouter:其支持包括 Claude 3,Gemma,Mistral,Llama2和Cohere等模型路由,支持智能路由优化,提升使用效率,开放且灵活。

支持本地大语言模型 (LLM)(我们重点介绍的地方)

为了满足特定用户的需求,LobeChat 还基于 Ollama 支持了本地模型的使用,让用户能够更灵活地使用自己的或第三方的模型。

部署方式

- 如果想在 Vercel 或 Zeabur 上部署该服务,可以按照以下步骤进行操作:

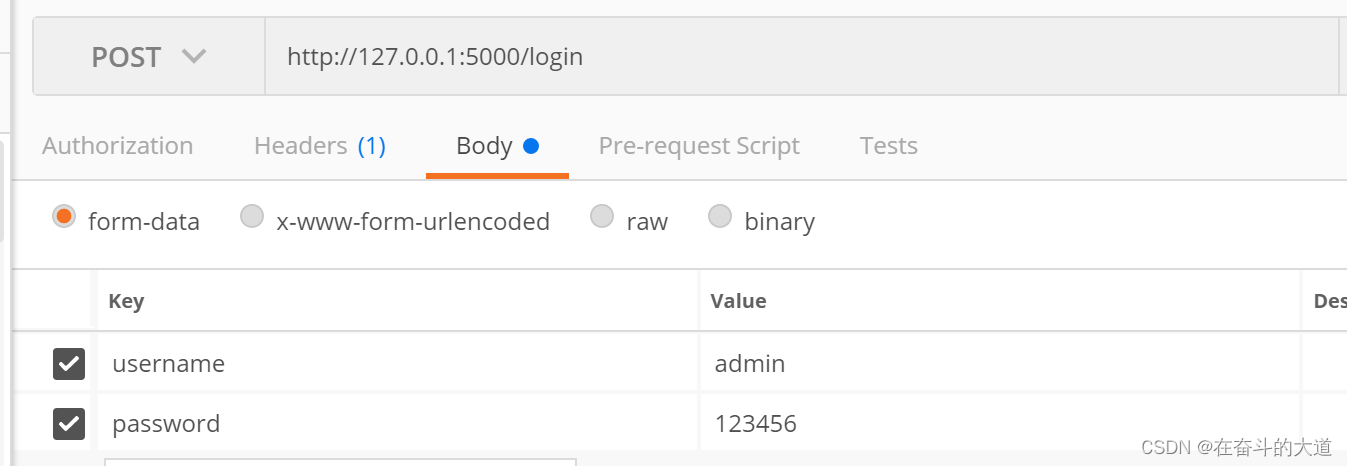

- 准备好你的 OpenAI API Key 。

- 点击下方按钮开始部署: 直接使用 GitHub 账号登录即可,记得在环境变量页填入 OPENAI_API_KEY (必填) and ACCESS_CODE(推荐);

- 部署完毕后,即可开始使用;

- 绑定自定义域名(可选):Vercel 分配的域名 DNS 在某些区域被污染了,绑定自定义域名即可直连。目前 Zeabur 提供的域名还未被污染,大多数地区都可以直连。

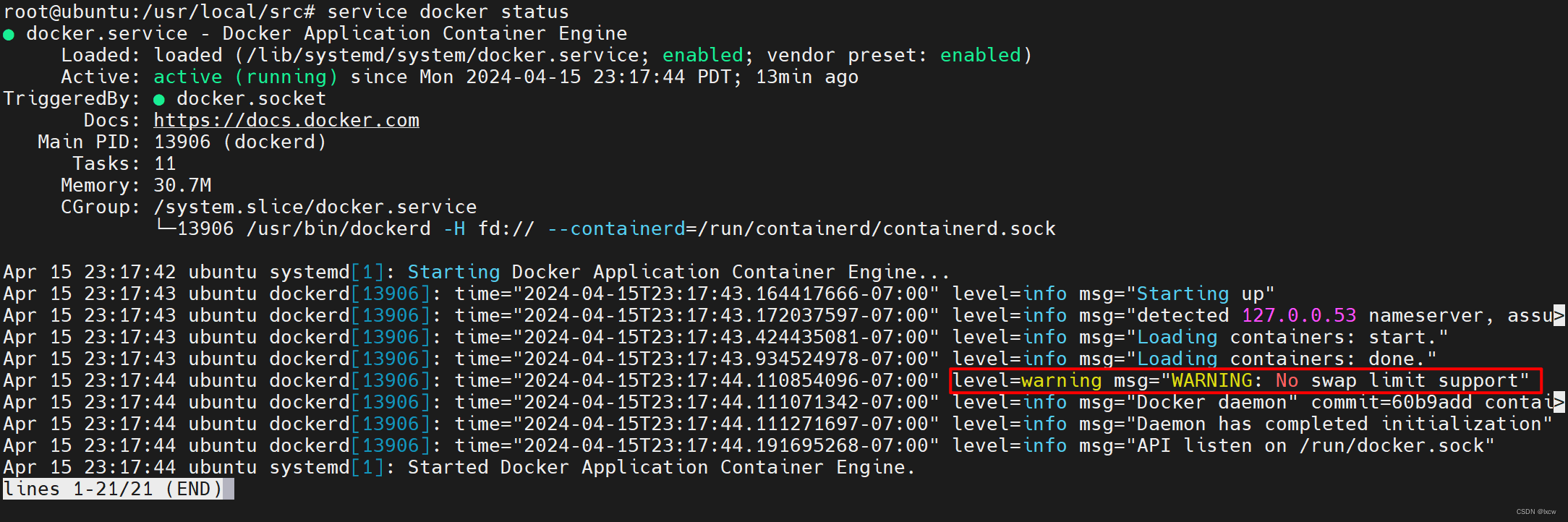

- 使用 Docker 部署

- 使用 Docker 镜像,供你在自己的私有设备上部署 LobeChat 服务。使用以下命令即可使用一键启动 LobeChat 服务:

- 命令行如下:

-

$ docker run -d -p 3210:3210 \ -e OPENAI_API_KEY=sk-xxxx \ -e ACCESS_CODE=lobe66 \ --name lobe-chat \ lobehub/lobe-chat - 如果你需要通过代理使用 OpenAI 服务,你可以使用 OPENAI_PROXY_URL 环境变量来配置代理地址:

$ docker run -d -p 3210:3210 \ -e OPENAI_API_KEY=sk-xxxx \ -e OPENAI_PROXY_URL=https://api-proxy.com/v1 \ -e ACCESS_CODE=lobe66 \ --name lobe-chat \ lobehub/lobe-chat

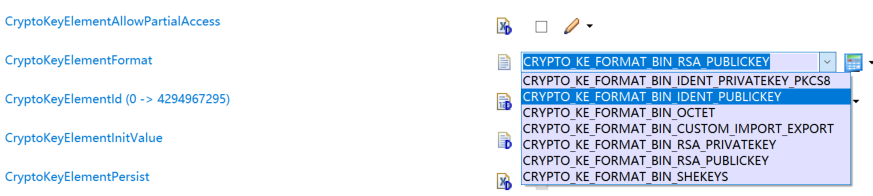

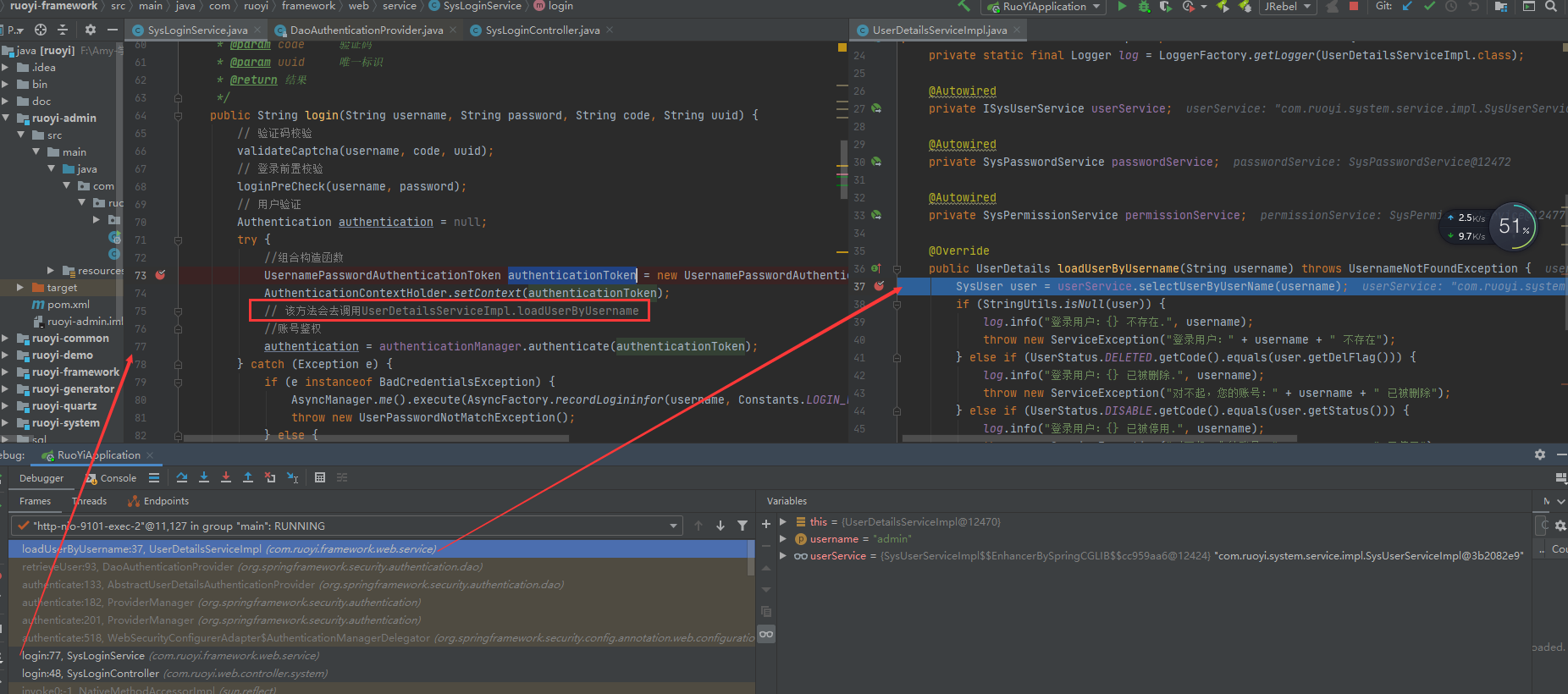

- 与 Ollama 集成

- 本地启动 Ollama

- 首先,你需要安装 Ollama,安装与配置 Ollama 的详细步骤

- 本地运行 LobeChat,假设你已经在本地 11434 端口启动了 Ollama 服务。运行以下 Docker 命令行,在本地启动 LobeChat:

docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat - 接下来,你就可以使用 LobeChat 与本地 LLM 对话了。

- 好玩到飞