使用jieba分词的目的主要是将连续的中文文本切分成独立的词汇单元,以便进行后续的文本分析和处理。jieba分词是中文文本处理中的一个重要步骤,特别适用于中文等没有明显词汇边界的语言。

jieba分词的应用场景非常广泛,包括但不限于以下几个方面:

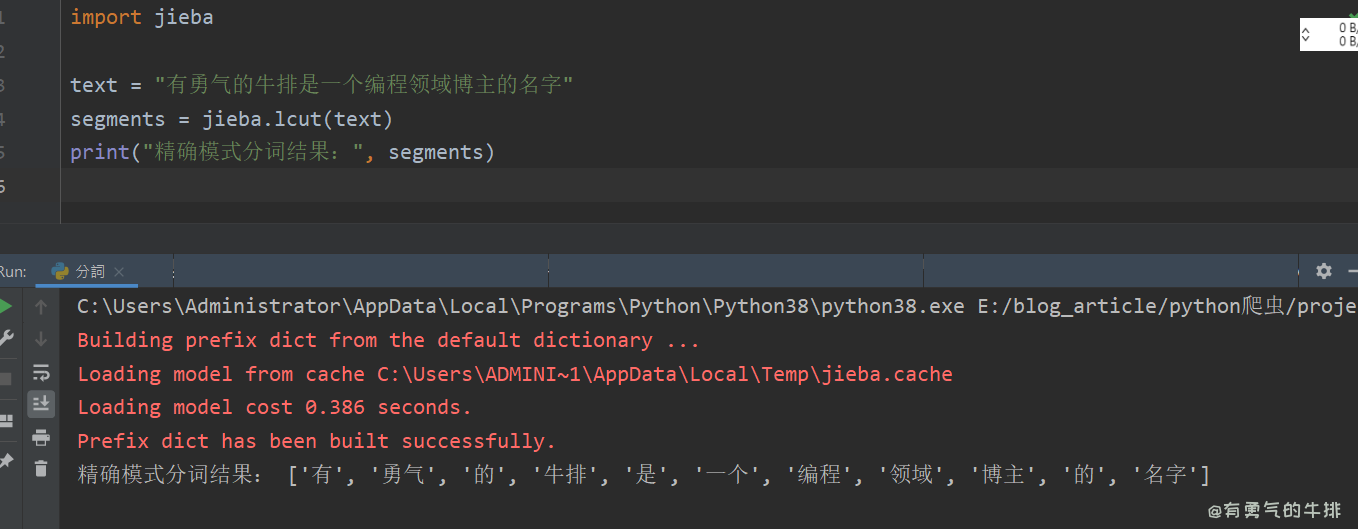

文本分词:最基本的应用就是对中文文本进行分词,将长文本切分为单个的词语,便于后续的分析和处理。

关键词提取:通过分词,可以更容易地识别和提取文本中的关键词,有助于用户快速了解文本的主题和内容。

词性标注:分词后的词语可以进行词性标注,这有助于理解文本的语法结构和语义信息。

文本分类:在机器学习中,分词后的文本可以作为特征输入到分类模型中,实现文本分类任务,如情感分析、主题分类等。

搜索引擎:在构建搜索引擎时,分词技术能够帮助提高搜索的准确性和效率。

自然语言处理研究:对于自然语言处理(NLP)的研究者来说,分词是研究句法、语义等语言现象的基础。

信息检索与挖掘:在大量的文本数据中,分词有助于信息的检索和挖掘,比如从社交媒体、新闻报道等中提取有用信息。

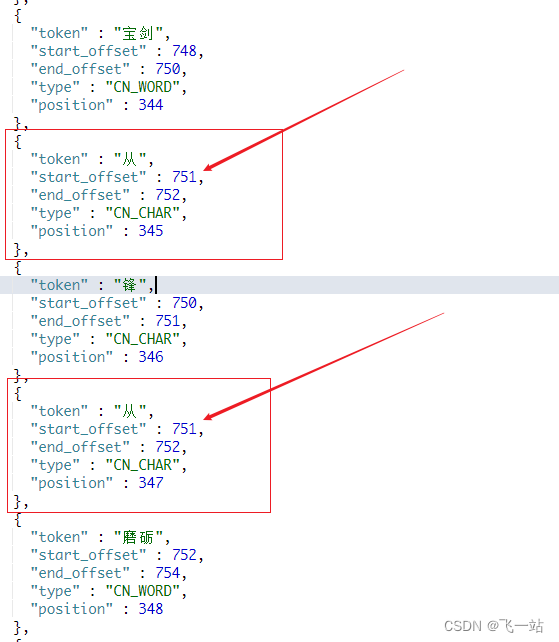

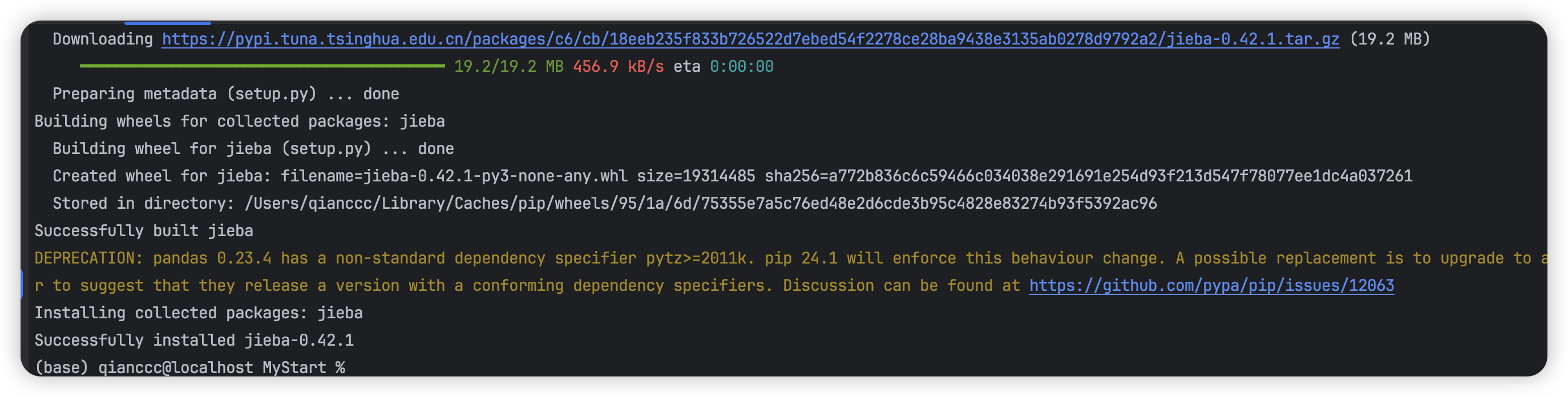

jieba分词提供了精确模式、全模式和搜索引擎模式,用户可以根据实际需求选择不同的模式进行分词。此外,jieba还支持自定义词典,用户可以添加或删除词条,以满足特定场景下的分词需求。