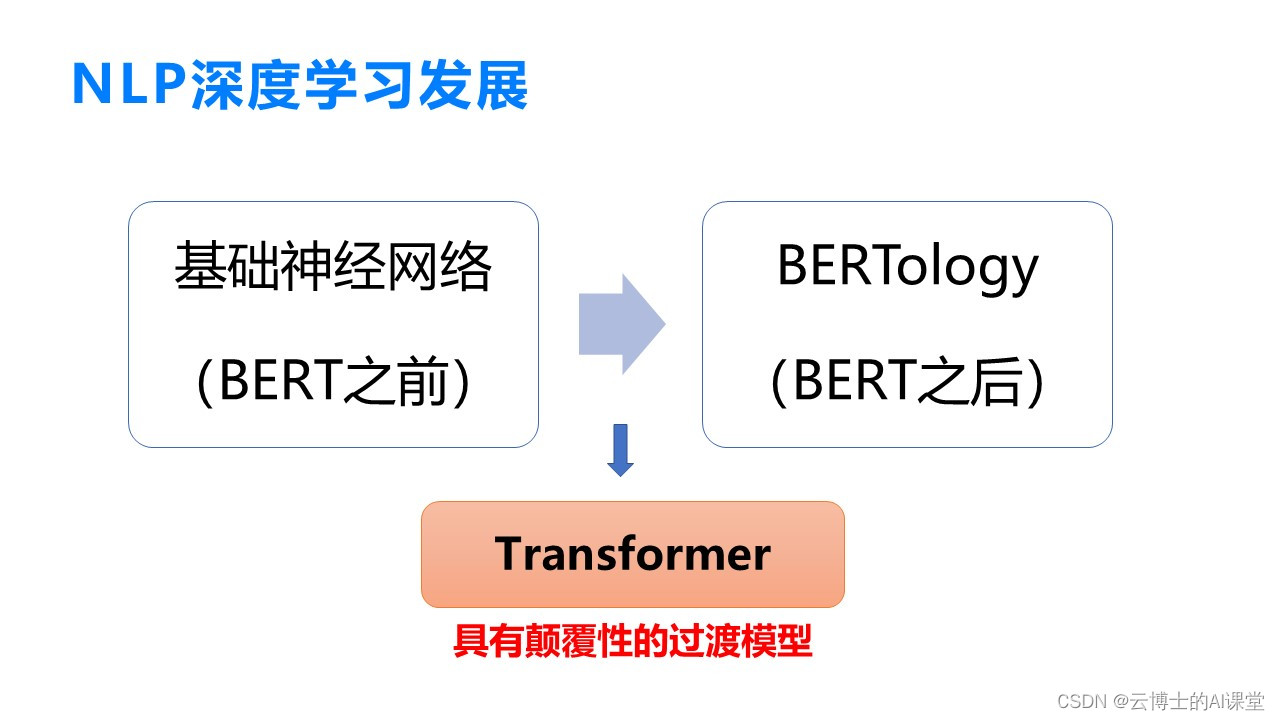

1. 第一章 BERT 的历史

1.1 BERT 的提出

BERT(Bidirectional Encoder Representations from Transformers)是由Google在2018年提出的,作为一种基于Transformer架构的预训练模型。其提出源于对传统自然语言处理模型的局限性的认识,如单向性和上下文理解不足。BERT的创新之处在于双向编码、上下文感知和预训练微调结合的思想,极大地提升了模型在各种NLP任务上的表现。因此,BERT的推出不仅给NLP领域带来革新,也开辟了预训练模型在其他领域的应用前景。

1.2 BERT 的发展

随着BERT的问世,其开源模型使得研究者们可以基于此构建自己的模型,快速应用到各种实际任务中。BERT的成功激发了大量相关研究,涌现出众多基于BERT的衍生模型和应用。同时,其开创的预训练微调模式也成为了当今流行的研究方向,为自然语言处理领域带来了新的发展机遇。

2. 第二章 BERT 模型结构解析

BERT 模型结构的核心包括输入表示、编码器结构以及输出层解析,这些部分构成了 BERT 模型的基本架构和核心思想。

2.1 BERT 的输入表示

在 BERT 模型中,文本首先需要经过 Token Embeddings、Segment Embeddings 和 Position Embeddings 的处理,以便模型能够更好地理解文本信息。

2.1.1 Token Embeddings

Token Embeddings 是将输入的文本分词后,将每个词转换为高维度的向量表示。这个向量包含了该词的语义信息,帮助模型理解每个词在句子中的作用。

# 代码示例:Token Embeddings

from transformers import BertTokenizer, BertModel

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

text = "This is an example sentence."

tokens = tokenizer.tokenize(text)

token_ids = tokenizer.convert_tokens_to_ids(tokens)

input_ids = torch.tensor(token_ids).unsqueeze(0) # Shape: [1, num_tokens]

outputs = model(input_ids)

2.1.2 Segment Embeddings

Segment Embeddings 用于处理输入文本中不同句子之间的关系。在 BERT 中,每个句子用不同的标识符表示,帮助模型区分不同句子的语义。

2.1.3 Position Embeddings

Position Embeddings 负责表达词在句子中的位置信息。BERT 使用位置编码来表示每个词在句子中的相对位置,使模型能够理解句子的顺序关系。

2.2 BERT 的编码器结构

BERT 的核心是基于 Transformer 架构设计的编码器结构,其中包括自注意力机制和多层 Transformer 堆叠,这使得 BERT 在处理文本时能够捕捉全局依赖关系。

2.2.1 Transformer 架构概述

Transformer 架构中的编码器由多个注意力层组成,每个注意力层包含自注意力机制和前馈神经网络。这种结构有助于模型同时考虑输入序列中不同位置的信息。

# 代码示例:Transformer 自注意力机制

from transformers import BertModel, BertTokenizer

import torch

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

text = "Example input text"

input_ids = tokenizer(text, return_tensors='pt')['input_ids']

outputs = model(input_ids)

2.2.2 自注意力机制

自注意力机制允许模型根据输入序列中的不同位置对序列中的其他位置进行加权表示。通过计算注意力权重,模型可以更好地捕捉长距离依赖关系。

2.2.3 多层 Transformer 堆叠

BERT 模型中包含多个 Transformer 编码层的堆叠,每一层都能够提取不同级别的特征表示。这种多层结构有助于模型学习输入序列的复杂语义信息。

2.3 BERT 的输出层解析

BERT 在输出层的设计上采用了 Fine-tuning 和 Feature-based 两种方式,允许模型在不同下游任务上进行微调或直接提取特征。

2.3.1 下游任务微调

Fine-tuning 是指在 BERT 预训练模型的基础上,通过在特定下游任务的训练数据上进行微调,以适应特定任务的需求,在 NLP 领域广泛应用于不同任务。

2.3.2 BERT 的输出解读

BERT 模型在不同下游任务中的输出结果可以通过不同策略进行解读。对于分类任务,通常使用模型输出的向量表示进行分类;对于生成任务,则可以直接使用模型生成的文本。

2.3.3 Fine-tuning vs Feature-based

Fine-tuning 和 Feature-based 两种方式各有优劣。Fine-tuning 可以在特定任务上取得更好的性能,但需要更多的标注数据;Feature-based 则更侧重于提取特征,适用于数据量较少的场景。

以上是关于 BERT 模型结构的详尽解析,包括输入表示、编码器结构和输出层解析,这些设计思想和机制是 BERT 能够在多个自然语言处理任务上取得显著成绩的关键因素。

3. 第三章 BERT 的预训练过程

3.1 Masked Language Model

在BERT的预训练过程中,其中一个关键组成部分是 Masked Language Model(MLM)。MLM的目的是通过对输入文本进行部分遮盖,让模型学会预测被掩盖的词汇。这样的设计可以促使模型学习到词汇之间的关联性,提高其语言理解能力。

填充掩码处理

在MLM中,输入的文本中的一部分词汇会被随机遮盖,被遮盖的位置会被特殊的“[MASK]”符号替代。模型的任务是根据上下文语境来预测被遮盖的词汇。

随机掩码策略

为了增加模型对多种掩码策略的适应能力,BERT引入了一个概率参数,决定是否对一个词进行遮盖。这样的策略可以让BERT更好地处理不同类型的文本输入。

预训练目标函数

BERT的预训练目标函数是最大化整个句子中所有被掩盖词汇的条件概率。通过最大化这个条件概率,BERT可以在预训练阶段学到丰富的文本表示信息,为后续的微调任务提供更好的表征。

3.2 下一句预测任务

除了MLM任务外,BERT还包含了下一句预测(Next Sentence Prediction, NSP)任务。NSP任务要求模型根据两个句子的关系,判断这两个句子是否是连续的。这个任务被用来训练模型对文本之间的逻辑关系进行理解。

预测过程详解

NSP任务中,模型接受两个句子作为输入,通过预测这两个句子是否连续来进行训练。这个任务旨在帮助模型学会捕捉文本段落之间的语义关系。

任务设计目的

NSP任务设计的初衷是为了帮助模型在理解自然语言文本时,更好地把握文本之间的逻辑关联性。通过NSP任务的训练,BERT可以学到如何在句子级别上进行信息融合。

模型自监督学习

通过MLM和NSP两个自监督任务的联合训练,BERT可以在大规模文本语料上获得丰富的语言理解能力。这种自监督学习方式为BERT的高性能提供了坚实基础。

3.3 BERT 的预训练框架

BERT的预训练过程是一个复杂的系统工程,其中包含了多任务学习、数据集选择以及训练策略与技巧。这些方面的设计都影响着BERT模型的最终性能。

多任务学习

BERT采用了多任务学习的方式,在同一个模型中联合训练多个任务。这种设计能够使得模型在学习的过程中获得更丰富的语言表示,提高泛化能力。

数据集选择

在BERT的预训练过程中,选择合适的数据集对于模型性能至关重要。BERT使用了包括书籍、维基百科等丰富的语料库进行预训练,以增加模型的语言涵盖度。

训练策略与技巧

为了获得更好的预训练效果,BERT采用了一系列训练技巧,如动态掩码策略、长文本处理、学习率调整等。这些策略和技巧使得BERT在预训练阶段能够更好地捕捉文本信息。

4. 第四章 BERT 的应用场景与效果

4.1 自然语言处理任务

自然语言处理(Natural Language Processing, NLP)是计算机科学与人工智能领域的重要研究方向,BERT 在 NLP 任务中展现出卓越的性能。主要应用包括文本分类、问答系统以及命名实体识别等。

4.1.1 文本分类

文本分类是将文本按照预先定义的类别或标签进行归类的任务。BERT 在文本分类任务中表现出色,通过将文本序列输入模型,BERT 能够充分理解文本之间的关系,从而提高分类的准确性和效率。

# 代码示例:BERT 文本分类

import torch

from transformers import BertTokenizer, BertForSequenceClassification

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

input_text = "Sample text for classification."

input_ids = tokenizer.encode(input_text, add_special_tokens=True)

outputs = model(torch.tensor(input_ids).unsqueeze(0))

4.1.2 问答系统

BERT 在问答系统中也大放异彩。通过将问题和相关文本输入到 BERT 模型中,BERT 能够理解上下文之间的关系,从而准确地回答问题。这在信息检索和智能对话系统中有着广泛的应用。

4.1.3 命名实体识别

命名实体识别是指从文本中识别出具有特定意义的实体,如人名、组织机构名等。BERT 在命名实体识别任务中凭借其强大的上下文理解能力,能够准确识别文本中的命名实体,提高了实体识别的准确性。

4.2 文本生成领域

除了在传统的自然语言处理任务中表现优异外,BERT 在文本生成领域也有着广泛的应用。主要包括语言模型、文本摘要以及文本翻译等任务。

4.2.1 语言模型

BERT 作为一种强大的语言表示模型,在语言模型任务中有着出色的表现。BERT 能够根据上下文生成与输入文本连贯的文本,使得生成的文本更加自然流畅。

# 代码示例:BERT 语言模型生成

from transformers import BertForMaskedLM, BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForMaskedLM.from_pretrained('bert-base-uncased')

input_text = "The capital of France is [MASK]."

input_ids = tokenizer.encode(input_text, add_special_tokens=True, return_tensors='pt')

outputs = model(input_ids, return_dict=True)

4.2.2 文本摘要

文本摘要是将文本内容压缩成简洁准确的摘要,这在信息检索和内容推荐等领域有着广泛的应用。BERT 在文本摘要任务中能够根据文本的关键信息生成精炼的摘要内容。

4.2.3 文本翻译

文本翻译是将一种语言的文本转换成另一种语言的文本,BERT 在文本翻译任务中引入了双向上下文理解,能够更好地捕捉文本之间的转换关系,提高翻译的质量和准确性。

5. 第五章 BERT 的扩展与未来发展

BERT 模型的成功催生了一系列衍生模型,其中 RoBERTa、DistilBERT 和 ALBERT 是最具代表性的。此外,BERT 在面临的技术挑战和未来发展方向也是研究者们关注的焦点。

5.1 BERT 衍生模型

5.1.1 RoBERTa

RoBERTa(A Robustly Optimized BERT Approach)在 BERT 的基础上进行了多项改进,包括删除了下游任务微调中的偏置,采用更大的批量大小,进行更长时间的训练等。RoBERTa 在多个自然语言处理任务中取得了优异的表现,验证了这些改进的有效性。

# RoBERTa 示例代码

from transformers import RobertaTokenizer, RobertaModel

import torch

tokenizer = RobertaTokenizer.from_pretrained('roberta-base')

model = RobertaModel.from_pretrained('roberta-base')

text = "Replace me by any text you'd like."

encoded_input = tokenizer(text, return_tensors='pt')

output = model(**encoded_input)

5.1.2 DistilBERT

DistilBERT 是一种轻量级的 BERT 模型,通过将 BERT 进行蒸馏(distillation)得到。它拥有更快的推理速度和更小的内存占用,适合在资源受限的环境中部署使用,同时在多个自然语言处理任务上表现也相当出色。

5.1.3 ALBERT

ALBERT(A Lite BERT)致力于解决 BERT 中参数过多、计算资源占用过高的问题。ALBERT 在将嵌入层参数共享、参数捆绑等方面做了一系列创新,大幅减少了模型的规模,同时保持了较高的性能表现。

5.2 BERT 的技术挑战

在 BERT 的发展过程中,研究者们也不断面对一些技术挑战,其中主要体现在模型尺度问题、训练效率优化和多语言与跨领域支持。

5.2.1 模型尺度问题

BERT 模型在处理长文本时会面临顺序长度限制的问题,可能导致信息丢失。为了解决这一问题,研究者们提出了一些改进方法,如长序列注意力机制、分段策略等。

5.2.2 训练效率优化

随着模型规模的增大,训练 BERT 模型需要庞大的计算资源和时间。为了提高训练效率,研究者们尝试采用分布式训练、深层网络初始化技巧等方法来加速训练过程。

5.2.3 多语言与跨领域支持

为了使 BERT 在多语言和跨领域的应用中表现良好,研究者们关注如何有效处理多语种数据,提高模型的泛化能力,以及构建更强大的预训练框架来支持各种任务和领域。

5.3 BERT 的未来展望

BERT 模型在自然语言处理领域取得了巨大成功,但仍然存在着一些有待改进的地方。未来,研究者们将继续关注模型的演进趋势、迁移学习与泛化能力、以及构建更完善的 BERT 生态系统等方面。

以上就是关于 BERT 模型的扩展和未来发展方向的一些介绍,希望对读者有所启发。

6. 第六章 BERT 的发展趋势

随着 BERT 模型的问世,自然语言处理领域迎来了一场革命。而在 BERT 的成功下,其衍生模型也相继出现,不断推动着 NLP 技术的快速发展。在未来,我们可以预见到以下几个方面的发展趋势:

跨领域应用增多:随着 BERT 在各个领域的成功应用,未来将出现更多基于 BERT 的跨领域应用,如金融领域的文本分析、医疗领域的病例解读等。

多模态融合:除了文本信息,图像、语音等多模态数据在实际应用中也越来越重要。未来的发展趋势之一是将 BERT 模型与多模态数据相结合,实现更加全面的语义理解和信息提取。

轻量级部署:目前大部分的预训练模型都是庞大的深度神经网络,对于资源有限的设备,如移动端设备或边缘计算设备,部署这些模型显得有些力不从心。因此,未来的发展方向之一是研究如何将 BERT 模型进行轻量化,以适应更多场景的部署需求。

迁移学习与泛化能力:随着迁移学习在深度学习领域的普及,未来 BERT 可能会更加注重在不同任务、不同领域之间的知识迁移能力,以实现更广泛的应用。

模型可解释性:对于深度学习模型来说,其内部机制往往是一个黑盒,在理解模型决策过程或进行错误分析时存在困难。未来的研究方向之一是提高 BERT 模型的可解释性,使其决策过程更加透明化。

生态系统建设:由于 BERT 的成功,未来可能会形成更加完善的 BERT 生态系统,涵盖模型训练、应用开发、模型服务化等方面,为开发者提供更加便捷的工具和支持。

持续优化与更新:随着技术的不断进步,BERT 及其衍生模型也会不断进行优化与更新,以适应不断变化的应用场景和需求。

领域拓展:除了目前主流的自然语言处理领域,未来 BERT 可能会涉足更多领域,如图像处理、推荐系统等,拓展其适用范围。

开源与合作:未来 BERT 可能会更加开放,推动更多领域专家、学者共同参与,共同打造一个更加强大和多样化的 NLP 技术生态。

社会影响:随着 BERT 技术的不断发展和普及,其对社会的影响也会日益凸显,包括信息传播、舆论引导等方面,需要更加谨慎地处理与关注。

综上所述,BERT 技术在未来的发展中将继续引领自然语言处理领域的发展方向,不断探索其在更多领域和场景中的应用,推动人工智能技术向更高层次发展。

![[RK3399 Linux] 使用busybox 1.36.1制作rootfs](https://img-blog.csdnimg.cn/direct/151ca3e9356c493bac89725b6b18354c.png#pic_center)