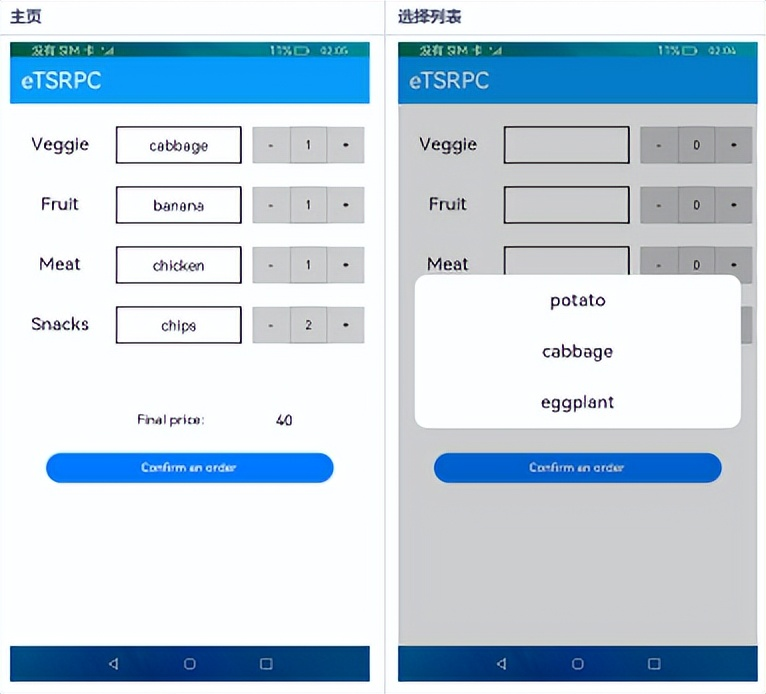

2024年4月10日 — 苹果公司近日宣布推出一款名为Ferret-UI的机器学习语言模型(MLLM),旨在大幅提升对移动用户界面(UI)屏幕的理解能力。这一创新技术预示着iOS 18操作系统可能将带来前所未有的交互体验,用户或将能够通过Siri实现对应用界面的自动操作。

- Ferret-UI模型:移动UI理解的新突破

Ferret-UI模型是专为移动UI屏幕设计的MLLM,它不仅具备引用、定位和推理能力,还能够处理UI屏幕上的各种复杂任务。该模型的关键创新之一是其独特的“任何分辨率”技术,该技术通过放大细节来解决小型对象的识别问题,显著提高了模型对UI元素的理解精度。

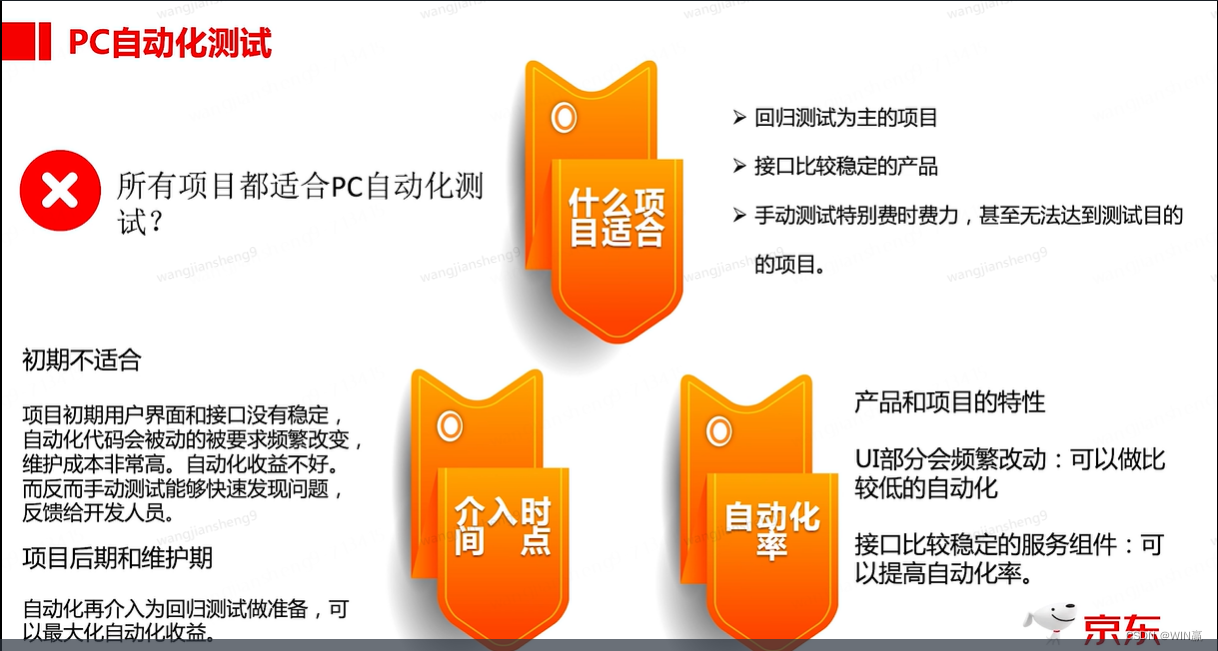

- UI屏幕理解的挑战与解决方案

与传统的自然图像相比,UI屏幕通常具有更多的长宽比和更小的元素,这对模型的识别能力提出了更高要求。Ferret-UI模型通过采用“任何分辨率”技术,将屏幕分割成基于原始宽高比的子图像,并对每个子图像进行单独编码,从而在不丢失重要视觉信号的情况下放大细节,实现了对小型对象的准确识别。

- 训练样本的收集与任务制定

为了训练Ferret-UI模型,苹果公司收集了从基础到高级的广泛数据样本,并将其格式化为带有区域注释的指令遵循格式。此外,为了提升模型的推理能力,还特别编制了一个包含详细描述、感知/交互对话和功能推断等高级任务的数据集。

- 模型架构与数据集的建立

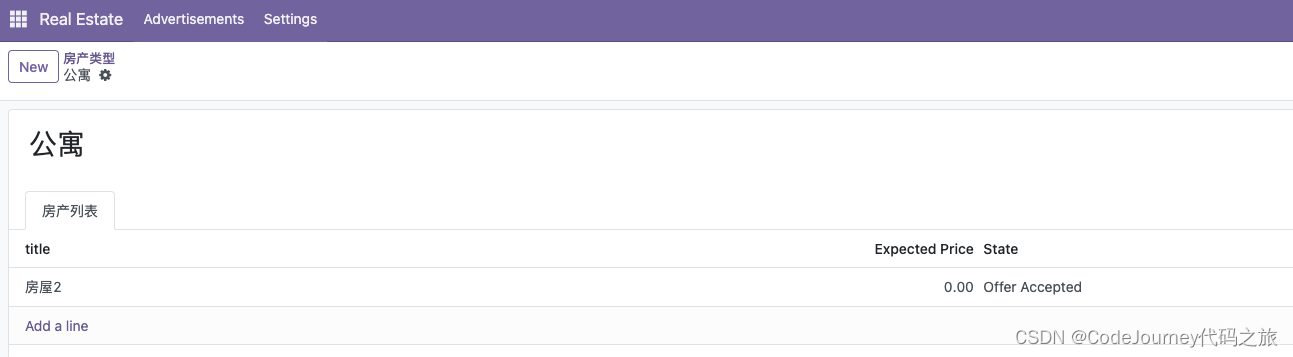

Ferret-UI的架构基于在自然图像引用和定位任务中表现出色的Ferret模型。针对UI屏幕的特点,Ferret-UI进行了架构调整,包括集成“任何分辨率”技术和使用预定义的网格配置来划分全图图像。同时,为了全面评估模型的能力,苹果公司还建立了一个包含所有研究任务的综合测试基准。

- 高级任务中的对话能力

Ferret-UI在高级任务中的对话能力尤为突出,模型能够生成与视觉组件相关的详细讨论,并提出以特定目标为导向的行动计划。通过功能推断,Ferret-UI还能够解释屏幕的整体目的,显示出其在理解和生成自然语言指令方面的高级能力。

苹果公司此次推出的Ferret-UI模型,不仅为移动UI界面的理解带来了革命性的突破,也为未来的智能设备交互体验开辟了新的可能性。随着iOS 18操作系统的即将到来,我们有理由相信,Ferret-UI将为用户带来更加智能、便捷的操作体验,开启移动设备交互的新篇章。