关于scaling law 的正确认识 - 知乎最近scaling law 成了最大的热词。一般的理解就是,想干大模型,清洗干净数据,然后把数据tokens量堆上来,然后搭建一个海量H100的集群,干就完了。训练模型不需要啥技巧,模型结构也没啥好设计的,对算法精度影响…![]() https://zhuanlan.zhihu.com/p/684955373对于基于transformer的语言模型,假设模型的参数量为N,数据集tokens个数为D(token数),那么模型的计算量C约为6ND,模型的计算量C一定后,模型的性能即精度就基本确定。语言模型的影响因素只有N和D,跟模型的具体结构诸如层数,深度,attention头个数基本无关,相关性非常小,性能在2%的区间内。

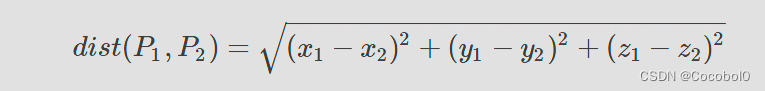

https://zhuanlan.zhihu.com/p/684955373对于基于transformer的语言模型,假设模型的参数量为N,数据集tokens个数为D(token数),那么模型的计算量C约为6ND,模型的计算量C一定后,模型的性能即精度就基本确定。语言模型的影响因素只有N和D,跟模型的具体结构诸如层数,深度,attention头个数基本无关,相关性非常小,性能在2%的区间内。

scaling laws的前提是标准的transformer结构。