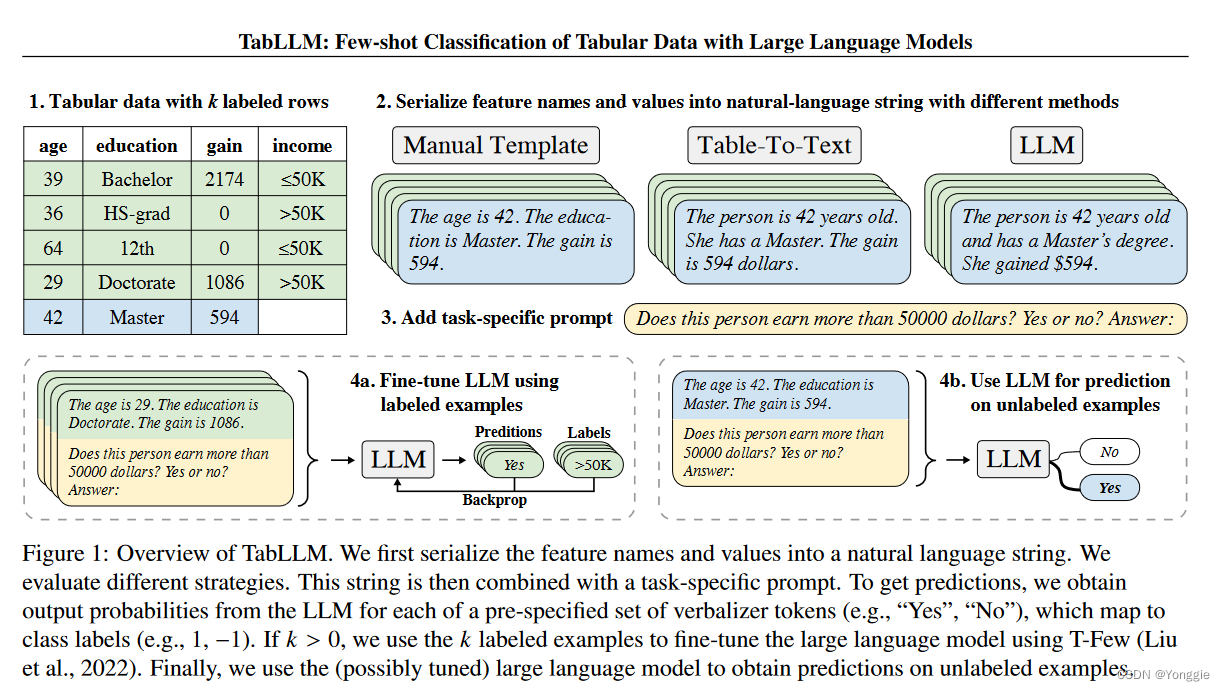

在机器学习特别是深度学习中,激活函数是用于增加模型的非线性特性。对于一个给定的输入信号,激活函数定义了输出信号的形式。以下是一些常见的激活函数及其导数:

一、Sigmoid函数

函数

导数

二、Tanh双曲正切函数

函数

导数

三、ReLU线性整流单元函数

函数

导数

ReLU函数在处导数不明确是因为实际使用中通常不会发生计算问题,并且在实现时通常会返回0或1。

四、Leaky ReLU函数

函数

其中α是一个小常数

导数

五、Softmax函数

函数(对第i个输入)

导数(对第i个输入)

Softmax函数的导数较为复杂,这里的表述为了简单化并未展现交叉项。在实际计算梯度时,需要考虑Softmax输出之间的相互作用。对于其他输入,导数会涉及到Softmax输出的相互关系。

![2023-<span style='color:red;'>简单</span>点-<span style='color:red;'>机器</span><span style='color:red;'>学习</span>中<span style='color:red;'>常用</span><span style='color:red;'>的</span>特殊<span style='color:red;'>函数</span>,<span style='color:red;'>激活</span><span style='color:red;'>函数</span>[sigmoid tanh ]](https://img-blog.csdnimg.cn/2e46a4283c3247f8bc20d09e9b2d2381.png)