一、环境配置

以下是在Ubuntu上配置Spark环境的基本步骤:

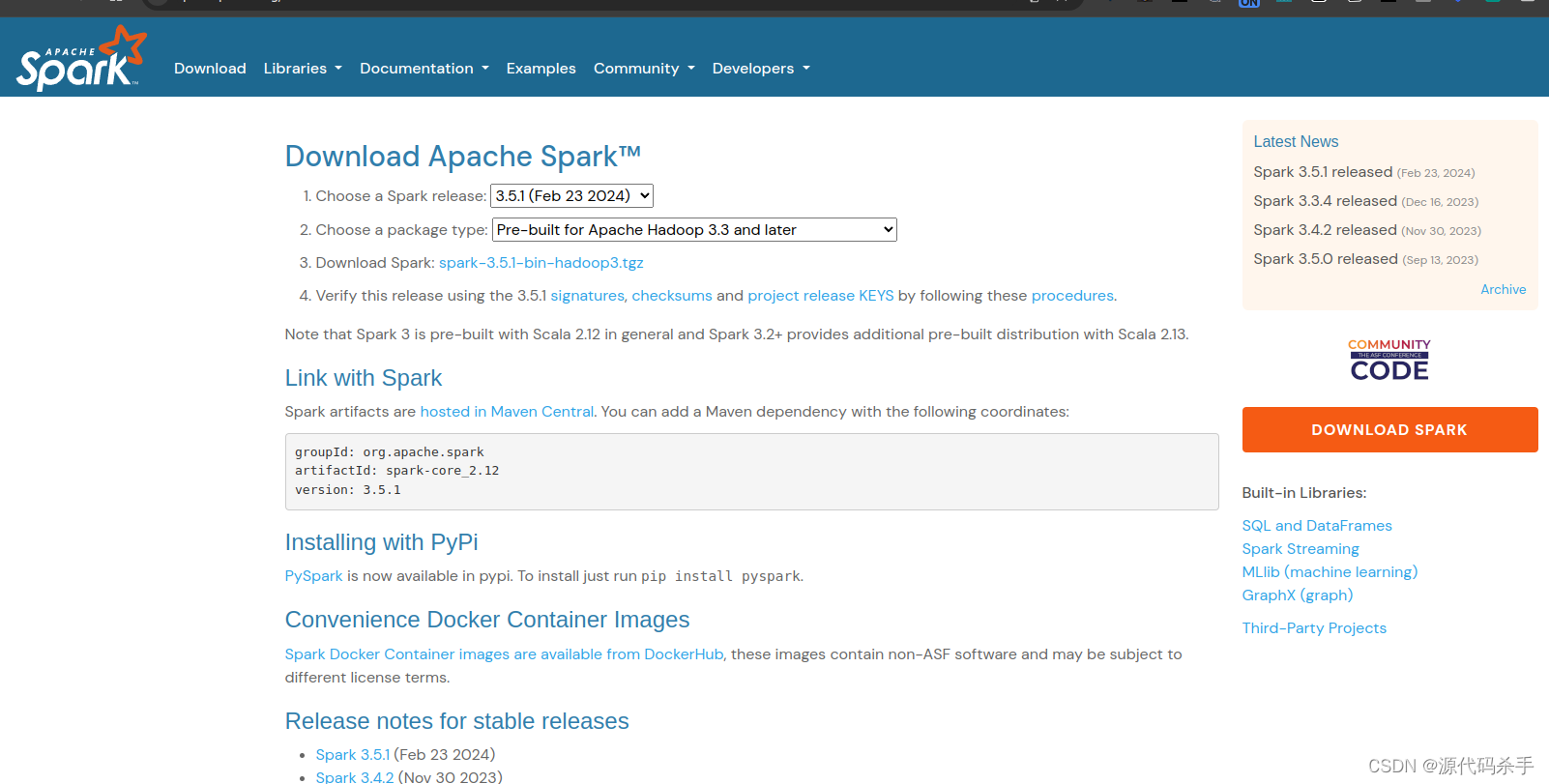

下载Spark:

从提供的链接中下载Spark压缩包。您可以使用wget命令从命令行下载:

wget https://dlcdn.apache.org/spark/spark-3.5.1/spark-3.5.1-bin-hadoop3.tgz

解压Spark:

使用以下命令解压下载的压缩包:

tar -xvf spark-3.5.1-bin-hadoop3.tgz

移动Spark文件夹:

将解压后的Spark文件夹移动到您想要安装的位置,例如/opt目录:

sudo mv spark-3.5.1-bin-hadoop3 /opt/spark-3.5.1

![笔记:[dv-admin开发系列]--2.0版本环境搭建](https://img-blog.csdnimg.cn/direct/61d482e4c0d24c808b1540874e700c22.png)