1. 背景介绍

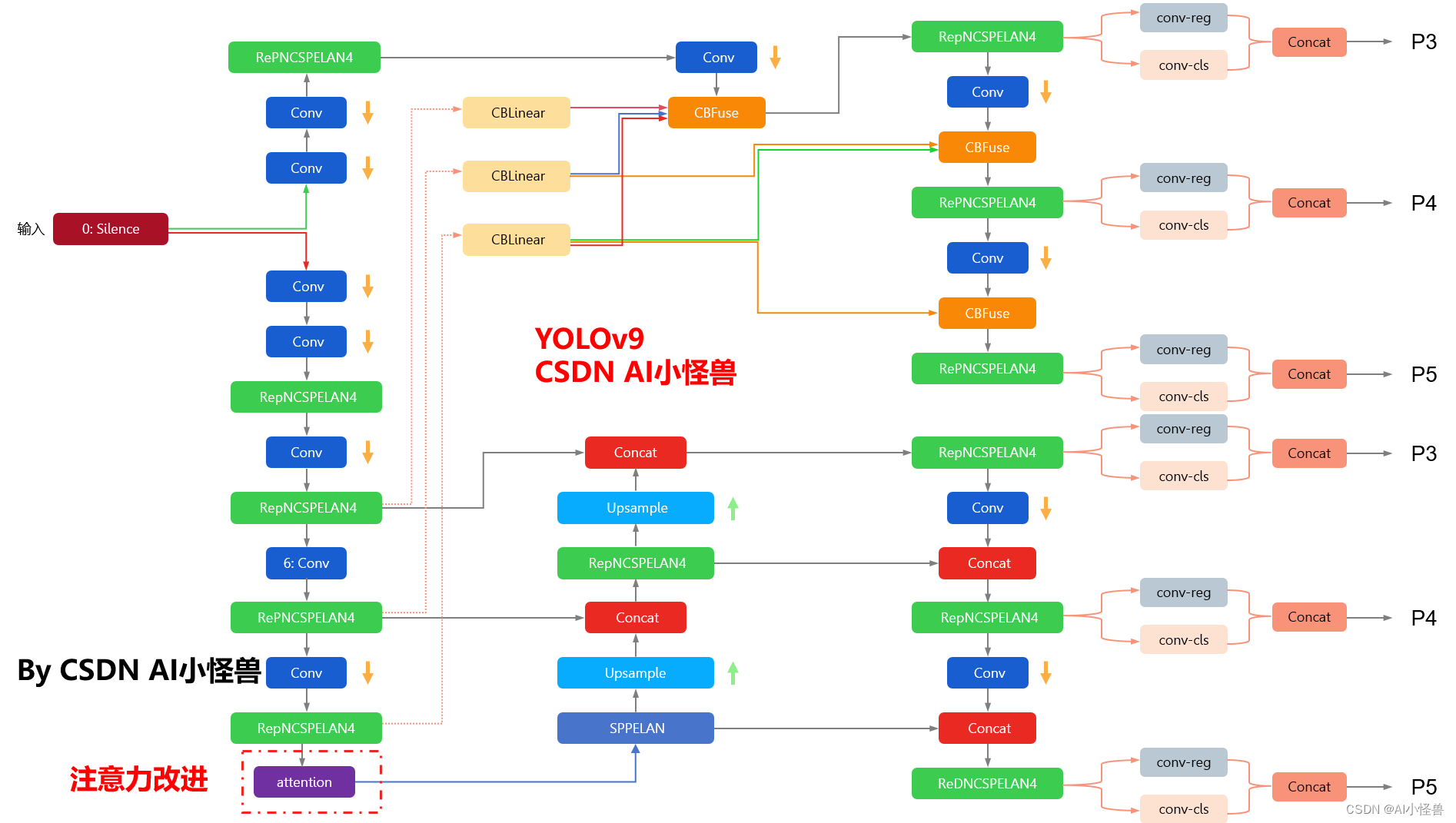

在深度学习领域,图像分类、目标检测、图像分割等任务都需要模型能够关注到图像中的关键信息。注意力机制(Attention Mechanism)是一种能够帮助模型自动聚焦于图像中重要部分的技术。注意力机制可以分为通道注意力(Channel Attention)、空间注意力(Spatial Attention)和自注意力(Self-Attention)三种。

2. 核心概念与联系

2.1 通道注意力

通道注意力关注的是图像的通道维度,即不同颜色通道之间的关系。例如,在图像分类任务中,通道注意力可以帮助模型关注到图像中与分类类别相关的特征。

2.2 空间注意力

空间注意力关注的是图像的空间维度,即不同像素之间的关系。例如,在目标检测任务中,空间注意力可以帮助模型关注到图像中与目标物体相关的区域。

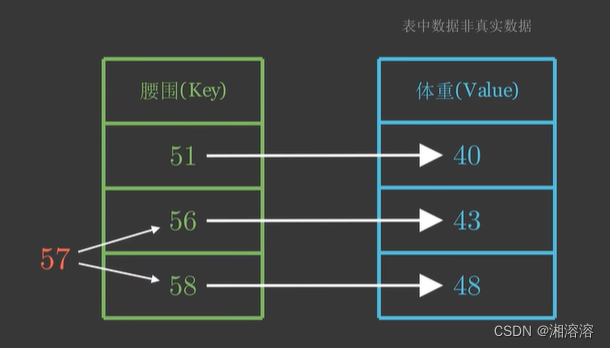

2.3 自注意力

自注意力关注的是图像的整体结构,即图像中所有像素之间的关系。自注意力可以捕捉图像中的全局依赖关系,有助于提高模型的表达能力。

2.4 联系

通道注意力、空间注意力和自注意力都是注意力机制的不同表现形式,它们可以相互结合,共同提高模型的性能。例如,在某些网络结构中,会先使用通道注意力提取特征,再使用空间注意力关注特征中的关键区域。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 通道注意力

通道注意力通过计算通道间的相关性来强调重要的特征。具体操作步骤如下:

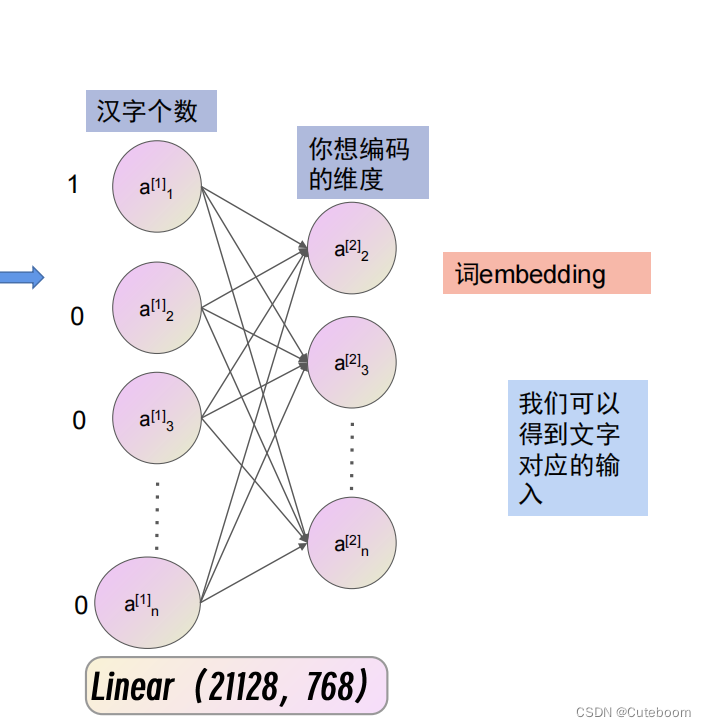

- 对输入特征图进行全局平均池化(Global Average Pooling, GAP)以降低维度。

- 对池化后的特征进行全连接(Fully Connected, FC)操作,得到通道注意力权重。

- 将注意力权重与原始特征图相乘,得到加权后的特征图。

数学模型公式为:

Attention ( X ) = σ ( W a ⋅ X ) \text{Attention}(X) = \sigma(W_a \cdot X) Attention(X)=σ(Wa⋅X)

其中, X X X 为输入特征图, W a W_a Wa 为全连接层的权重, σ \sigma σ 为激活函数。

3.2 空间注意力

空间注意力通过计算像素间的相关性来强调重要的区域。具体操作步骤如下:

- 对输入特征图进行空间维度上的卷积操作,得到空间注意力权重。

- 将注意力权重与原始特征图相乘,得到加权后的特征图。

数学模型公式为:

Attention ( X ) = X ⋅ σ ( W s ⋅ X ) \text{Attention}(X) = X \cdot \sigma(W_s \cdot X) Attention(X)=X⋅σ(Ws⋅X)

其中, W s W_s Ws 为卷积层的权重, σ \sigma σ 为激活函数。

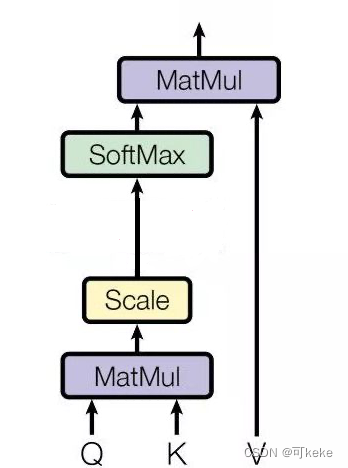

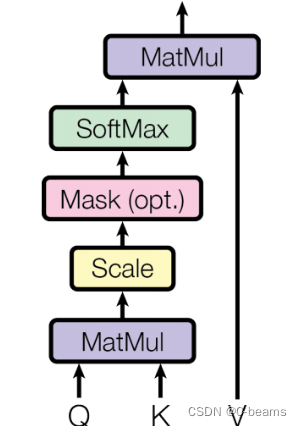

3.3 自注意力

自注意力通过计算图像中所有像素间的相关性来强调重要的区域。具体操作步骤如下:

- 对输入特征图进行自注意力机制的计算,得到注意力权重。

- 将注意力权重与原始特征图相乘,得到加权后的特征图。

数学模型公式为:

Attention ( X ) = X ⋅ σ ( W a ⋅ X ) \text{Attention}(X) = X \cdot \sigma(W_a \cdot X) Attention(X)=X⋅σ(Wa⋅X)

其中, W a W_a Wa 为自注意力机制的权重, σ \sigma σ 为激活函数。

4. 具体最佳实践:代码实例和详细解释说明

以PyTorch为例,实现一个简单的通道注意力模块:

import torch

import torch.nn as nn

import torch.nn.functional as F

class ChannelAttention(nn.Module):

def __init__(self, in_channels, reduction=16):

super(ChannelAttention, self).__init__()

self.avg_pool = nn.AdaptiveAvgPool2d(1)

self.fc = nn.Sequential(

nn.Linear(in_channels, in_channels // reduction, bias=False),

nn.ReLU(),

nn.Linear(in_channels // reduction, in_channels, bias=False),

nn.Sigmoid()

)

def forward(self, x):

b, c, _, _ = x.size()

y = self.avg_pool(x).view(b, c)

y = self.fc(y).view(b, c, 1, 1)

return x * y

该模块首先通过全局平均池化降低维度,然后通过全连接层计算通道注意力权重,最后将权重与原始特征图相乘得到加权后的特征图。

5. 实际应用场景

注意力机制在图像分类、目标检测、图像分割等任务中都有广泛的应用。例如,在图像分类任务中,注意力机制可以帮助模型关注到图像中的关键特征;在目标检测任务中,注意力机制可以帮助模型关注到图像中的目标物体;在图像分割任务中,注意力机制可以帮助模型关注到图像中的不同区域。

6. 工具和资源推荐

- PyTorch:一个开源的深度学习框架,提供了丰富的注意力机制实现。

- TensorFlow:另一个开源的深度学习框架,也提供了注意力机制的实现。

- Attention Is All You Need:一篇介绍自注意力的经典论文,详细介绍了自注意力的原理和实现。

7. 总结:未来发展趋势与挑战

注意力机制在深度学习领域有着广泛的应用,未来发展趋势包括:

- 注意力机制的进一步研究,包括新的注意力机制的提出和现有注意力机制的改进。

- 注意力机制与其他技术的结合,例如生成对抗网络(GAN)和强化学习。

- 注意力机制在更多任务中的应用,例如语音识别和自然语言处理。

挑战包括:

- 注意力机制的计算复杂度较高,如何在保证性能的同时降低计算量。

- 注意力机制的解释性较差,如何提高注意力机制的可解释性。

- 注意力机制在实际应用中的泛化能力,如何提高注意力机制在实际应用中的泛化能力。

8. 附录:常见问题与解答

Q: 注意力机制和卷积神经网络有什么关系?

A: 注意力机制可以看作是一种特殊的卷积操作,它可以帮助模型关注到图像中的关键信息。注意力机制可以与卷积神经网络相结合,提高模型的性能。

Q: 注意力机制和循环神经网络有什么关系?

A: 注意力机制可以看作是一种特殊的循环操作,它可以帮助模型关注到序列数据中的关键信息。注意力机制可以与循环神经网络相结合,提高模型的性能。

Q: 注意力机制和自编码器有什么关系?

A: 注意力机制可以看作是一种特殊的自编码器,它可以帮助模型关注到数据中的关键信息。注意力机制可以与自编码器相结合,提高模型的性能。