全都是猫,很纯,有的不是猫,也很纯。

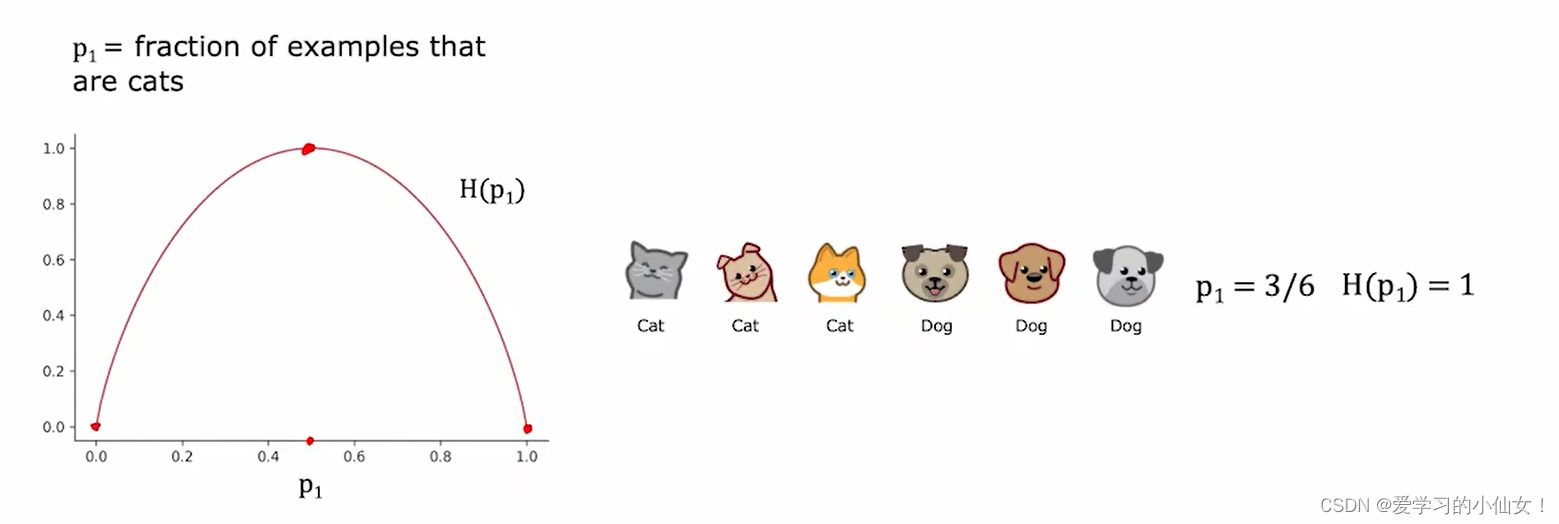

熵(entropy): 衡量一组数据纯度的指标。熵的图象如下图所示,纵轴通常用 H 来表示。当训练集的比例为一半一半的时候熵最高,为1;全是猫或者全是狗的时候最低,为0。

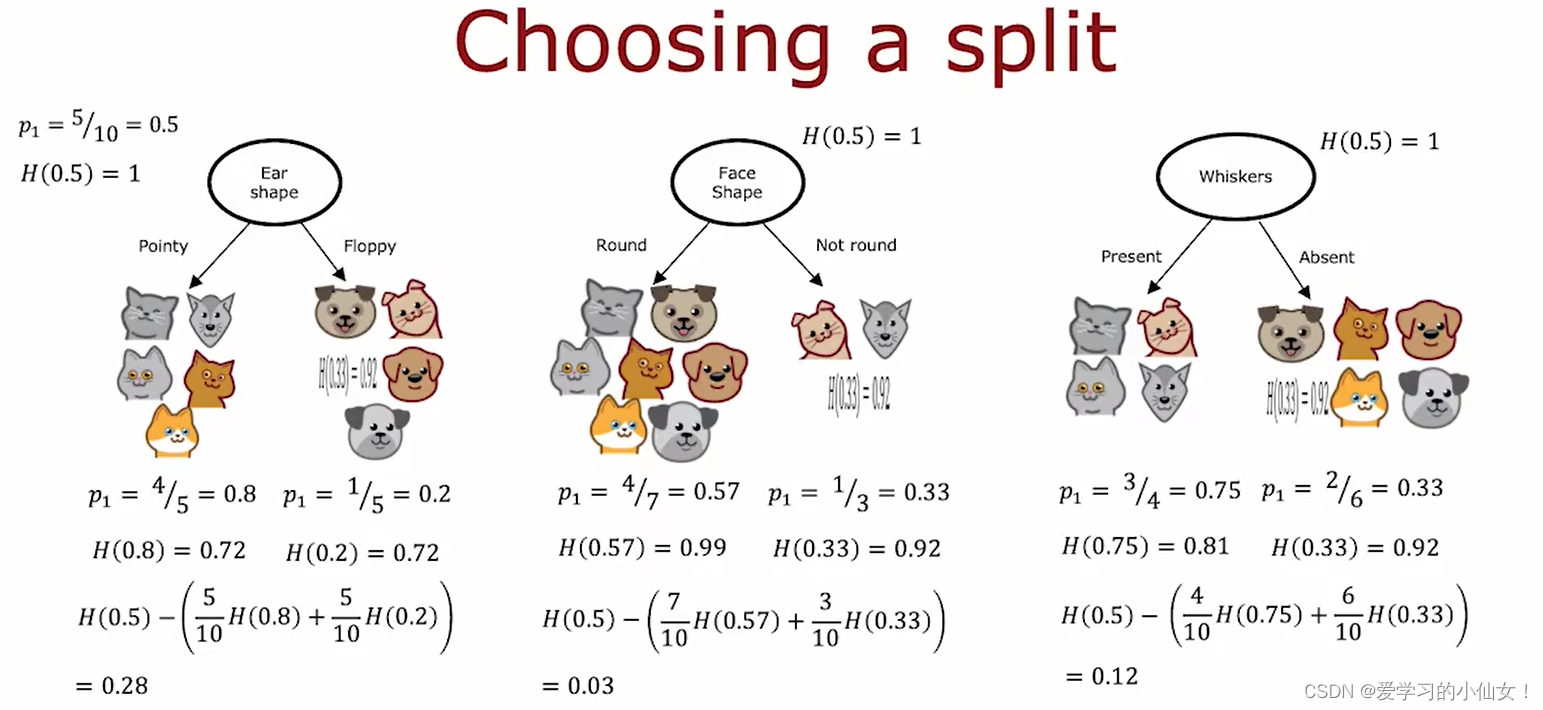

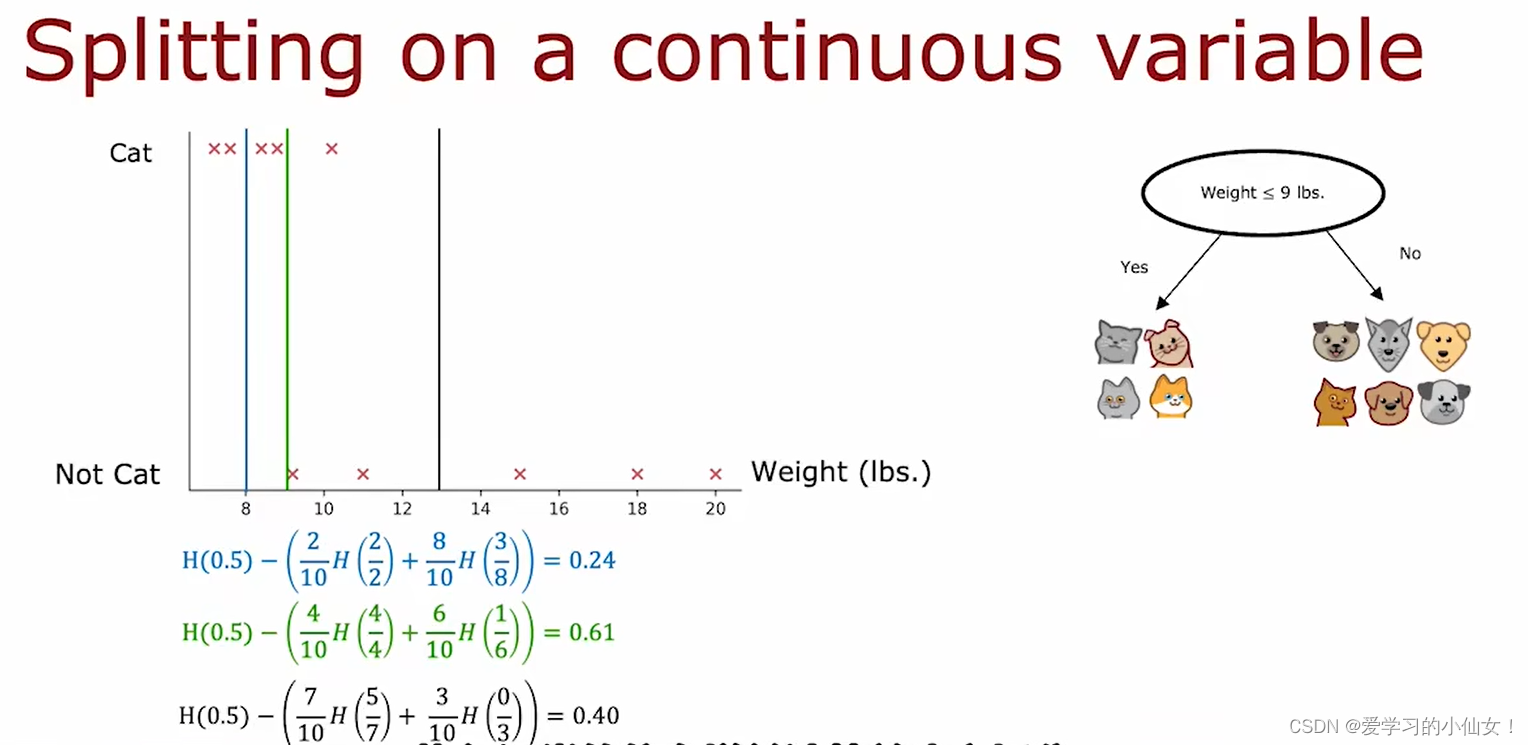

选择什么特征可以最大程度地减少熵 ? 熵的减少在 决策树 中称信息增益(information gain)

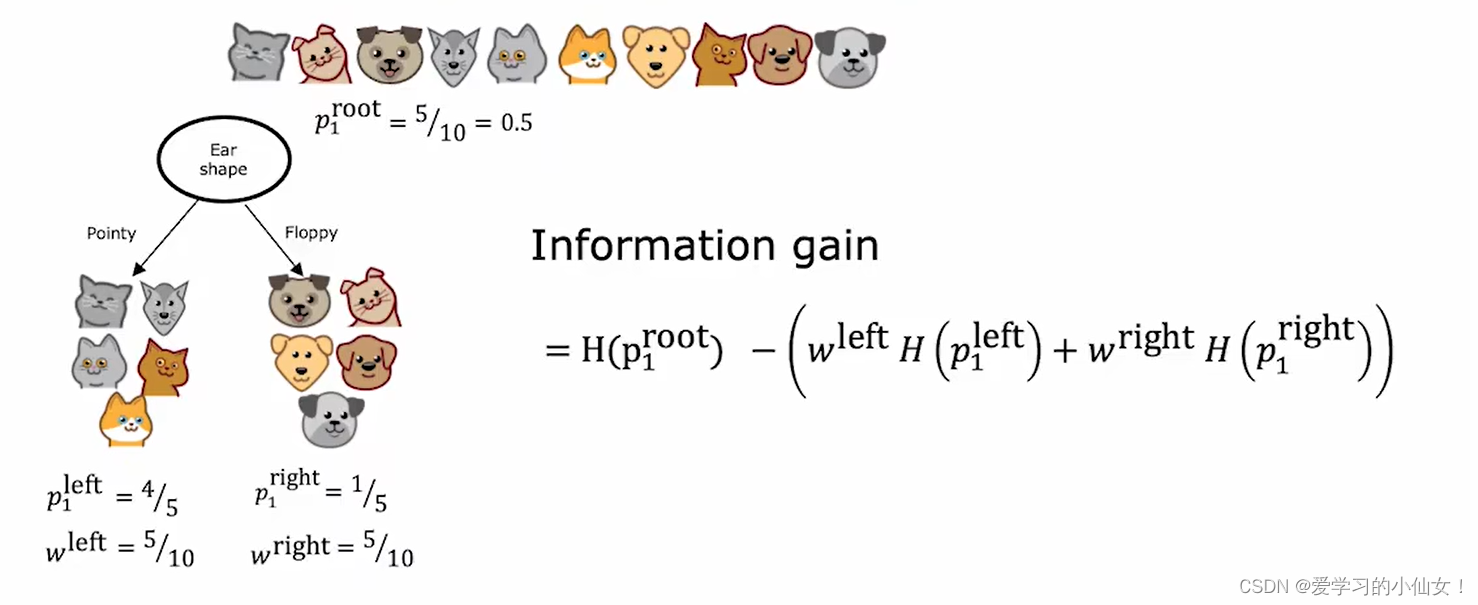

因为分到左右两支的样本数不同,所以要计算左右两个子树的熵的加权平均

实际中要对比的熵的减少,用根结点的熵减去计算出的加权平均,得到的结果就是信息增益,衡量的是让树分裂而导致的纯度的提升。如果计算出来 没减少多少熵,那么就不必冒着过拟合的风险再分裂树。

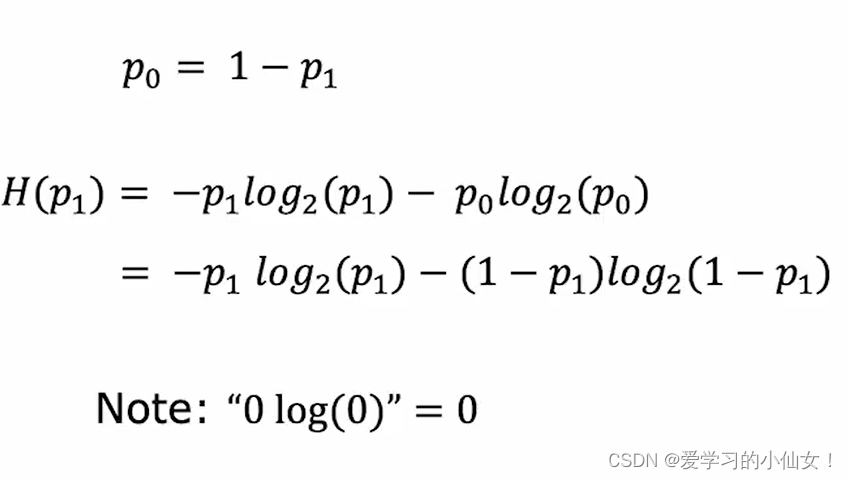

熵的计算公式:

其中 p 是当前这个结点有多少是正样本(多少只猫),w 是有多少样本进入到了这个结点

![Leetcode209-长度最小的子数组[两种方法] 关键词 滑窗 二分答案 前缀和](https://img-blog.csdnimg.cn/direct/bc6437a3a2a14276ad1fc18bd6702b3f.png)