网络爬虫的基本原理涉及到从互联网上自动收集信息的过程。这一过程通常包括请求网页、解析内容、提取数据、存储数据等关键步骤。在实现网络爬虫时,开发者会遇到各种问题,如反爬虫机制、数据解析难题、性能优化等。本文将通过Python示例,详细介绍网络爬虫的基本原理、实现方式及问题解决策略。

一、网络爬虫的基本原理

网络爬虫的工作原理可以概括为以下几个步骤:

初始URL集合:爬虫开始工作时,需要一个初始的URL列表,这个列表可以是用户指定的,也可以是从某个或某些已知网页上提取的链接。

URL队列:爬虫维护一个URL队列,用于存储待抓取的网页地址。初始URL集合是这个队列的起始内容。

下载网页:爬虫从URL队列中取出一个URL,使用HTTP或其他协议下载对应的网页内容。

解析内容:下载的网页内容通常是HTML格式,爬虫需要解析HTML文档,提取有用的信息,如文本内容、图片、链接等。

URL提取与去重:从提取的内容中,爬虫会进一步提取出新的URL链接,并将这些新链接加入到URL队列中。为了避免重复访问相同的网页,爬虫需要对新发现的URL进行去重处理。

数据处理:提取出的有用信息将按照既定的规则进行处理,可能包括数据清洗、格式化、存储等操作。

遵守规则:在整个过程中,爬虫需要遵守robots.txt协议和网站的访问策略,尊重网站的爬取限制。

循环过程:爬虫将重复上述过程,直到URL队列为空,或者达到了用户设定的条件,如爬取的深度、数量限制等。

二、网络爬虫的关键技术

多线程和异步IO:为了提高爬取效率,现代网络爬虫通常采用多线程或异步IO技术并行下载网页。

HTML解析:HTML解析是爬虫的核心技术之一,它需要将复杂的HTML文档转换为可操作的DOM树结构,以便提取所需数据。

动态内容处理:许多现代网站使用JavaScript动态生成内容。处理这类网页需要爬虫具备执行JavaScript代码的能力,这通常通过集成浏览器引擎或使用专门的库(如Selenium)来实现。

去重策略:为了避免重复处理相同的URL,爬虫需要实现高效的去重策略。常见的方法包括使用散列集合存储已访问的URL,或者使用更高级的数据结构如布隆过滤器。

数据存储:爬取的数据需要被存储以供后续处理。这可能涉及到数据库、文件系统或其他形式的数据存储方案。

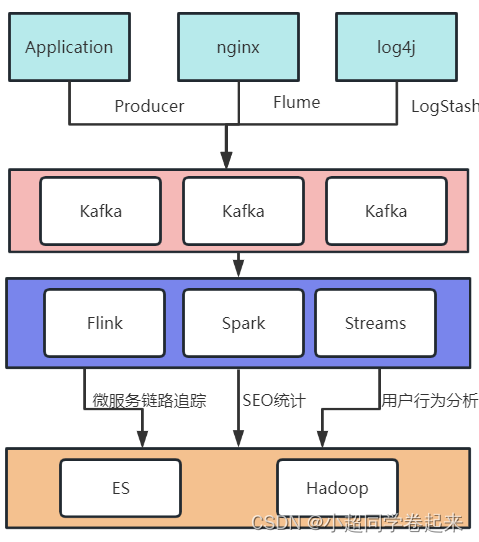

分布式爬虫:对于大规模的爬取任务,单机爬虫可能无法满足需求。分布式爬虫通过在多台机器上并行运行来提高爬取速度和效率。

三、Python爬虫实现

网络爬虫的工作流程大致可以分为以下几个步骤:

发送请求:爬虫通过HTTP协议向目标网站的服务器发送请求,请求可以是获取网页的GET请求,也可以是提交数据的POST请求。

获取响应:服务器接收到请求后,会返回响应数据,通常是HTML、JSON或其他格式的内容。

解析内容:爬虫需要解析服务器返回的内容,提取有用的数据。这一步骤可能涉及HTML解析、JSON解析等。

数据存储:将提取的数据保存到数据库、文件或其他存储系统中,以便后续使用。

遵守规则:在整个过程中,爬虫需要遵循robots.txt协议和网站的使用条款,尊重网站的爬取限制。

在Python中,常用的网络爬虫库有requests用于发送网络请求,BeautifulSoup和lxml用于解析HTML内容。以下是一个简单的爬虫示例,用于爬取一个网页的标题。

import requests

from bs4 import BeautifulSoup

# 目标网页URL

url = 'http://example.com'

# 发送GET请求

response = requests.get(url)

# 判断响应状态码,200表示成功

if response.status_code == 200:

# 使用BeautifulSoup解析HTML内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页的标题

title = soup.find('title').text

# 打印标题

print(title)

else:

print('请求失败,状态码:', response.status_code)

四、遇到的问题及解决策略

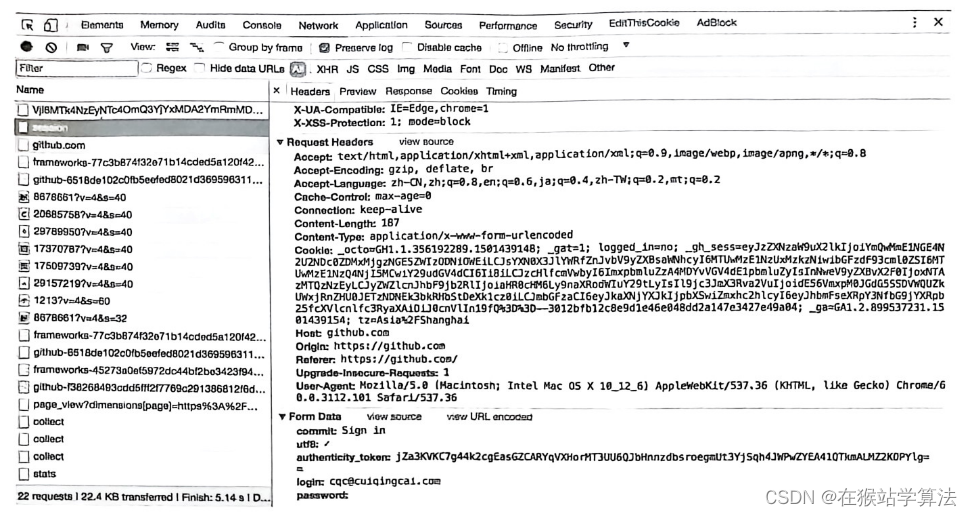

反爬虫机制:许多网站会实施反爬虫策略,如检查User-Agent、设置Cookies、使用验证码等。解决这类问题通常需要模拟浏览器行为,使用

requests库设置合适的请求头,或者使用Selenium等工具模拟浏览器操作。动态内容加载:一些网站的内容是通过JavaScript动态加载的,直接请求网页源码无法获取完整内容。解决这个问题可以使用

Selenium等工具,它可以启动一个浏览器实例,执行JavaScript并获取动态加载的内容。数据解析:解析复杂网页时,可能会遇到解析困难的问题。这时可以使用更强大的解析库如

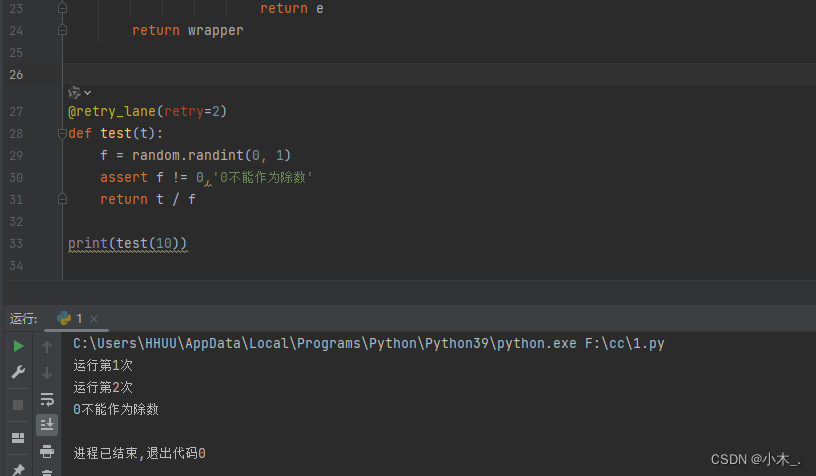

lxml,或者利用正则表达式提取特定模式的数据。性能优化:对于大规模的爬取任务,性能成为关键问题。可以通过多线程、异步请求等方式提高爬取效率。Python的

threading库和asyncio库提供了实现多线程和异步编程的能力。遵守法律法规:在爬取数据时,必须遵守相关的法律法规,尊重网站的robots.txt规则,合理设置爬取频率和时间,避免给网站服务器造成过大压力。

络爬虫是一种强大的工具,可以自动化地收集和处理互联网上的信息。然而,有效地实现和维护一个网络爬虫需要深入理解其工作原理,熟悉相关的技术和工具,并能够应对各种可能出现的问题。随着技术的发展和网站反爬虫技术的不断进步,网络爬虫的开发和维护也是一个不断学习和适应的过程。通过实践和不断优化,可以构建出高效、稳定且符合法律法规要求的网络爬虫系统。