摘要:

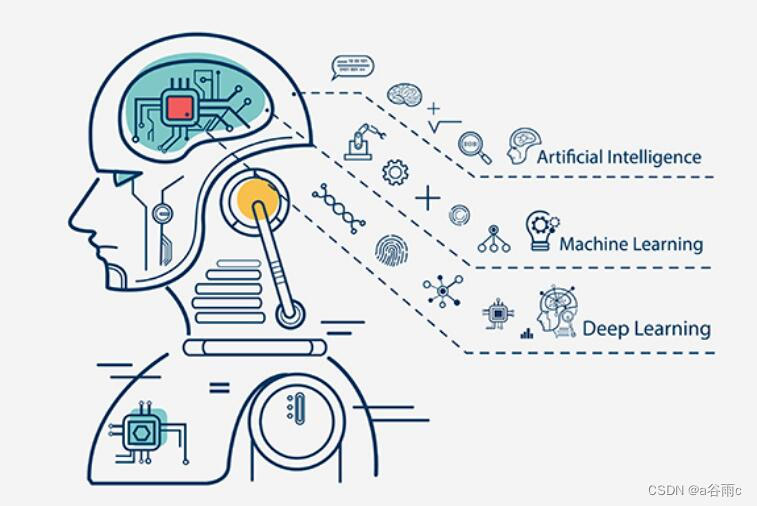

自监督学习的新前沿,特别是大型模型在自然语言处理中的应用,正在引领自然语言处理领域的发展。本文将概述自监督学习的新前沿,特别是大型模型在自然语言处理中的应用,以及其在自然语言处理领域的重要性和应用前景。

引言:

自监督学习是一种无需人工标注数据即可进行训练的学习方法,近年来在自然语言处理领域取得了显著的进展。大型模型,如Transformer、BERT、GPT等,在自监督学习中发挥着重要作用。本文将介绍自监督学习的概念,以及其在自然语言处理领域的重要性,并引出大型模型在其中的应用。

基础知识回顾:

自监督学习是一种无需人工标注数据即可进行训练的学习方法。它通过设计一些预测任务,使模型能够从未标注的数据中学习到有用的表示。自然语言处理是人工智能领域的一个重要分支,旨在使计算机能够理解和生成人类语言。

核心组件:

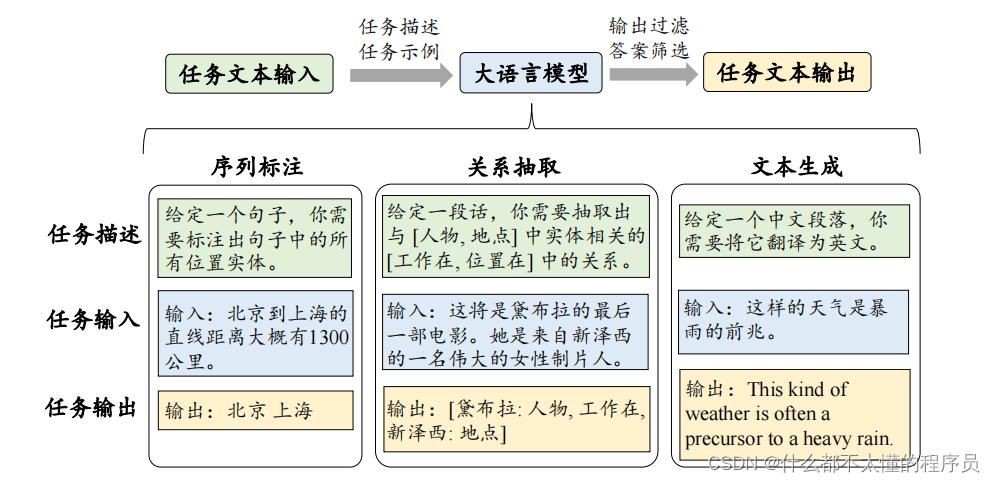

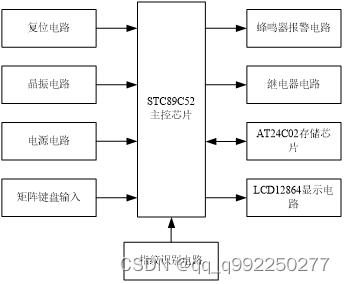

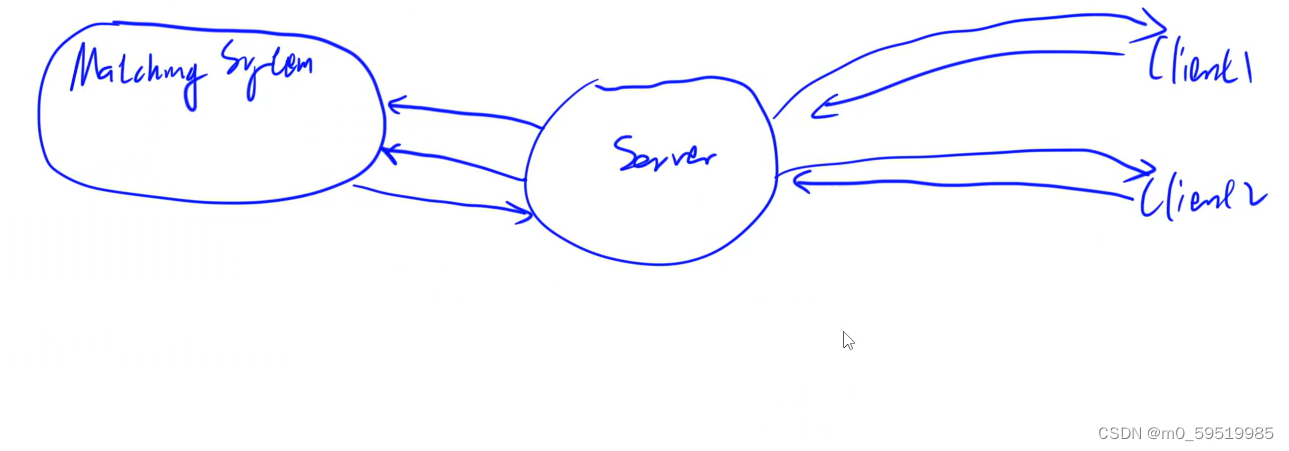

大型模型在自然语言处理中的核心组件包括Transformer、BERT、GPT等模型结构。这些模型通过自监督学习任务,如掩码语言模型和下一句预测,从未标注的数据中学习到丰富的语言表示。

实现步骤:

利用大型模型进行自监督学习的实现步骤包括数据预处理、模型训练和微调。数据预处理包括分词、编码和批量生成等操作。模型训练通过设计自监督学习任务,使模型从未标注的数据中学习到有用的表示。微调是在特定任务上对模型进行进一步训练,以提高其在特定任务上的性能。

代码示例:

from transformers import BertTokenizer, BertForMaskedLM

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForMaskedLM.from_pretrained('bert-base-uncased')

input_ids = tokenizer.encode("Hello, how are you?")

mask = [1 if i == tokenizer.mask_token_id else 0 for i in input_ids]

input_ids = torch.tensor(input_ids).unsqueeze(0)

mask = torch.tensor(mask).unsqueeze(0)

outputs = model(input_ids, mask)

predictions = outputs[0]

技巧与实践:

在利用大型模型进行自监督学习过程中,需要注意以下几点:

- 选择合适的预训练模型和超参数。

-

- 数据预处理要充分,包括分词、编码和批量生成等操作。

-

- 在微调过程中,可以根据具体任务调整学习率和训练轮数。

性能优化与测试:

为了确保大型模型在自然语言处理任务中的有效性,需要进行性能优化和测试。性能优化可以通过调整模型结构和超参数来实现。测试可以通过在特定任务上评估模型的性能来完成。

常见问题与解答:

- 如何选择合适的预训练模型?

- 答:选择预训练模型时,需要考虑模型的性能、计算资源和具体任务的需求。

- 如何进行数据预处理?

- 答:数据预处理包括分词、编码和批量生成等操作。需要根据具体任务和数据集进行选择和调整。

- 如何进行性能优化和测试?

- 答:性能优化可以通过调整模型结构和超参数来实现。测试可以通过在特定任务上评估模型的性能来完成。

结论与展望:

自监督学习在自然语言处理领域的新前沿,特别是大型模型的应用,正在引领自然语言处理领域的发展。未来,随着计算资源的增加和算法的改进,自监督学习将在自然语言处理领域发挥更大的作用。

附录:

- Devlin, J., Chang, M.-W., Lee, K., & Toutanova, K. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. arXiv preprint arXiv:1810.04805.

-

- Radford, A., Narasimhan, K., Salimans, T., & Sutskever, I. (2018). Improving Language Understanding by Generative Pre-Training. arXiv preprint arXiv:1801.06146.

-

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., … & Polosukhin, I. (2017). Attention is All You Need. arXiv preprint arXiv:1706.03762.

![[QT]自定义的QtabWidget](https://img-blog.csdnimg.cn/direct/52ed24c0306e4ea8a3846f376dfcb375.gif)