我是陌小北,每月不定时更新前一个月AI领域科研新进展,拿走不谢,欢迎提建议。

目前的分类包括:LLM研究、Agent、多模态、特定领域应用、世界模型。内容较多所以每个相对简略。

1. LLM研究

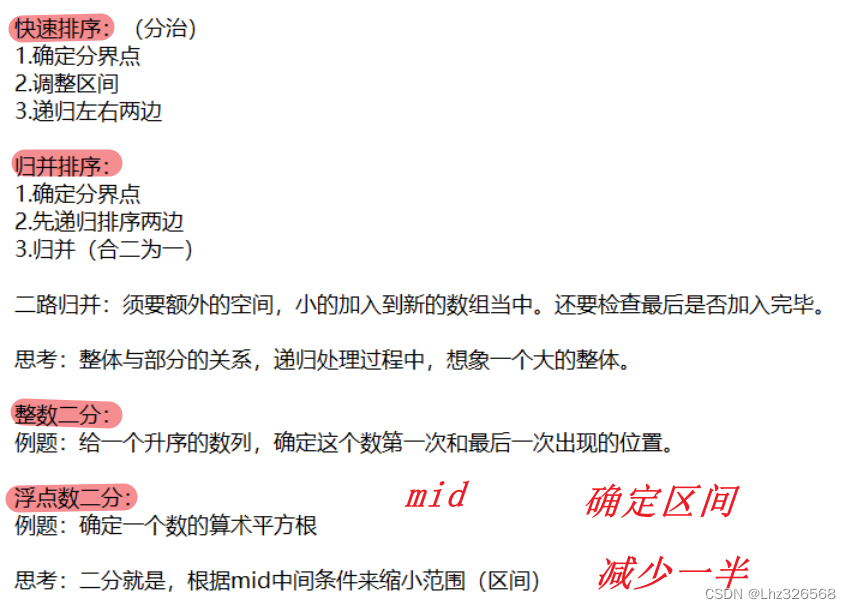

(1)通过任务分解提高大模型推理效率

论文标题: Divide-or-Conquer? Which Part Should You Distill Your LLM?

发布机构: 密歇根大学,苹果公司

论文链接: https://arxiv.org/abs/2402.15000

主要内容: 本文提出了一种策略,将复杂推理任务分解为问题分解阶段和问题解决阶段,并展示了这种策略能够胜过单一阶段解决方案。研究者们假设分解阶段比解决问题阶段更容易蒸馏到一个更小的模型中,因为后者需要大量的领域知识,而前者只需要学习一般的解决问题策略。文章提出了蒸馏这两种能力的方法,并评估了它们对推理结果和推理成本的影响。研究发现,可以蒸馏问题分解阶段,同时在不同任务、数据集和模型之间保持良好的泛化能力。然而,蒸馏问题解决能力在不损失性能的情况下更加困难,并且由此产生的蒸馏模型在泛化方面存在挑战。这些结果表明,通过使用较小的、蒸馏过的问题分解模型与问题解决的大型语言模型相结合,我们可以实现具有成本效益的推理和本地适应。

(2)移动设备上的高效大型语言模型(MobileLLM)

论文标题: MobileLLM: Optimizing Sub-billion Parameter Language Models for On-Device Use Cases

发布机构: Meta实验室,PyTorch

论文链接: https://arxiv.org/abs/2402.14905

主要内容: 本文针对移动设备上高效大型语言模型(LLMs)的需求进行了研究,特别是在云成本增加和延迟问题日益突出的背景下。研究者们专注于设计少于10亿参数的顶级LLMs,这是移动部署的一个实用选择。与强调数据和参数数量在决定模型质量中的关键作用的普遍观点相反,本研究强调了模型架构对于亚10亿规模LLMs的重要性。通过利用深度和薄架构,结合嵌入共享和分组查询注意力机制,研究者们建立了一个强大的基线网络,称为MobileLLM,与之前的125M/350M最先进模型相比,准确率提高了2.7%/4.3%。此外,提出了一种即时块权重共享方法,无需增加模型大小,只有边际延迟开销,从而使MobileLLM-LS模型在性能上进一步提升了0.7%/0.8%。

(3)优化语言模型的学习:减少训练步骤的理论

论文标题: Towards Optimal Learning of Language Models

发布机构: 清华大学,微软研究院

论文链接: https://arxiv.org/abs/2402.17759

主要内容: 本研究探讨了提高语言模型(LMs)学习效率的一般原则,旨在减少达到卓越性能所需的训练步骤。研究者们提出了一个理论,通过最大化数据压缩比来优化LM学习。他们提出了一个名为“学习定律”的定理,揭示了在优化目标下,最优学习过程中的动态特性。该定理通过在线性分类和真实世界的语言建模任务上的实验得到了验证。最后,研究者们通过实验验证了LMs的最优学习本质上源于学习过程中的系数改进,这为设计实用的学习加速方法提供了巨大的希望和意义。

(4)扩展大型语言模型的上下文窗口至200万以上

论文标题: LongRoPE: Extending LLM Context Window Beyond 2 Million Tokens

发布机构: 微软研究院

论文链接: https://arxiv.org/abs/2402.13753

主要内容: 本文介绍了LongRoPE方法,首次将预训练的大型语言模型(LLMs)的上下文窗口扩展到令人印象深刻的2048k个标记,同时在保持原始短上下文窗口性能的同时,仅需1k次微调步骤。这是通过三个关键创新实现的:首先,通过有效搜索识别并利用位置插值中的两种非均匀性,为微调提供了更好的初始化,并在非微调情况下实现了8倍扩展;其次,引入了一种渐进式扩展策略,首先对256k长度的LLM进行微调,然后在微调后的扩展LLM上进行第二次位置插值,以实现2048k的上下文窗口;最后,对8k长度的LongRoPE进行调整,以恢复短上下文窗口的性能。在LLaMA2和Mistral上进行的广泛实验证明了我们方法的有效性。通过LongRoPE扩展的模型保留了原始架构,并对位置嵌入进行了轻微修改,可以重用大部分现有的优化。

(5)LONGAGENT: 通过多智能体协作扩展语言模型至128k上下文

论文标题: LONGAGENT: Scaling Language Models to 128k Context through Multi-Agent Collaboration

发布机构: 复旦大学计算机科学学院

论文链接: https://arxiv.org/abs/2402.11550

主要内容: 本文提出了一种名为LONGAGENT的方法,它基于多智能体协作,能够将大型语言模型(LLMs)的上下文扩展至128K,与GPT-4相比,在长文本处理方面展现出潜在的优越性。LONGAGENT通过一个领导者和多个成员的团队合作,领导者负责理解用户意图、指导成员获取信息并解决冲突。为了解决成员幻觉问题,研究者开发了一种成员间通信机制,通过信息共享解决由幻觉引起的响应冲突。实验结果表明,LONGAGENT在处理长文本方面提供了一种有前景的替代方案,尤其是在128k长文本检索和多跳问答任务中,与GPT-4相比取得了显著的改进。

(6)Aligner: 通过弱到强的纠正实现高效对齐

论文标题: Aligner: Achieving Efficient Alignment through Weak-to-Strong Correction

发布机构: 北京大学人工智能安全与治理中心

论文链接: https://arxiv.org/abs/2402.02416

主要内容: 本文介绍了Aligner,一种新的高效对齐范式,它通过学习对齐和未对齐答案之间的校正残差,绕过了整个基于人类反馈的强化学习(RLHF)过程。Aligner是一个自回归的seq2seq模型,通过监督学习在查询-答案-校正数据集上进行训练,提供了一种参数高效的对齐解决方案。此外,Aligner支持从弱到强的泛化,即通过Aligner的监督信号微调大型预训练模型,可以显著提升性能。Aligner作为一个模型无关的即插即用模块,可以直接应用于不同的开源和基于API的模型。实验结果表明,Aligner-7B在11种不同的LLMs上平均提高了21.9%的有用性和23.8%的无害性(GPT-4分别提高了17.5%和26.9%)。

2. Agent

(1)大型多模态代理:综述

论文标题: Large Multimodal Agents: A Survey

发布机构: 香港中文大学(深圳)、大数据研究院、中山大学

论文链接: https://arxiv.org/abs/2402.15116

主要内容: 本文系统性地回顾了由大型语言模型(LLMs)驱动的多模态智能代理(LMAs),这些代理能够处理文本、图像、视频和音频等多种模态的信息。论文首先介绍了LMAs开发所涉及的核心组件,并将现有研究分为四种类型。接着,论文回顾了整合多个LMAs的协作框架,以提高集体效能。论文还讨论了评估LMAs的多样化方法,并提出了一个全面的评估框架以标准化评估,促进更有意义的比较。最后,论文强调了LMAs在现实世界中的广泛应用,并提出了未来研究的可能方向。论文的目标是为这一快速发展领域提供有价值的见解和指导。

(2)Agent-Pro: 通过策略级反思和优化学习进化的代理

论文标题: Agent-Pro: Learning to Evolve via Policy-Level Reflection and Optimization

发布机构: 浙江大学计算机科学与技术学院,中国科学院软件研究所,南京邮电大学,南京信息工程大学,北京工业大学,中国科学院大学南京

论文链接: https://arxiv.org/abs/2402.17574

主要内容: 本文提出了Agent-Pro,一个基于大型语言模型(LLM)的代理,它能够通过交互体验学习并逐步提升其行为策略。Agent-Pro涉及动态信念生成和反思过程,以实现策略的进化。与传统的基于LLM的代理不同,它不是通过手动设计的提示来告知任务规则和调节行为,而是能够自主地通过反思过去的轨迹和信念来“微调”其不合理的信念,从而形成更好的策略。此外,Agent-Pro采用了深度优先搜索来优化策略,确保策略收益的持续提升。在Blackjack和Texas Hold’em两个游戏中的评估表明,Agent-Pro能够学习和在复杂动态场景中进化,这同样有益于众多基于LLM的应用。

(3)移动代理:具有视觉感知的自主多模态移动设备代理

论文标题: MOBILE-AGENT: AUTONOMOUS MULTI-MODAL MOBILE DEVICE AGENT WITH VISUAL PERCEPTION

发布机构: 北京交通大学,阿里巴巴集团

论文链接: https://arxiv.org/abs/2401.16158

主要内容:

本文介绍了Mobile-Agent,一个基于多模态大型语言模型(MLLM)的自主多模态移动设备代理。Mobile-Agent利用视觉感知工具准确识别和定位应用前端界面中的视觉和文本元素。基于感知到的视觉上下文,它能够自主规划和分解复杂操作任务,并通过逐步操作导航移动应用。与依赖于应用或移动系统元数据的XML文件的先前解决方案不同,Mobile-Agent在视觉为中心的方式下提供了更大的适应性,消除了对系统特定定制的需求。为了评估Mobile-Agent的性能,作者引入了MobileEval,一个用于评估移动设备操作的基准测试。基于MobileEval,对Mobile-Agent进行了全面评估。实验结果表明,Mobile-Agent在准确性和完成率方面取得了显著成果。即使在具有挑战性的指令下,如多应用操作,Mobile-Agent也能够完成要求。

(4)PreAct:在反应中预测未来以增强代理的规划能力

论文标题: PreAct: Predicting Future in ReAct Enhances Agent’s Planning Ability

发布机构: 北京邮电大学,美团

论文链接: https://arxiv.org/abs/2402.11534

主要内容: 本文介绍了PreAct,一个将预测与推理和行动相结合的代理框架。通过利用预测提供的信息,基于大型语言模型(LLM)的代理能够提供更多样化和战略导向的推理,从而采取更有效的行动帮助代理完成复杂任务。实验表明,PreAct在完成复杂任务方面优于ReAct方法,并且当与Reflexion方法结合时,PreAct可以得到共同增强。研究者通过给模型提供不同数量的历史预测,并发现历史预测对LLM规划有持续的积极影响。PreAct与ReAct在单步推理上的差异表明,PreAct在多样性和战略指导方面确实优于ReAct。

3. 多模态

(1)Sora:关于大型视觉模型的背景、技术、局限性和机遇的综述

论文标题: Sora: A Review on Background, Technology, Limitations, and Opportunities of Large Vision Models

发布机构: 利哈伊大学,微软研究院

论文链接: https://arxiv.org/abs/2402.17177

主要内容:

本文是对OpenAI在2024年2月发布的文本到视频生成AI模型Sora的全面综述。Sora能够根据文本指令生成现实或想象的视频场景,展示了在模拟物理世界方面的潜力。文章基于公开技术报告和逆向工程,详细介绍了Sora的开发背景、相关技术、应用、面临的挑战以及文本到视频AI模型的未来发展方向。首先追溯了Sora的发展,并调查了构建这个“世界模拟器”所使用的底层技术。然后详细描述了Sora在电影制作、教育、游戏等多个行业的应用及其潜在影响。讨论了需要解决的主要挑战和局限性,例如确保视频生成的安全性和无偏见。最后,讨论了Sora和视频生成模型的未来发展,以及该领域的进步如何能够使新的人工智能交互方式成为可能,提高视频生成的生产力和创造力。

(2)EMO: Emote Portrait Alive - 生成富有表现力的肖像视频,音频到视频的扩散模型在弱条件下的应用

论文标题: EMO: Emote Portrait Alive - Generating Expressive Portrait Videos with Audio2Video Diffusion Model under Weak Conditions

发布机构: 阿里巴巴集团智能计算研究所

论文链接: https://arxiv.org/abs/2402.17485

主要内容: 本文提出了EMO,一种新颖的框架,利用直接的音频到视频合成方法,无需中间的3D模型或面部标记。该方法确保了视频帧之间的无缝过渡和一致的身份保持,从而产生高度表现力和逼真度的动画。实验结果表明,EMO不仅能够制作令人信服的说话视频,还能制作各种风格的唱歌视频,显著超越了现有的最先进方法。

(3)LAVE: 视频编辑中的LLM驱动代理协助与语言增强

论文标题: LAVE: LLM-Powered Agent Assistance and Language Augmentation for Video Editing

发布机构: 多伦多大学、Meta Reality Labs Research、加州大学圣地亚哥分校、Meta Reality Labs Research、Meta Reality Labs Research

论文链接: https://arxiv.org/abs/2402.10294

主要内容: 本文探讨了将大型语言模型(LLMs)集成到视频编辑工作流程中以降低初学者编辑障碍的可能性。LAVE系统提供了LLM支持的代理协助和语言增强的编辑功能,可以自动为用户的视频生成语言描述,为LLM处理视频和协助编辑任务提供基础。用户研究显示,LAVE在帮助视频编辑方面有效,并揭示了用户对LLM辅助编辑范式的接受程度以及其对用户创造力和共同创作感的影响。

(4)ChatMusician: 与LLM内在地理解和生成音乐

论文标题: ChatMusician: Understanding and Generating Music Intrinsically with LLM

发布机构: 香港科技大学、Skywork AI PTE. LTD.

论文链接: https://arxiv.org/abs/2402.16153

主要内容: 本文介绍了ChatMusician,一个开源的LLM,它集成了内在的音乐能力。ChatMusician基于持续预训练和微调LLaMA模型,使用与文本兼容的音乐表示法ABC记谱法,将音乐视为第二种语言。ChatMusician能够在纯文本标记器中理解和生成音乐,而无需任何外部多模态神经结构或标记器。有趣的是,赋予音乐能力并不会损害语言能力,甚至在MMLU分数上略有提高。ChatMusician能够创作结构良好、全长的音乐,条件包括文本、和弦、旋律、动机、音乐形式等,超越了GPT-4基线。在精心策划的大学级音乐理解基准MusicTheoryBench上,ChatMusician在零样本设置下显著超越了LLaMA2和GPT-3.5。

(5)SongComposer: 歌曲创作大型语言模型

论文标题: SongComposer: A Large Language Model for Lyric and Melody Composition in Song Generation

发布机构: 香港中文大学、北京航空航天大学、上海人工智能实验室

论文链接: https://arxiv.org/abs/2402.17645

主要内容: 本文介绍了SongComposer,一个创新的大型语言模型(LLM),专为歌曲创作设计。它能够理解和生成具有象征性歌曲表示的旋律和歌词,通过利用LLM的能力。与现有将音乐视为量化音频信号的方法不同,SongComposer采用人类为音乐设计的成熟且高效的方式——象征性歌曲表示,使LLM能够像人类一样明确地创作歌曲。在实践中,作者设计了一种新颖的元组格式,用于格式化旋律中的歌词和三个音符属性(音高、持续时间和休息时间),确保LLM正确理解音乐符号并实现歌词和旋律之间的精确对齐。为了赋予LLM基本的音乐理解,作者精心收集了SongCompose-PT,这是一个大规模的歌曲预训练数据集,包括中文或英文的歌词、旋律以及成对的歌词旋律。通过充分的预训练,使用10K精心制作的问答对来赋予LLM指令跟随能力,解决多样化的任务。通过广泛的实验,SongComposer在歌词到旋律生成、旋律到歌词生成、歌曲延续和文本到歌曲创作等任务中表现出优越性能,超越了像GPT-4这样的先进LLM。

(6)AnyGPT: 统一的多模态大型语言模型,具有离散序列建模

论文标题: AnyGPT: Unified Multimodal LLM with Discrete Sequence Modeling

发布机构: 复旦大学、多模态艺术投影研究社区、上海人工智能实验室

论文链接: https://arxiv.org/abs/2402.12226

主要内容: 本文介绍了AnyGPT,一个任何到任何的多模态语言模型,它利用离散表示统一处理各种模态,包括语音、文本、图像和音乐。AnyGPT可以在不改变当前大型语言模型(LLM)架构或训练范式的情况下稳定训练。它完全依赖于数据级预处理,便于将新模态无缝整合到LLM中,类似于添加新语言。作者构建了一个多模态文本中心数据集进行多模态对齐预训练。利用生成模型,合成了第一个大规模的任何到任何多模态指令数据集,包含108k个多轮对话样本,这些样本复杂地交织了各种模态,使模型能够处理任意组合的多模态输入和输出。实验结果表明,AnyGPT能够在所有模态中进行任何到任何的多模态对话,同时在所有模态中实现与专门模型相当的性能,证明了离散表示可以有效且方便地在语言模型中统一多个模态。

(7)Image Anything: 多模态图像生成

论文标题: Image Anything: Towards Reasoning-coherent and Training-free Multi-modal Image Generation

发布机构: 香港科技大学(广州)、香港科技大学

论文链接: https://arxiv.org/abs/2401.17664

主要内容: 本文提出了ImgAny,一种新颖的无需训练的多模态图像生成框架,可以模仿人类推理并从任何模态(如语言、音频、图像、点云、热图、深度和事件数据)生成高质量图像。ImgAny巧妙地在实体和属性级别整合和协调多种输入模态,无需针对模态进行特定调整即可生成视觉上吸引人的图像。该方法的关键在于模仿人类的认知过程,通过实体知识图谱提取实体特征,并通过属性知识图谱有效地融合来自不同输入模态的不同属性特征。最后,实体和属性特征被适应性地融合为预训练的稳定扩散模型的条件输入,用于图像生成。广泛的实验在不同的模态组合下展示了其在视觉内容创作方面的卓越能力。

(8)MM-LLMs: 多模态大型语言模型的最新进展

论文标题: MM-LLMs: Recent Advances in MultiModal Large Language Models

发布机构: 腾讯AI实验室、京都大学、中国科学院沈阳自动化研究所

论文链接: https://arxiv.org/abs/2401.13601

主要内容: 本文提供了一份全面的调查,旨在促进多模态大型语言模型(MM-LLMs)的进一步研究。文章首先概述了模型架构和训练流程的一般设计公式。然后,介绍了一个包含122个MM-LLMs的分类法,每个模型都有特定的公式。此外,回顾了选定的MM-LLMs在主流基准测试上的性能,并总结了关键的训练配方,以增强MM-LLMs的效能。最后,探索了MM-LLMs的有前景的研究方向,并建立了一个实时跟踪网站,以跟踪该领域最新的发展。希望这份调查能够为MM-LLMs领域的持续发展做出贡献。

4. 特定领域应用研究

(1)金融交易的多模态基础代理:工具增强、多样化和通用性

论文标题: A Multimodal Foundation Agent for Financial Trading: Tool-Augmented, Diversified, and Generalist

发布机构: 南洋理工大学(新加坡);浙江大学(中国)

论文链接: https://arxiv.org/abs/2402.18485

主要内容: 本文介绍了FinAgent,一个为金融交易设计的多模态基础代理。FinAgent通过工具增强、多样化记忆检索系统和双层次反思模块,能够快速适应市场动态并提高决策能力。实验表明,FinAgent在6个金融数据集上的表现显著优于9种最先进的基准线模型,平均利润提高了36%以上。

(2)FinTral:为金融分析量身定制的GPT-4级别的多模态大型语言模型家族

论文标题: FinTral: A Family of GPT-4 Level Multimodal Financial Large Language Models

发布机构: 不列颠哥伦比亚大学(加拿大);Invertible AI

论文链接: https://arxiv.org/abs/2402.10986

主要内容: 本研究提出了FinTral,一系列基于Mistral-7b模型的最先进的多模态大型语言模型(LLMs),专门用于金融分析。FinTral整合了文本、数值、表格和图像数据,并通过领域特定的预训练、指令微调和RLAIF训练进行了增强。研究还引入了一个包含九个任务和25个数据集的广泛基准测试,用于评估模型性能。

(3)面向参与式城市规划的大型语言模型

论文标题: Large Language Model for Participatory Urban Planning

发布机构: 清华大学(中国)

论文链接: https://arxiv.org/abs/2402.17161

主要内容: 本研究提出了一个基于大型语言模型(LLMs)的多代理协作框架,用于参与式城市规划。该框架通过模拟规划者和居民的代理,生成满足居民多样化需求的土地利用计划。研究在北京的两个真实区域进行了部署,结果表明该方法在居民满意度和包容性指标上达到了最先进的性能,并在服务可达性和生态指标上超越了人类专家。

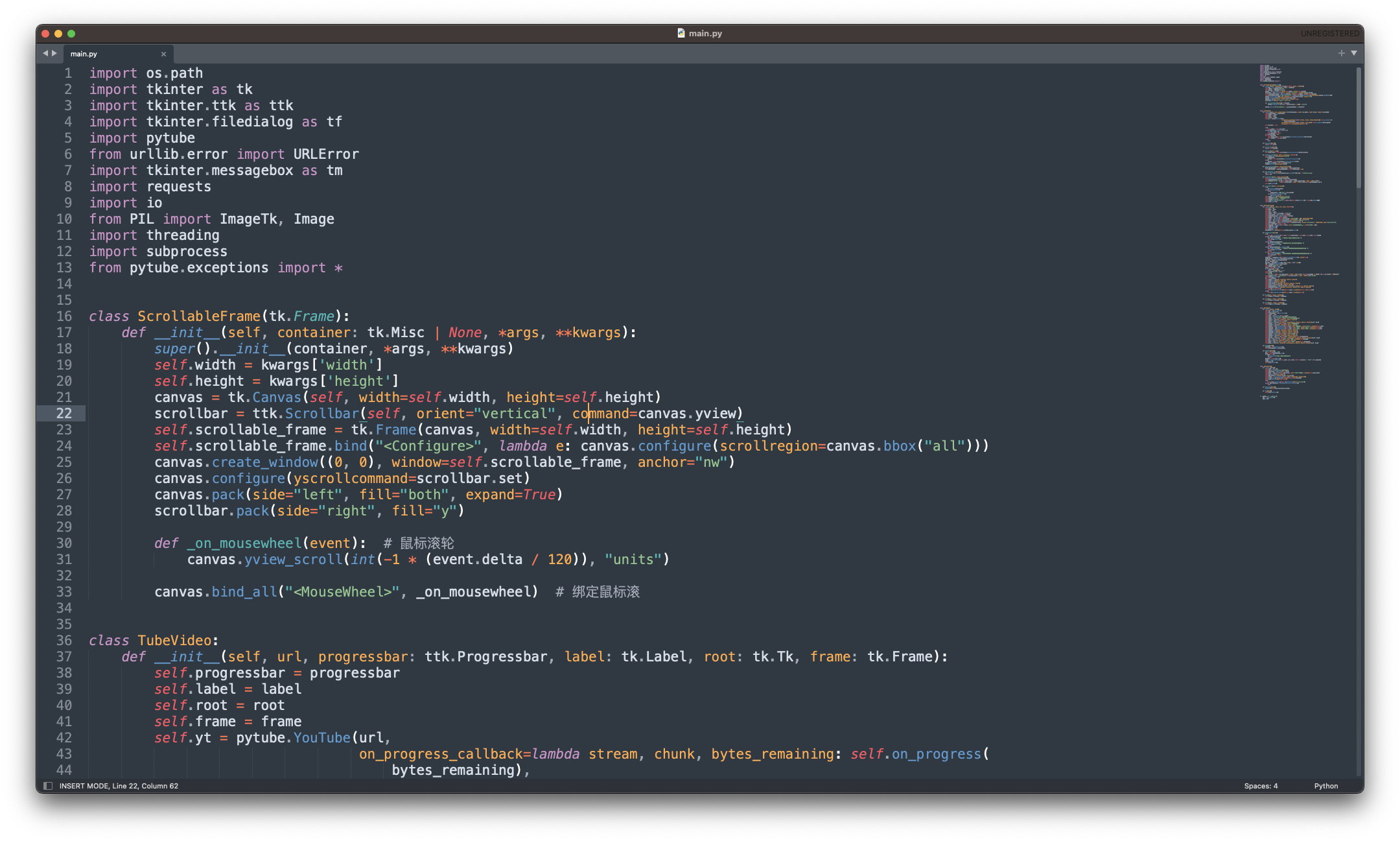

(4)推进GenAI辅助编程——GPT-4与GLM-4在提示效率和代码质量方面的比较研究

论文标题: Advancing GenAI Assisted Programming— A Comparative Study on Prompt Efficiency and Code Quality Between GPT-4 and GLM-4

发布机构: 悉尼大学(澳大利亚);上海交通大学(中国)

论文链接: https://arxiv.org/abs/2402.12782

主要内容: 本研究通过比较GPT-4和GLM-4,探索了利用GenAI作为编程工具的最佳实践。研究发现,简单直接的提示策略能够产生最佳的代码生成结果。此外,添加类似Chain-of-Thought(CoT)的初步确认步骤可以进一步提高成功率。研究还发现,尽管GPT-4在平均用户中的表现略优于GLM-4,但差异很小。通过简化的评估模型,研究观察到与传统编码规范相比,代码生成效率提高了30到100倍。

(5)生成表达机器人行为使用大型语言模型

论文标题: Generative Expressive Robot Behaviors using Large Language Models

发布机构: Google Deepmind

论文链接: https://arxiv.org/abs/2401.14673

主要内容: 本文提出了一种新的方法,利用大型语言模型(LLMs)生成适应性强且可组合的表达性机器人行为。研究者们提出了一种基于少量样本的链式思维提示方法,将人类语言指令转换为使用机器人现有技能和已学习行为的参数化控制代码。通过用户研究和模拟实验,展示了该方法产生的行为能够被用户理解和接受。

(6)基于大型语言模型的推荐系统中的表示学习

论文标题: Representation Learning with Large Language Models for Recommendation

发布机构: 香港大学、百度

论文链接: https://arxiv.org/abs/2310.15950

主要内容: 该论文提出了一个模型无关的框架RLMRec,旨在通过LLMs增强现有推荐系统的表示学习。RLMRec结合了用户/物品的文本信号,通过跨视图对齐,将LLMs的语义空间与协作关系信号对齐。研究表明,通过最大化互信息,可以改善表示的质量。RLMRec与多种最先进的推荐模型集成,并分析了其对噪声数据的鲁棒性。

6.世界模型

(1)Genie:生成交互式环境

论文标题: Genie: Generative Interactive Environments

发布机构: Google DeepMind

论文链接: https://arxiv.org/abs/2402.15391

主要内容: 本文介绍了Genie,这是一个从未经标记的互联网视频数据中无监督训练的生成交互式环境。Genie能够根据文本、合成图像、照片甚至草图生成可控制的虚拟世界。作为一个具有110亿参数的模型,Genie可以被视为一个基础世界模型。它由时空视频分词器、自回归动态模型和简单且可扩展的潜在动作模型组成。Genie允许用户在生成的环境中进行帧级别的交互操作,即使在没有真实动作标签或其他领域特定要求的情况下。此外,学习到的潜在动作空间有助于训练代理从未见视频中模仿行为,为未来通用代理的训练铺平了道路。

(2)视频作为现实世界决策制定的新语言

论文标题: Video as the New Language for Real-World Decision Making

发布机构: Google DeepMind、加州大学伯克利分校、麻省理工学院

论文链接: https://arxiv.org/abs/2402.17139

主要内容: 本文讨论了视频数据在互联网上的丰富性以及其在大规模自监督学习中的作用,尤其是在下一个标记或帧预测方面。尽管视频数据在捕捉物理世界的重要信息方面具有独特价值,但视频生成模型在现实世界任务中的应用仍然有限。文章提出了视频生成模型可以作为规划器、代理、计算引擎和环境模拟器的可能性,并通过技术如上下文学习、规划和强化学习来实现。作者还指出了视频生成领域的关键挑战,并提出了可能的解决方案,以释放视频生成在更广泛的AI应用中的独特价值。

(3)超越语言模型:字节模型是数字世界模拟器

论文标题: Beyond Language Models: Byte Models are Digital World Simulators

发布机构: 微软亚洲研究院、中央音乐学院、独立研究者、清华大学

论文链接: https://arxiv.org/abs/2402.19155

主要内容: 本文介绍了bGPT模型,它通过预测下一个字节来模拟数字世界。bGPT在文本、音频和图像等多种模态上与专门模型的性能相匹配,并为预测、模拟和诊断算法或硬件行为提供了新的可能性。bGPT在将符号音乐数据转换为MIDI格式的过程中几乎无误,错误率仅为0.0011比特/字节。此外,bGPT在模拟CPU行为方面表现出色,执行各种操作的准确率超过99.99%。通过下一个字节预测,像bGPT这样的模型可以直接从庞大的二进制数据中学习,有效地模拟数字世界的复杂模式。