导 读

在快速发展的机器学习领域,特别是深度学习,训练算法的效率和有效性至关重要。学习率作为这些算法的一个关键因素,决定了梯度下降期间的步长。

而余弦退火作为用于优化学习率的一种新颖且日益流行的技术。本文将深入探讨了余弦退火的概念、其理论基础、实际应用以及它在深度学习领域提供的优势。

有需要的朋友关注公众号【小Z的科研日常】,获取更多内容。

01、深度学习中学习率的概念

在理解余弦退火之前,有必要了解学习率在深度学习中的作用。学习率是一个超参数,控制神经网络在训练过程中调整权重的程度。

它影响网络收敛到损失函数的最小值——这是模型性能的关键因素。学习率太高可能会导致不稳定的行为,而学习率太低可能会导致训练过程极其缓慢或陷入局部最小值。

02、余弦退火:动态方法

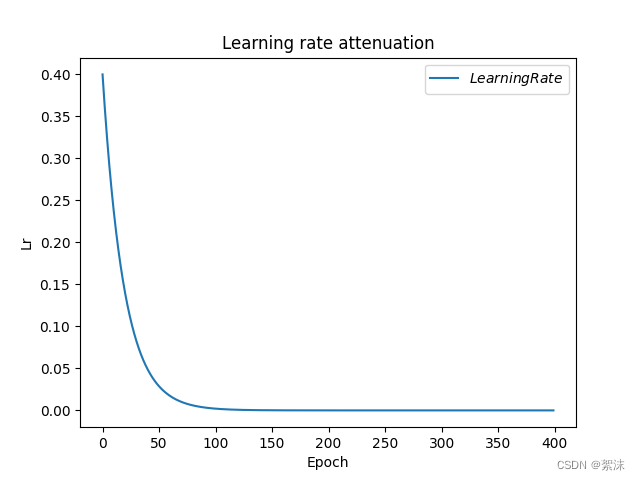

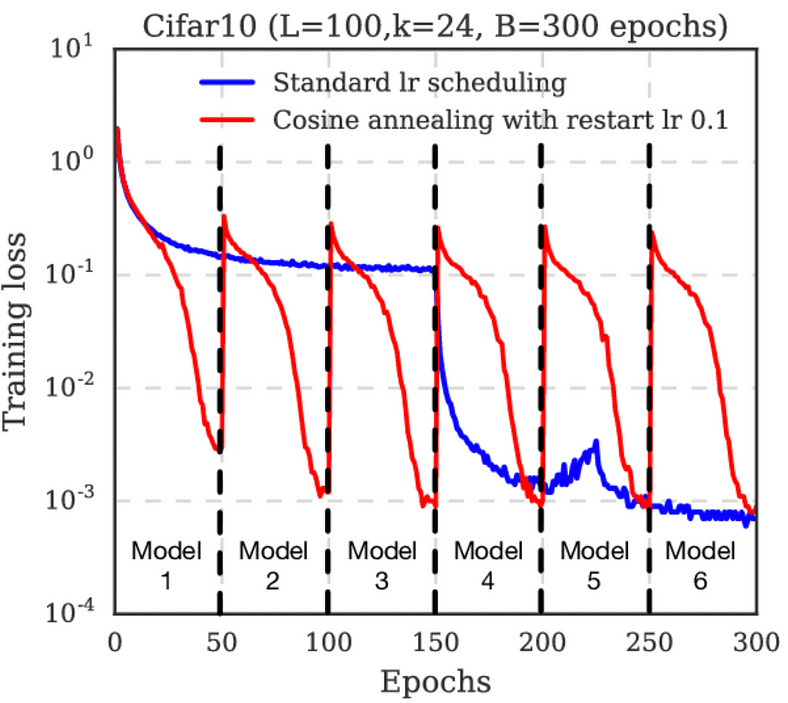

余弦退火作为一种动态学习率调度方法出现。它按照余弦曲线调整学习率。该技术的灵感来自于余弦函数的数学特性,余弦函数以其平滑和周期性的特性而闻名。学习率从最大值开始,并在多个时期内沿着余弦曲线逐渐减小到最小值。

余弦退火是机器学习中用于在训练过程中调整学习率的一种方法。它基于余弦函数,其中学习率沿着余弦曲线逐渐减小。这种方法通常用于神经网络训练中,以微调学习率以获得更好的性能和收敛性。

基本思想是从较高的学习率开始,然后根据多个时期的余弦函数降低学习率。学习率表可以可视化为一条平滑曲线,从高开始并逐渐接近零。这种方法对于更有效地应对损失情况很有用,有可能在训练过程中产生更好的解决方案。

余弦退火对于避免损失景观中的局部极小值以及在训练的后期阶段微调模型特别有效。它是称为学习率调度的更广泛技术的一部分,这对于有效训练深度神经网络至关重要。

03、余弦退火总结分析

3.1理论基础

余弦退火的理论基础在于它能够驾驭深度神经网络复杂的高维损失场景。通过动态调整学习率,余弦退火在损失表面平坦时允许较大的步长,在表面陡峭时允许较小的步长。这种适应性有助于避免局部最小值和鞍点的陷阱——神经网络训练中的常见挑战。

3.2实际应用和好处

余弦退火在深度学习的各个领域(从图像识别到自然语言处理)都有广泛的应用。与恒定或基于步进的学习率计划相比,它的主要好处是实现更快的收敛。此外,余弦退火可以带来更好的泛化能力,降低过度拟合的风险。当模型的微调至关重要时,它在训练的后期阶段特别有效。

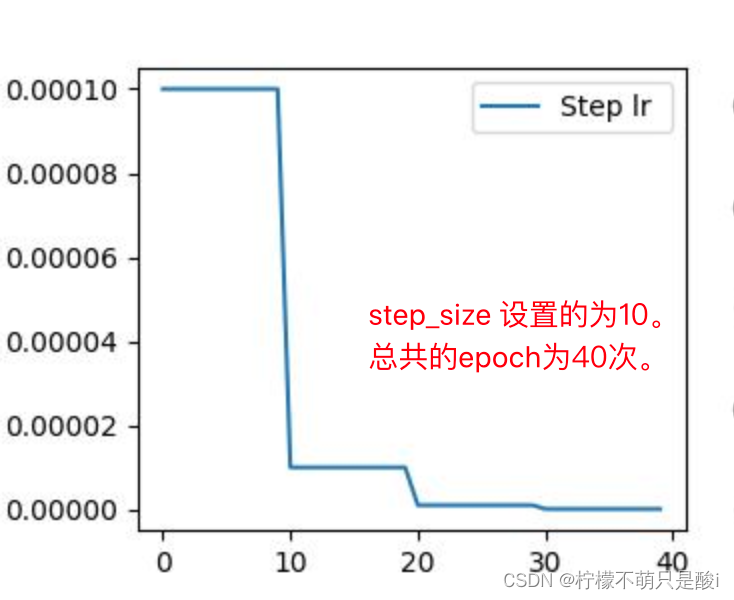

3.3与其他调度技术的比较分析

与步长衰减或指数衰减等其他学习率调度技术相比,余弦退火因其平滑过渡和适应性而脱颖而出。与步长衰减的突然变化不同,余弦函数确保学习率的平滑过渡,这对于维持训练过程的稳定性通常至关重要。

3.4挑战和考虑因素

尽管有其优点,但实施余弦退火需要仔细考虑初始学习率、最小学习率和轮数等因素。这些参数必须根据模型和数据集的特定需求进行调整。此外,余弦退火可能并不总是最适合每个问题或数据集,这凸显了上下文在选择正确学习率策略时的重要性。

04、代码示例

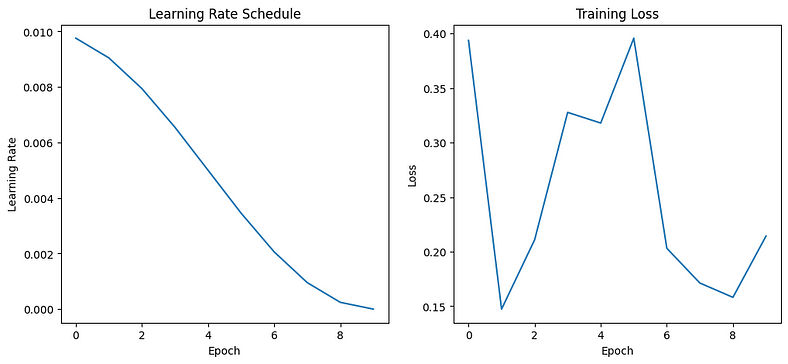

我将为您提供一个完整的 Python 示例,演示如何使用余弦退火在合成数据集上训练简单的神经网络模型。我们将包含用于生成合成数据集、定义神经网络模型、对学习率应用余弦退火、训练模型以及绘制结果的代码。

生成合成数据集:我们将创建一个适合分类任务的简单合成数据集。

定义神经网络模型:我们将使用 PyTorch 定义一个基本的神经网络。

实施余弦退火以进行学习率调度:我们将使用 PyTorch

torch.optim.lr_scheduler.CosineAnnealingLR来调整学习率。训练模型:我们将使用余弦退火调度程序在合成数据集上训练模型。

绘制结果:我们将绘制学习率表和训练损失以观察余弦退火的效果。

在运行此代码之前,请确保您已安装必要的库:

pip install torch matplotlib sklearn现在,我们继续代码实现:

import torch

import torch.nn as nn

import torch.optim as optim

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from torch.utils.data import TensorDataset, DataLoader

# 步骤 1:生成合成数据集

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 转换为 PyTorch 张量

X_train_tensor = torch.tensor(X_train, dtype=torch.float32)

y_train_tensor = torch.tensor(y_train, dtype=torch.long)

train_data = TensorDataset(X_train_tensor, y_train_tensor)

train_loader = DataLoader(train_data, batch_size=64, shuffle=True)

# 第 2 步:定义神经网络模型

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.fc1 = nn.Linear(20, 64)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(64, 2)

def forward(self, x):

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

return x

model = SimpleNN()

# 第 3 步:余弦退火算法

optimizer = optim.Adam(model.parameters(), lr=0.01)

scheduler = optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=10)

# 第 4 步:训练模型

def train_model(model, train_loader, optimizer, scheduler, num_epochs=10):

criterion = nn.CrossEntropyLoss()

model.train()

lr_list = []

loss_list = []

for epoch in range(num_epochs):

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

scheduler.step()

lr_list.append(optimizer.param_groups[0]['lr'])

loss_list.append(loss.item())

print(f'Epoch {epoch+1}/{num_epochs}, Loss: {loss.item():.4f}, LR: {optimizer.param_groups[0]["lr"]:.8f}')

return lr_list, loss_list

lr_list, loss_list = train_model(model, train_loader, optimizer, scheduler)

# 第 5 步:绘制结果图

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.plot(lr_list)

plt.title('Learning Rate Schedule')

plt.xlabel('Epoch')

plt.ylabel('Learning Rate')

plt.subplot(1, 2, 2)

plt.plot(loss_list)

plt.title('Training Loss')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.show()该代码将在合成数据集上训练一个简单的神经网络,并使用余弦退火调整学习率。这些图将显示学习率如何随时期变化以及训练过程中损失如何减少。

Epoch 1/10, Loss: 0.3937, LR: 0.00975528

Epoch 2/10, Loss: 0.1473, LR: 0.00904508

Epoch 3/10, Loss: 0.2108, LR: 0.00793893

Epoch 4/10, Loss: 0.3277, LR: 0.00654508

Epoch 5/10, Loss: 0.3179, LR: 0.00500000

Epoch 6/10, Loss: 0.3957, LR: 0.00345492

Epoch 7/10, Loss: 0.2031, LR: 0.00206107

Epoch 8/10, Loss: 0.1712, LR: 0.00095492

Epoch 9/10, Loss: 0.1581, LR: 0.00024472

Epoch 10/10, Loss: 0.2143, LR: 0.00000000

05、结论

余弦退火代表了深度学习优化策略的重大进步。通过采用动态、适应性强的学习率调度方法,它提供了一种更高效、更有效的神经网络训练途径。

随着机器学习领域的不断发展,余弦退火等技术将在突破人工智能可能的界限方面发挥至关重要的作用。